So nutzen Sie die erweiterten Segmentierungen von OnCrawl

Veröffentlicht: 2018-11-29In unserem Bereich ist eines der wichtigsten Dinge, die Sie tun können, eine effiziente und relevante Cross-Analyse von SEO-Daten erfolgreich durchzuführen. Mit der Erfahrung werden Sie feststellen, dass einige Datenüberschneidungen leistungsfähiger sind als andere, und dass beim Erstellen benutzerdefinierter Segmentierungen bestimmte Muster entstehen.

„Viele Daten sind gut, aber zu wissen, was man damit anstellt, ist besser!“ Paul Sanches, Gründer von SEOHacker

In diesem Artikel versuchen wir, die besten in OnCrawl verfügbaren Datendarstellungsmodelle mit Ihnen zu teilen und Ihnen zu zeigen, wie Sie datenübergreifende Analysen verwenden, um Optimierungen aufzudecken, die den größten Wert generieren. Aber dieser Artikel ist vor allem ein Mittel, um Ihnen zu helfen, zu erkennen, dass jedes Diagramm in OnCrawl aus verschiedenen Blickwinkeln betrachtet werden kann (und sollte).

Sie werden verstehen, wie jede Linse, durch die Sie sich einem Diagramm nähern, eine Optimierung aufzeigen oder eine Hypothese bestätigen/widerlegen kann, und dass es hilfreich ist, wenn Sie mit den erweiterten Funktionen von OnCrawl vertraut sind, wie z.

- Metrikbasierte“ Segmentierungen

- Benutzerdefinierte Felder, um gekratzte Daten zum Erstellen von Seitengruppen zu verwenden

- Segmentübergreifend in benutzerdefinierten Dashboards

Alle Segmentierungsbeispiele in diesem Artikel stehen als JSON-Dateien zum Download bereit. Um sie auf Ihre eigenen Daten in OnCrawl anzuwenden, befolgen Sie die Anweisungen in diesem Artikel, um eine neue Segmentierung zu erstellen. Sie sollten „Aus einem vorhandenen Satz oder Import“ und dann „JSON einfügen“ auswählen.

Hinweis: Es ist wichtig, dass Sie den exakten Namen beibehalten, der für Segmentierungen verwendet wird, wenn Sie sie erstellen, um unsere bevorstehenden Updates nutzen zu können.

Starten Sie Ihre kostenlose 14-Tage-Testversion

Segmentierungen basierend auf verschiedenen Metriken

Eine gute Segmentierung ist eine Segmentierung, die es Ihnen ermöglicht, die Perspektive eines OnCrawl-Felds zum Kategorisieren von Seiten basierend auf verschiedenen Werten in einem Datensatz zu verwenden.

Nehmen wir fünf einfache Beispiele:

- Welche Seiten ranken für Schlüsselausdrücke in hervorgehobenen Snippet-Positionen?

Segmentierung: oncrawl-segmentation-seo-voice-search.json

Name: SEO-Sprachsuche - Welche Seiten generieren die meisten organischen Besuche?

Segmentierung: oncrawl-segmentation-seo-top-visits-by-day.json

Name: SEO-Besuche pro Tag - Welche Seiten sind laut Google die wichtigsten?

Segmentierung: oncrawl-segmentation-log-bot-hits-by-day.json

Name: LOG-Bot-Treffer pro Tag - Welche Seiten werden auf meiner Website am häufigsten dupliziert?

Segmentierung: oncrawl-segmentation-seo-duplicate-rate.json

Name: SEO-Duplikatrate - Welche Seiten haben die besten Positionen bei Google?

Segmentierung: oncrawl-segmentation-gsc-positions.json

Name: GSC-Positionen

Wenn Sie ein visuelles Modell einer Darstellung dieser fünf wichtigen SEO-Aspekte haben, das Sie in jeder OnCrawl-Analyse verwenden können, können Sie schnell die wichtigsten oder wertvollsten Optimierungen erkennen und Ihre technischen Projekte darauf basierend priorisieren solide, quantifizierte Daten.

Nun, genau das ermöglichen OnCrawl-Segmentierungen … und wir sind die einzigen, die diese Funktion anbieten!

Einige Beispiele aus den oben genannten 5 Punkten:

1. Erhalten alle Seiten, die auf potenziellen „Featured Snippets“ ranken, organische Besuche?

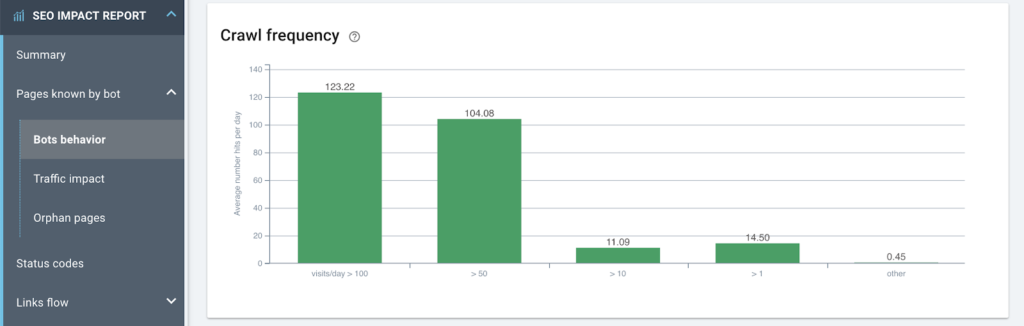

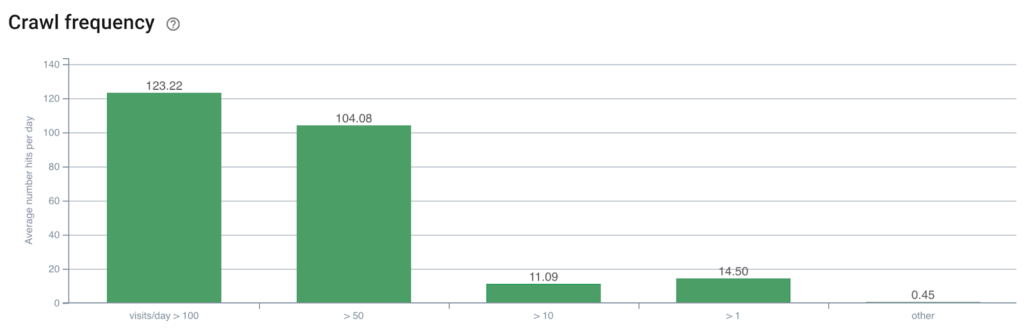

2. Ist die Crawl-Frequenz auf meiner am häufigsten besuchten Seite überdurchschnittlich hoch?

Es scheint, dass es eine starke Korrelation gibt

Noch besser! Gibt es „meistbesuchte“ Seiten, die keine internen Links mehr erhalten?

3. Gibt es einen Zusammenhang zwischen der Entfernung von der Startseite in Anzahl der Klicks und dem Crawling-Verhalten von Google?

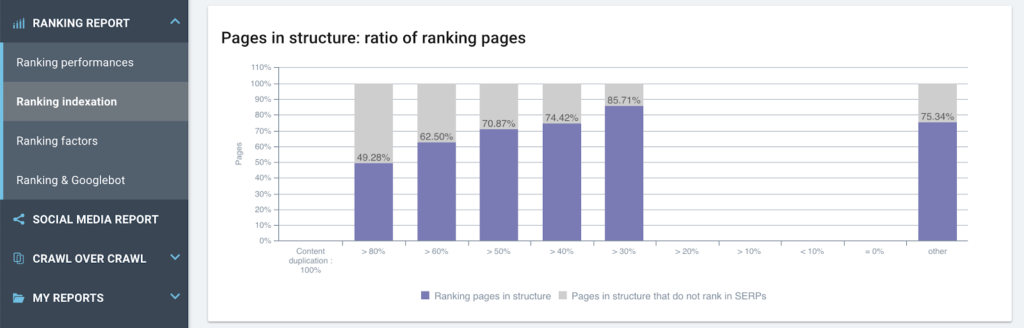

4. Hat Duplicate Content Einfluss auf das Ranking?

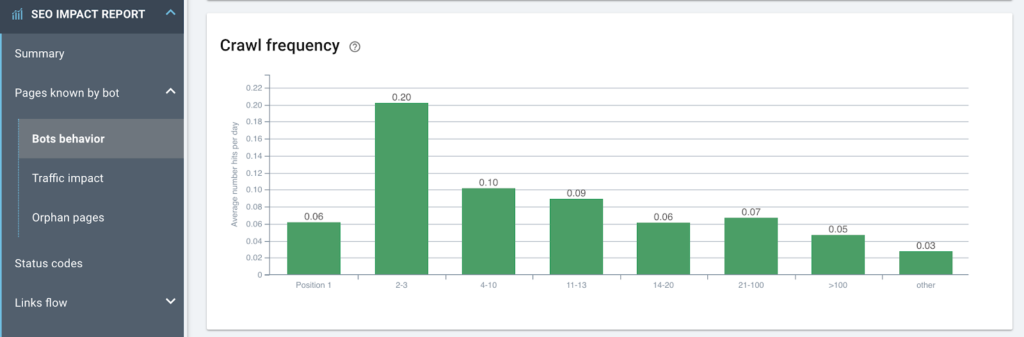

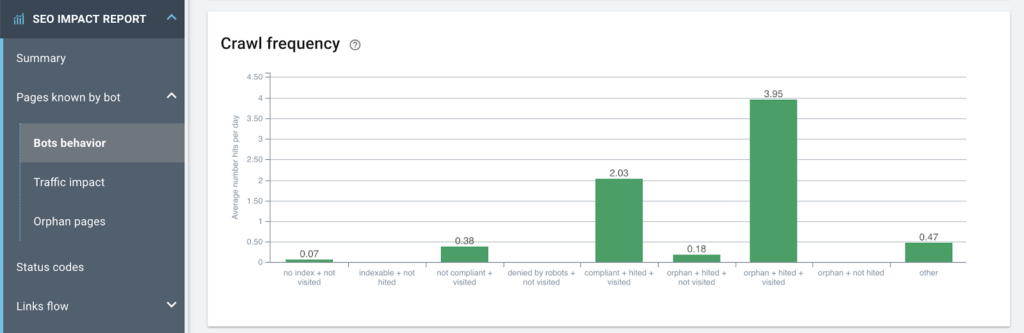

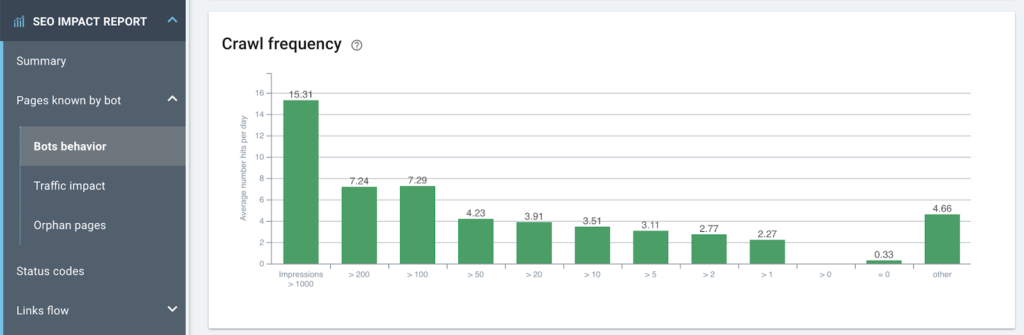

5. Crawlt Google Seiten häufiger basierend auf ihren Rankings (zeigen Rankings an, dass die Crawl-Häufigkeit mit Rankings verknüpft ist)?

Hinweis: Als Customer Success Manager sehen wir dieses Phänomen auf fast jeder Website und so interpretieren Sie es:

– Von rechts nach links verbessern sich die Positionen und die Krabbelfrequenz verbessert sich.

– Bis zu den Positionen 2-3, die 3x mehr Bot-Hits erhalten als die folgenden Positionen auf Seite 1 der SERP.

– Aber auf Position 1 (Zeitraummittel) ist die Krabbelfrequenz deutlich geringer als bei allen anderen Gruppen.

Wenn sich eine Seite an Position 1 befindet, ist es nicht diese Seite, die Google überprüfen wird. Google wird seine Konkurrenz crawlen (stellen Sie sich dieses Diagramm auf den Websites Ihrer Konkurrenten vor: es ist in 90 % der Fälle gleich), und das bedeutet die konkurrierenden Seiten auf den Positionen 2-3.

Das ist richtig: Wenn Sie neue Blickwinkel auf bestimmte Daten haben, können Sie Lehren ziehen, die für Ihre SEO-Strategie unerlässlich sind.

Hier sind nun einige ordentliche Segmentierungen.

Ladezeit

Aktuell ist die Ladezeit ein wichtiger Faktor, sowohl aus Nutzersicht als auch für die Crawler von Google. Die Segmentierung basierend auf der Metrik „Ladezeit“ ermöglicht es Ihnen, Ihre Seiten von der schnellsten zur langsamsten zu klassifizieren und die Auswirkungen der Ladezeit auf das Verhalten Ihrer Benutzer zu überwachen (indem Sie diese Daten mit der CTR kreuzen, wenn Google Analytics aktiv ist). zum Verhalten von Indizierungs-Bots in Protokollen und zur Ranking-Leistung mit GSC.

Wenn Sie daran interessiert sind, eine dieser Optionen zu testen, kontaktieren Sie uns unter [email protected]

Segmentierung: oncrawl-segmentation-seo-load-time.json

Name: SEO-Ladezeit

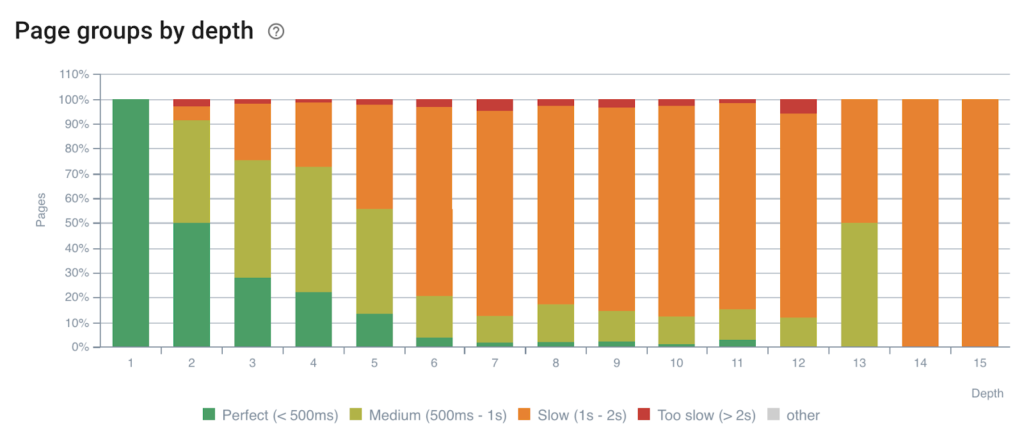

Einfluss der Tiefe auf die Ladezeit

Je tiefer eine Seite in der Struktur ist, desto länger dauert die Antwort

Hinweis: Aus Erfahrung wissen wir, je tiefer eine Seite ist, desto weniger haben die Elemente der Systemarchitektur ihre Daten zwischengespeichert. Datenbanken haben keine Anfragen dafür im Speicher und Cache-Systeme haben keinen Zugriff auf ihren Inhalt. Diese Seiten werden seltener aufgerufen – das ist normal!

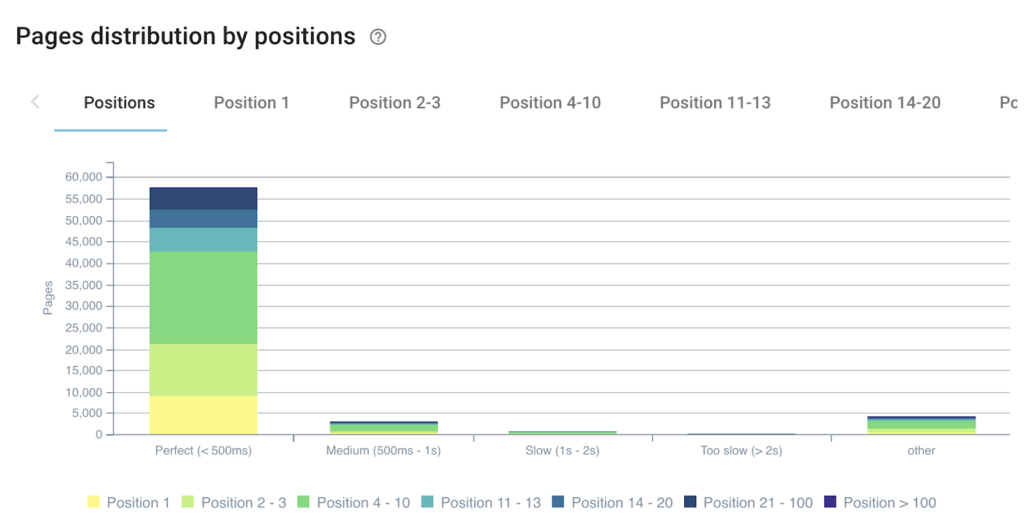

Einfluss der Ladezeit auf die Ranking-Performance

Je mehr Seiten es gibt, die schnell antworten, desto mehr Seiten haben diesen Rang

Indexierbarkeit

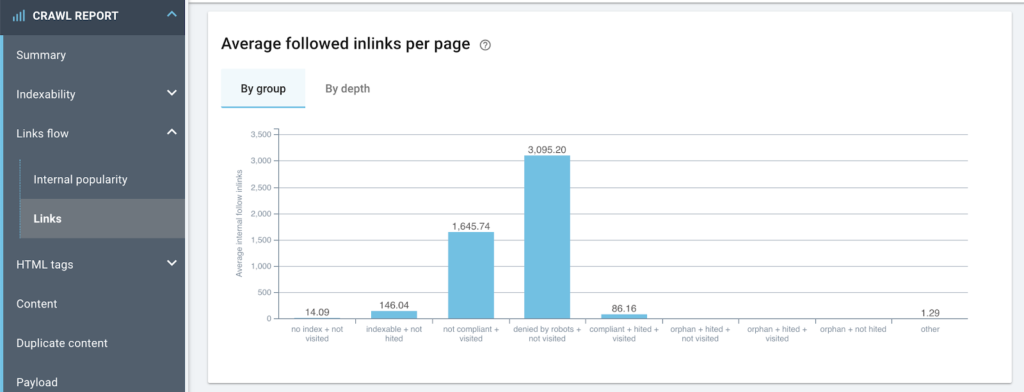

Diese Segmentierung ermöglicht es Ihnen, Fehler in der Site-Struktur schnell zu identifizieren, indem Sie die internen Links identifizieren, die auf die falsche Version von Seiten verweisen, oder den Inrank (die interne Popularitätsrate) anzeigen, der an die falschen Gruppen gesendet wird.

Segmentierung: oncrawlmentation-seo-indexability.json

Name: SEO Indexability-seg

Durchschnittliche Anzahl von Inlinks nach Indexierbarkeitstyp

Viele verschwendete Links in einer Gruppe, die in der robots.txt-Datei abgelehnt werden soll, sowie auf nicht konformen Seiten

Crawling-Häufigkeit nach Art der Indexierbarkeit

Viele verwaiste Seiten sind aktiv und gehören zu den größten Verbrauchern des Crawl-Budgets

Segmentierung der Google Search Console

Durch das Kreuzen von Crawling-Daten mit Daten aus GSC in OnCrawl werden neue Felder erstellt, die Sie zum Gruppieren von Seiten verwenden können. Positionen, CTR, Impressionen und Klicks können alle zu Segmenten werden.

Segmentierung: oncrawl-segmentation-seo-load-time.json

Name: GSC-Impressionen

Darstellung der Crawl-Frequenz pro Anzahl der Impressionen bei Google

Wir stellen fest, dass die Daten kohärent sind (Crawling-Budget vs. Impressionen)

Segmentierung: oncrawl-segmentation-gsc-positions.json

Name: GSC-Positionen

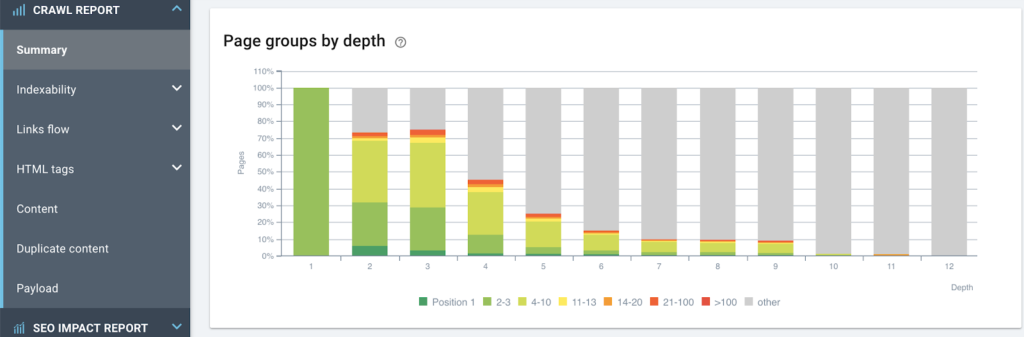

Ansicht der Ranking-Performance basierend auf der Seitenstruktur

Je tiefer eine Seite ist, desto weniger rankt sie

Segmentierung: oncrawl-segmentation-gsc-clicks.json

Name: GSC-Klicks

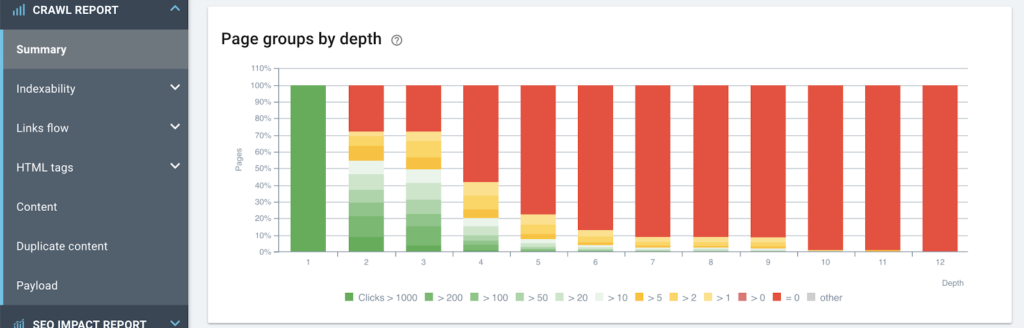

Einfluss der Tiefe auf die Anzahl der Klicks (und damit auf organische Besuche)

Je höher eine Seite in der Struktur ist, desto besser ist ihre SEO-Performance

Segmentierung: oncrawl-segmentation-gsc-ranking-pages.json

Name: GSC-Ranking-Seiten

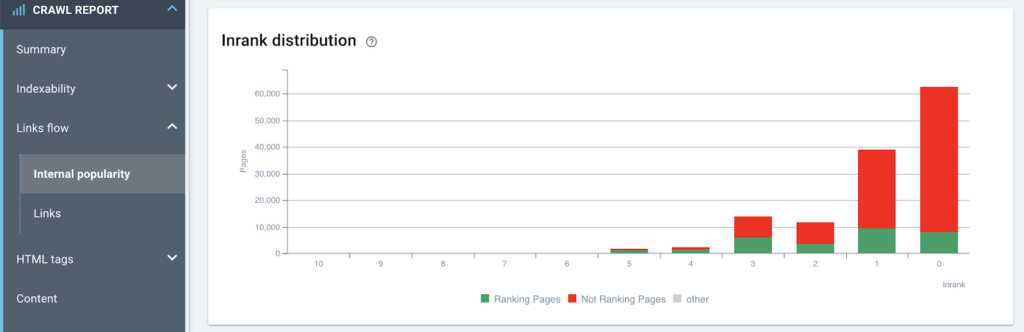

Einfluss der internen Popularität auf die Fähigkeit, Impressionen (Rankings) zu generieren

Bei der internen Verlinkung dieser Seite sind natürlich einige Maßnahmen zu ergreifen

Segmentierung: oncrawl-segmentation-gsc-ctr.json

Name: GSC-Ktr

Gruppen mit durchschnittlicher Klickrate pro Seite für die Positionen 4–10

Auf diese Weise können Sie schnell die Seiten anvisieren, die zuerst optimiert werden sollen (beste CTRs) und die Aktionen priorisieren, um die besten Ergebnisse zu erzielen

Protokollbasierte Segmentierung

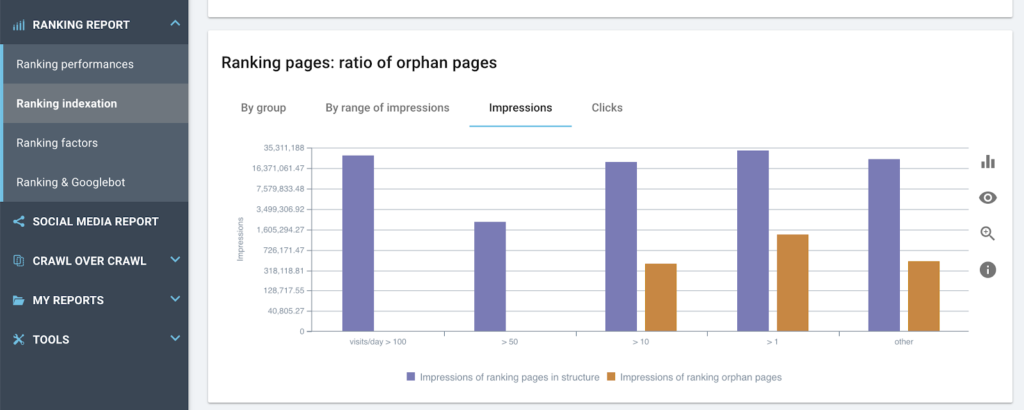

Segmentierungen basierend auf Protokolldaten ermöglichen es Ihnen, offensichtliche Darstellungen für die Analyse von OnCrawl-Diagrammen zu erstellen. Wenn wir Seiten basierend auf der Anzahl der organischen Besuche (und warum nicht nach Art des Bots? – Mobil/Desktop) oder nach der Anzahl der Bot-Zugriffe pro Tag (Crawl-Budget) gruppieren, können wir die Auswirkungen jedes vom entdeckten SEO-Elements sehen Raupe.

Segmentierung: oncrawl-segmentation-log-bot-hits-by-day.json

Name: LOG-Bot-Treffer pro Tag

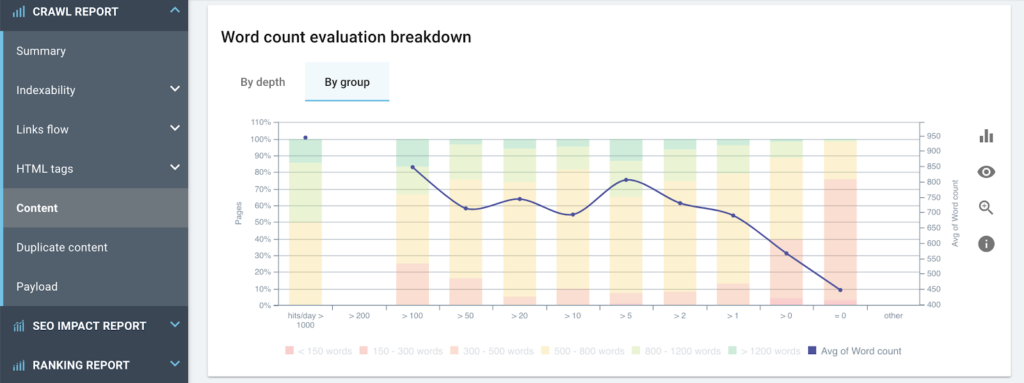

Darstellung der Häufigkeit von Googlebot-Besuchen basierend auf der durchschnittlichen Anzahl von Wörtern pro Seite

Segmentierung: oncrawl-segmentation-log-seo-visits-by-day.json

Name: LOG SEO-Besuche pro Tag

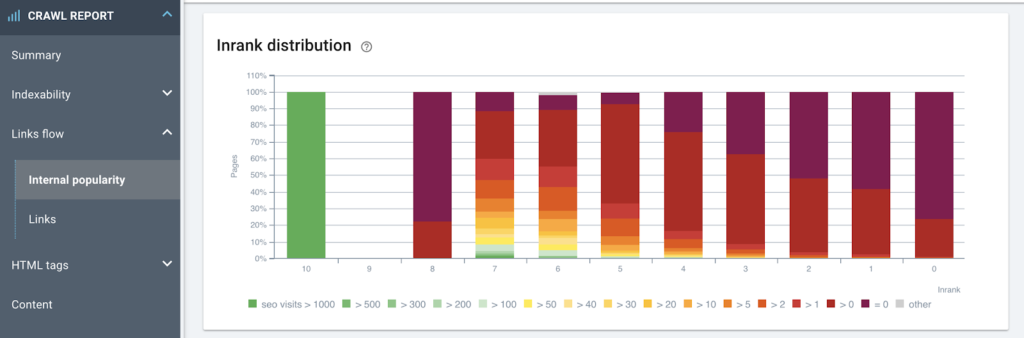

Analyse des Zusammenhangs zwischen interner Popularität und der Anzahl der Besuche über Suchmaschinen

Dies schlägt mehrere Optimierungen vor: Die beliebtesten Seiten ohne Besuche sollten lockerer verknüpft werden / bestimmte Seiten haben viele Besuche, sind aber möglicherweise weniger beliebt; Sie zu verstärken, könnte eine gute Optimierung sein

Segmentierung der Traffic-Erfassung

Wenn Sie noch weiter gehen, können Sie Seiten nach ihrer aktuell beobachteten Leistung gruppieren. Auf diese Weise können Sie auf Gruppen von Seiten abzielen, die bereits einen Mehrwert bringen, und schnell erkennen, ob Optimierungen (Tiefe, Inrank, Inhalt, Duplizierung, Ladezeit usw.) vorhanden sind, von denen diese Seiten profitieren können. Indem Sie bereits gut funktionierende Seitensätze optimieren, können Sie den Effekt, den Sie auf den erzielten Traffic haben, vervielfachen. Ihr Einsatz zahlt sich aus!

Segmentierung: oncrawl-segmentation-seo-top-visits-by-day.json

Name: SEO-Top-Besuche pro Tag

Hinweis: Diese Beispielsegmentierung verwendet Protokolldaten, kann jedoch problemlos für die Verwendung mit Google Analytics-Sitzungen oder GSC-Klicks angepasst werden

Segmentierungen basierend auf gekratzten Daten

Mit OnCrawl können Sie personalisierte Felder durch regelbasierte Extraktion aus dem Quellcode (XPATH oder REGEX) erstellen. Diese neuen Felder können verwendet werden, um repräsentative Sätze von Seiten zu erstellen. Seitentypen, Datenschichten oder Veröffentlichungsdaten können für neue Segmentierungen verwendet werden.

Segmentierung: oncrawl-segmentation-date-published.json

Name: Datum der Veröffentlichung

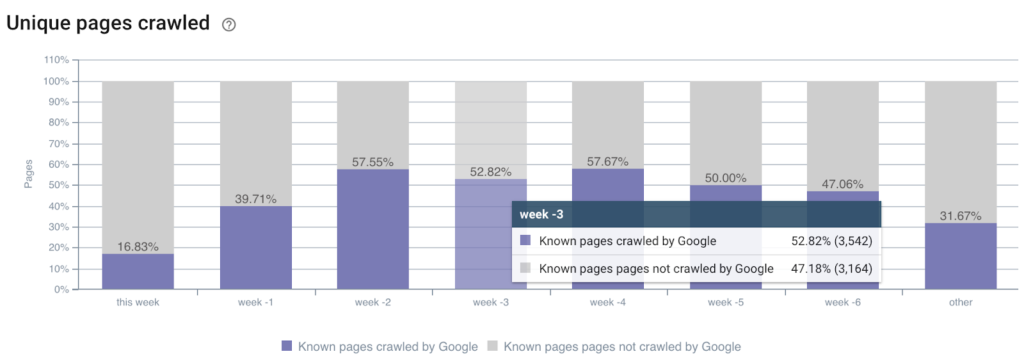

Crawling-Rate von Seiten basierend auf ihrem Veröffentlichungsdatum

Hinweis: Das extrahierte Feld muss den Namen „publicationDate“ und ein Feld vom Typ „Datum“ haben, um diese gleitende Segmentierung zu ermöglichen, die bei jedem Crawl automatisch aktualisiert wird

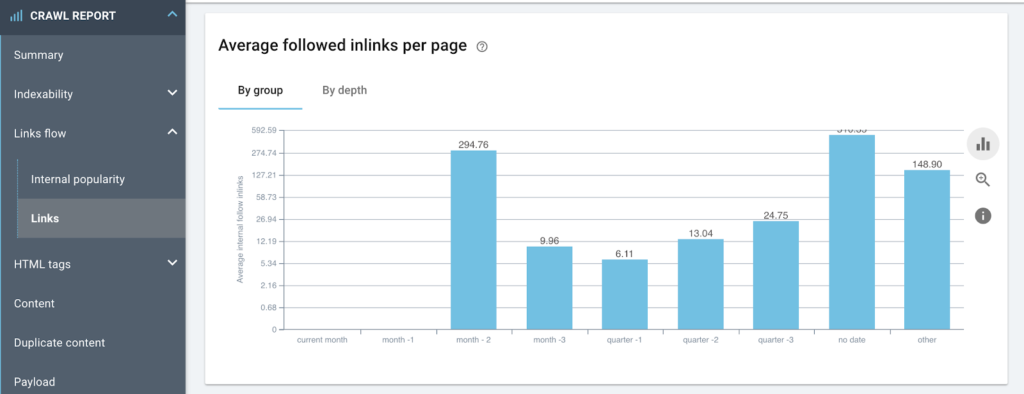

Darstellung der durchschnittlichen Anzahl von Inlinks auf Seiten basierend auf deren Veröffentlichungsdatum

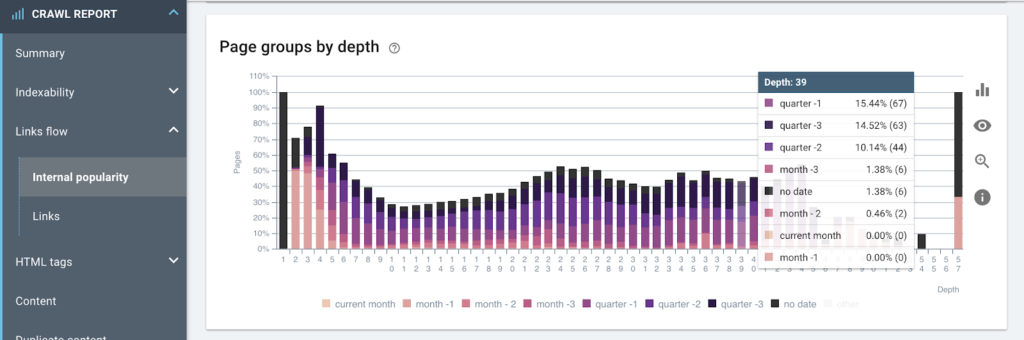

Formatierung der Seitenstruktur basierend auf dem Veröffentlichungsdatum

Segmentierung nach Seitentyp (Daten aus der Datenschicht)

Sobald Ihre Scraping-Regeln in den Crawling-Einstellungen (Artikel zu diesem Thema) festgelegt wurden, erhalten Sie neue Felder, die genau der Art von Daten entsprechen, die Ihr Team gewöhnt ist. Wenn Ihr DataLayer eingerichtet ist, wird er von all den verschiedenen Fachleuten verwendet, die mit Ihnen zusammenarbeiten, und die Bereitstellung von Berichten auf der Grundlage eines gemeinsamen Standards hilft Ihnen, gemeinsam auf ein gemeinsames Ziel hinzuarbeiten.

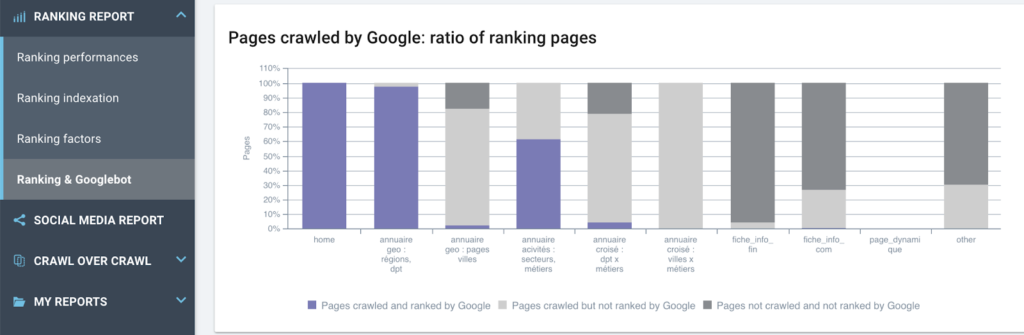

Untersuchung des Verhältnisses von Ranking-Seiten, die von Google gecrawlt werden oder nicht, für jeden Seitentyp, wie in der Datenschicht definiert

Segmentübergreifend

Allein genommen können diese Segmentierungen Sie dazu anleiten, Optimierungen oder Hindernisse aus Makrosicht zu entdecken, aber OnCrawl ermöglicht Ihnen auch, diese Segmentierungen auf einzigartige Weise zu verwenden: Sie können Ihre verschiedenen Darstellungsmodi neu segmentieren , um Ihre Analysen einzugrenzen durch Koppeln von Filtern mit Diagrammen, die in benutzerdefinierten Dashboards auf eine feste Segmentierung eingestellt wurden.

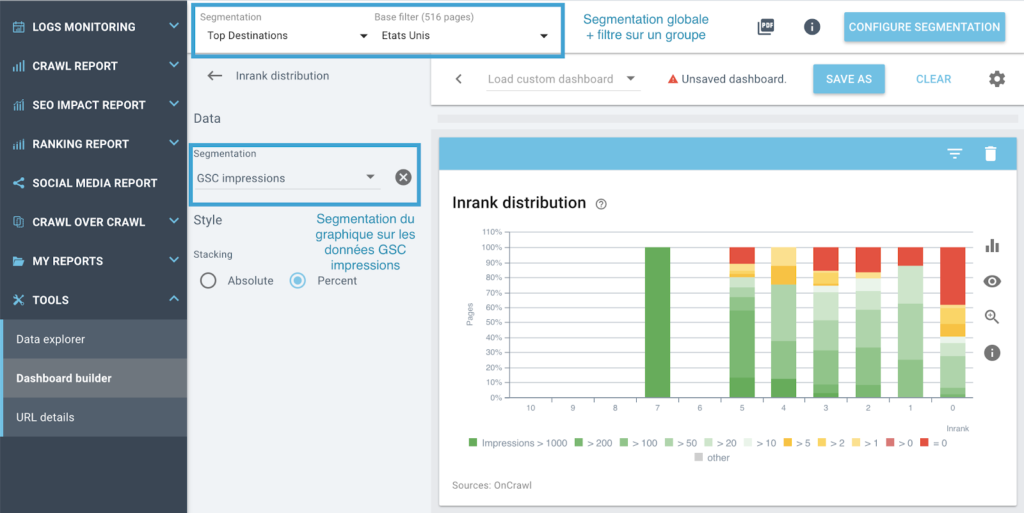

Wenn Sie bereits mit der benutzerdefinierten Dashboard-Funktion (YouTube-Video/Artikel) vertraut sind, wissen Sie, dass es möglich ist, ein Diagramm zu zwingen, eine bestimmte Segmentierung zu verwenden – eine Einstellung, die Sie vornehmen können, indem Sie auf die Kopfzeile des Diagramms klicken Erstellen eines benutzerdefinierten Dashboards. Auf diese Weise können Sie eine globale Segmentierung (die durch das Menü oben auf der Seite festgelegte Segmentierung) beibehalten und die Daten im Diagramm mit einer Darstellung anzeigen, die aus einer anderen Segmentierung stammt.

Zum Beispiel:

Ich möchte die genaue Verteilung von Inrank innerhalb einer Gruppe von Seiten in der Segmentierung „Top Destination“ wissen und diese Daten für ein bestimmtes Land mithilfe der Ansicht „GSC Impressions“ im Diagramm anzeigen.

Veranschaulichung der Kreuzsegmentierung: Verwenden von zwei Segmentierungen auf demselben Diagramm

Schlussfolgerungen

Sobald wir uns von der allzu restriktiven Segmentierung auf der Grundlage von URL-Pfaden einen Schritt zurücknehmen, sind wir in der Lage, Website-Daten aus ganz anderen und viel präziseren Blickwinkeln zu untersuchen. OnCrawl ist derzeit das einzige Tool, mit dem Sie alle verfügbaren Daten auf diese Weise formatieren können.

Mit ein wenig Erfahrung und Neugier können Sie Ihre Daten effizienter zum Sprechen bringen und kommen nicht umhin, neue Wege für relevante SEO-Verbesserungen zu finden, die leicht zu priorisieren sind.

Die einzige Grenze bei der Erstellung und Erforschung der Segmentierung von OnCrawl ist die Grenze Ihrer eigenen Kreativität. Der Ball liegt jetzt bei Ihnen!

Und vergessen Sie nicht: Das gesamte OnCrawl-Team ist hier, um Ihnen bei Ihrem Projekt zu helfen.