Warum OnCrawl viel mehr als ein Desktop-Crawler ist: Ein tiefer Einblick in unsere Cloud-basierte SEO-Plattform

Veröffentlicht: 2018-12-06OnCrawl wurde 2015 rund um die SEO-Anforderungen des französischen E-Commerce-Players Nr. 1 entwickelt. Das bedeutete, dass wir unsere Analyse skalieren und in kurzer Zeit mit einer Website mit mehr als 50 Millionen URLs umgehen mussten. Schwierig, würden Sie sagen, für einen neuen Spieler? Unsere Infrastruktur, für die wir allein in Forschung und Entwicklung 1,5 Mio. € ausgegeben haben und die zuvor verschiedene Datenprojekte unterstützt hat, hat es uns leicht gemacht. Da die Unterscheidung zwischen Desktop- und Cloud-basierten Crawlern manchmal noch unklar ist, hielten wir es für nützlich zu erklären, warum OnCrawl viel mehr zu bieten hat als ein einfacher Desktop-Crawler – von hohen Skalierungsmöglichkeiten bis hin zu Integrationen von Drittanbietern und Analysegeschwindigkeit.

Skalierung bis unendlich und darüber hinaus

Desktop-Crawler sind aufgrund der Ressourcen und des Arbeitsspeichers des Computers, auf dem sie ausgeführt werden, in ihrer Crawling-Kapazität begrenzt. Höchstwahrscheinlich werden sie darauf beschränkt sein, nur ein paar Tausend URLs pro Crawl zu crawlen. Während dies für kleine Websites in Ordnung sein kann, kann das Crawlen dieser URLs im Vergleich zu einem SaaS-Crawler (Software as a Service) immer noch länger dauern. Cloud-basierte Crawler werden auf viele Server verteilt, sodass Sie nicht durch die Geschwindigkeit und Größe Ihres Computers eingeschränkt sind.

Das bedeutet, dass es keinen Crawl gibt, den wir nicht bewältigen können. Wir haben sowohl für kleine Websites als auch für sehr große Websites gearbeitet, darunter einige der Fortune 500-Unternehmen. Wie in der Einleitung erwähnt, haben wir unseren SEO-Crawler entwickelt, nachdem Cdiscount, die größte E-Commerce-Website in Frankreich, uns gebeten hatte, eine maßgeschneiderte Lösung zu entwickeln, um ihre über 50 Millionen URLs und SEO-Anforderungen in einem einzigen Crawl zu bewältigen. Außerdem haben uns unsere Skalierungsfähigkeiten zwei Jahre in Folge zum besten SEO-Tool bei den European Search Awards gemacht, der führenden Preisverleihung in der Suchbranche. Derzeit erfassen wir bis zu 25 Millionen URLs pro Tag und pro Website oder ungefähr 1 Milliarde Webseiten und 150 Milliarden Links pro Monat. Hier erfahren Sie mehr über unsere Technologie und wie wir mit DSGVO-Richtlinien umgehen.

Benutzerdefinierte Geschwindigkeit, umfangreiche Funktionen

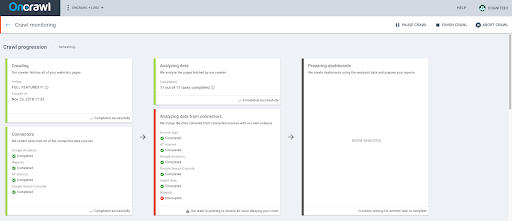

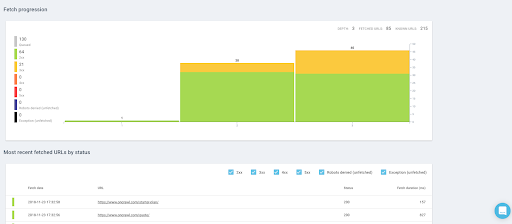

Da unsere Anwendung Cloud-basiert ist, müssen Sie sich keine Gedanken über die Ressourcen und Geschwindigkeitsmöglichkeiten Ihrer Maschine machen. Es bedeutet auch, dass es keine Beschränkung hinsichtlich des Timings oder der Anzahl der Crawls gibt, die gestartet werden können. Sie können so viele Crawls starten, wie es Ihr Abonnement zulässt, und während des Crawlens andere Dinge tun. Die Verwendung einer Cloud-basierten Lösung bedeutet auch, dass Sie Ihr Anwendungsfenster schließen und warten können, bis das Crawling abgeschlossen ist – es funktioniert von selbst und benötigt keine Überwachung durch Sie. Mit OnCrawl können Sie Crawls basierend auf Ihren SEO-Anforderungen planen, unabhängig davon, ob Sie Ihre Website einmal pro Woche oder jeden Monat crawlen müssen. Sie können auch entscheiden, Ihre Analyse zu beschleunigen, wenn Sie sie schneller benötigen.

Da die OnCrawl-App zum Crawlen jeder Website verwendet werden kann, folgt unser Bot der Crawl-Delay-Anweisung, die in der robots.txt-Datei ausgedrückt ist, die sich auf der Ziel-Website befindet, falls vorhanden.

Andernfalls begrenzen wir die Crawling-Rate auf eine Geschwindigkeit von 1 Seite pro Sekunde, damit unser Bot nicht zu aggressiv gegen die Zielwebsite vorgeht.

Wenn eine Website eine Crawl-Delay-Direktive größer als 1 hat, gibt unsere Anwendung eine Warnung aus, um Sie darauf hinzuweisen, dass das Crawling langsamer als die angeforderte Geschwindigkeit sein wird.

Wenn die Crawl-Verzögerung größer als 30 ist, zeigen wir einen Fehler an. Wir erlauben Ihnen einfach nicht, einen Crawl mit einer so hohen Crawl-Verzögerung zu konfigurieren.

Die einzige Möglichkeit, unter diesen Umständen einen Crawl einzurichten, ist die Verwendung einer virtuellen robots.txt-Datei.

Dazu müssen Sie das Projekt zunächst mit Ihrem Google Analytics-Konto validieren, damit wir sicherstellen können, dass Sie eine Art Eigentum an der Domain haben, die Sie crawlen möchten.

Wir haben ein paar verschiedene Parameter, mit denen Sie Ihren Crawl steuern können:

- Beschleunigen Sie Ihren Crawl

- Anhalten, Stoppen, Neustarten oder Abbrechen eines Crawls

- Planen Sie einen Crawl, um Stoßzeiten zu vermeiden und Ihren Server zu entlasten, wenn unsere Bots auf Ihre Website kommen

- Sehen Sie in Echtzeit die abgerufenen Seiten, die Anzahl der bisher abgerufenen URLs und sehen Sie, ob es ein Problem gibt, das Ihr Crawling verlangsamt.

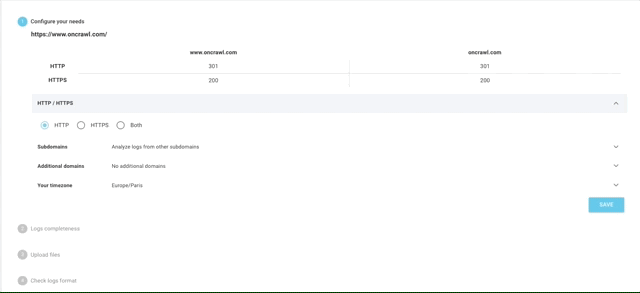

Logdatei-Analyse leicht gemacht

OnCrawl ist so viel mehr als ein einfacher SEO-Crawler. In den letzten Jahren haben wir auch einen leistungsstarken Logdatei-Analysator veröffentlicht, der Probleme angeht, die keine andere SEO-Lösung gefunden hat.

Vollständige Protokolldateien spiegeln das Leben Ihrer Website perfekt wider. Ob Besucher oder Bots, angezeigte Seiten oder Aufrufe von Ressourcen, jede Aktivität auf Ihrer Website wird darin festgehalten.

Mit Informationen wie IP-Adresse, Statuscode, User-Agent, Referrer und anderen technischen Daten kann Ihnen jede Protokollzeile (serverseitige Daten) dabei helfen, die Analyse Ihrer Website abzuschließen, die meistens auf Analysen basiert (eher clientseitig orientiert).

Unser Protokolldatei-Analysator unterstützt alle Arten von Protokollformaten, von Standardformaten wie IIS, Apache auf Ngnix bis hin zu benutzerdefinierten Formaten. Es gibt keine Analyse, die wir nicht durchführen können. Wir lassen unsere Benutzer ihre Protokolldaten auch direkt von Lösungen von Drittanbietern wie Splunk, ELK / Elastic Stack, Amazon S3, OVH (ES) oder Cloudflare abrufen.

Das bedeutet, dass Sie nicht mehr wie bei einigen unserer Mitbewerber auf einen zusätzlichen Logdatei-Manager eines Drittanbieters angewiesen sind.

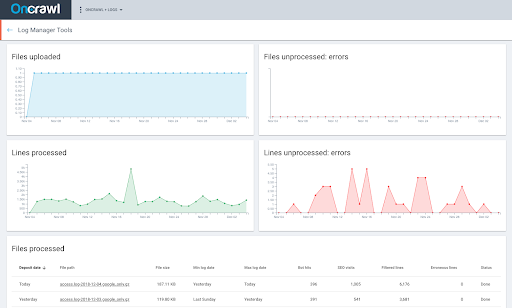

Unsere Schnittstelle macht es einfach, Ihre Protokolldateien automatisch über ein sicheres und privates FTP hochzuladen. Es sind nur wenige Schritte erforderlich, um Ihre Protokolldateianalyse abzuschließen.

Sie können auch die Verarbeitung Ihrer Dateien in Echtzeit überwachen und sehen, ob ein Fehler den Upload blockiert.

Unbegrenzte Integrationen von Drittanbietern

OnCrawl hat an der Entwicklung integrierter Konnektoren mit führenden Suchmaschinenmarketing-Lösungen gearbeitet, ohne die SEOs nicht leben können: Google Search Console, Google Analytics, Adobe Analytics oder Majestic, um nur einige zu nennen. Die Integration dieser Lösungen in Ihren Audit-Prozess ist nicht überflüssig: Sie bietet einen umfassenderen Überblick über die Leistung und den Zustand Ihrer Website in Suchmaschinen und verdeutlicht, wie sich Bots und Besucher auf Ihrer Website wirklich verhalten. Außerdem sparen Sie Zeit und Mühe, da Sie diese Daten später nicht manuell in Excel-Tabellen verarbeiten müssen.

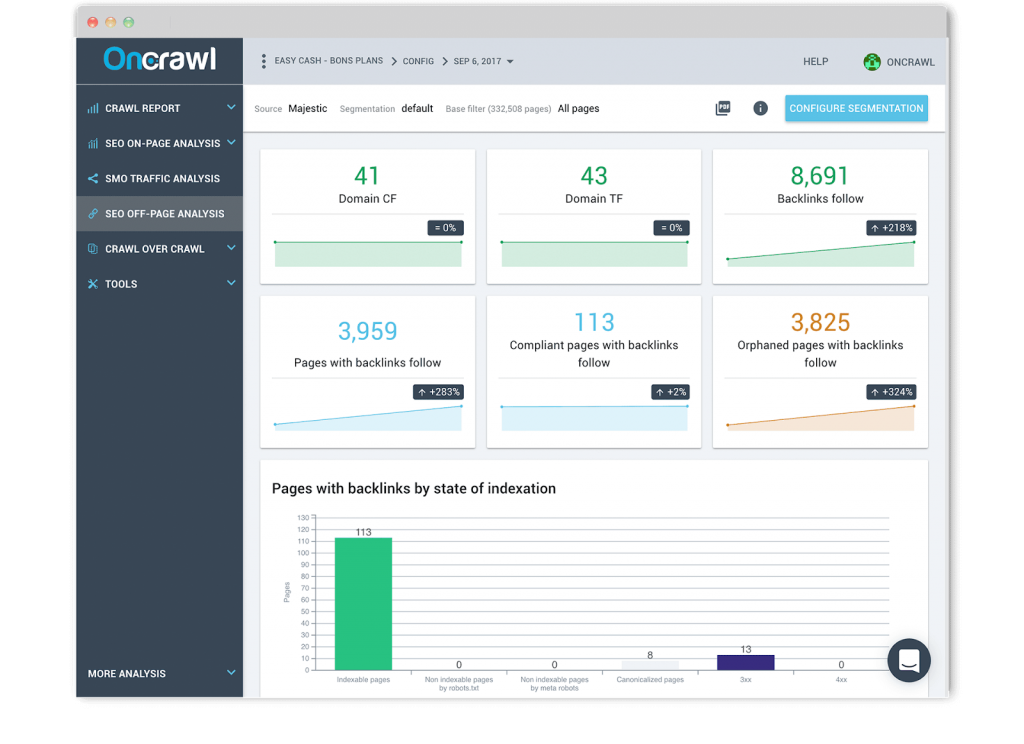

Backlink-Bericht

Wir haben eine vertrauensvolle Beziehung zu Majestic aufgebaut, der führenden Link-Intelligence-Lösung. Mit unserer datenübergreifenden Analyse können Sie Ihre Crawl-Daten und Protokolldaten mit Ihren Backlink-Daten kombinieren, um den Einfluss von Backlinks auf Ihren SEO-Traffic und Ihre Crawl-Frequenz zu verstehen. Sobald Sie eine Website-weite Segmentierung von benutzerdefinierten Seitengruppen basierend auf Ihren wichtigsten KPIs eingerichtet haben. Sie können auch die Anzahl der Backlinks in Bezug auf die Seitenklicktiefe visualisieren oder untersuchen, ob die Anzahl der Backlinks einen Einfluss auf das Verhalten von Google hat.

Die von uns angebotenen Analysen, bei denen Backlink-Daten auf URL- und Bot-Treffer-Ebene korreliert und kombiniert werden, sind derzeit die einzigen auf dem Markt.

Ranking-Bericht

Wir haben auch einen einzigartigen Konnektor zur Google Search Console entwickelt, um zu verstehen, wie Ihre Website gefunden und indexiert wird und wie sich Ihre On-Page-Optimierungen auf Ihren Traffic und Ihre Indexierung auswirken. Wir bieten standardmäßige, aber umfassende Einblicke in Bezug auf Ihre Keyword-Verteilung, Impressionen, Klicks und Klickrate im Laufe der Zeit, ob auf dem Desktop oder auf Mobilgeräten, für markenbezogene oder nicht markenbezogene Keywords oder in Bezug auf Ihre Seitengruppen. Noch wichtiger ist, dass wir auch einzigartige Analysen anbieten, die keiner unserer Konkurrenten erreicht hat.

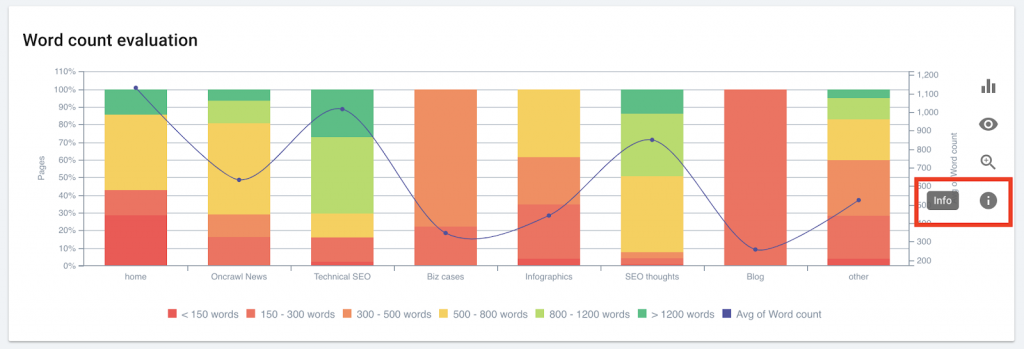

OnCrawl verwendet Ihre Segmentierungen und Daten aus Ihren Protokolldateien, um Ihre Ranking-Daten zu interpretieren. So können Sie die gemeinsamen Merkmale von rankenden und nicht rankenden Seiten in Bezug auf Tiefe, interne Popularität, Wortzahl, Inlinks, Ladezeit und Titelbewertung identifizieren. Nicht nur das, Sie können auch die Auswirkungen der Beschreibungslänge und strukturierter Daten auf die Klickrate untersuchen.

Schließlich können Sie mit OnCrawl Rankings Ihre Crawl-, Protokolldateien und Search Console-Daten in großem Maßstab kombinieren, um bewertete Seiten hervorzuheben und zu verstehen, ob das Crawl-Budget Ihre Positionen beeinflusst. Keine anderen Crawls, ob Desktop- oder Cloud-basiert, unterstützen solche Funktionen.

Analytics-Bericht

Wir lassen Sie Ihr Google Analytics oder Adobe Analytics (ex-Omniture) verbinden, um zu verstehen, wie On-Page und technisches SEO die Leistung des organischen Verkehrs von Suchmaschinen beeinflussen. Wir helfen Ihnen bei der Überwachung der SEO-Verkehrsleistung und des Benutzerverhaltens in Bezug auf jeden Abschnitt Ihrer Website.

CSV-Aufnahme

Während wir ständig an neuen Integrationen von Lösungen von Drittanbietern arbeiten, wollten wir Sie nicht ohne eine bestimmte Art von Daten zurücklassen, die Sie möglicherweise für Ihre technischen SEO-Audits benötigen. Aus diesem Grund können Sie CSV-Dateien in großem Umfang hochladen (Sie können Millionen von Zeilen hochladen), um eine neue Datenebene auf URL-Ebene hinzuzufügen. Sie können Ihre ganz eigenen Segmentierungen und Filter basierend auf diesen speziellen Daten (Rankings, CRM, Geschäftsdaten, Google Ads-Daten usw.) erstellen, um zu sehen, ob Ihre strategisch wichtigsten Seiten Ihren Zielen entsprechen.

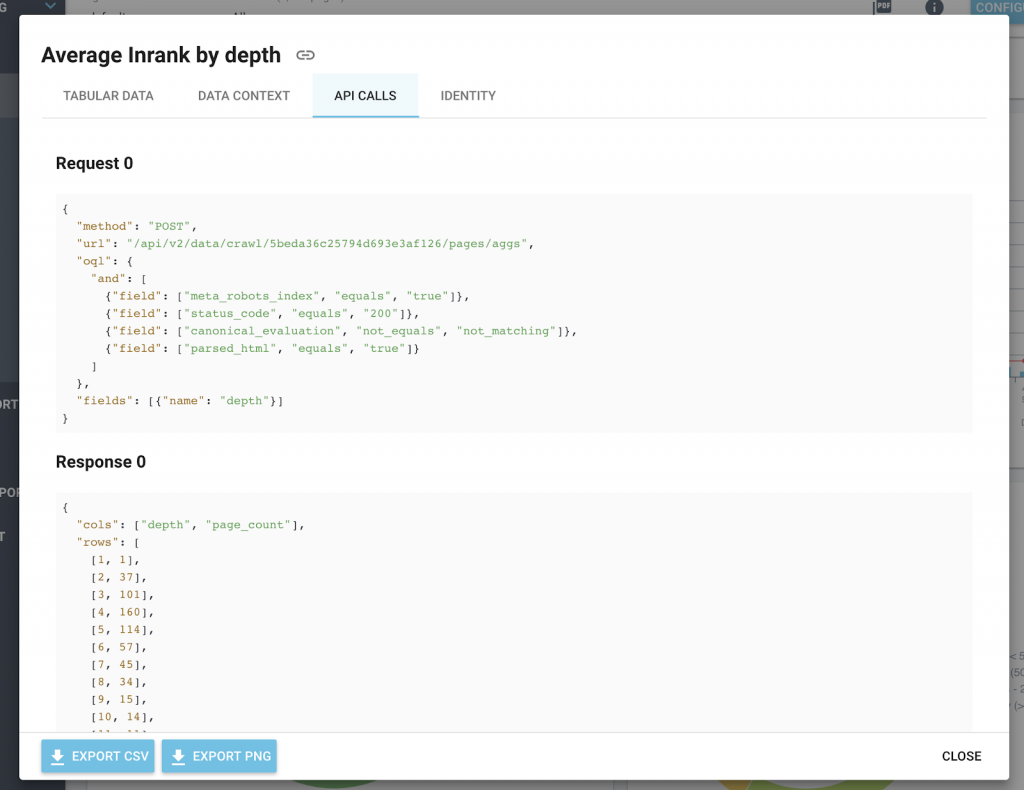

Offene API, benutzerdefinierte Analyse

OnCrawl basiert auf einer Plattform, die um eine API herum aufgebaut ist. Die OnCrawl-REST-API wird für den Zugriff auf Ihre Crawl-Daten sowie für die Verwaltung Ihrer Projekte und Ihrer Crawls verwendet. Um diese API nutzen zu können, benötigen Sie ein OnCrawl-Konto, ein aktives Abonnement und ein Zugriffstoken.

Sie können ganz einfach Ihre eigene Anwendung erstellen, um diese API anzufordern. Dies kann mit einem vom Benutzerkonto generierten API-Token oder mit einer OAuth-Anwendung erfolgen, um eine Verbindung zu OnCrawl über das Konto des Benutzers herzustellen.

Mit unserer API können Sie Anwendungen schreiben, die die vielen Funktionen von OnCrawl optimal nutzen, in Ihrer eigenen Umgebung bereitgestellt werden und die Programmiersprache und Plattformen verwenden, die Sie bevorzugen. Das bedeutet, dass Sie benutzerdefinierte Dashboards erstellen, unsere Daten in andere Plattformen integrieren und automatisch einen Crawl auslösen können, wenn eine Website aktualisiert wird.

Um Ihnen die Integration zu erleichtern, enthalten alle unsere Diagramme die API-Aufrufe und das Antwortformat im Informationssymbol.

Trends und Optimierungen im Laufe der Zeit

OnCrawl organisiert Ihre Crawls nach Datum innerhalb Ihrer Projekte. Wir speichern Ihre Crawling-Daten, während Ihr Abonnement aktiv ist, was bedeutet, dass Sie monate- oder sogar jahrelange Analysen verfolgen können. Bitte beachten Sie, dass die OnCrawl-Anwendung personenbezogene Daten in Form der IP-Adressen von Besuchern Ihrer Website verarbeitet, wenn Sie unsere Log-Monitoring-Funktion verwenden. Diese Informationen werden benötigt, um Googlebots zuverlässig von anderen Besuchern unterscheiden zu können. IP-Adressen werden nicht in der OnCrawl-Anwendung gespeichert. Diese Daten existieren nur in der Originaldatei, die Sie auf Ihr privates, sicheres FTP hochladen.

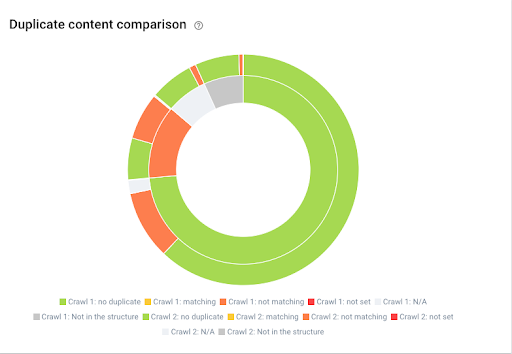

Wir bieten auch umfangreiche Funktionen, mit denen Sie zwei Crawls basierend auf derselben Crawl-Konfiguration vergleichen können, um Trends und Änderungen im Laufe der Zeit zu erkennen. Dies ist eine großartige Möglichkeit, eine Staging- und eine Live-Version zu vergleichen und zu überprüfen, ob während der Migration alles reibungslos gelaufen ist.

Sie können Ihre Projekte auch mit Teamkollegen oder Kunden teilen, was eine großartige Möglichkeit ist, den Wert Ihrer Optimierungen zu beweisen und Ergebnisse zu teilen.

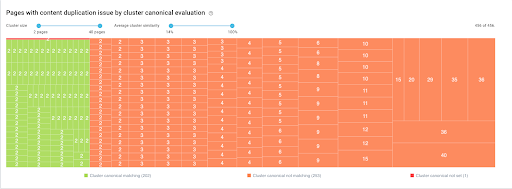

Zeigt die Entwicklung von Duplicate Content zwischen zwei Crawls

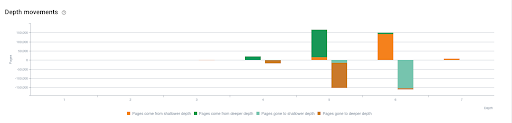

Zeigt die Entwicklung der Tiefenbewegungen zwischen zwei Crawls

Semantik überall

Innovation liegt in unserer Kern-DNA und wir arbeiten seit Jahren daran, technisches SEO zu evangelisieren. Mit über 15 Jahren Erfahrung in der Verarbeitung natürlicher Sprache hat uns Tanguy Moal, CTO bei OnCrawl, dabei geholfen, semantische und Big-Data-Technologien zusammenzuführen, um das enorme Datenvolumen, das im Internet verfügbar ist, zu verstehen. Wir haben den allerersten Near Duplicate Content Detektor mit dem Simhash-Algorithmus entwickelt.

Cluster ähnlicher Seiten mit kanonischer Bewertung – Cluster können nach Anzahl der Seiten oder Prozentsatz der inhaltlichen Ähnlichkeit gefiltert werden

Wir haben kürzlich auch an einem Heatmap-Inhaltsdetektor gearbeitet, der unseren Benutzern dabei hilft, Blöcke mit einzigartigem Inhalt und den Prozentsatz der Duplizierung auf Webseiten und einer ganzen Website zu identifizieren. Semantik ist Teil unseres SEO-Crawlers: Die N-Gramm-Analyse war von Anfang an verfügbar, um Ihnen zu helfen, zu verstehen, wie Wortfolgen innerhalb einer Website verteilt sind. Wir sind der einzige Cloud-basierte Crawler mit solchen semantischen Fähigkeiten. In einem Bereich, in dem Konversationssuchanfragen zunehmen, hilft Ihnen semantisches SEO, den Traffic auf einer Website durch aussagekräftige Metadaten und semantisch relevante Inhalte zu verbessern, die eine eindeutige Antwort auf eine bestimmte Suchabsicht liefern können.

OnCrawl ist viel mehr als ein Desktop-Crawler und bietet eine beispiellose und Cloud-basierte SEO-Analyse in großem Maßstab. OnCrawl ermöglicht es Ihnen, wirklich zu verstehen, wie sich Suchmaschinen auf Ihrer Website verhalten, und mit Zuversicht eine SEO-Strategie zu erstellen.

Nehmen Sie nicht unser Wort dafür. Probieren Sie es selbst aus und starten Sie noch heute Ihre kostenlose Testversion.