Logfile-Analyse: die smarte Alternative zu Google Analytics

Veröffentlicht: 2022-03-08Wissen Sie, was jeden Tag auf Ihrer Website passiert? Das erste, was bei der Beantwortung dieser Frage in den Sinn kommt, ist höchstwahrscheinlich die Verwendung von Publikums- und Verhaltens-Tracking-Tools. Es gibt viele solcher Tools auf dem Markt, darunter: Google Analytics, At Internet, Matomo, Fathom Analytics und Simple Analytics, um nur einige zu nennen. Diese Tools ermöglichen uns zwar einen ziemlich guten Überblick darüber, was zu einem bestimmten Zeitpunkt auf unseren Websites passiert, aber die ethischen Praktiken, die von diesen Tools, insbesondere von Google Analytics, angewendet werden, werden erneut in Frage gestellt.

Dies deutet darauf hin, dass es andere Datenquellen gibt, die derzeit nicht von allen Website-Eigentümern ausreichend genutzt werden: Protokolle.

Analysetools und DSGVO (Schwerpunkt Google Analytics)

Personenbezogene Daten sind in Frankreich seit der Umsetzung der Datenschutz-Grundverordnung (DSGVO) und der Gründung der Nationalen Kommission für Informatik und Freiheit (CNIL) zu einem sensiblen Thema geworden. Datenschutz ist zu einer Priorität geworden.

Ist Ihre Website also immer noch „DSGVO-freundlich“?

Wenn wir uns alle Websites ansehen, können wir feststellen, dass viele einen Weg gefunden haben, die Regeln zu umgehen, indem sie ihre Cookies (Datenerfassungsbanner) verwenden, um die benötigten Informationen zu sammeln, während andere sich immer noch strikt an die offiziellen Vorschriften halten.

Durch das Sammeln dieser Informationen ermöglichen uns Datenanalysetools die Analyse der Herkunft des Publikums und des Besucherverhaltens. Diese Art der Analyse erfordert einen tadellosen Tagging-Plan, um möglichst zuverlässige und genaue Daten zu sammeln, und letztendlich sind die gesammelten Daten das Ergebnis jeder Aktion und jedes Ereignisses auf einer Website.

Nach einer Reihe von Beschwerden hat die CNIL beschlossen, Google Analytics vorerst in Frankreich für illegal zu erklären. Diese Sanktion ergibt sich aus dem offensichtlichen Mangel an Überwachung bezüglich der Übermittlung personenbezogener Daten an die Geheimdienste in den Vereinigten Staaten, obwohl Besucherinformationen zuvor mit Zustimmung gesammelt wurden. Die Entwicklungen sollten genau beobachtet werden.

In diesem aktuellen Kontext mit eingeschränktem oder keinem Zugriff auf Google Analytics könnte es interessant sein, sich andere Datenerfassungsoptionen anzusehen. Protokolldateien sind eine Zusammenstellung der historischen Ereignisse einer Site und relativ einfach wieder herzustellen. Sie sind eine großartige Informationsquelle.

Obwohl Protokolldateien Zugriff auf ein interessantes Informationsarchiv zur Analyse bieten, erlauben sie uns nicht, Geschäftswerte oder das tatsächliche Verhalten eines Website-Besuchers anzuzeigen, wie z Seite? ˅. Der Verhaltensaspekt bleibt jedoch spezifisch für die oben genannten Tools; Protokollanalyse kann uns helfen, ziemlich weit zu kommen.

Protokolldateien verstehen

Was sind Protokolldateien? Protokolle sind eine Art von Datei, deren Hauptaufgabe es ist, einen Verlauf von Ereignissen zu speichern.

Von was für Veranstaltungen sprechen wir? Im Wesentlichen sind „Ereignisse“ die Besucher und Roboter, die jeden Tag auf Ihre Website zugreifen.

Die Google Search Console kann diese Informationen ebenfalls sammeln, wendet jedoch aus mehreren Gründen – insbesondere aus Datenschutzgründen – einen sehr spezifischen Filter an.

(Quelle: https://support.google.com/webmasters/answer/7576553. „Unterschiede zwischen der Search Console und anderen Tools“.)

Folglich haben Sie nur einen Ausschnitt dessen, was eine Protokollanalyse liefern kann. Mit den Logfiles haben Sie Zugriff auf 100% der Daten!

Die Analyse der Protokolldateizeilen kann Ihnen helfen, Ihre zukünftigen Aktionen zu priorisieren.

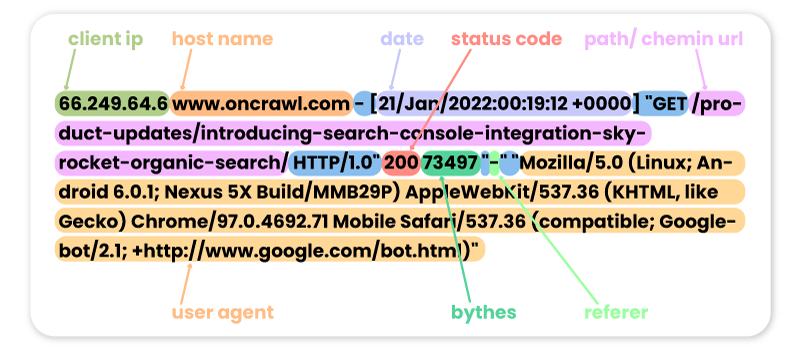

Hier sind einige Beispiele vergangener Besuche auf der Oncrawl-Website von verschiedenen Robotern:

FACEBOOK:

66.220.149.10 www.oncrawl.com - [07/Feb/2022:00:18:35 +0000] "GET /feed/ HTTP/1.0" 200 298008 "-" "facebookexternalhit/1.1 (+http://www.facebook.com/externalhit_uatext.php)"

SEMRUSCH:

185.191.171.20 fr.oncrawl.com - [13/Feb/2022:00:18:27 +0000] "GET /infographie/mises-jour-2017-algorithme-google/ HTTP/1.0" 200 50441 "-" "Mozilla/5.0 (compatible; SemrushBot/7~bl; +http://www.semrush.com/bot.html)"

BING:

207.46.13.188 www.oncrawl.com - [22/Jan/2022:00:18:40 +0000] "GET /wp-content/uploads/2018/04/url-detail-word-count.png HTTP/1.0" 200 156829 "-" "Mozilla/5.0 (compatible; bingbot/2.0; +http://www.bing.com/bingbot.htm)"

GOOGLE-BOT:

66.249.64.6 www.oncrawl.com - [21/Jan/2022:00:19:12 +0000] "GET /product-updates/introducing-search-console-integration-skyrocket-organic-search/ HTTP/1.0" 200 73497 "-" "Mozilla/5.0 (Linux; Android 6.0.1; Nexus 5X Build/MMB29P) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/97.0.4692.71 Mobile Safari/537.36 (compatible; Googlebot/2.1; +http://www.google.com/bot.html)"

Bitte beachten Sie, dass einige Bot-Besuche gefälscht sein können. Es ist wichtig, daran zu denken, die IP-Adressen zu überprüfen, um festzustellen, ob es sich um echte Besuche von Googlebot, Bingbot usw. handelt. Hinter diesen gefälschten Benutzeragenten stecken möglicherweise Profis, die manchmal Roboter starten, um auf Ihre Website zuzugreifen und Ihre Preise, Ihren Inhalt oder anderes zu überprüfen Informationen, die sie nützlich finden. Um sie zu erkennen, hilft nur die IP!

Hier sind einige Beispiele für Besuche von Oncrawl-Websites durch Internetnutzer:

Von Google.com:

41.73.11x.xxx fr.oncrawl.com - [13/Feb/2022:00:25:29 +0000] "GET /seo-technique/predire-trafic-seo-prophet-python/ HTTP/1.0" 200 57768 "https://www.google.com/" "Mozilla/5.0 (Linux; Android 10; Orange Sanza touch) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/97.0.4692.98 Mobile Safari/537.36"

Von Google Ads UTMs:

199.223.xxx.x www.oncrawl.com - [11/Feb/2022:15:18:30 +0000] "GET /?utm_source=sea&utm_medium=google-ads&utm_campaign=brand&gclid=EAIaIQobChMIhJ3Aofn39QIVgoyGCh332QYYEAAYASAAEgLrCvD_BwE HTTP/1.0" 200 50423 "https://www.google.com/" "Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/96.0.4664.110 Safari/537.36"

Von LinkedIn dank an den Referrer:

181.23.1xx.xxx www.oncrawl.com - [14/Feb/2022:03:54:14 +0000] "GET /wp-content/uploads/2021/07/The-SUPER-SEO-Game-Building-an-NLP-pipeline-with-BigQuery-and-Data-Studio.pdf HTTP/1.0" 200 3319668 "https://www.linkedin.com/"

[Ebook] Vier Anwendungsfälle zur Nutzung der SEO-Protokollanalyse

Warum Protokollinhalte analysieren?

Nun, da wir wissen, was die Protokolle tatsächlich enthalten, was können wir damit machen? Die Antwort: Analysieren Sie sie wie jedes andere Analysetool.

Bots oder Roboter

Hier können wir uns folgende Frage stellen:

Welche Roboter verbringen die meiste Zeit auf meiner Website?

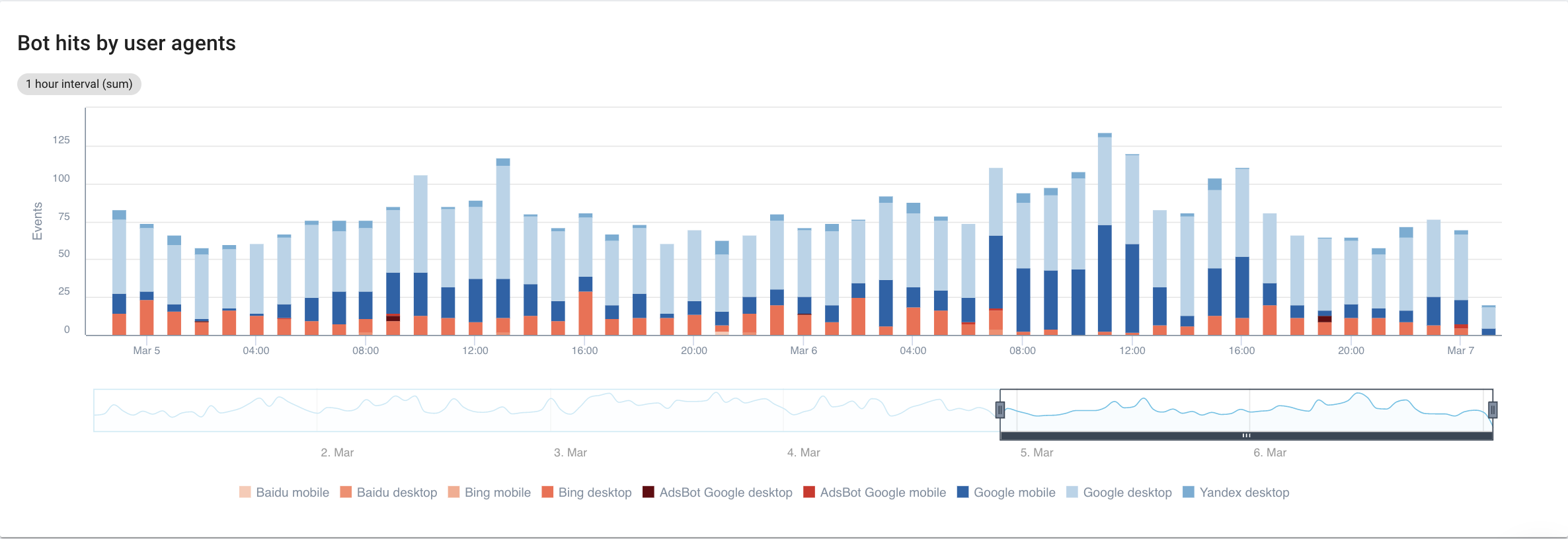

Wenn wir uns auf Suchmaschinen mit einer detaillierten Ansicht jedes Bots konzentrieren, können wir Folgendes sehen:

Quelle: Oncrawl-Anwendung

Google Mobile und Desktop verbringen eindeutig viel mehr Zeit mit dem Crawlen als Bing- oder Yandex-Bots. Googlebot hat einen globalen Marktanteil von über 90 %.

Wenn Google meine Seiten crawlt, werden sie automatisch indexiert? Nein, nicht unbedingt.

Wenn wir ein paar Jahre zurückgehen, hat Google einen automatischen Reflex angewendet, um Seiten direkt nach dem Besuch zu indizieren. Heute ist dies angesichts des zu verarbeitenden Seitenvolumens nicht mehr der Fall. Infolgedessen entbrennt ein SEO-Kampf um das Crawl-Budget.

Abgesehen davon fragen Sie sich vielleicht: Was bringt es, zu wissen, welcher Bot mehr Zeit als ein anderer auf meiner Website verbringt?

Die Antwort auf diese Frage hängt von den Algorithmen der einzelnen Bots ab. Sie sind alle ein wenig anders und kehren nicht unbedingt aus den gleichen Gründen zurück.

Jede Suchmaschine hat ihr eigenes Crawl-Budget, das sie auf diese Bots aufteilt . Mit anderen Worten bedeutet dies, dass Google sein Crawl-Budget auf all diese Bots aufteilt. Daher wird es ziemlich interessant, sich etwas genauer anzusehen, was GooglebotAds tut, insbesondere wenn wir 404s herumliegen haben. Sie zu bereinigen ist eine Möglichkeit, das Crawl-Budget und letztendlich Ihre SEO zu optimieren.

Oncrawl Log Analyzer

Querverweise auf Googlebot-Daten mit Oncrawl-Crawler-Daten

Um das Verhalten des Googlebots eingehender zu analysieren, vergleicht Oncrawl Protokolldaten mit Crawling-Daten, um die detailliertesten und genauesten Informationen zu erhalten.

Das Ziel ist auch, die Hypothesen zu bestätigen oder zu widerlegen, die mit mehreren KPIs wie Tiefe, Inhalt, Leistung usw. verknüpft sind.

Dementsprechend müssen Sie sich die richtigen Fragen stellen:

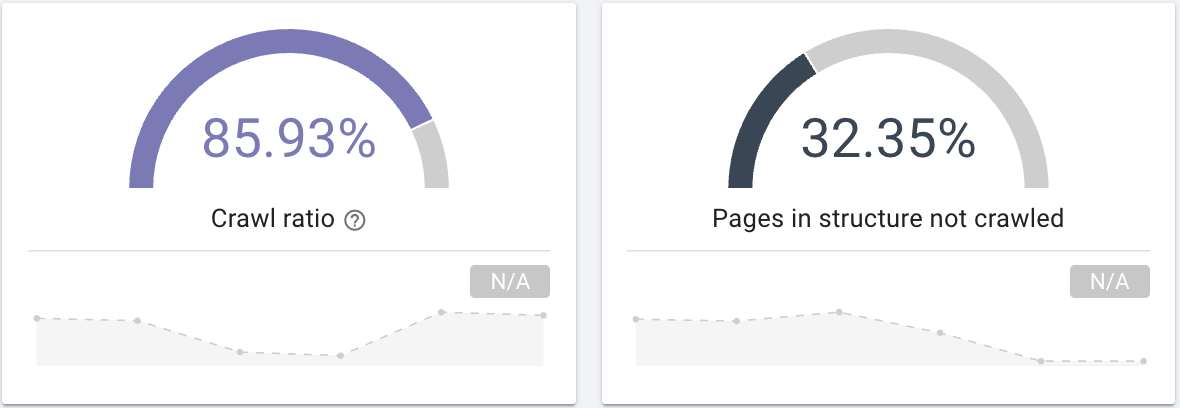

- Crawlt der Googlebot alle Seiten Ihrer Website? Interessieren Sie sich für das Crawl-Verhältnis, das diese Informationen eindeutig liefert, die Sie auch mit einer Segmentierung Ihrer Seiten filtern können.

Quelle: Oncrawl-Anwendung

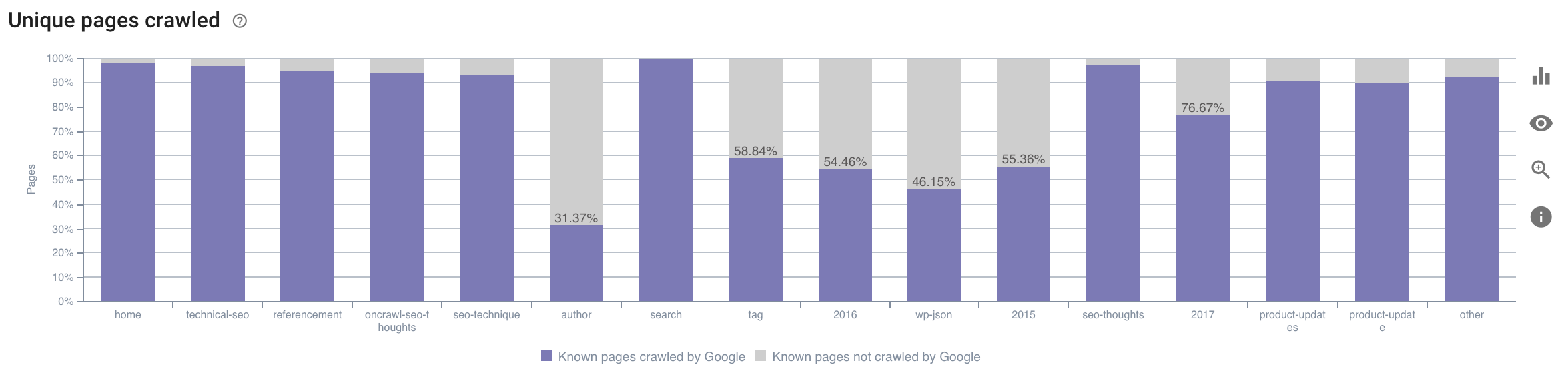

- Auf welche Kategorie verbringt der Googlebot seine Zeit? Ist das eine optimale Nutzung des Crawl-Budgets? Diese Grafik im SEO Impact Report von Oncrawl vergleicht die Daten und gibt Ihnen diese Informationen.

Quelle: Oncrawl-Anwendung

Quelle: Oncrawl-Anwendung

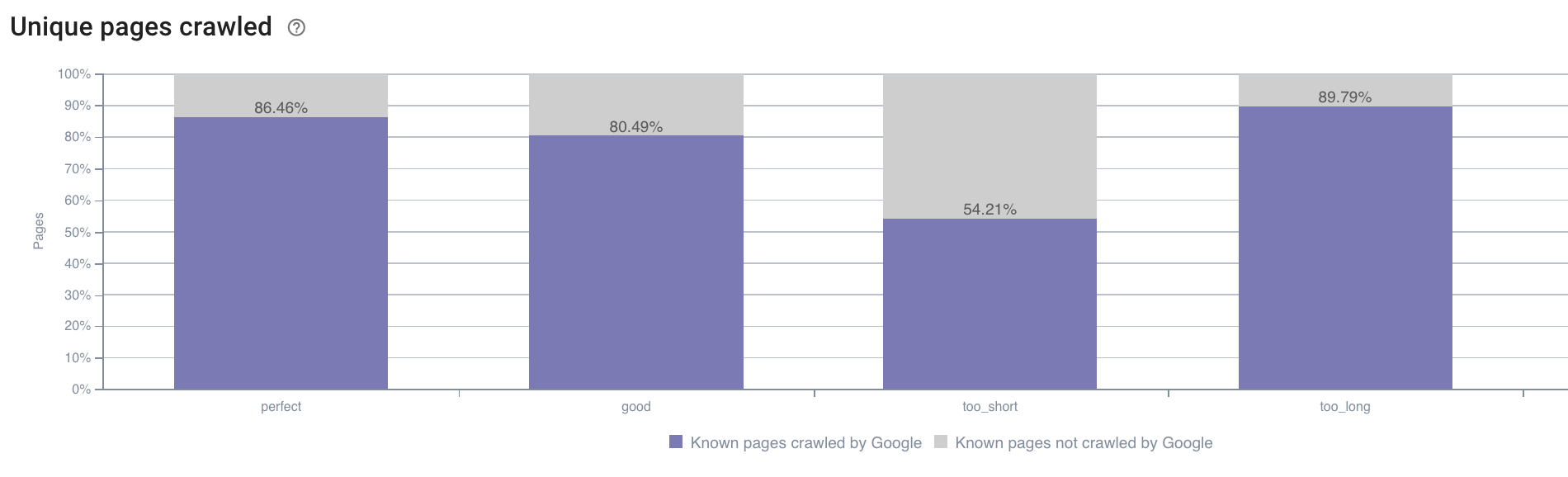

- Möglicherweise haben wir auch Fragen außerhalb dessen, was der Oncrawl-Crawling-Bericht standardmäßig bietet. Hat beispielsweise die Länge der Beschreibung einen Einfluss auf das Verhalten des Googlebots? Dank des Crawls haben wir die Daten dazu, sodass wir sie verwenden können, um eine Segmentierung wie folgt zu erstellen:

Quelle: Oncrawl-Anwendung

Zu kurze Beschreibungen werden deutlich weniger gecrawlt als solche mit der hier von der Oncrawl-Anwendung als „perfekt“ oder „gut“ bezeichneten Idealgröße (zwischen 110 und 169 Zeichen).

Wenn die Beschreibung unter anderem die Kriterien Relevanz und Größe erfüllt, erhöht der Googlebot gerne sein Crawl-Budget auf relevanten Seiten.

Hinweis: Seiten, die als zu lang erachtet werden, werden manchmal von Google umgeschrieben.

Analysieren Sie Website-Besuche mithilfe von Protokollen

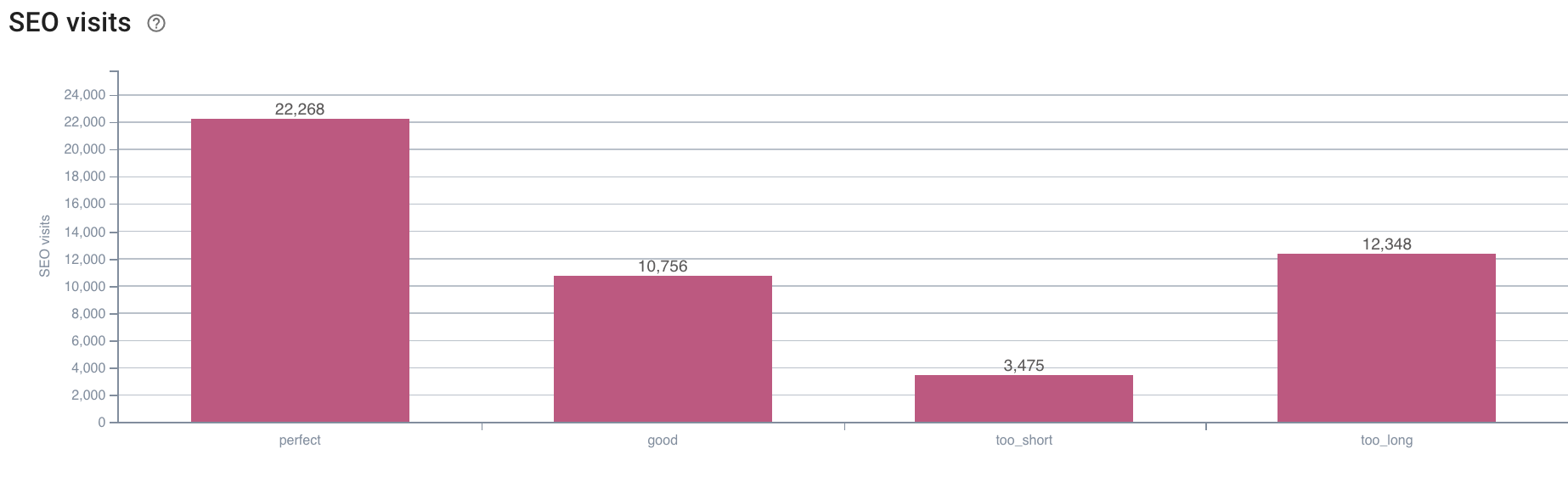

Wenn wir uns als nächstes das Beispiel von SEO ansehen, da wir versuchen, dies mit Oncrawl zu analysieren, schlage ich vor, dass Sie sich eine andere Frage stellen:

- Welcher Zusammenhang besteht zwischen dem Verhalten des Googlebots und SEO-Besuchen?

Oncrawl verfügt über dieselben Diagramme, um die Daten zwischen denen des Crawls und den in den Protokollen abgerufenen SEO-Besuchen abzugleichen.

Quelle: Oncrawl-Anwendung

Quelle: Oncrawl-Anwendung

Die Antwort ist ganz klar: Die Seiten mit einer „perfekten“ Beschreibungslänge scheinen die meisten SEO-Besuche zu generieren. Deshalb müssen wir unsere Anstrengungen auf diese Achse konzentrieren. Neben der „Fütterung“ des Googlebots scheinen die Nutzer die Relevanz der Beschreibung zu schätzen.

Die Oncrawl-App liefert ähnliche Daten für viele andere KPIs. Fühlen Sie sich frei, Ihre Hypothesen zu überprüfen!

Abschließend

Jetzt, da Sie die Möglichkeit kennen und verstehen, was dank der Protokolle jeden Tag auf Ihrer Website passiert, ermutige ich Sie, die Internetbenutzer und Roboterbesuche zu analysieren, um verschiedene Möglichkeiten zur Optimierung Ihrer Website zu finden. Die Antworten können technischer oder inhaltlicher Natur sein, aber denken Sie daran, dass eine gute Segmentierung der Schlüssel zu einer guten Analyse ist.

Eine solche Analyse ist mit den Tools von Google Analytics jedoch nicht möglich; ihre Daten können manchmal mit denen unseres Crawlers verwechselt werden. Es ist auch eine gute Lösung, möglichst viele Daten zur Verfügung zu haben.

Um noch mehr aus Ihren Protokolldaten und Crawl-Analysen herauszuholen, können Sie sich gerne eine Studie des Oncrawl-Teams ansehen, die 5 SEO-KPIs in Bezug auf Protokolle auf E-Commerce-Websites zusammenstellt.