Webinar Digest: Live-SEO-Audit und Protokolldateien mit Bill Hartzer

Veröffentlicht: 2018-10-02Am 25. September freute sich OnCrawl, Bill Hartzer für ein Webinar über die Analyse von Protokolldateien und warum sie für SEO-Audits wichtig ist, zu empfangen. Er ging seine eigene Website durch, um die Auswirkungen von Optimierungen auf Bots-Aktivität und Crawl-Frequenz zu zeigen.

Wir stellen Bill Hartzer vor

Bill Hartzer ist ein SEO-Berater und Experte für Domainnamen mit über 20 Jahren Erfahrung. Bill ist international als Experte auf seinem Gebiet anerkannt und wurde kürzlich von CBS News als einer der führenden Suchexperten des Landes interviewt.

Im Laufe dieses einstündigen Webinars gibt uns Bill einen Einblick in seine Protokolldateien und erläutert, wie er sie im Zusammenhang mit einem Site-Audit verwendet. Er stellt die verschiedenen Tools vor, die er verwendet, um die Website-Performance und das Bot-Verhalten auf seiner Website zu überprüfen.

Abschließend beantwortet Bill Fragen zur Verwendung von OnCrawl zur Visualisierung aussagekräftiger Ergebnisse und gibt Tipps für andere SEOs.

So greifen Sie über das cPanel-Plugin für WordPress auf Ihre Protokolldateien zu

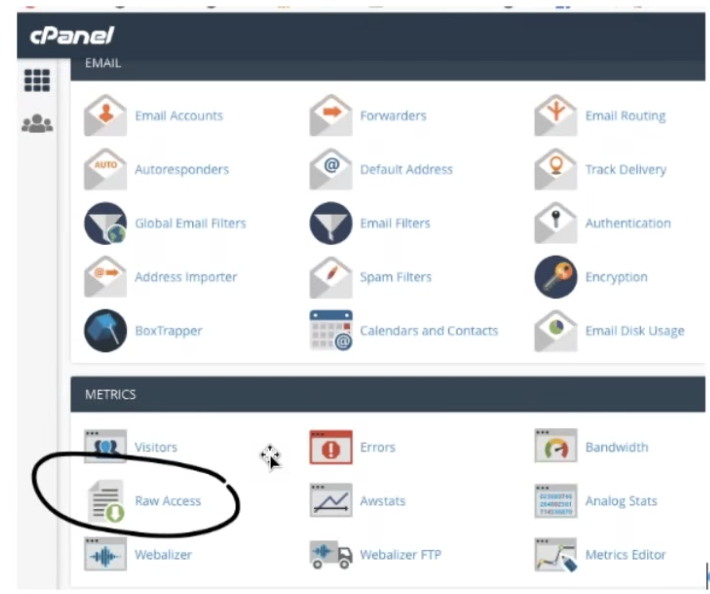

Wenn Ihre Website mit WordPress erstellt wurde und Sie das Plugin cPanel verwenden, finden Sie Ihre Serverprotokolle direkt in der WordPress-Oberfläche.

Navigieren Sie zu Metriken und dann zu Raw Access. Dort können Sie tägliche Protokolldateien aus dem Dateimanager sowie gezippte Archive älterer Protokolldateien herunterladen.

Untersuchen Sie den Inhalt einer Protokolldatei

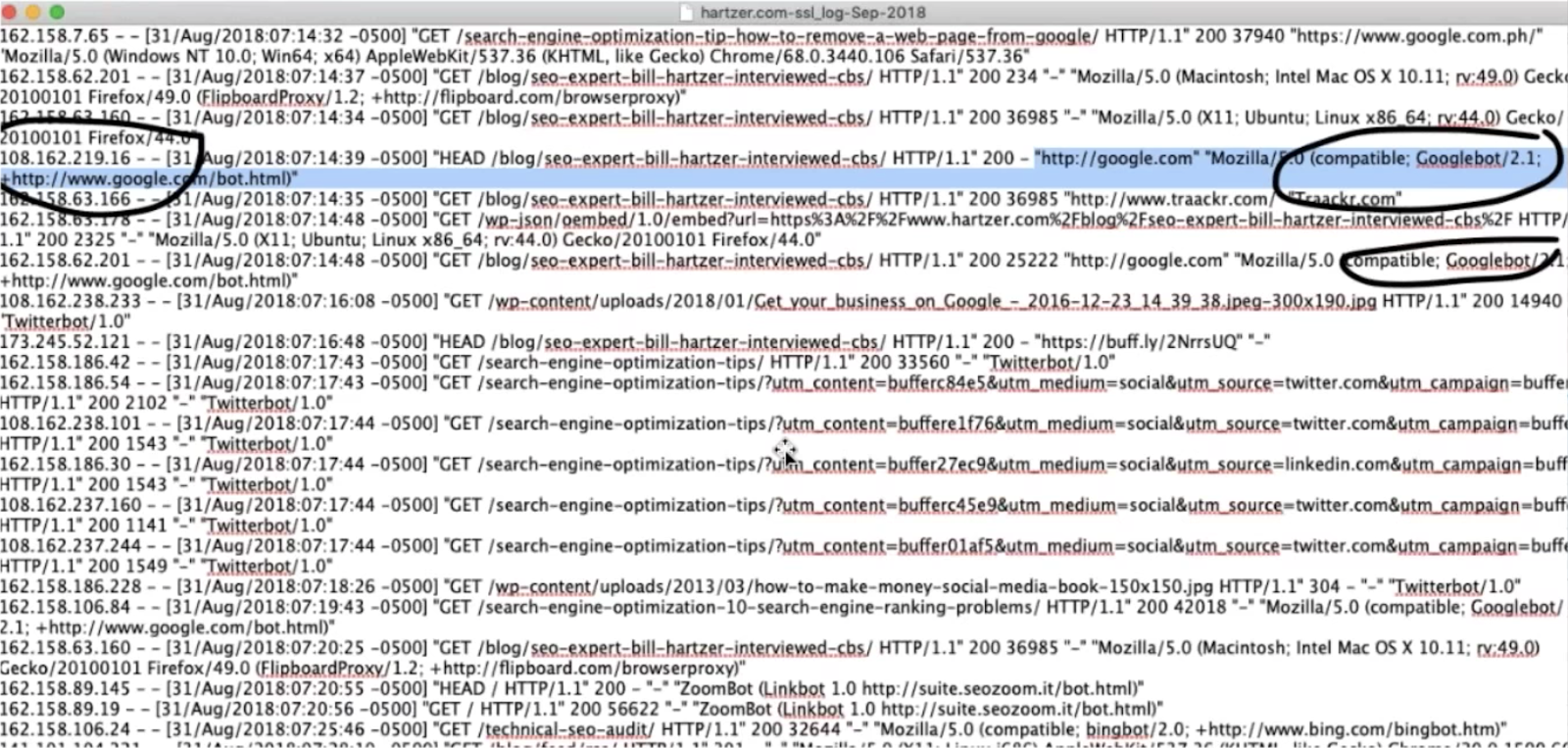

Eine Protokolldatei ist eine große Textdatei, die Informationen über alle Besucher Ihrer Website enthält, einschließlich Bots. Sie können es mit einem einfachen Texteditor öffnen.

Es ist nicht schwierig, potenzielle Bot-Treffer von Googlebot oder Bing zu erkennen, die sich selbst in den Protokolldateien identifizieren, obwohl es eine gute Idee ist, die Bot-Identifizierung mithilfe von IP-Lookups zu bestätigen.

Möglicherweise finden Sie auch andere Bots, die Ihre Website crawlen, die für Sie jedoch möglicherweise nicht nützlich sind. Sie können den Zugriff dieser Bots auf Ihre Website blockieren.

OnCrawl verarbeitet die Rohanalysen in Ihren Protokolldateien, um Ihnen einen klaren Überblick über die Bots zu geben, die Ihre Website besuchen.

Verwenden Ihrer Protokolldateien für weitere Informationen zu Crawl-Statistiken

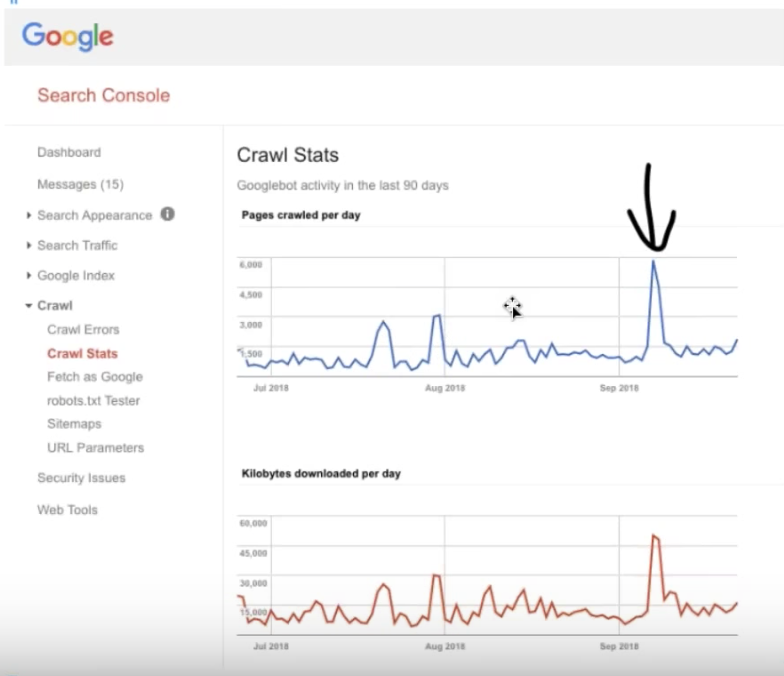

Informationen zu Crawl-Statistiken sind in der alten Version der Google Search Console unter Crawl > Crawl-Statistiken verfügbar und erhalten im Vergleich zu Informationen in Ihren Protokolldateien eine neue Bedeutung.

Sie sollten sich darüber im Klaren sein, dass die in der Google Search Console angezeigten Daten nicht auf die SEO-Bots von Google beschränkt sind und daher weniger nützlich sein können als die genaueren Informationen, die Sie durch die Analyse Ihrer Protokolldateien erhalten können.

Kürzlich aufgetretene ungewöhnliche Crawling-Aktivitäten

Bill sieht sich drei aktuelle Spitzen an, die in den Crawling-Statistiken in der Google Search Console sichtbar sind. Diese entsprechen großen Ereignissen, die eine erhöhte Crawling-Aktivität auslösen.

Mobile First Indexierungsspitze

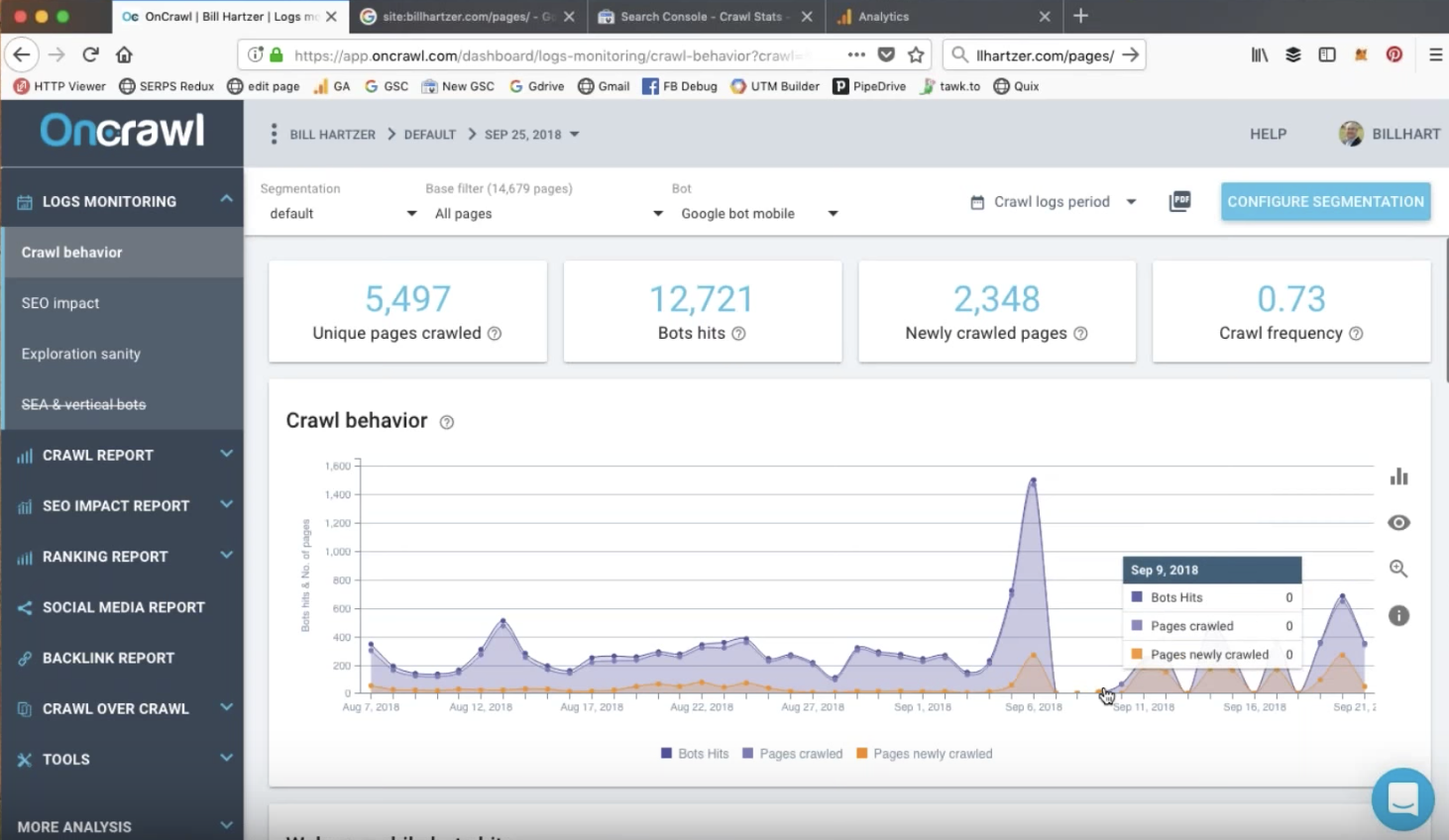

Der Anstieg am 7. September in der Google Search Console scheint zunächst nichts mit Ereignissen auf der Website zu tun zu haben. Ein Blick in die Log-Analyse in OnCrawl lieferte jedoch Hinweise:

Die Analyse der Protokolldateien ermöglicht es uns, die Aufschlüsselung der verschiedenen Bots zu sehen, die Google zum Crawlen von Seiten verwendet. Es wird deutlich, dass die Aktivität des Desktop-Googlebot vor diesem Datum stark zurückgegangen ist und dass diese Spitze – anders als die früheren, kleineren Spitzen – fast ausschließlich aus Treffern auf eindeutige, bereits indexierte Seiten durch den mobilen Google-Bot bestand.

Ein von Google Analytics aufgezeichneter Anstieg des organischen Verkehrs um 50 % bestätigte, dass dieser Anstieg der Mobile-First-Indexierung der Website Anfang September entspricht, Wochen vor der von Google gesendeten Warnung!

Änderung der URL-Struktur für die Website

Mitte August hat Bill Änderungen an seiner URL-Struktur vorgenommen, um sie SEO-freundlicher zu machen.

Die Google Search Console verzeichnete direkt nach dieser Änderung zwei große Spitzen, was bestätigt, dass Google wichtige Website-Ereignisse identifiziert und sie als Signale zum erneuten Crawlen der URLs der Website verwendet.

Wenn wir die Aufschlüsselung dieser Treffer in OnCrawl beobachten, wird deutlich, dass die zweite Spitze weniger eine Spitze ist, sondern dass die hohe Crawling-Rate von Seiten auf dieser Website über mehrere Tage anhält. Es ist klar, dass Google die Änderungen aufgegriffen hat, wie Bill bestätigen kann, indem er die Unterschiede in der Crawling-Aktivität in den Tagen nach seinen Änderungen beobachtet.

Nützliche OnCrawl-Berichte und -Funktionen zur Durchführung eines technischen Audits

SEO-Besuche und SEO-aktive Seiten

OnCrawl verarbeitet Ihre Protokolldateidaten, um genaue Informationen über SEO-Besuche oder menschliche Besucher bereitzustellen, die von Google SERP-Einträgen kommen.

Sie können die Anzahl der Besuche verfolgen oder sich SEO-aktive Seiten ansehen, bei denen es sich um einzelne Seiten auf der Website handelt, die organischen Traffic erhalten.

Eine Sache, die Sie im Rahmen eines Audits untersuchen sollten, wäre der Grund, warum einige Ranking-Seiten keinen organischen Traffic erhalten (oder mit anderen Worten keine SEO-aktiven Seiten sind).

Frischer Rang

Metriken wie der Fresh Rank von OnCrawl liefern wichtige Informationen. In diesem Fall: die durchschnittliche Verzögerung in Tagen zwischen dem ersten Crawlen einer Seite durch Google und dem ersten SEO-Besuch der Seite.

Der #FreshRank hilft Ihnen zu wissen, wie viele Tage eine Seite zum ersten Mal gecrawlt werden muss und um ihren ersten #SEO-Besuch zu erhalten #oncrawlwebinar pic.twitter.com/WVojWXKStC

– OnCrawl (@OnCrawl) 25. September 2018

Content-Promotion-Strategien und die Entwicklung von Backlinks können dazu beitragen, schneller Traffic für eine neue Seite zu generieren. Einige Seiten auf der Website in diesem Audit, wie z. B. Blog-Posts, die über soziale Netzwerke beworben wurden, erhielten einen viel niedrigeren Fresh Rank.

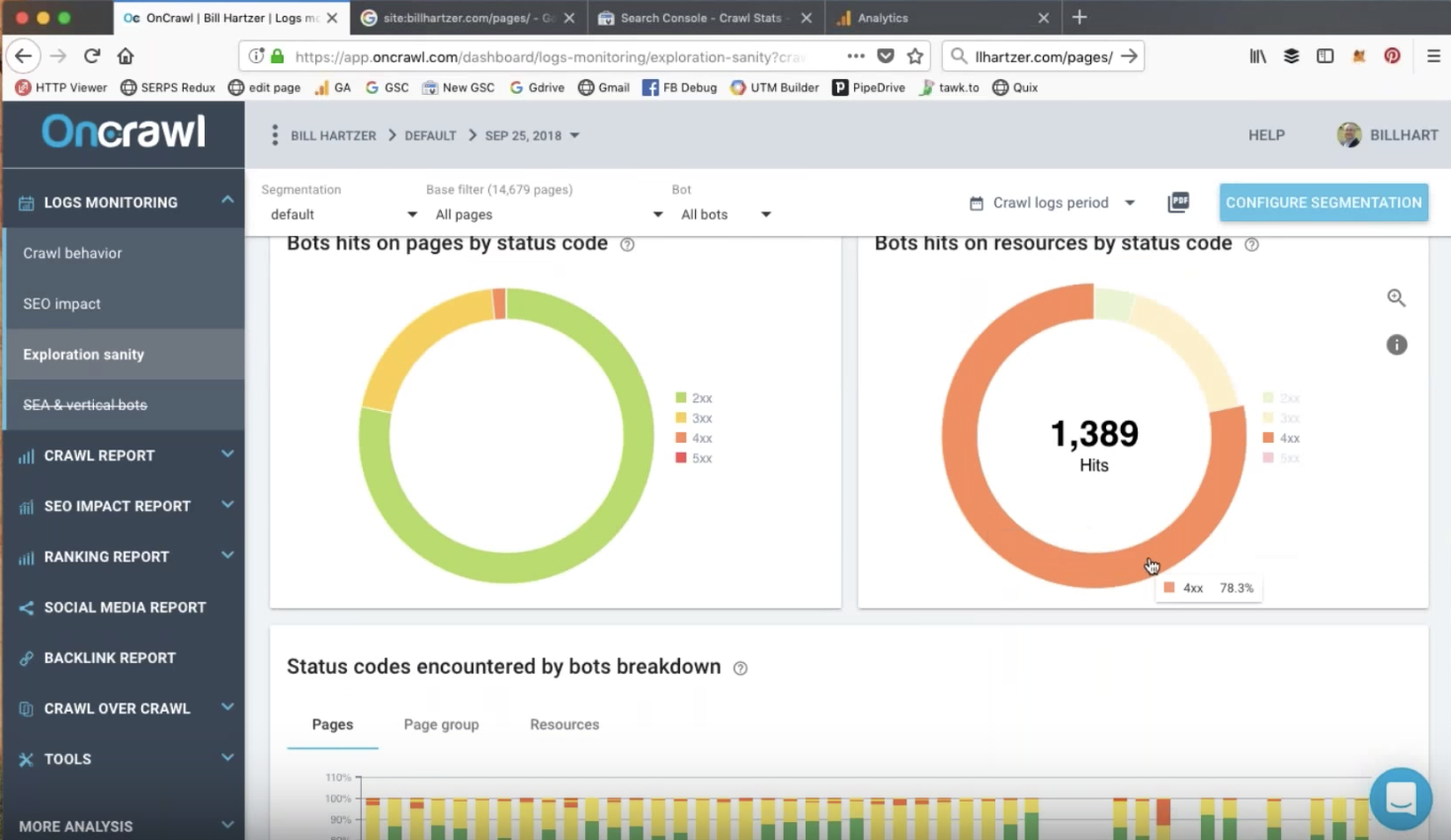

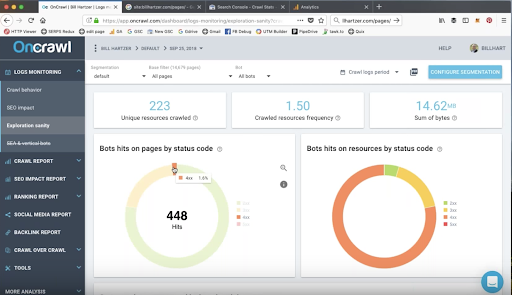

Bot-Treffer auf Seiten und Ressourcen nach Statuscode

Bots besuchen möglicherweise URLs, die 404- oder 410-Fehler zurückgeben. Dies kann Ressourcen wie CSS, JavaScript, PDFs oder Bilddateien betreffen.

Dies sind Elemente, die Sie während eines Audits unbedingt untersuchen möchten. Das Umleiten dieser URLs und das Entfernen interner Links zu ihnen kann schnelle Erfolge bringen.

Während eines Audits kann es hilfreich sein, sich Notizen zu Elementen zu machen, die behandelt werden sollten, z. B. URLs, die Statusfehler an Bots zurückgeben.

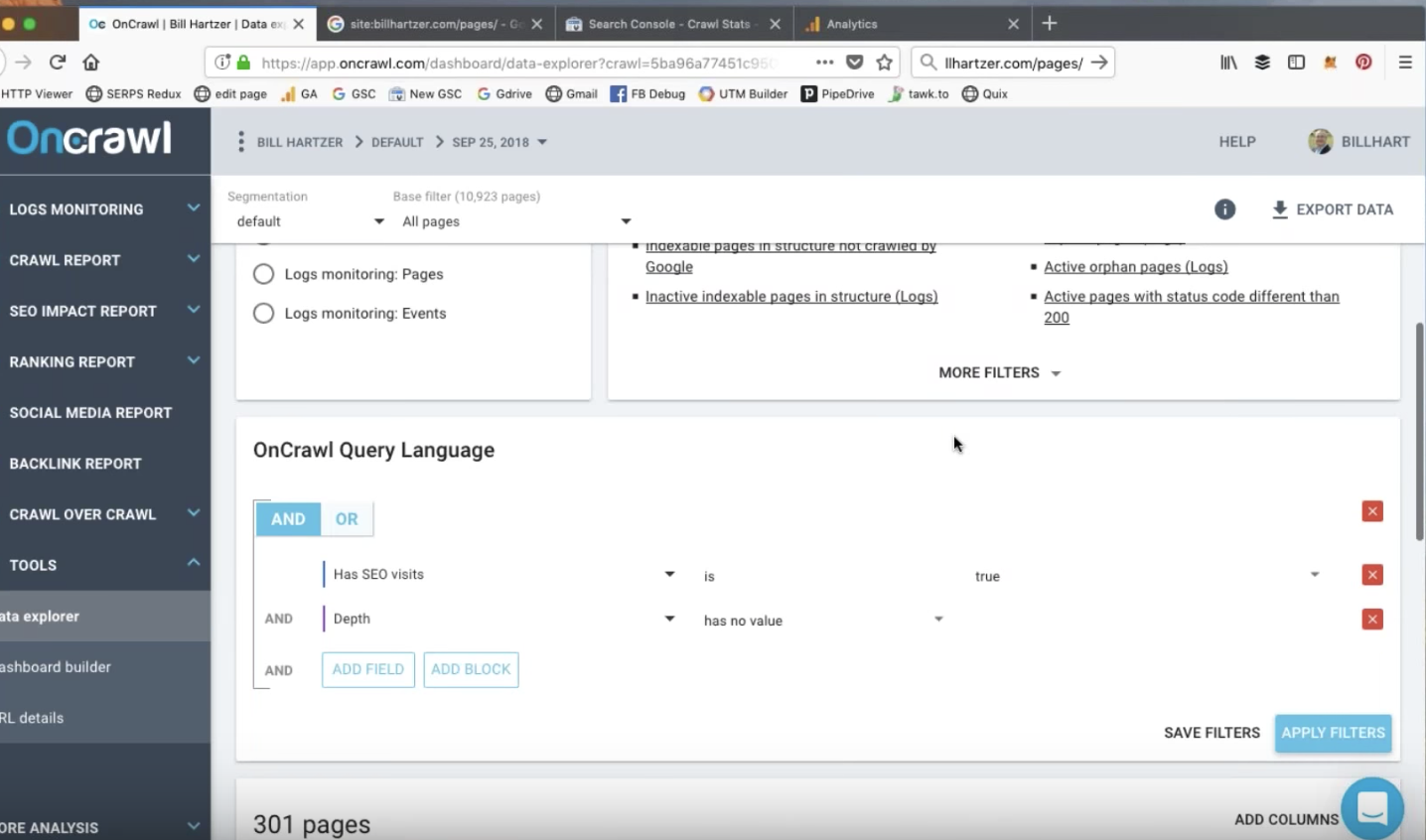

Data Explorer-Berichte: Benutzerdefinierte Berichte

Der OnCrawl Data Explorer bietet Schnellfilter, um Berichte zu erstellen, die Sie interessieren könnten, aber Sie können auch Ihre eigenen Berichte basierend auf den Kriterien erstellen, die Sie interessieren. Beispielsweise möchten Sie möglicherweise SEO-aktive Seiten mit Bounces und einer hohen Ladezeit befragen.

Data Explorer-Berichte: Aktive verwaiste Seiten

Durch die Kombination von Analyse-, Crawl- und Protokolldateidaten kann OnCrawl Ihnen dabei helfen, Seiten mit organischen, menschlichen Besuchen zu entdecken, die Ihrer Website nicht immer einen Mehrwert bringen. Der Vorteil der Verwendung von Daten aus Protokolldateien besteht darin, dass Sie jede Seite Ihrer Website entdecken können, die besucht wurde, einschließlich Seiten, die möglicherweise keinen Google Analytics-Code enthalten.

Bill konnte organische SEO-Besuche auf RSS-Feed-Seiten identifizieren, wahrscheinlich durch Links von externen Quellen. Diese Seiten sind verwaiste Seiten auf seiner Website; sie haben keine „übergeordnete“ Seite, die auf sie verlinkt. Diese Seiten bringen keinen zusätzlichen Wert für seine SEO-Strategie, erhalten aber dennoch einige Besuche durch organischen Traffic.

Diese Seiten sind großartige Kandidaten, um mit der Optimierung zu beginnen.

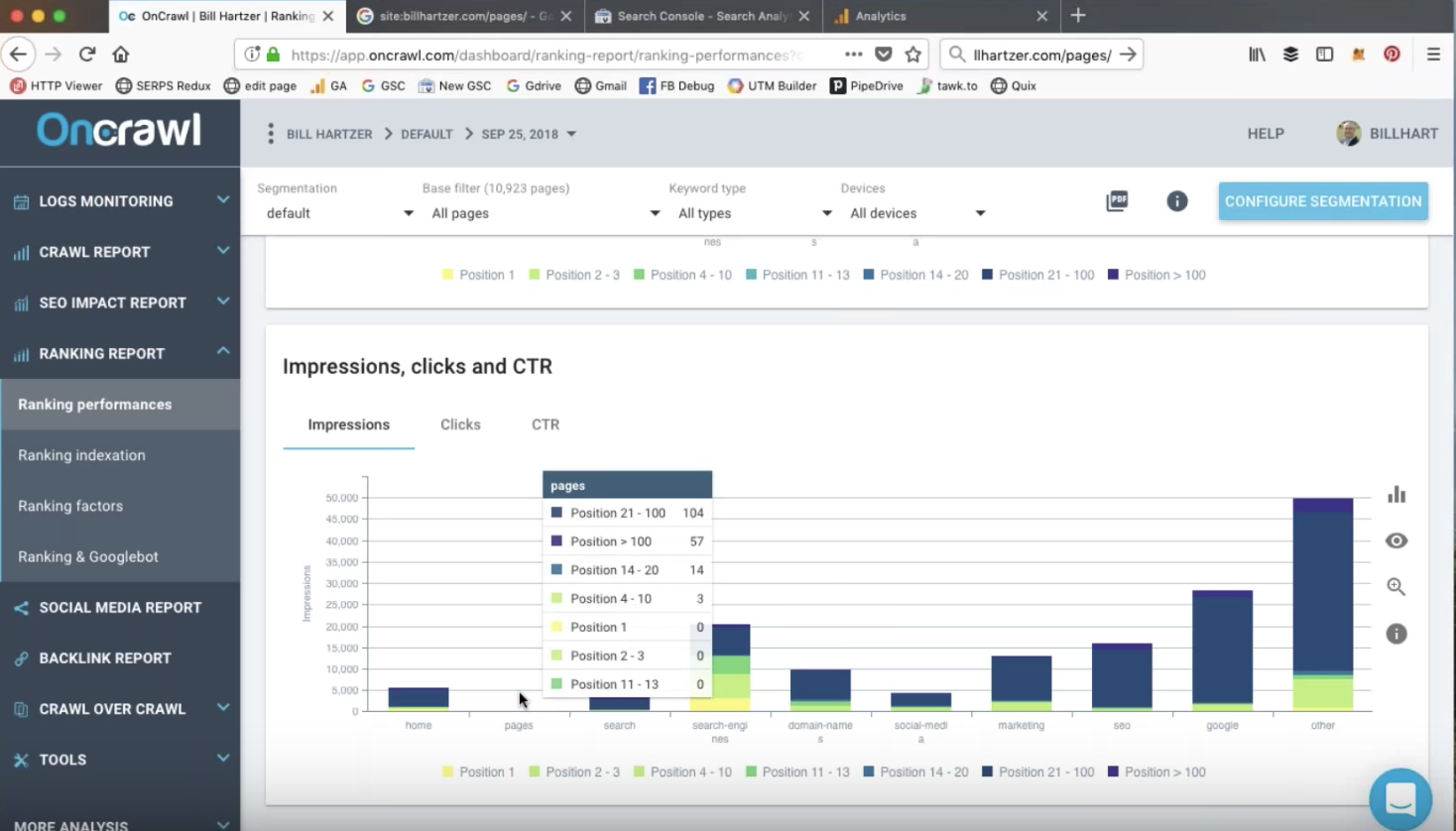

Suchanalysen für Keyword-Rankings

Daten für Rankings können aus der Google Search Console bezogen werden. Direkt in der alten Version der Google Search Console können Sie zu Suchverkehr und dann zu Suchanalysen gehen und Klicks, Impressionen, CTR und Positionen für die letzten 90 Tage anzeigen.

OnCrawl bietet klare Berichte darüber, wie sich diese Informationen auf die gesamte Website beziehen, sodass Sie die Gesamtzahl der Seiten auf der Website, die Anzahl der Seiten im Ranking und die Anzahl der Seiten, die Klicks erhalten, vergleichen können.

Impressionen, CTRs und Klicks

Durch die Website-Segmentierung können Sie auf einen Blick feststellen, welche Arten oder Gruppen von Seiten auf Ihrer Website ranken und auf welcher Seite der Ergebnisse.

Bei diesem Audit kann Bill die Metrik von OnCrawl verwenden, um die Arten von Seiten zu erkennen, die tendenziell gut ranken. Dies sind die Arten von Seiten, von denen er weiß, dass er sie weiterhin erstellen sollte, um den Traffic auf der Website zu erhöhen.

Klicks auf Ranking-Seiten sind stark mit der Ranking-Position korreliert: Positionen über 10 befinden sich nicht mehr auf der ersten Seite der Suchergebnisse, dann sinkt die Anzahl der Klicks bei den meisten Keywords stark ab.

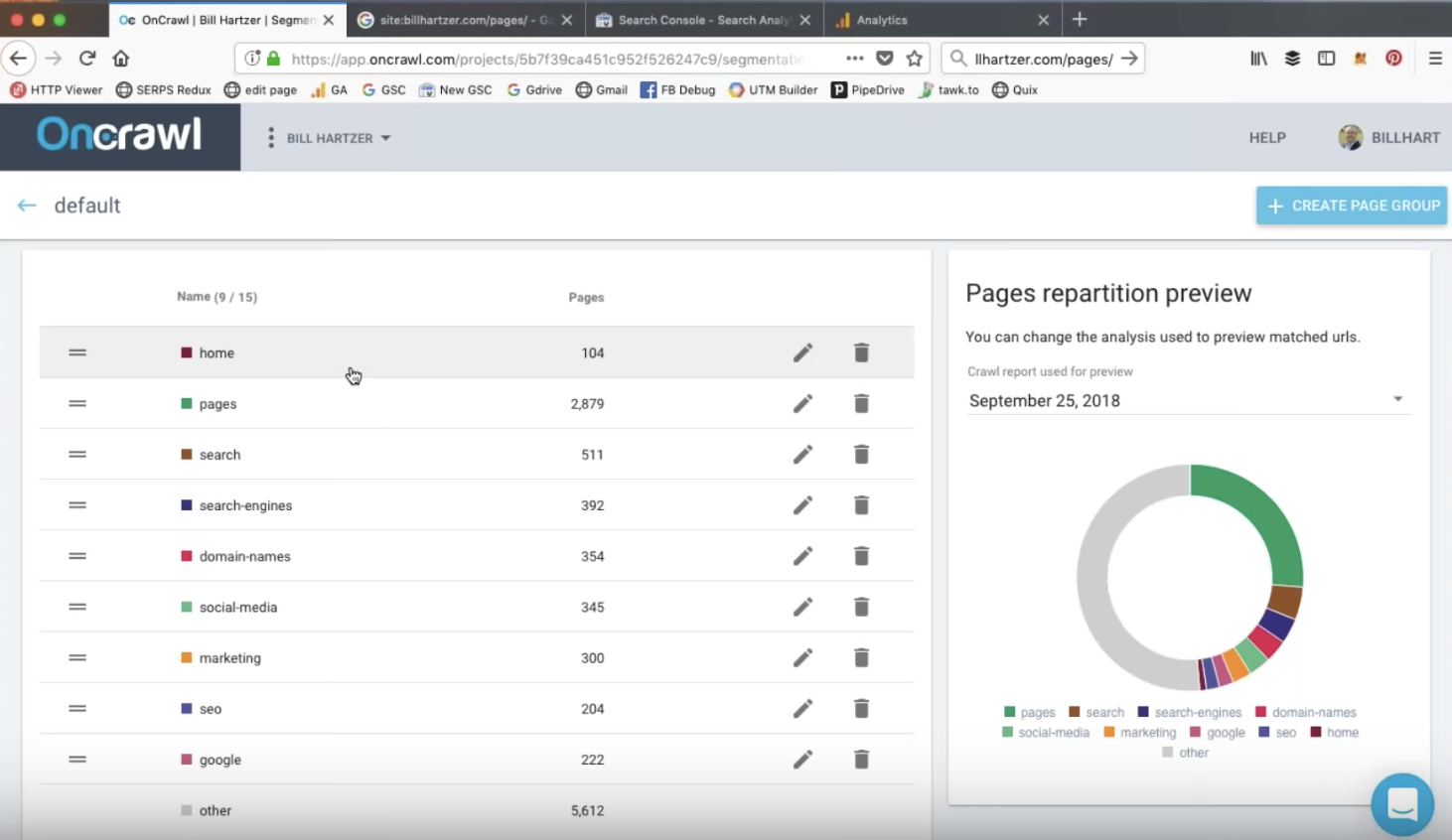

Website-Segmentierung

Die Segmentierung von OnCrawl ist eine Möglichkeit, Ihre Seiten in aussagekräftige Sätze zu gruppieren. Während eine automatische Segmentierung bereitgestellt wird, können Sie die Filter bearbeiten oder Ihre eigenen Segmentierungen von Grund auf neu erstellen. Mit den Filtern der OnCrawl-Abfragesprache können Sie Seiten basierend auf vielen verschiedenen Kriterien in eine Gruppe ein- oder ausschließen.

Auf der Website, die sich Bill im Webinar ansieht, basiert die Segmentierung auf den verschiedenen Verzeichnissen auf der Website.

Seiten in Struktur > gecrawlt > bewertet > aktiv

Im OnCrawl-Ranking-Bericht kann Sie das Diagramm „Seiten in Struktur > gecrawlt > bewertet > aktiv“ auf Probleme beim Ranking und Besuch Ihrer Seiten hinweisen.

Dieses Diagramm zeigt Ihnen:

- Seiten in der Struktur: Die Anzahl der Seiten, die über die verschiedenen Links auf Ihrer Website erreicht werden können

- Gecrawlt: Seiten, die Google gecrawlt hat

- Ranking: Seiten, die in Google SERPs erschienen sind

- Aktiv: Seiten, die organische Besuche erhalten haben

Ihr Audit wird die Gründe für die Unterschiede zwischen den Balken in diesem Diagramm untersuchen wollen.

Unterschiede zwischen der Anzahl der Seiten in der Struktur und der Anzahl der gecrawlten Seiten können jedoch beabsichtigt sein, beispielsweise wenn Sie Google daran hindern, bestimmte Seiten zu crawlen, indem Sie Robots in der robots.txt-Datei untersagen. Dies ist etwas, das Sie während Ihres Audits überprüfen möchten.

Sie können sich diese Art von Daten in OnCrawl ansehen, indem Sie auf das Diagramm klicken.

Die zentralen Thesen

Die Analyse von Protokolldateien hilft Ihnen, Spitzen bei Bot-Treffern zu erkennen und die Bot-Aktivität täglich zu überwachen #oncrawlwebinar

Das heutige Webinar mit @bhartzer pic.twitter.com/3DAC5d36j9– OnCrawl (@OnCrawl) 25. September 2018

Zu den wichtigsten Erkenntnissen aus diesem Webinar gehören:

- Große Änderungen in der Struktur einer Website können zu großen Änderungen in der Crawling-Aktivität führen.

- Die kostenlosen Tools von Google melden aggregierte, gemittelte oder gerundete Daten, die ungenau aussehen können.

- Protokolldateien ermöglichen es Ihnen, echtes Bot-Verhalten und organische Besuche zu sehen. In Kombination mit Crawling-Daten und täglicher Überwachung sind sie ein leistungsstarkes Tool zur Erkennung von Spitzen.

- Genaue Daten sind notwendig, um zu verstehen, warum und was passiert ist, und dies kann nur durch eine übergreifende Analyse von Analysen, Crawling, Rankings und – insbesondere – Protokolldateidaten in einem Tool wie OnCrawl erreicht werden.

Testen Sie OnCrawl kostenlos

Sind Sie daran interessiert, diese Techniken auf Ihrer Website anzuwenden, um umsetzbare Audit-Erkenntnisse zu erhalten?

Live verpasst? Sehen Sie sich die Wiederholung an!

Auch wenn Sie nicht am Live-Webinar teilnehmen oder nicht an der gesamten Sitzung teilnehmen konnten, können Sie sich dennoch die vollständige Version ansehen.