Alles über A/A-Tests: Warum und wann sollten Sie A/A-Tests durchführen?

Veröffentlicht: 2022-07-07

A/A-Testing ermöglicht es Ihnen, zwei identische Seiten gegeneinander zu testen und kann äußerst nützlich sein, wenn Sie ein neues A/B-Testing-Tool einrichten.

A/A-Tests können verwendet werden

- die Genauigkeit einer A/B-Testplattform bewerten,

- festzustellen, ob Ihre A/B-Testplattform vollständig in Ihre internen Analysen integriert ist,

- identifizieren Sie mögliche technische Probleme mit Ihrem A/B-Testing-Tool,

- Bereitstellung einer Basis-Conversion-Rate für eine Seite oder einen Trichter,

- Bestimmen Sie die geeignete Stichprobengröße für Ihre A/B-Tests und

- Benchmarken Sie die Leistung Ihrer Seiten und Trichter.

Convert bietet sowohl A/A- als auch A/B-Testfunktionen, um sicherzustellen, dass Sie alles haben, was Sie zum erfolgreichen Entwerfen und Entwickeln einer Website mit hoher Konvertierungsrate benötigen.

Lesen Sie weiter, um mehr über die Bedeutung von A/A-Tests zu erfahren und wie Sie Ihre erste Erfahrung aufbauen können!

- Was ist A/A-Test?

- Warum A/A-Tests durchführen?

- Überprüfen Sie die Genauigkeit der A/B-Testplattform

- Bestimmen Sie den Umfang der Integration mit Ihren internen Analysen

- Identifizieren Sie mögliche technische Probleme

- Geben Sie die Baseline-Conversion-Rate für jede Seite oder jeden Trichter an

- Finden Sie die erforderliche Stichprobengröße

- Benchmarken Sie die Leistung Ihrer Seiten und Trichter

- Einrichten einer A/A-Erfahrung

- Wie interpretiert man die A/A-Testergebnisse?

- Wir erwarten nicht schlüssige Ergebnisse bei einer A/A-Erfahrung

- Was bedeutet es, wenn Sie nicht identische Variationen erhalten?

- Was sind die Herausforderungen von A/A-Tests?

- Zufälligkeit

- Große Stichprobengröße

- Konvertieren Sie Erfahrungen und A/A-Tests

- Wie richte ich A/A-Tests in Convert Experiences ein?

- Das reine A/A-Erlebnis

- Das kalibrierte A/A/B- oder A/A/B/B-Erlebnis

- Führen Sie viele A/A-Erlebnisse durch

- Kann ich ein A/A-Erlebnis gleichzeitig mit einem A/B-Erlebnis durchführen?

- Pre-Test QA-Prozess: Eine interessante Alternative zu A/A-Tests

- Kann SRM bei A/A-Tests existieren?

- Wie richte ich A/A-Tests in Convert Experiences ein?

- Überwiegen die Vorteile von A/A-Tests die Nachteile?

Vielleicht ist Ihnen so etwas schon einmal passiert…

- Sie führen einen A/B-Test durch, um zu sehen, ob Ihre neue CTA-Schaltfläche und Überschrift die Conversions steigern werden.

- Im Laufe des nächsten Monats senden Sie die gleiche Menge an Zugriffen auf Ihre Kontroll- und Variationszielseiten.

- Ihre Software erklärt, dass Ihre Variante der Gewinner ist (mit 99%iger Sicherheit), also hören Sie auf.

- Sie starten dann Ihr „gewinnendes“ Design, aber nach mehreren Geschäftszyklen stellen Sie fest, dass die 50%ige Steigerung Ihrer Konversionsrate kaum Auswirkungen auf Ihr Nettoeinkommen hatte.

Die wahrscheinlichste Erklärung ist ein falsch positives Testergebnis. Glücklicherweise gibt es verschiedene Methoden, um mit falschen Tests umzugehen.

Einer, von dem Sie vielleicht schon gehört haben, ist der A/A-Test.

Was ist A/A-Test?

Bevor wir uns mit A/A-Tests befassen, lassen Sie uns über A/B-Tests sprechen, damit wir die Unterschiede aufzeigen können.

Bei einem typischen A/B-Erlebnis wird der Datenverkehr auf zwei oder mehr alternative Varianten aufgeteilt.

Eine Variation wird normalerweise als „Kontrolle“ oder „Original“ bezeichnet. Alle anderen Variationen der Erfahrung werden mit der Kontrolle verglichen, um zu bestimmen, welche den größten Auftrieb in einer bestimmten Metrik erzeugt.

A/A-Tests hingegen erfordern, dass der Verkehr zwei identischen Varianten zugewiesen wird, normalerweise unter Verwendung einer 50/50-Aufteilung.

Bei einem normalen A/B-Test geht es darum, eine höhere Conversion Rate zu finden, während bei einem A/A-Test meist geprüft wird, ob die Varianten den gleichen Lift haben.

Bei einem A/A-Test wird der Traffic nach dem Zufallsprinzip aufgeteilt, wobei beiden Gruppen dieselbe Seite angezeigt wird.

Dann werden die gemeldeten Konversionsraten, Klickraten und zugehörigen Statistiken für jede Gruppe protokolliert, in der Hoffnung, etwas zu lernen.

A/A-Test = 2 identische Seiten gegeneinander getestet

Schauen wir uns nun einige Beispiele an, wo A/A-Erfahrungen verwendet werden können, um festzustellen, ob sie für Sie nützlich sind.

Warum A/A-Tests durchführen?

Die Durchführung eines A/A-Tests kann in verschiedenen Phasen des Webdesign- und -entwicklungsprozesses besonders effektiv sein, z. B.:

- Wenn Sie die Installation eines neuen A/B-Testtools abgeschlossen haben,

- Wenn die Einrichtung Ihres aktuellen A/B-Testtools aktualisiert oder geändert wurde,

- Wenn Sie eine neue Website oder App erstellen,

- Wenn Sie Abweichungen zwischen den Datenberichten Ihres A/B-Tests und anderen von Ihnen verwendeten Analysetools feststellen.

Lassen Sie uns einen tieferen Einblick in jeden dieser Anwendungsfälle nehmen.

Überprüfen Sie die Genauigkeit der A/B-Testplattform

Eine A/A-Erfahrung kann entweder von einem Unternehmen gestartet werden, das eine A/B-Testplattform erwerben möchte, oder von einem Unternehmen, das eine neue Testsoftware ausprobieren möchte (um zu bestätigen, dass sie richtig eingerichtet ist).

Bei einem A/A-Erlebnis vergleichen wir zwei völlig identische Versionen derselben Seite mit dem Ziel, ähnliche Conversion-Werte zu erzielen.

Das erwartete Ergebnis ist nicht schlüssig, wenn es keinen Unterschied zwischen der Kontrolle und der Variation gibt.

Trotzdem wird manchmal ein „Gewinner“ auf zwei identischen Exemplaren erklärt.

In diesem Fall ist es wichtig, die A/B-Testplattform zu bewerten, da das Tool möglicherweise falsch konfiguriert oder unwirksam ist.

Als nächsten Schritt sollten Sie:

- Überprüfen Sie, ob Sie den A/B-Tracking-Code korrekt installiert haben

- Überprüfen Sie Ihren Standortbereich

- Überprüfen Sie Ihre Zielgruppen

- Überprüfen Sie Ihre Ziele

- Wenden Sie sich an das Supportteam für A/B-Tests, um herauszufinden, ob es etwas ist, das gelöst werden kann, bevor Sie Ihre Plattform verlassen.

Hoffentlich ist das Problem eines der oben genannten. Wenn Sie das Problem nicht herausfinden können, bedeutet dies wahrscheinlich, dass der A/A-Test schlüssig und Ihre A/B-Testplattform ungenau ist.

Bestimmen Sie den Umfang der Integration mit Ihren internen Analysen

Wenn Sie die Genauigkeit einer A/B-Testplattform überprüfen, können Sie mit einem A/A-Test beurteilen, ob die Plattform vollständig in Ihr Analysetool integriert ist.

Unabhängig davon, ob Sie Google Analytics, Heap Analytics, Adobe Analytics, Plausible, Matomo oder andere verwenden, können Sie die A/A-Testergebnisse mit Ihrem internen Analysetool vergleichen, um festzustellen, ob die Integration wie erwartet funktioniert hat.

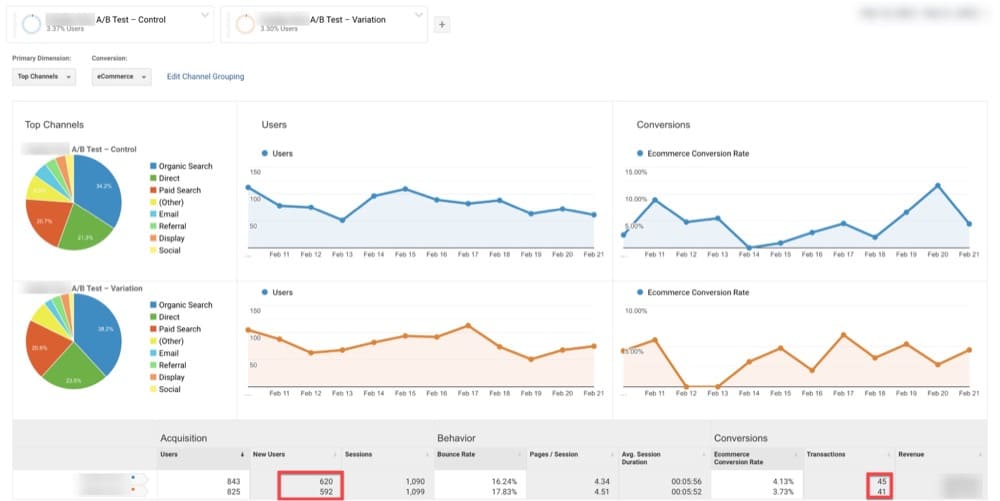

Zum Beispiel unten hat GA 620 Besucher auf dem Original und 592 auf der Variation (identische Seite mit Original) identifiziert.

Für denselben Zeitraum zeigte Convert 972 Besucher auf dem Original und 980 auf der Variation (identische Seite mit Original).

Dies könnte ein Zeichen dafür sein, dass die Integration zwischen den beiden Plattformen nicht wie erwartet funktioniert.

Identifizieren Sie mögliche technische Probleme

Sie können auch einen A/A-Test verwenden, um mögliche technische Probleme zu identifizieren.

Die meisten A/B-Testsoftware verwenden Methoden, die etwas anders sind und zu erheblichen Abweichungen führen können, je nachdem, wie weit das Programm gepusht wird.

Dies mag wie eine Anomalie erscheinen, könnte aber auch auf ein ernsteres zugrunde liegendes Problem mit einem der folgenden hinweisen:

- Mathematische und statistische Formeln

- Randomisierungsalgorithmen

- Browser-Cookies

Sie können A/A-Erfahrungen verwenden, um die oben genannten Probleme aufzudecken.

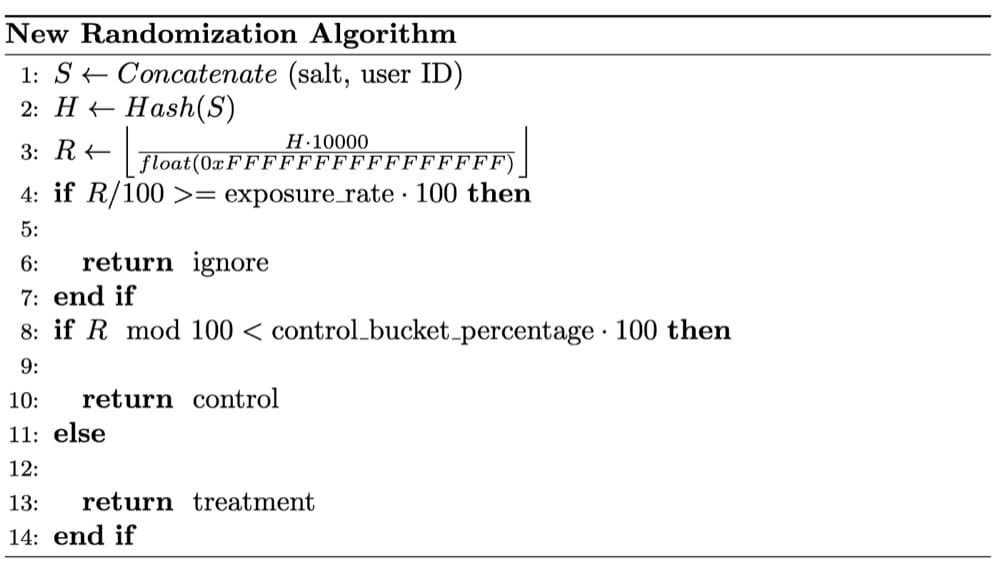

Im folgenden Fall bemerkten Data Scientists von Wish SRM-Bedenken bei einem A/A-Test. Nach einer gründlichen Untersuchung wurde festgestellt, dass das SRM dadurch verursacht wurde, dass ihre Randomisierung nicht vollständig zufällig war.

Die Randomisierungstechnik ist entscheidend für zuverlässige Versuchsergebnisse.

Die Verwendung von Zufallsstichproben ist eine wesentliche Annahme der statistischen Tests, die beim A/B-Testing verwendet werden.

Die Randomisierung gleicht sowohl beobachtete als auch unbeobachtete Benutzerfaktoren zwischen Experiment-Buckets aus. Es stellt einen kausalen Zusammenhang zwischen der getesteten Produktfunktion und etwaigen Änderungen der Testergebnisse her.

Geben Sie die Baseline-Conversion-Rate für jede Seite oder jeden Trichter an

Wenn Sie eine Zahl verbessern möchten, müssen Sie zuerst verstehen, wie ihre Grundlinie aussieht. Dies kann Ihre Geschwindigkeit, Ihr Gewicht oder Ihre Laufzeit sein.

Ebenso müssen Sie vor der Durchführung eines A/B-Tests zunächst die Konversionsrate bestimmen, mit der Sie die Ergebnisse vergleichen. Dies ist Ihre Baseline-Conversion-Rate .

Sie haben wahrscheinlich schon von höheren Einnahmen gehört, die sich aus einer einzigen Erfahrung ergeben, aber das kann irreführend sein. Eine einzelne Erfahrung sagt Ihnen nicht, ob sich Ihre Website-Konvertierung verbessert hat.

Es ist wichtig, Ihre Baseline-Conversion-Rate zu kennen, denn wenn Sie den Anstieg jeder Erfahrung nicht quantifizieren können, müssen Sie die insgesamt erwarteten und erreichten Conversions regelmäßig vergleichen.

Mit etwas Glück trägt jede Erfahrung, die als „Gewinn“ gilt, dazu bei, dass Ihre Conversions die Erwartungen übertreffen.

Und wenn Sie dies oft genug tun, werden sich Ihre Conversions nur noch weiter verbessern!

Der A/A-Test hilft Ihnen dabei.

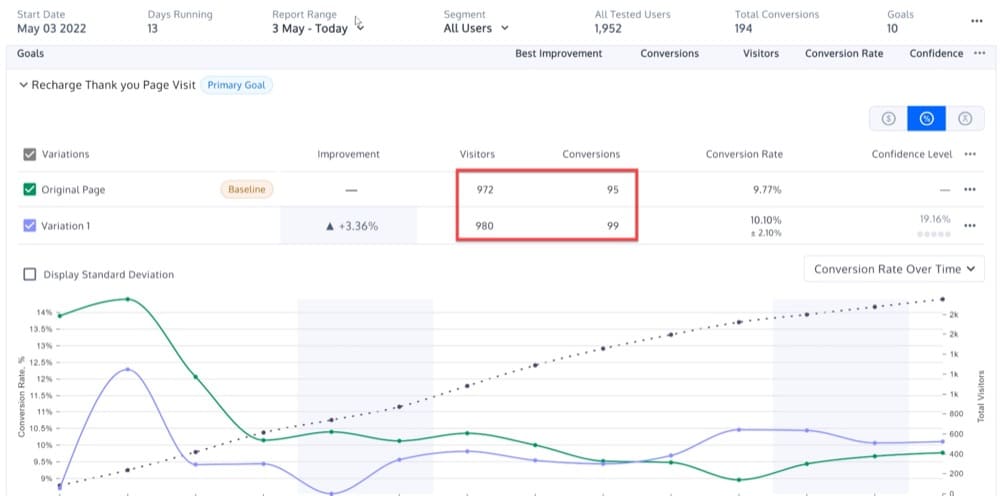

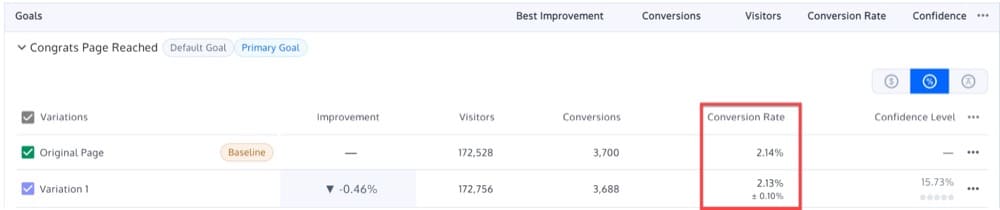

Angenommen, Sie führen einen A/A-Test auf einer Ihrer Zielseiten durch, wobei Original A und Variante B fast identische Ergebnisse liefern: 2,14 % und 2,13 %.

Infolgedessen kann die Baseline-Conversion-Rate auf 2,13-2,14 % festgelegt werden.

In diesem Sinne können Sie zukünftige A/B-Tests durchführen, mit dem Ziel, diesen Benchmark zu übertreffen.

Das Ergebnis ist statistisch nicht signifikant, wenn Sie einen A/B-Test auf einer neuen Version der Zielseite durchführen und eine Conversion-Rate von 2,15 % erhalten.

Finden Sie die erforderliche Stichprobengröße

Bevor Sie eine A/B-Erfahrung durchführen, überprüfen Sie Ihre Stichprobengrößen genau so, wie Sie es vor einem Roadtrip tun würden.

Sie werden den Erfahrungseffekt nicht beobachten, wenn es nicht genügend Beispiele (Benutzer) gibt. Wenn Sie andererseits zu viele Proben haben, riskieren Sie, den Fortschritt Ihres Teams zu verlangsamen, indem Sie die Leute ständig einer schlechten Erfahrung aussetzen.

Idealerweise sollten Sie niemals mit einer Erfahrung beginnen, ohne vorher festgelegt zu haben, wie viele Proben Sie sammeln werden.

Um zu verstehen, warum, bedenken Sie Folgendes:

Nehmen wir an, Sie haben eine Münze und Ihre Hypothese ist, dass sie eine 50/50-Chance hat, Kopf oder Zahl zu landen. Um das zu beweisen, wirfst du es hundertmal.

Aber nehmen wir an, Sie haben bei den ersten zehn Würfen zehn Zahlen und entscheiden, das Experiment dort abzubrechen.

Das Ablehnen der Nullhypothese (dass die Münze fair ist) mag statistisch signifikant erscheinen, aber Sie haben das Experiment vorzeitig abgebrochen. Sie haben keine Ahnung, wie lange das Experiment zu Beginn hätte dauern sollen.

Wenn Sie die Stichprobengröße nicht schätzen, können Sie möglicherweise auch nicht bestimmen, wie lange Sie die Erfahrung durchführen werden.

Wie gehen wir also vor?

A/A-Tests können Ihnen dabei helfen, herauszufinden, wie groß die Stichprobengröße ist, die Sie von Ihren Website-Besuchern benötigen.

Vielleicht unterscheiden sich Ihre Besucher am Montagmorgen statistisch gesehen völlig von Ihren Besuchern am Samstagabend. Und vielleicht unterscheiden sich Ihre Feiertagseinkäufer statistisch von denen, die außerhalb der Feiertage einkaufen.

Ihre Desktop-Kunden können sich statistisch von Ihren mobilen Kunden unterscheiden. Und Ihre Kunden, die über gesponserte Anzeigen kommen, sind nicht die gleichen wie diejenigen, die durch Mundpropaganda kommen.

Wenn Sie Ihre Ergebnisse innerhalb von Kategorien wie Geräten und Browsern anzeigen, werden Sie erstaunt sein, welche Trends Sie mit der richtigen Stichprobengröße aufdecken werden.

Wenn Ihre Stichprobengröße zu klein ist, sind die Ergebnisse natürlich möglicherweise nicht zuverlässig. Möglicherweise verpassen Sie einige Portionen, was sich auf Ihre Erlebnisergebnisse auswirken könnte.

Eine höhere Stichprobengröße erhöht die Wahrscheinlichkeit, dass alle Segmente eingeschlossen werden, die den Test beeinflussen.

Indem Sie einen A/A-Test durchführen, können Sie bestimmen, welche Stichprobengröße eine ideale Gleichheit zwischen Ihren identischen Variationen ermöglicht.

Kurz gesagt, ein A/A-Test hilft Ihnen, die geeignete Stichprobengröße zu bestimmen, die dann für zukünftige A/B-Tests verwendet werden kann.

Benchmarken Sie die Leistung Ihrer Seiten und Trichter

Wie viele Besucher kommen auf Ihre Startseite, Warenkorbseite, Produktseiten und andere Seiten?

Es ist Ihnen egal, ob Sie dabei einen Gewinner finden oder nicht. Vielmehr suchen Sie nach größeren Mustern für eine bestimmte Seite.

Diese Erfahrungen können Ihnen helfen, Fragen zu beantworten wie:

- Wie hoch ist die Makro-Conversion-Rate der Startseite?

- Wie sieht die Aufschlüsselung dieser Konversionsrate nach Besuchersegment aus?

- Wie sieht die Aufschlüsselung dieser Conversion-Rate nach Gerätesegment aus?

A/A-Erfahrungen bieten Ihnen eine Basis, mit der Sie neue A/B-Erfahrungen für jeden Teil Ihrer Website vergleichen können.

Man könnte argumentieren, dass Sie die gleichen Informationen durch die Analyse der Website erhalten können.

Aber das ist sowohl wahr als auch unwahr.

Das A/B-Test-Tool wird hauptsächlich verwendet, um einen Gewinner zu ermitteln (während Testdaten an Google Analytics gesendet oder andere Berechnungen durchgeführt werden), sodass Sie die Website-Metriken weiterhin beobachten möchten, wenn es ausgeführt wird.

Einrichten einer A/A-Erfahrung

A/A-Erfahrungen sind ein sehr wichtiges Instrument zur Optimierung der Conversion Rate.

Die Herausforderung bei einer A/A-Erfahrung besteht jedoch darin, zu entscheiden, welche Seite bei der Durchführung der Erfahrung verwendet werden soll.

Stellen Sie sicher, dass die Seite, die Sie für Ihre A/A-Erfahrungsseite auswählen, diese beiden Eigenschaften aufweist:

- Ein hohes Verkehrsaufkommen. Je mehr Personen eine Seite besuchen, desto eher werden Sie die Übereinstimmung zwischen den Variationen bemerken.

- Besucher haben die Möglichkeit zu kaufen oder sich anzumelden . Sie werden Ihre A/B-Testlösung bis zur Ziellinie optimieren wollen.

Diese Anforderungen sind der Grund, warum wir häufig A/A-Tests auf der Homepage einer Website durchführen.

Im nächsten Abschnitt werde ich ausführlicher erklären, wie man eine A/A-Testkampagne erstellt, aber kurz gesagt, hier ist, wie man einen A/A-Test auf der Homepage einer Website einrichtet:

- Erstellen Sie zwei identische Versionen derselben Seite: eine Kontrolle und eine Variation. Nachdem Sie Ihre Variationen erstellt haben, wählen Sie Ihre Zielgruppen mit identischen Stichprobenumfängen aus.

- Bestimmen Sie Ihren KPI. Ein KPI ist eine Metrik, die die Leistung im Laufe der Zeit misst. Ihr KPI könnte beispielsweise die Anzahl der Besucher sein, die auf einen Call-to-Action klicken.

- Teilen Sie Ihre Zielgruppe mit Ihrem Testtool gleichmäßig und zufällig auf, indem Sie eine Gruppe zur Kontrolle und die andere zur Variation schicken. Führen Sie das Erlebnis aus, bis sowohl die Kontrolle als auch die Variation eine bestimmte Anzahl von Besuchen erreichen.

- Verfolgen Sie die KPIs beider Gruppen. Da beide Gruppen denselben Inhalten ausgesetzt sind, sollten sie ähnlich handeln.

- Verbinden Sie Ihr A/B-Testing-Tool mit Ihrer Analysesoftware. Auf diese Weise können Sie überprüfen, ob Ihre Daten in Ihrem Analyseprogramm korrekt erfasst werden.

Wie interpretiert man die A/A-Testergebnisse?

Wir erwarten nicht schlüssige Ergebnisse bei einer A/A-Erfahrung

Obwohl es unwahrscheinlich ist, dass die Saisonalität die Ergebnisse eines A/A-Tests verändert, besteht eines der Ziele darin, unerwartete Ergebnisse zu erkennen. Aus diesem Grund empfehlen wir, den Test mindestens eine Woche lang durchzuführen, bevor Sie das Ergebnis überprüfen.

Am Ende einer Woche sollten Sie das folgende Verhalten bemerken, wenn Sie die Ergebnisse Ihres A/A-Tests untersuchen:

- Im Laufe der Zeit wird sich Ihre statistische Signifikanz um einen bestimmten Wert herum einpendeln. In 10 % der Fälle pendelt sich die statistische Signifikanz über 90 % ein.

- Je mehr Daten gesammelt werden, desto kleiner werden die Konfidenzintervalle für Ihr Experiment, wodurch Werte ungleich Null ausgeschlossen werden.

- Das Original und die Variation können an verschiedenen Punkten während der Testergebnisse unterschiedlich abschneiden, aber beide sollten nicht offiziell als statistisch signifikanter Gewinner bezeichnet werden.

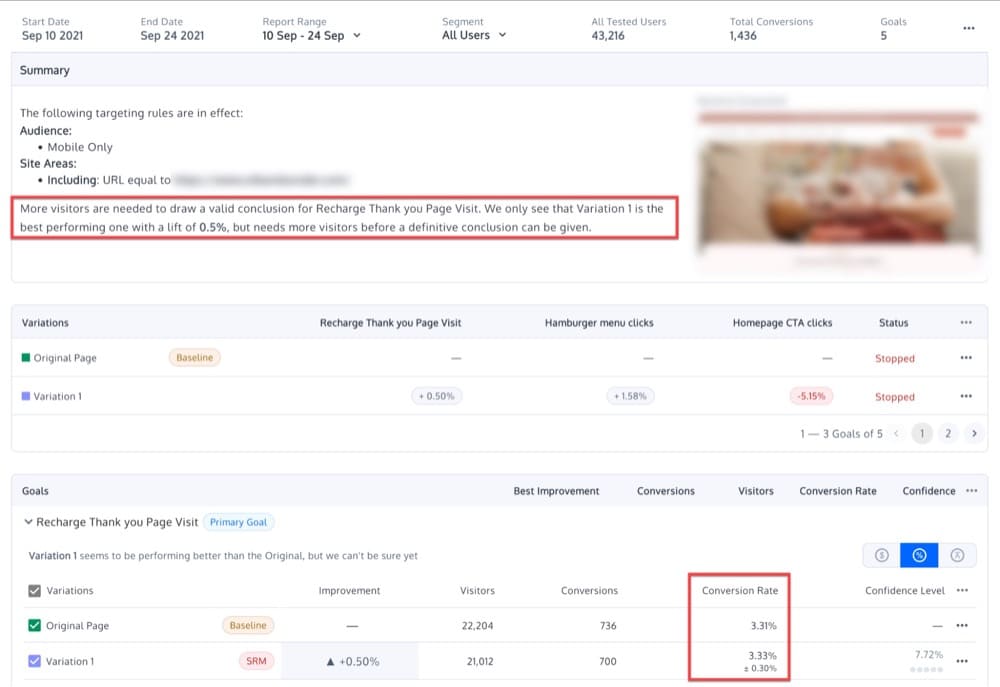

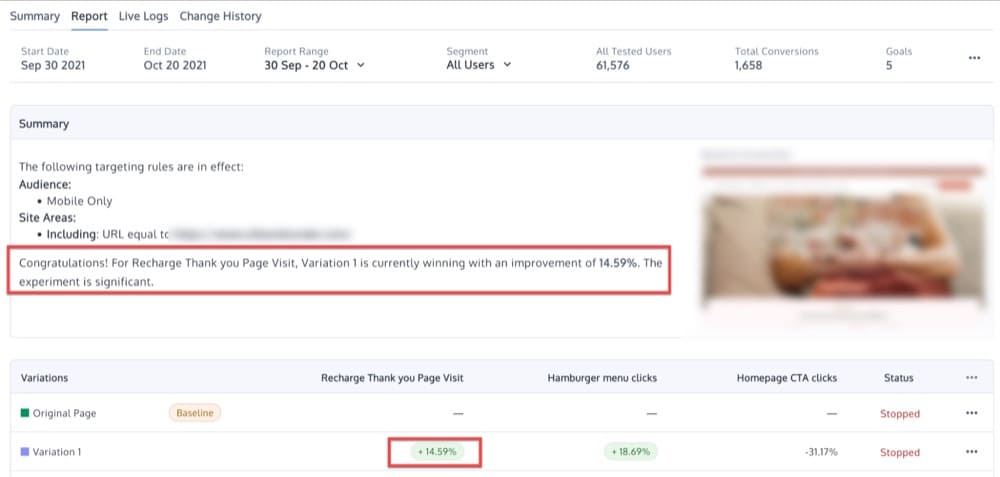

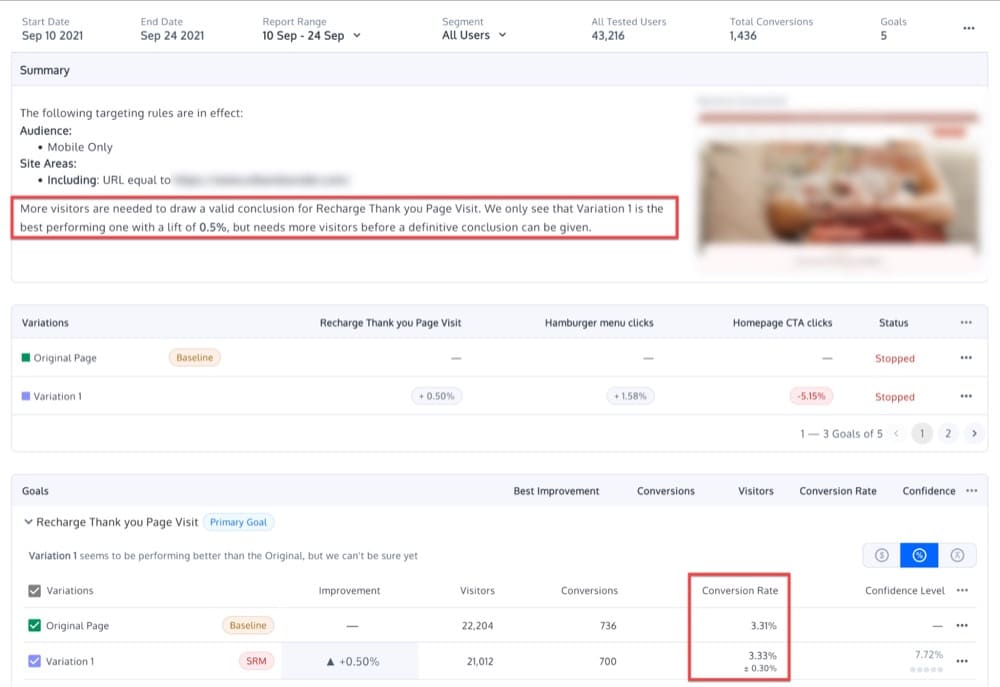

Da es keinen Unterschied zwischen den Variationen geben sollte, sollten Sie damit rechnen, nur geringfügige Unterschiede und keine statistisch signifikanten Ergebnisse zu sehen. Vielleicht sehen Sie etwas in dieser Richtung:

Was bedeutet es, wenn Sie nicht identische Variationen erhalten?

Wenn es bei einem A/A-Erlebnis einen erheblichen Unterschied zwischen den beiden identischen Varianten gibt, könnte dies bedeuten, dass Ihre A/B-Testsoftware nicht korrekt implementiert wurde oder dass das Testtool ineffizient ist .

Es ist jedoch auch möglich, dass die Erfahrung nicht richtig durchgeführt wurde oder dass die Ergebnisse auf zufällige Abweichungen zurückzuführen sind . Diese Art von Stichprobenfehler tritt natürlich auf, wenn eine Stichprobe gemessen wird, im Gegensatz zur Messung aller Besucher.

Beispielsweise deutet ein Konfidenzniveau von 95 % darauf hin, dass in einem von 20 Fällen ein Gewinnergebnis erzielt wird, und zwar aufgrund eines Stichprobenfehlers und nicht aufgrund eines bedeutenden Leistungsunterschieds zwischen zwei Varianten.

Ein weiterer Grund, warum eine ordnungsgemäß ausgeführte A/A-Erfahrung die Identität von Variationen möglicherweise nicht validiert, liegt in der Heterogenität einer Zielgruppe .

Nehmen wir zum Beispiel an, wir führen eine A/A-Erfahrung mit einer Gruppe von Frauen durch, mit unterschiedlichen Konversionsraten für Frauen unterschiedlichen Alters.

Selbst wenn wir einen Test mit einem genauen A/B-Testtool ordnungsgemäß durchführen, kann er dennoch einen signifikanten Unterschied zwischen zwei identischen Varianten aufzeigen. Wieso den? In diesem Beispiel können 50 % der Besucher zwischen 20 und 90 Jahre alt sein, während die anderen 50 % zwischen 20 und 50 Jahre alt sein können. Das inkongruente Ergebnis ist kein Fehler der Plattform, sondern lediglich ein Zeichen dafür, dass die beiden Zielgruppen es sind sehr verschieden.

Schließlich besteht ein weiterer häufiger Fehler bei der Durchführung von Tests, einschließlich A/A-Tests, darin , die Ergebnisse ständig zu überprüfen und den Test vorzeitig zu beenden, sobald eine statistische Signifikanz festgestellt wird.

Diese Praxis, eine Gewinnvariante zu früh zu deklarieren, wird als „Daten-Peeking“ bezeichnet und kann zu ungültigen Ergebnissen führen.

Das Einsehen von Daten in einem A/A-Test kann Analysten dazu veranlassen, eine Steigerung in einer Variante zu sehen, obwohl die beiden tatsächlich identisch sind.

Um dies zu vermeiden, sollten Sie sich im Voraus für die Stichprobengröße entscheiden, die Sie verwenden möchten. Treffen Sie diese Entscheidung basierend auf:

- Minimale Effektgröße: Die minimale Steigerung, unterhalb derer ein Effekt für Ihr Unternehmen nicht von Bedeutung ist

- Leistung

- Signifikanzniveaus, die Sie für akzeptabel halten

Der Zweck eines A/A-Tests wäre dann, ein statistisch signifikantes Ergebnis zu vermeiden, sobald die Stichprobengröße erreicht ist.

Was sind die Herausforderungen von A/A-Tests?

Abgesehen von den vielen Vorteilen, die ein A/A-Test für Ihre Experimentierstrategie bringen kann, gibt es zwei große Nachteile von A/A-Tests:

- Ein A/A-Versuchsaufbau enthält ein Element der Unvorhersehbarkeit.

- Eine hohe Stichprobengröße ist erforderlich.

Sehen wir uns jede dieser Herausforderungen separat an.

Zufälligkeit

Wie bereits erwähnt, ist einer der Hauptgründe für die Durchführung eines A/A-Tests die Bewertung der Genauigkeit eines Testwerkzeugs.

Angenommen, Sie entdecken einen Unterschied zwischen Ihren Kontroll- und Variations-Conversions.

Das Problem bei A/A-Tests ist, dass immer ein gewisses Element der Zufälligkeit beteiligt ist.

Unter anderen Umständen wird die statistische Signifikanz rein zufällig erreicht. Das bedeutet, dass der Unterschied in den Conversion-Raten zwischen zwei Variationen eher probabilistisch als absolut ist.

Große Stichprobengröße

Beim Vergleich ähnlicher Variationen ist eine große Stichprobengröße erforderlich, um festzustellen, ob eine gegenüber ihrem identischen Gegenstück bevorzugt wird.

Dies erfordert einen erheblichen Zeitaufwand.

Das Ausführen von A/A-Tests kann die „echte“ Testzeit in Anspruch nehmen.

Der Trick eines groß angelegten Optimierungsprogramms besteht darin, das Verhältnis von Ressourcenkosten zu Opportunität zu reduzieren, um einen schnellen Testdurchsatz und das, was Sie lernen, sicherzustellen, indem Verschwendung, Dummheit und Ineffizienz vollständig aus dem Prozess entfernt werden.

Das Ausführen von Experimenten auf Ihrer Website ist ein bisschen wie das Führen einer vielbeschäftigten Fluggesellschaft auf einem großen internationalen Flughafen – Sie haben begrenzte Startzeiten und müssen sicherstellen, dass Sie diese effektiv nutzen.

Craig Sullivan für CXL

Konvertieren Sie Erfahrungen und A/A-Tests

A/A-Tests kommen häufig in „fortgeschritteneren“ Supportanfragen vor.

Die folgenden Vorschläge von Convert-Supportmitarbeitern basieren auf Dutzenden gelöster Fälle:

- Um Ihre A/B-Testplattform zu testen, führen Sie zuerst eine A/A-Erfahrung durch. Wenn der Unterschied zwischen den beiden auf der gewählten Ebene statistisch signifikant ist, ist Ihre Plattform möglicherweise defekt.

- Führen Sie einen A/A/B- oder A/A/B/B-Test durch (mehr dazu weiter unten) und verwerfen Sie die Ergebnisse, wenn die zwei A-Variationen oder zwei B-Variationen statistisch signifikante Unterschiede auf dem gewählten Niveau ergeben.

- Richten Sie viele A/A-Tests ein. Wenn mehr Tests als erwartet statistisch signifikante Unterschiede zeigen, ist Ihre Plattform defekt.

Wie richte ich A/A-Tests in Convert Experiences ein?

Sehen wir uns nun an, wie Sie mit Convert Experiences einige verschiedene Arten von A/A-Tests (ja, Plural) einrichten.

Das reine A/A-Erlebnis

Das typischste A/A-Setup ist eine 50/50-Aufteilung zwischen zwei identischen Seiten.

Das Ziel besteht darin, die Erfahrungskonfiguration zu validieren, indem sichergestellt wird, dass jede Variation ungefähr die gleiche Leistung aufweist.

Sie prüfen dasselbe mit sich selbst, um herauszufinden, ob die Daten eher Rauschen als nützliche Informationen enthalten.

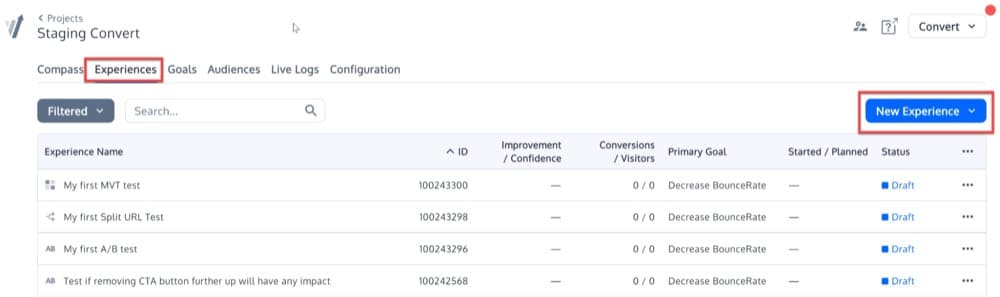

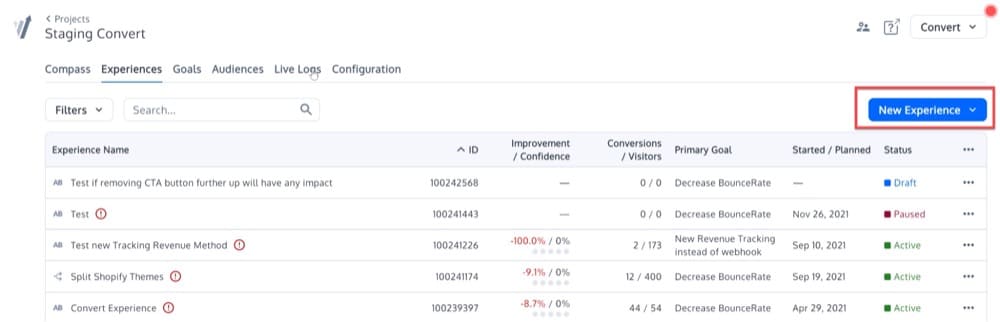

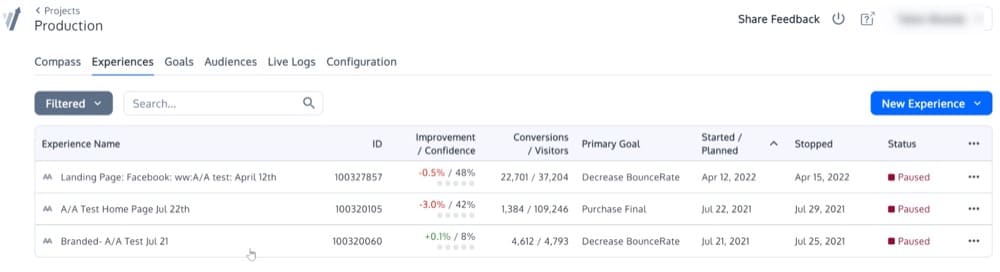

Um dieses einfache A/A-Erlebnis einzurichten, klicken Sie auf das Menü „Erlebnisse“. Klicken Sie dann oben rechts auf die Schaltfläche „Neue Erfahrung“.

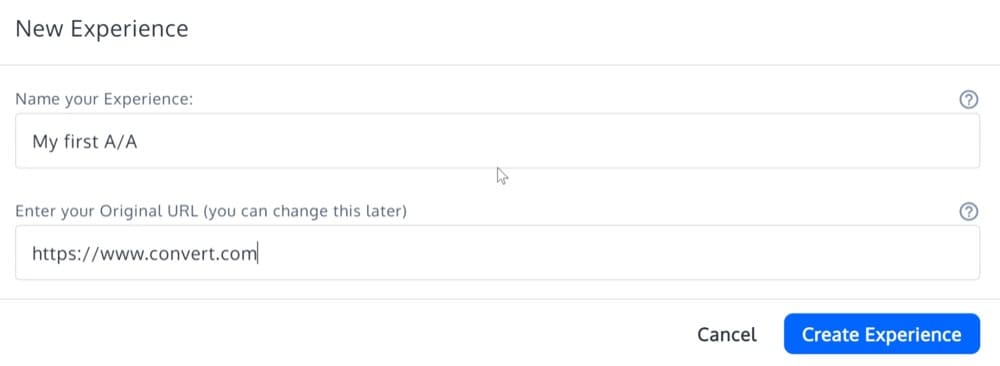

Füllen Sie die Details des „Experience Creation Wizard“ aus und wählen Sie den Experience-Typ „A/A Experience“.

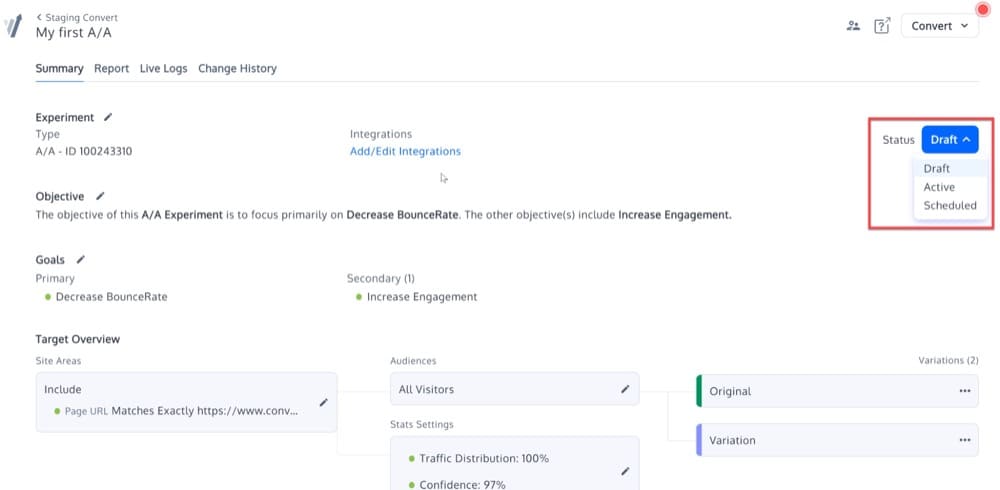

Jetzt sollte Ihr A/A-Erlebnis erstellt werden. Es wird mit anderen Arten von Experimenten auf der Plattform identisch sein, abgesehen davon, dass es keine Optionen zum „Bearbeiten von Variationen“ gibt.

Aktivieren Sie das Erlebnis, indem Sie seinen Status ändern:

Das kalibrierte A/A/B- oder A/A/B/B-Erlebnis

Die Idee hinter diesem kalibrierten A/A/B- oder A/A/B/B-Test ist, dass die replizierten A- oder B-Variationen ein Maß für die Genauigkeit des A/B-Tests liefern.

Wenn der Unterschied zwischen A und A oder B und B statistisch signifikant ist, gilt der Test als ungültig und die Ergebnisse werden verworfen.

Um einen solchen Test einzurichten, müssen Sie eine A/B-Erfahrung und keine A/A-Erfahrung starten.

Klicken Sie rechts auf dem Bildschirm auf die Schaltfläche „Neue Erfahrung“, um mit der Erstellung einer neuen Erfahrung zu beginnen.

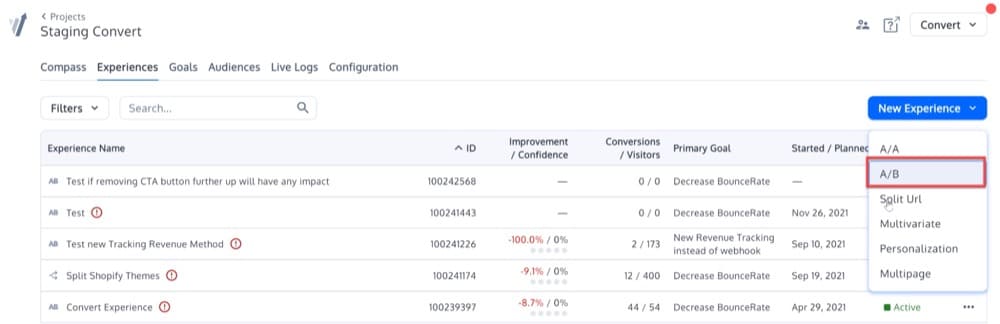

Sobald Sie auf diese Schaltfläche klicken, sehen Sie dieses Popup-Menü. Wählen Sie die Option A/B:

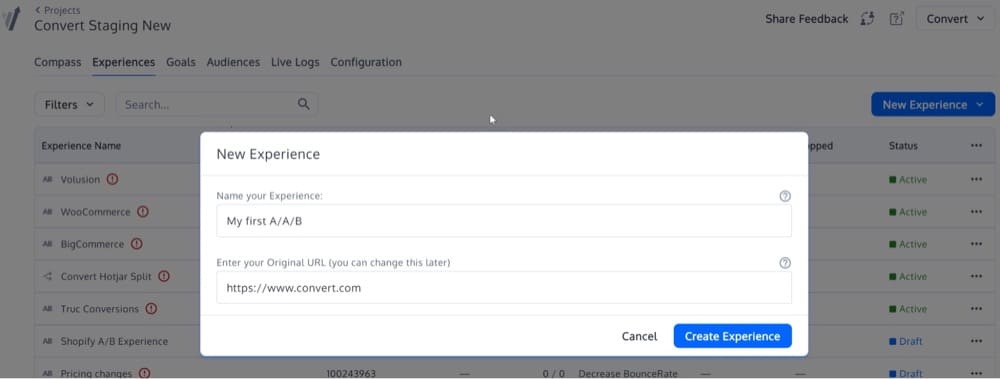

Geben Sie dann Ihre URL in das zweite Feld ein.

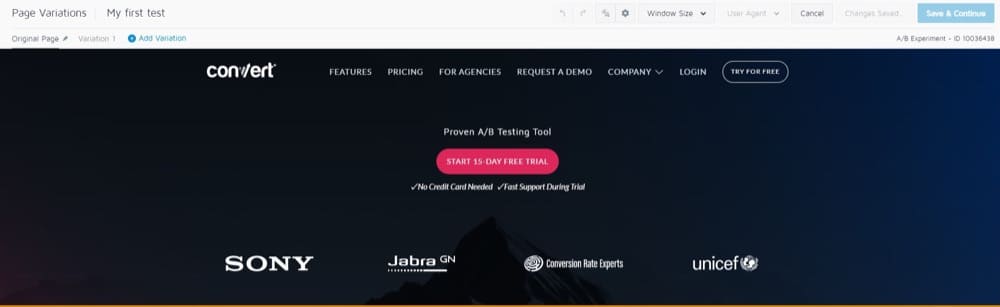

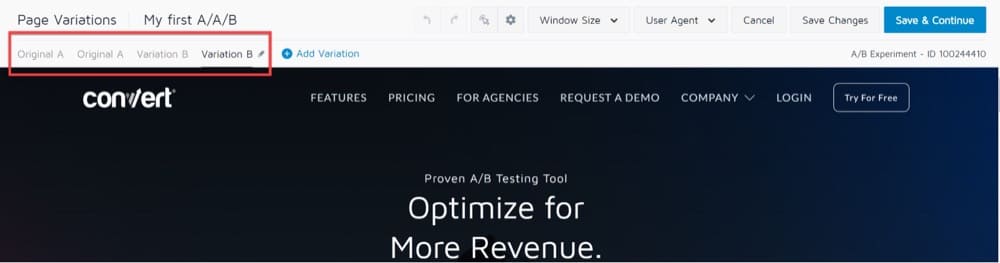

Sie werden zum visuellen Editor weitergeleitet, der die von Ihnen gewählte URL und oben eine Symbolleiste anzeigt:

Im Abschnitt Seitenvariationen oben links werden Sie feststellen, dass „Variation 1“ standardmäßig ausgewählt ist.

Das bedeutet, dass alle Änderungen, die wir an dieser Version der URL vornehmen, sich nicht auf die ursprüngliche URL auswirken.

Das Ergebnis ist ein klassischer A/B-Test, bei dem die „A“-Version die Originalseite und die „B“-Version die Variante 1 ist.

Für A/A/B oder A/A/B/B müssen Sie eine weitere Variante A und eine weitere Variante B hinzufügen, die jeweils mit Variante A und Variante B identisch sind.

Es sollte so aussehen:

Klicken Sie auf die Schaltfläche „Speichern & Fortfahren“ und Sie sind fertig!

Führen Sie viele A/A-Erlebnisse durch

Wir haben das bereits behandelt, aber wenn Sie 1000 aufeinanderfolgende A/A-Tests mit einem großen Publikum durchführen, alle Anforderungen befolgen und viel häufiger als vorhergesagt statistisch signifikante Ergebnisse erzielen, ist es möglich, dass Ihr A/B-Test-Framework kaputt ist.

Es könnte sein, dass die Stichproben nicht richtig randomisiert sind. Oder vielleicht schließen sich die beiden Varianten nicht gegenseitig aus.

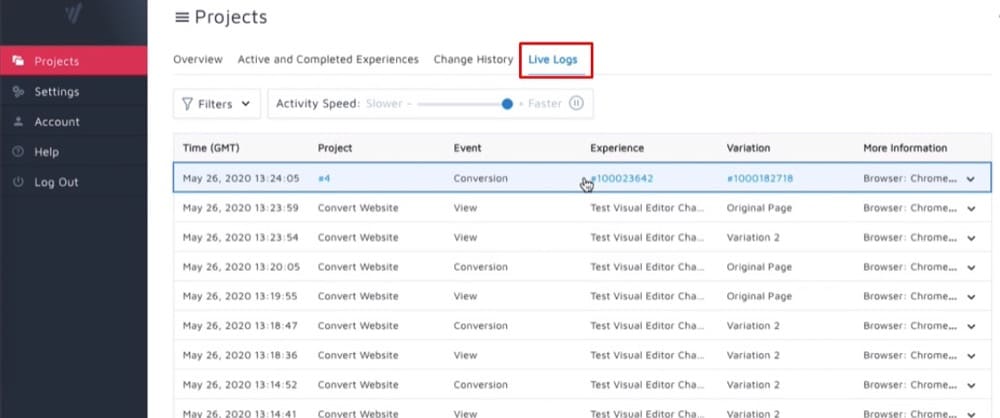

So könnte das aussehen:

Kann ich ein A/A-Erlebnis gleichzeitig mit einem A/B-Erlebnis durchführen?

Es besteht die Möglichkeit, dass Sie einen A/A-Test gleichzeitig mit einem A/B-Test auf derselben Website durchführen müssen.

In diesem Fall sind hier einige Möglichkeiten:

- Sie müssen sich keine Sorgen darüber machen, dass die Tests miteinander in Konflikt geraten, wenn Sie sie gleichzeitig ausführen.

- Sie könnten die Experimente gleichzeitig durchführen, aber mit unterschiedlichen Zielgruppen.

- Sie könnten die Tests in der richtigen Reihenfolge durchführen (Test 1 (A/A-Test) abschließen, bevor Sie mit Test 2 (A/B-Test) fortfahren).

Option 3 ist die sicherste, aber sie schränkt die Möglichkeiten Ihrer Erfahrung drastisch ein.

Es ist durchaus möglich, mehrere Erlebnisse gleichzeitig auf derselben Seite oder einem Satz von Seiten auszuführen.

Beachten Sie jedoch, dass das Bucketing in einem Experiment Auswirkungen auf die Daten eines anderen gleichzeitig stattfindenden Experiments haben kann.

Hier sind die beiden wichtigsten Convert-Techniken, die Sie beim Ausführen paralleler Tests verwenden sollten:

- Weisen Sie 50 % des Datenverkehrs dem A/A-Test zu, während Sie die anderen 50 % des Datenverkehrs in die anderen laufenden A/B-Erfahrungen einspeisen lassen.

- Schließen Sie A/A-Besucher von anderen A/B-Tests aus.

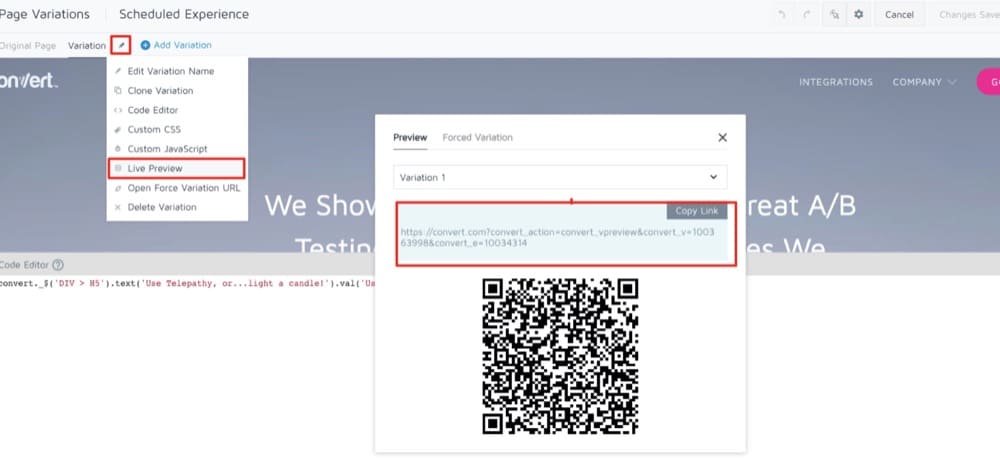

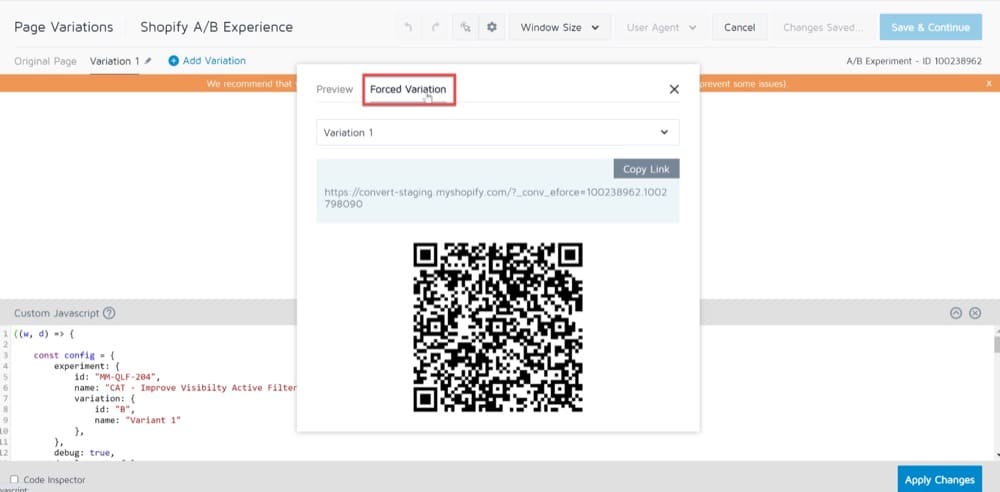

Pre-Test QA-Prozess: Eine interessante Alternative zu A/A-Tests

Bei der Entscheidung, ob ein A/A-Test durchgeführt werden soll oder nicht, variieren die Antworten je nachdem, wen Sie fragen. Es besteht kein Zweifel, dass A/A-Tests ein umstrittenes Thema sind.

Eines der häufigsten Argumente gegen A/A-Tests ist, dass es zu lange dauert.

A/A-Tests nehmen viel Zeit in Anspruch und erfordern oft eine erheblich höhere Stichprobengröße als A/B-Tests.

Beim Vergleich zweier identischer Versionen einer Website ist eine hohe Stichprobengröße erforderlich, um eine signifikante Verzerrung nachzuweisen.

Infolgedessen dauert der Test länger, was möglicherweise Zeit spart, die für andere wichtige Tests aufgewendet wird.

In solchen Fällen, in denen Sie nicht viel Zeit oder hohen Traffic haben, ist es am besten, einen Pre-Test-QA-Prozess durchzuführen.

In diesem Blogartikel führen wir Sie durch alle Schritte, die Sie befolgen müssen, um einen vollständigen QA-Prozess durchzuführen. Die Methoden, die Sie verwenden, sind Ihnen überlassen und hängen davon ab, wie viel Zeit Sie zur Verfügung haben.

Kann SRM bei A/A-Tests existieren?

Stellen Sie sich folgende Frage: Liegt die tatsächliche Anzahl der während Ihres A/A-Tests beobachteten Benutzer nahe dem Verhältnis von 50/50 (oder dem Verhältnis von 90/10 oder einem anderen Verhältnis), wenn Sie sie halbieren?

Wenn nicht, stehen Sie vor einem von zwei Problemen: Entweder gibt es ein Problem damit, wie Sie die Testinfrastruktur aus Ihrem Code heraus aufrufen (was ihn auf einer Seite „undicht“ macht) oder es gibt ein Problem mit der Testinfrastruktur Zuordnungsmechanismus.

Ein Sample-Ratio-Mismatch-Fehler (SRM-Fehler) ist ein Defekt, den ein A/A-Test erkennen kann.

Wenn Ihr Verhältnis etwa 65/35 beträgt, sollten Sie das Problem untersuchen, bevor Sie einen weiteren A/B-Test mit derselben Targeting-Strategie durchführen.

Überwiegen die Vorteile von A/A-Tests die Nachteile?

Obwohl A/A-Tests nicht monatlich durchgeführt werden sollten, lohnt es sich, Ihre Daten beim Aufsetzen eines neuen A/B-Tools zu testen.

Wenn Sie die fehlerhaften Daten jetzt erkennen, haben Sie später mehr Vertrauen in Ihre A/B-Testergebnisse.

Obwohl die Entscheidung letztendlich bei Ihnen liegt, ist es sehr ratsam, dass Sie A/A-Tests durchführen, wenn Sie mit einem neuen Tool beginnen. Wenn nicht, empfehlen wir Ihnen, ein strenges QA-Verfahren vor dem Test einzurichten, da A/B-Tests Ihnen Zeit, Geld und Traffic sparen.

Wir hoffen, dass die obigen Screenshots Ihre Fragen beantwortet haben, aber wenn nicht, melden Sie sich für eine Demo an, um selbst zu sehen, wie einfach es ist, einen A/A-Test mit Convert Experiences einzurichten.