Wie man eine SEO-Website-Migration handhabt

Veröffentlicht: 2017-10-13Im Lebenszyklus einer Website sind SEO-Website-Migrationsphasen wichtige Momente, in denen Sie auf viele Details achten müssen, um die SEO nicht negativ zu beeinflussen.

Jede Site-Migration ist anders. Eine Migration bedeutet keine sofortigen Ergebnisse, aber es ist der perfekte Zeitpunkt, um Ihre SEO zu verbessern. Es muss verstanden werden, dass Suchmaschinen bei der Weiterentwicklung einer Website nicht immer im gleichen Timing sind und dass es eine mehr oder weniger wichtige Zeit der Anpassung geben wird. Dies ist jedoch der günstigste Zeitpunkt für eine Website, um die technische Qualität zu verbessern, den Code mit HTML5 und json-ld anzureichern, Siloing dank der Architektur der internen Verlinkung, redaktionellen Reichtum und starke SEO-Signale an Suchmaschinen zurückzugeben.

Abhängig von den auftretenden Änderungen gibt es verschiedene Arten der Site-Migration, die normalerweise eines oder mehrere der folgenden Elemente umfassen:

- Hosting / IP-Adresse

- Domänenname

- URL-Struktur

- Architektur der Website

- Inhalt

- Design Konzept

Die Migration der schwierigsten Standorte beinhaltet Änderungen in den meisten (oder allen) der oben genannten Punkte.

Wenn das SEO-Redesign richtig verwaltet wird, gibt es eine vor und eine nach der Migration. Nehmen Sie sich die Zeit, die Schmerzpunkte der Website zu verstehen und daran zu arbeiten, sie zu korrigieren. Verbessern Sie die Leistung, erleichtern Sie die Crawlbarkeit. Sie werden auf lange Sicht ein Gewinner sein.

In diesem Artikel stellen wir Ihnen die Best Practices für eine sichere SEO-Website-Migration vor.

Wichtige Schritte, Aktionen und Dokumente einer SEO-Website-Migration

Eine kontrollierte Migration ist eine gut vorbereitete Migration. Sie werden daher effektiv sein, wenn Sie eine Reihe von Strukturierungsschritten befolgen. Diese Schritte ermöglichen es Ihnen auch, eine Reihe von Dokumenten und Daten zu sammeln, auf die Sie sich während des gesamten Migrationszyklus verlassen können, und dann die guten (oder schlechten) Auswirkungen der Migration zu qualifizieren.

Hier ist eine Tabelle, die die Maßnahmen und Migrationsdokumente nach Zielen auflistet:

| TORE | AKTIONEN | UNTERLAGEN |

| Website-Bild | – Vorläufige CrawlAggregate-Serverprotokolldaten | Crawling-Berichte Technische Dateien (robots.txt, Sitemaps, alte Weiterleitungsdateien) Tabelle mit gecrawlten/nicht gecrawlten URLs, verwaisten Seiten und jeweils Crawling-Frequenz/Tag |

| Kompilieren, aggregieren und speichern Sie Daten aus externen Tools | – Daten lesenGoogle Analytics, Omniture, AT Internet, Search Consoles (Bing/Google), SemRush, MyPoseo, Majestic, SEObserver,… | Export von Positionen, Klickraten und Impressionen nach Ausdrücken/Nischen Analytischer Datenexport Backlink-Export, TF/CF, Nische, Keywords aus Nischen exportieren Schlagwortsuche Datenüberkreuzung |

| Identifizierung von Verbesserungsbereichen | – Audit und Datenanalyse | Aufgabenliste |

| Themenpriorisierung | – Bewertung der Gewinne/Aufwände | ROI-Matrix |

| Spezifikationen | – Bewertung der Gewinne/Aufwände | Anforderungsausdruck mit Anhang für SEO-freundliche Codes |

| Produktion | - Entwicklung – Wissensimplementierung | Teamdiskussion um kritische Punkte Qualitätscode |

| Änderungen überprüfen | – Technisches Rezept – Code-ValidierungCode-Garantie | Vergleichs-Crawling-Bericht Tägliche Korrektur Prüfbericht Validierung der Tests, die am D-Tag gespielt werden sollen |

| Leben | – Bereitstellen von neuem Code und Dateien (Sitemaps, robots.txt, Weiterleitungen) – Integritätstest der neuen Seite – Deklaration der neuen Sitemaps – Engine-Crawling mit der Search Console erzwingen | Übergeben des neuen Codes in der Produktion Sorgen Sie für aktuelle XML-Sitemap-Dateien Validieren Sie Roboter. txt-Optimierung Umleitungsdatei, falls zutreffend Habe den Code erwartet und stabil in der Produktion |

| Live-Überwachung | – Kriechen über Kriechen – Crawl von umgeleiteten URLs | Zurück zum Datenvergleich Bericht über die Entwicklung von KPIs |

Datenerfassung und -analyse vor der Migration

Vorläufiges Crawling

Das Verständnis der Probleme eines Standorts ist für die Erstellung von Spezifikationen und KPIs für die Migrationsüberwachung unerlässlich. Um den Standort besser kennenzulernen und verbesserungswürdige Bereiche zu erkennen, laden wir Sie ein, vor der Migration ein vollständiges Foto des Standorts zu machen.

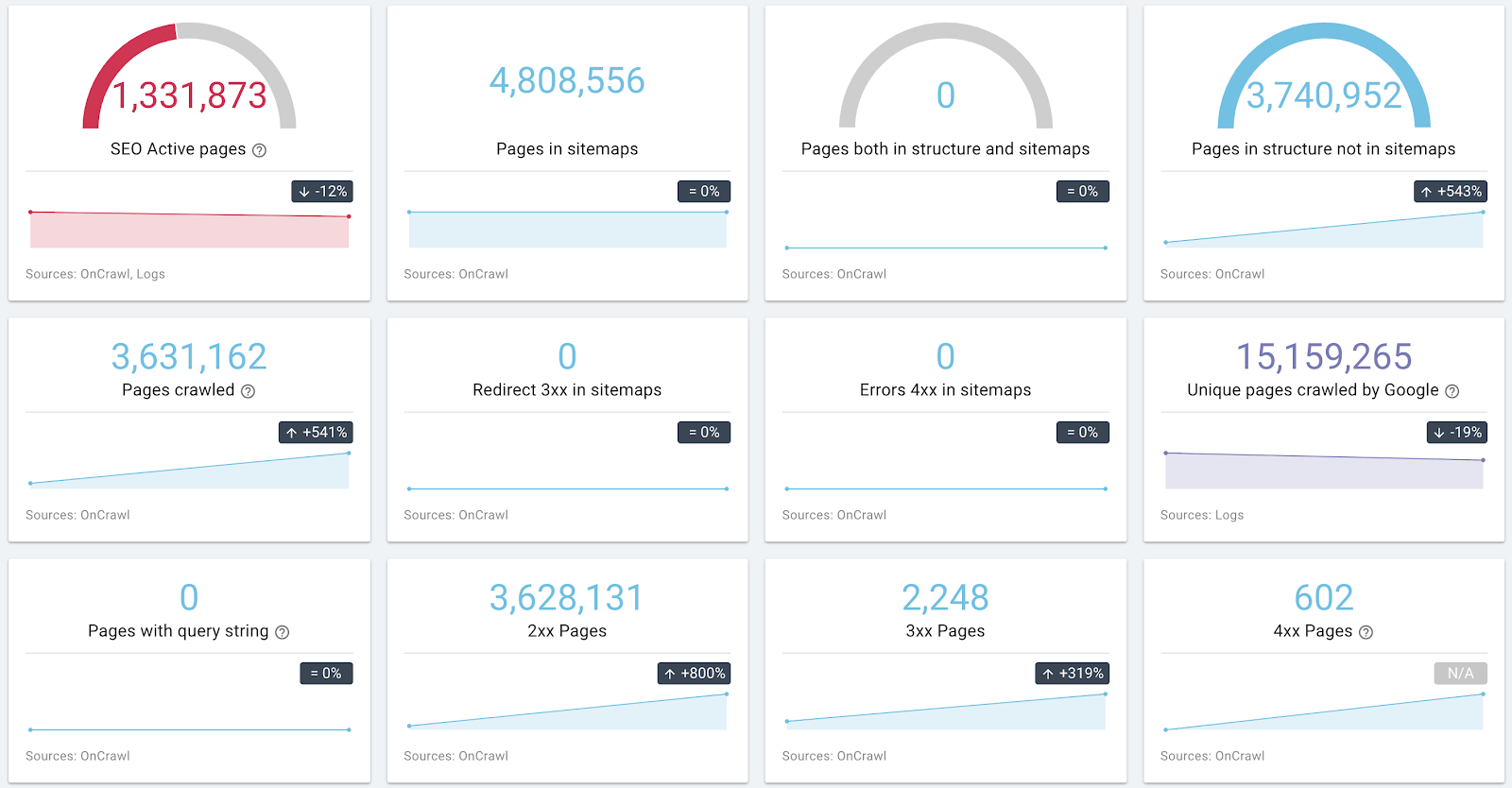

Starten Sie dazu einen Crawl, der die gleichen Prinzipien wie die von Google respektiert: Berücksichtigung von Robotern. txt, gefolgt von Links mit Abfragezeichenfolge. Wenn Ihre Migration mehrere Subdomains umfasst, können Sie mit OnCrawl Subdomains entdecken und crawlen.

Beispiel für Informationen zur Architektur und zum Integritätsstatus einer Site

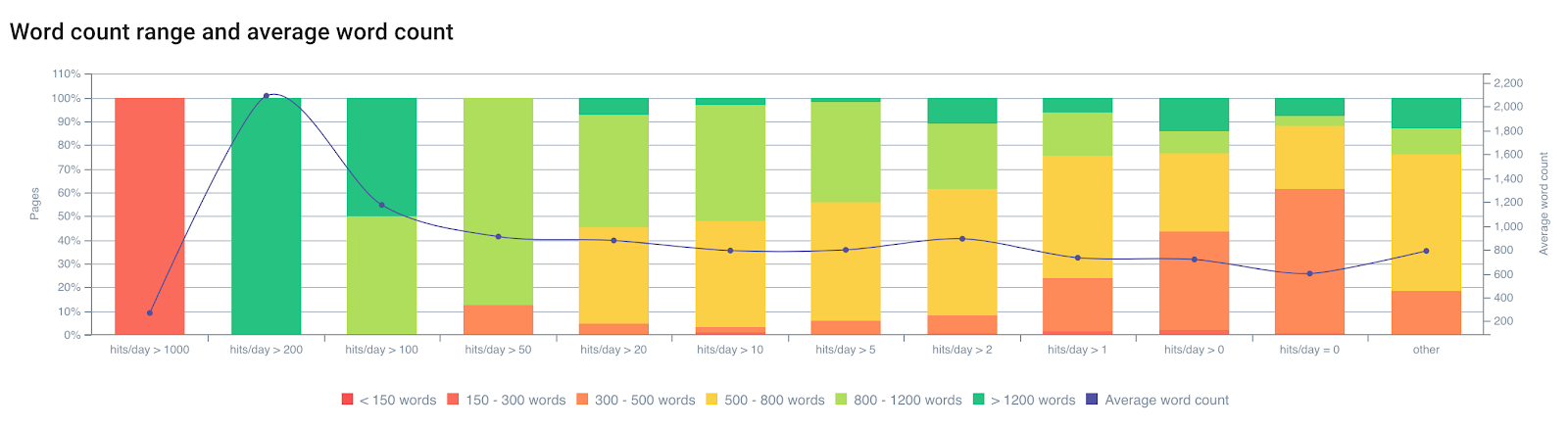

Wenn Sie die Möglichkeit haben, die Protokolldaten zu sammeln, zögern Sie nicht, dies für jede URL zu tun. Crawl-/Protokolldaten mit Querverweisen können verwendet werden, um Erfolgsfaktoren für eine Reihe von Seiten zu identifizieren.

Zeigen Sie die Anzahl der Bot-Hits/Tag nach der Anzahl der Wörter an

Aus Erfahrung wissen wir, dass das Crawling von Google von mehreren Faktoren auf der Seite beeinflusst wird. Google durchsucht nicht alle Seiten mit der gleichen Häufigkeit. Sein Index wird für diese Seiten nicht aktualisiert, daher werden sie tendenziell herabgestuft. Eine veraltete Seite im Index ist nicht mehr unbedingt die „beste Antwort“ auf eine Nutzeranfrage. Es besteht eine starke Beziehung zwischen der Crawl-Frequenz, der Indexaktualisierung und dem Ranking.

Eine Seite wird weniger gecrawlt, wenn:

- Es ist zu tief in der Architektur;

- Es enthält nicht genügend einzelnen Text;

- Es hat nicht genug interne Links (auch externe);

- Es ist nicht schnell genug zum Laden oder zu schwer;

- … etc.

Um mehr über den Einfluss von Onpage-Faktoren auf Googles Crawling zu erfahren, können Sie den Artikel „Google Importance Page“ lesen, der es Ihnen ermöglicht, mehr über Googles Patente im Zusammenhang mit „Crawl Scheduling“ zu erfahren.

Das vorläufige Crawling ermöglicht es Ihnen, Ihre Website kennenzulernen. Es ermöglicht Ihnen auch, die Seiten zu klassifizieren, die die Seiten zur Validierung von Optimierungen sein werden. Ihre vorläufige Analyse muss diese Daten berücksichtigen, um die Faktoren zu korrigieren, die das Crawling benachteiligen.

Lesen von Daten aus externen Tools

Google-Suchkonsole / Bing-Suchkonsole / Bing-Suchkonsole

In der Search Console von Google und Bing finden Sie sowohl qualitative als auch quantitative Daten. Es ist sehr empfehlenswert, diese Daten zu sammeln, um Verbesserungen zu überwachen.

Wir laden Sie ein, diese Daten erneut zu überprüfen, um zu verstehen, was die gemeinsamen Merkmale der Seiten sind, die sich selbst positionieren, fehlende Keywords oder Probleme im Zusammenhang mit mobilen/AMP- oder SEO-Fehlern.

Wichtige Daten zum Speichern: Anzahl und Arten von Fehlern, Crawl-Budget (Anzahl der Zugriffe pro Tag) und Ladezeit, HTML-Verbesserung, Anzahl der indexierten Seiten, Position/CTR/Impression nach Ausdrücken und URLs.

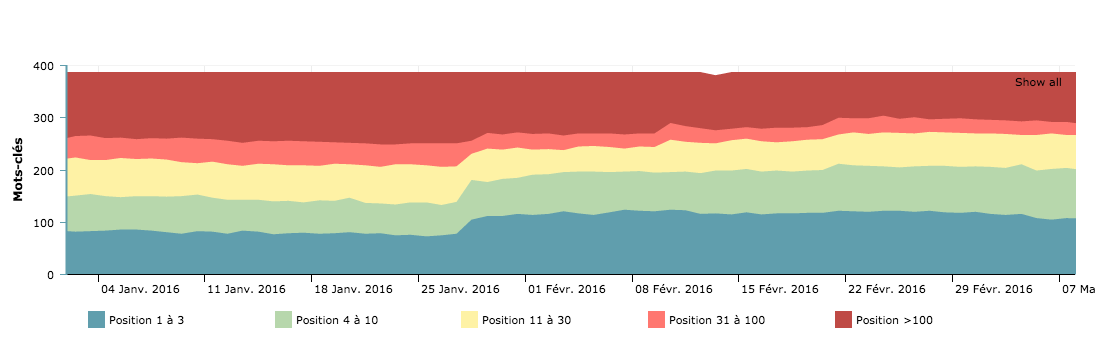

Erkundete Seiten nach Tag – Crawl-Budgetkurve zum Vergleich vor/nach der Migration

Diese Ansichten von den Suchmaschinen ermöglichen es Ihnen zu verstehen, wie sie Ihre Website interpretieren. Es ist auch die Grundlage für das KPI-Post-Migration-Monitoring. Es ist wichtig, von Suchmaschinen gemeldete SEO-Fehler zu berücksichtigen, um sie zuerst zu korrigieren.

Ranking und Sichtbarkeit

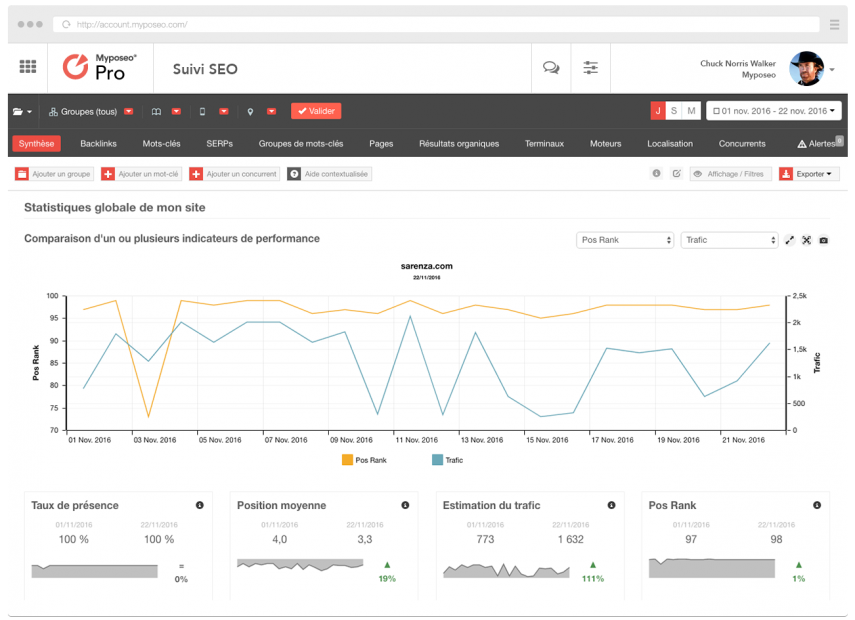

Positionierungs-Tracking-Tools wie MyPoseo vereinfachen das Studium der Website-Sichtbarkeit und Schlüsselwörter.

Zusätzlich zu den Daten der Google Search Console müssen Sie Ihre Sichtbarkeitsrate in Ihrer Nische kennen. Diese Daten sind für Ihre Analyse nach der Migration unerlässlich.

Analytik

Tracking- und Analyselösungen können verwendet werden, um die Nutzungsdaten Ihrer Benutzer zu sammeln. Sie sind auch eine Informationsquelle über die Leistung Ihrer Seiten in Bezug auf organische Besuche, Absprungrate, Konversionstunnel, Routen und Attraktivität der Website. Sie müssen Daten exportieren, die es Ihnen ermöglichen, verbesserungswürdige Bereiche zu erkennen und diese für Ihre Live-Analyse zu speichern.

Der Export aller URLs, die in den letzten 12 Monaten mindestens einen Besuch über Google Analytics erhalten haben, ist eine Möglichkeit, eine große Anzahl wertvoller indexierter Seiten abzurufen.

Klassifizieren Sie Zielseiten für die Priorisierung Ihrer Aktionen, verpassen Sie keine nicht überprüften Seiten und versuchen Sie erneut, Leistungsfaktoren zu erkennen, um Sie bei Ihren Empfehlungen zu inspirieren.

Segmentierung

Nach dem vorläufigen Crawl und der externen Datenaufzeichnung haben Sie einen vollständigen Überblick über den Migrationsperimeter. Aus Ihren Analysen können Sie Sätze von Seiten erstellen, die nach verschiedenen Metriken gruppiert werden können, um Ihre Migration zu qualifizieren.

Mit OnCrawl ist es möglich, 10 Sätze oder einen Satz von 15 Seitengruppen zu erstellen. Warum diese Funktion nicht zum Erstellen von Migrationssätzen verwenden?

Erstellen Sie eine Kategorisierung für jeden der Verbesserungsbereiche. Mit OnCrawl können Sie Gruppen erstellen, die auf mehr als 350 Metriken basieren – zum Beispiel schlecht, schwer, dupliziert, nicht von Robotern besucht, wenig von Benutzern besucht, mit zu wenigen eingehenden Links oder zu tief. Sie ermöglichen es Ihnen, die Neugestaltung im Nachhinein zu validieren.

Profi-Tipp: Sie können alle Seiten gruppieren, die in mehr als 1 Sekunde antworten, Seiten mit einer schlechten Crawling-Rate und mit der Überschneidung von Ranking-Daten und menschlichem Verhalten – CTR bei GSC oder Absprungrate bei Analytics. Sie werden in der Lage sein, die richtigen Entscheidungen zu treffen.

Das Abgleichen von Crawl-, Protokoll- und Analysedaten ist der beste Weg, um eine vollständige und realistische Analyse für Ihre Migration durchzuführen.

Seiten zum Bearbeiten, Erstellen, Löschen

Dank der gesammelten Daten können Sie Seiten mit den meisten Besuchen, Seiten mit den wichtigsten Duplicate-Content-Raten, fehlende Seiten in Ihrer Architektur usw. identifizieren.

Sie sollten bedenken, dass die Umstrukturierung neben der Korrektur der am stärksten nachteiligen SEO-Probleme und der Einhaltung der SEO-Richtlinien auch eine Anreicherung und Neuausrichtung Ihrer Website um Schlüsselsätze von Suchmaschinennutzern ermöglichen sollte. Sie suchen mit ihren eigenen Worten nach Daten, die auf Ihren Seiten vorhanden sind. Die Arbeit der Exploration und semantischen Anpassung ist eine oft vernachlässigte Aufgabe, die jedoch die beste Leistung in Bezug auf das Ranking ermöglicht.

Neue Hub- und Zielseiten müssen hinzugefügt werden, um den Anforderungen der Benutzer am besten gerecht zu werden. Sie müssen auf die Suchanfragen ausgerichtet sein, bei denen die Seite am wenigsten gut positioniert ist.

[Fallstudie] Verhindern Sie, dass Ihr Redesign Ihre SEO benachteiligt

Interne Linkverwaltung

Die interne Verlinkung ist heute mehr denn je einer der Schlüsselfaktoren für eine erfolgreiche SEO-Umstrukturierung. Die Variation von Ankern, die Optimierung der internen Popularitätsdiffusion und die semantische Ausrichtung von Ankern sind mächtige Verbündete.

Darstellung einer optimierten internen Verlinkung mit OnCrawl

Nehmen Sie sich die Zeit, um zu verstehen, wie sich die Popularität Ihrer Seiten über die verschiedenen Linkblöcke verteilt. Versuchen Sie, irrelevante Links auf Ihren Seiten so weit wie möglich zu reduzieren. Bestes Beispiel ist das Mega-Menü.

Vermeiden Sie Links zu allen Seiten von allen Seiten; das ist kontraproduktiv. Entfernen Sie Links, die nicht aus demselben Silo stammen, aus dem HTML-Code – und behalten Sie Links zu Kategorieüberschriften bei.

Die Navigation ist auch eine Roboterfalle. Versuchen Sie, Verknüpfungen zwischen Seiten zu erstellen, indem Sie einen Algorithmus verwenden, der es Ihnen ermöglicht, zu den nächsten Einheiten, Zehnern, Hundertern zu springen.

Versuchen Sie, die Anker, die auf die Seiten verweisen, so weit wie möglich zu variieren. Dadurch können Sie Suchmaschinen zeigen, dass Sie ein breites semantisches Feld nutzen und den Page Importance Score und damit das Crawling der Seiten begünstigen.

Denken Sie auch daran, die Fußzeilenlinks zu reduzieren oder zu segmentieren, um zu vermeiden, dass unattraktive und sehr beliebte Seiten erstellt werden. Die CGU- oder Newsletter-Abonnement-Links sowie ausgehende Links von Ihrer Domain sind ebenso viele interne Page Rank-Lecks. Achten Sie auch auf Links zu sozialen Netzwerken, diese Websites sind oft größer als Ihre und saugen den Page Rank Ihrer Website auf.

Umleitung

Diese Aktivität erfordert viel Aufmerksamkeit, da etwas schief gehen kann. Es ist wichtig, die aktuellen Umleitungsregeln abzurufen, damit Sie sie gegebenenfalls an die neue Baumstruktur anpassen können. Die alten Umleitungsregeln müssen aktualisiert werden, um Umleitungszeichenfolgen zu vermeiden.

Es muss auch überprüft werden, ob alle alten URLs in 301 auf die neuen umleiten.

Test-Crawls können durchgeführt werden, indem die Liste aller alten URLs exportiert und in Start-URLs mit einer maximalen Tiefe von 1 hinzugefügt werden.

Stellen Sie für den speziellen Fall der HTTPS-Migration (mit oder ohne Änderung der URL-Struktur) sicher, dass alle internen Links aktualisiert wurden (keine internen Links von einer HTTPS-Seite zu einer HTTP-Seite). Es gibt Customs Fields OnCrawl, um diesen Vorgang auszuführen.

Profi-Tipp: Erstellen Sie Seiten mit Verknüpfungen zu Ihren zu rankenden Seiten (Produktseiten dank der Hub-Seiten), verbessern Sie die Ladezeiten, erhöhen Sie das Inhaltsvolumen der Seiten, erstellen Sie Sitemaps und korrigieren Sie verwaiste Seiten, kanonische Seiten, reduzieren Sie doppelte Inhalte…

Es ist wichtig zu betonen, dass stark frequentierte Seiten besondere Aufmerksamkeit erfordern, aber im SEO zählt jede URL.

Es ist wichtig zu betonen, dass stark frequentierte Seiten besondere Aufmerksamkeit erfordern, aber im SEO zählt jede URL.

Die Rezeptphase

Diese wesentliche Phase der Migration ist der Zeitraum, in dem Sie nach Fehlern im Quellcode oder beim Verständnis von Bedarfsäußerungen Ausschau halten müssen.

Schutz der Suchmaschinenentwicklungsplattform

htpasswd ist die empfohlene Lösung, um zu vermeiden, dass Suchmaschinen Ihre gecrawlten Staging-URLs sehen. Diese Methode stellt auch sicher, dass Sie keine blockierende robots.txt-Datei ausführen oder Meta-Robots „disallow“ ausführen. Es passiert öfter als es scheint.

Profi-Tipp: Ihre Website in der Entwicklung MUSS ISO sein, um den Code der zukünftigen Website zu garantieren.

Überprüfen Sie die Qualität jeder Codelieferung

Während dieser Phase müssen Sie überprüfen, ob sich die Website in die richtige Richtung bewegt, indem Sie regelmäßig Crawls auf der Rezeptplattform starten. Wir empfehlen, Crawl Over Crawl zu erstellen, um zwei Versionen miteinander zu vergleichen.

Zögern Sie nicht, es auszuprobieren:

- Link Juice-Übertragung und interne Verlinkung;

- Die Entwicklung der Seitentiefe;

- Fehler 40x und Links zu diesen Seiten;

- Fehler 50x und Links zu diesen Seiten;

- Die Qualität von Titel, Meta-Beschreibung und Robot-Tags;

- Die Qualität des Quellcodes und doppelte Inhaltselemente.

Stellen Sie sicher, dass der Code W3C-konform ist. Wir vergessen es oft, aber es ist eine der ersten Empfehlungen von Google, dass semantische Daten keine Fehler enthalten, dass Quellcodes auf der Ebene der Ambitionen sind und dass Optimierungsregeln im gesamten Perimeter angewendet werden.

Profi-Tipp : Alte Weiterleitungsregeln müssen aktualisiert werden, um zu verhindern, dass Weiterleitungen auf neue Weiterleitungen verweisen.

Es muss überprüft werden, ob alle alten URLs in 301 auf neue umgeleitet werden. Test-Crawls können durchgeführt werden, indem die Liste aller alten URLs exportiert und in der Start-URL mit einer maximalen Tiefe von 1 hinzugefügt wird.

Seitenverzeichnis. xml-Dateien

Wenn der Code stabil ist und alle URLs vom Test-Crawler entdeckt wurden, können Sie alle URLs der Website exportieren. Auf diese Weise können Sie Ihre sitemap.xml-Datei (oder sitemap_index.xml) erstellen.

Fügen Sie die Adressen in Ihre robots.txt-Datei ein und platzieren Sie sie im Stammverzeichnis der Website (wie in der hier verfügbaren Sitemap-Spezifikation empfohlen).

Profi-Tipp: Erstellen Sie eine Sitemap nach großen Abschnitten der Website, damit Sie die Indizierung jedes Teils der Website in der Google Search Console unabhängig verfolgen können.

Erstellen Sie eine Sitemap-Datei mit all Ihren alten umgeleiteten URLs, um die Suchmaschinen zu zwingen, jede einzelne weiterzugeben.

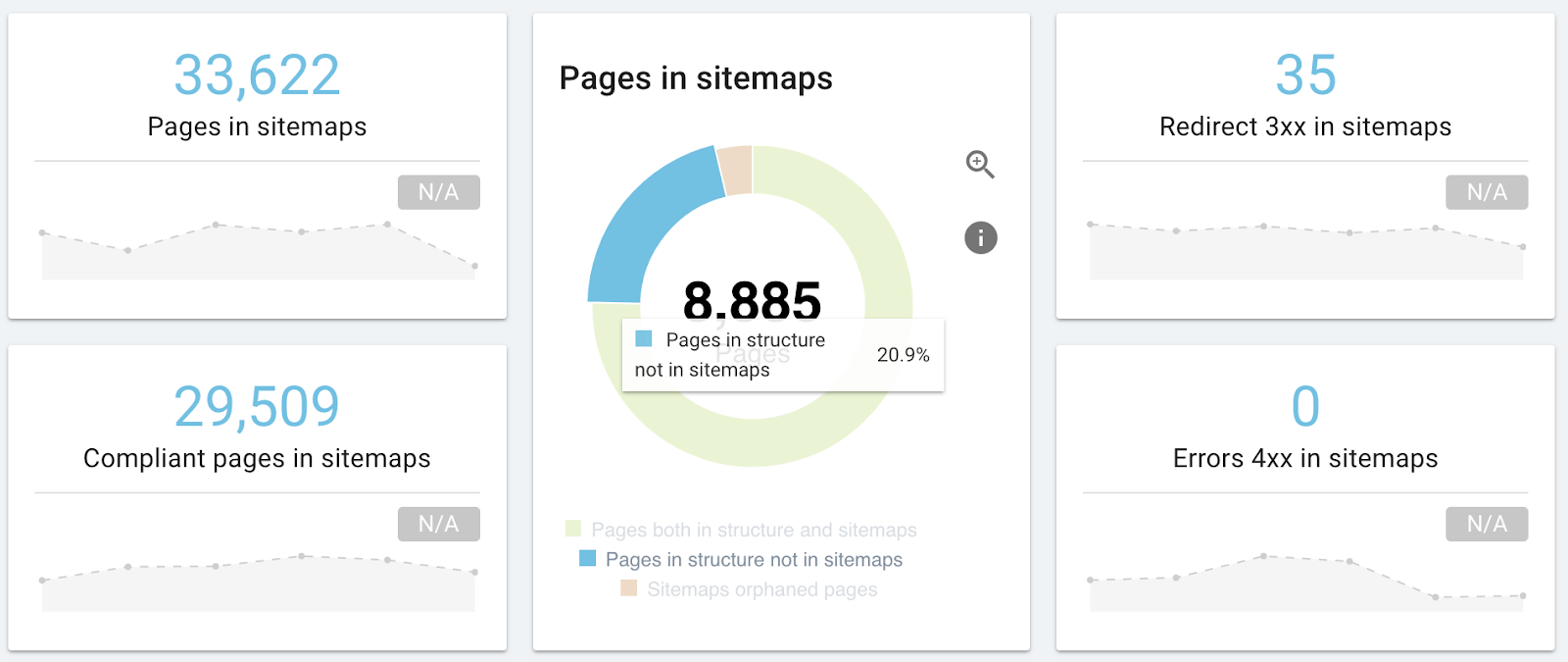

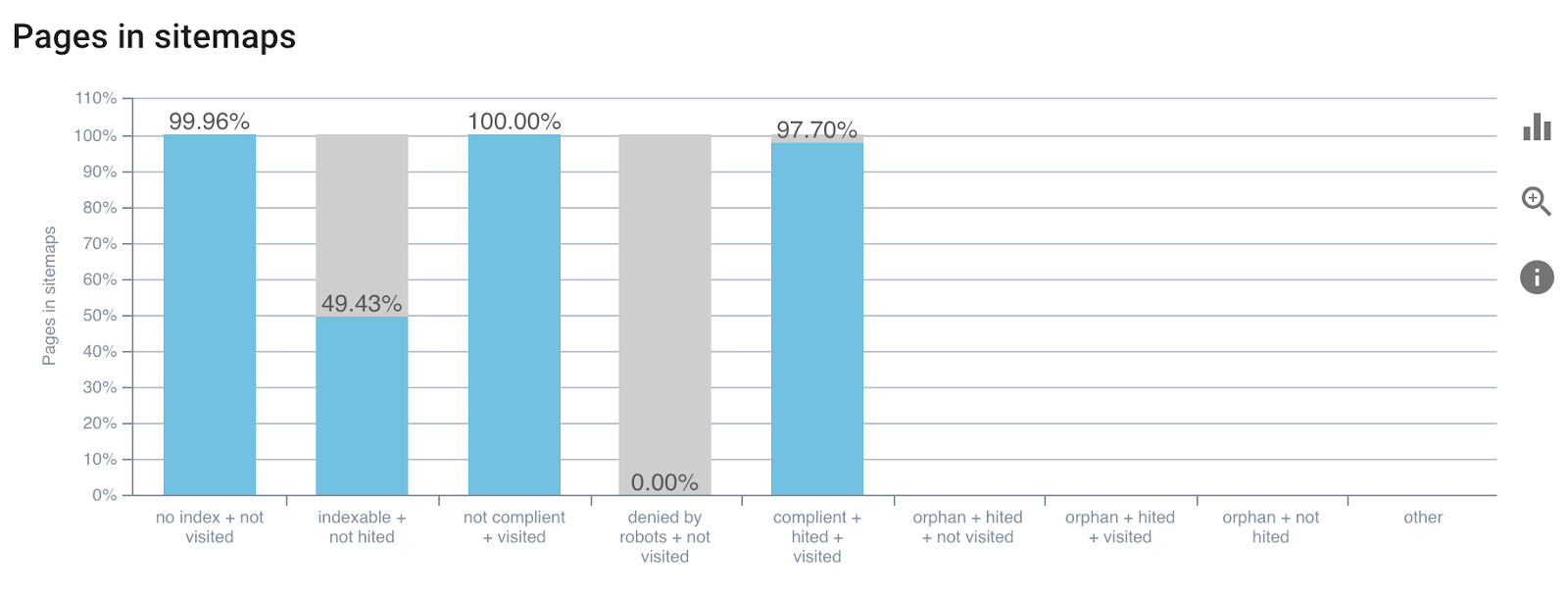

Die neueste Version von OnCrawl wird einen Bericht enthalten, der sich auf die Untersuchung von sitemap.xml bezieht. Damit können Sie bestätigen, dass Sie keine URLs verpasst haben, dass Ihre Sitemaps nicht auf Seiten verweisen, deren kanonische URL von der URL abweicht, oder dass sie auf 404 verweisen.

Beispiel für den Sitemap-Analysebericht

Um mehr über Sitemaps zu erfahren. xml.

Der Tag des Übergangs zur Live-Version

Das Rezept ist fertig und der Code wird von allen Spielern validiert. So haben Sie alle Signale in Grün, um den neuen Code live weiterzugeben. Die SEO wird nicht beeinträchtigt, da die wichtigen Seiten besondere Aufmerksamkeit verdienen. Sie sind aber auch der Garant für alle auf der Google-Seite durchzuführenden Aktionen.

Hier ist eine Liste Ihrer Aufgaben als SEO:

- Überprüfen Sie die robots.txt-Datei;

- Überprüfen Sie den Code online;

- Überprüfen Sie Online-Sitemaps;

- Weiterleitungen prüfen;

Wenn alles in Ordnung ist:

- Motorkriechen erzwingen

- Überprüfen Sie Protokolle und Statuscodes live

Sie können dedizierte Crawls für jeden Schritt starten, das Ziel ist es, die Seiten zu qualifizieren, also verwenden Sie Crawls auf engeren Perimetern, um an Reaktivität zu gewinnen.

Profi-Tipp: Definieren Sie Crawls mit maximaler Tiefe 1, um die Referenzseiten Ihrer Änderungen zu testen, ohne die gesamte Website zu testen.

Live-Nachverfolgung

Nach dem Online-Start müssen Sie in der Lage sein, SEOs vorher/nachher zu vergleichen und sicherzustellen, dass die Migration positive oder minimale negative Auswirkungen hatte.

Sobald die neue Website eingerichtet ist und läuft, müssen die Auswirkungen aller Änderungen überwacht werden. Überwachen Sie als ersten Schritt wöchentlich Rankings und Indexierung. Es wird geschätzt, dass Sie einen kurzen Monat warten müssen, um Schlussfolgerungen zu ziehen, also müssen Sie geduldig sein.

Überprüfen Sie nach der Migration die Leistung der Website in den Webmaster-Tools auf ungewöhnliche Anomalien.

Verfolgen Sie die Indizierungsraten und das Caching Ihrer Seiten durch Suchmaschinen, bevor Sie die Rankings überprüfen.

Wie wir in der Einleitung gesagt haben, werden die Engines einige Zeit brauchen, um sich an Ihre neue Version anzupassen, und die Positionen können während dieser Zeit ziemlich volatil sein.

Das Starten von Crawl Over Crawl (Crawl Over Crawl-Vergleich) vor und nach der Migration zum Vergleichen Ihrer Daten ist der beste Weg, um die Effizienz zu steigern.

Schlussfolgerungen

Die Migration ist eine wichtige und oft vorteilhafte Zeit für die SEO. OnCrawl begleitet Sie durch diese Phasen. Vom ersten Crawl über die Nachverfolgung von Validierungsmetriken bis hin zur Analyse der Suchmaschinenreaktion dank Protokollen wird Ihre operative Arbeit vereinfacht.