Wie geht man mit Bot Herding und Spider Wrangling für Rankings um?

Veröffentlicht: 2020-01-23

Google-Crawler indizieren alle Inhalte, die Sie auf Ihrer Website veröffentlichen. Diese Crawler sind programmierte Software, die Links und Codes folgen und an einen Algorithmus liefern. Dann indiziert der Algorithmus es und fügt Ihren Inhalt einer riesigen Datenbank hinzu. Auf diese Weise extrahiert und ordnet die Suchmaschine verwandte Ergebnisse aus der Datenbank bereits indizierter Seiten, wenn ein Benutzer nach einem Schlüsselwort sucht.

Google weist jeder Website ein Crawl-Budget zu und die Crawler führen das Crawlen Ihrer Website entsprechend aus. Sie müssen das Crawl-Budget verwalten und nutzen, um ein intelligentes Crawlen und Indizieren Ihrer gesamten Website sicherzustellen.

In diesem Beitrag erfahren Sie mehr über die Tricks und Tools, mit denen Sie handhaben können, wie die Suchmaschinen-Bots/Spider oder Crawler Ihre Website crawlen und indizieren.

1. Optimierung der Disallow-Direktive für Robot.txt:

Robots.txt ist eine Textdatei mit einer strengen Syntax, die wie ein Leitfaden für die Spinnen funktioniert, um zu bestimmen, wie sie Ihre Website crawlen sollen. Eine robots.txt-Datei wird in den Host-Repositories Ihrer Website gespeichert, von wo aus Crawler nach den URLs suchen. Um diese Robots.txt oder „Robots Exclusion Protocol“ zu optimieren, können Sie einige Tricks anwenden, die dazu beitragen können, dass die URLs Ihrer Website von Google-Crawlern für höhere Rankings gecrawlt werden.

Einer dieser Tricks ist die Verwendung einer „Disallow Directive“ , das ist so, als würde man ein Schild mit „Restricted Area“ auf bestimmten Abschnitten Ihrer Website anbringen. Um die Disallow-Richtlinie zu optimieren, müssen Sie die erste Verteidigungslinie verstehen: „User-Agents“.

Was ist eine User-Agent-Richtlinie?

Jede Robots.txt-Datei besteht aus einer oder mehreren Regeln, und unter ihnen ist die User-Agent-Regel die wichtigste. Diese Regel bietet den Crawlern Zugriff und Nichtzugriff auf eine bestimmte Liste auf der Website.

Die User-Agent-Direktive wird also verwendet, um einen bestimmten Crawler anzusprechen und ihm Anweisungen zur Ausführung des Crawls zu geben.

Arten von Google Crawlern, die häufig verwendet werden:

Disallow-Anweisung:

Nachdem Sie nun etwas über den Bot erfahren haben, der Ihre Website crawlen soll, können Sie verschiedene Abschnitte davon basierend auf der Art des Benutzeragenten optimieren. Einige wesentliche Tricks und Beispiele, die Sie befolgen können, um die Disallow-Direktive Ihrer Website zu optimieren, sind:

- Verwenden Sie einen vollständigen Seitennamen, der im Browser angezeigt werden kann, um für die Disallow-Anweisung verwendet zu werden.

- Wenn Sie den Crawler von einem Verzeichnispfad umleiten möchten, verwenden Sie ein „/“-Zeichen.

- Verwenden Sie * für Pfadpräfix, -suffix oder eine ganze Zeichenfolge.

Beispiele für die Verwendung der Disallow-Anweisungen sind:

# Beispiel 1: Nur Googlebot blockieren

User-Agent: Googlebot

Nicht zulassen: /

# Beispiel 2: Googlebot und Adsbot blockieren

User-Agent: Googlebot

User-Agent: AdsBot-Google

Nicht zulassen: /

# Beispiel 3: Alle außer AdsBot-Crawler blockieren

User-Agent: *

Nicht zulassen: /

2. Eine Nicht-Index-Direktive für Robots.txt:

Wenn andere Websites auf Ihre Website verlinken, besteht die Möglichkeit, dass die URL, die der Crawler nicht indexieren soll, offengelegt werden kann. Um dieses Problem zu umgehen, können Sie eine Nicht-Index-Direktive verwenden. Lassen Sie uns sehen, wie wir die Non-Index-Direktive auf Robots.txt anwenden können:

Es gibt zwei Methoden, um eine Nicht-Index-Richtlinie für Ihre Website anzuwenden:

<Meta>-Tags:

Meta-Tags sind die Textausschnitte, die den Inhalt Ihrer Seite in einer kurzen, durchsichtigen Weise beschreiben, die es den Besuchern ermöglicht, zu wissen, was kommen wird? Wir können dasselbe verwenden, um zu vermeiden, dass Crawler die Seite indexieren.

Platzieren Sie zunächst ein Meta-Tag „<meta name= „robots“ content=“ noindex“>“ im Abschnitt „<head>“ Ihrer Seite, den die Crawler nicht indexieren sollen.

Für Google-Crawler können Sie „<meta name=“googlebot“ content=“noindex“/>“ im Abschnitt „<head>“ verwenden.

Da verschiedene Suchmaschinen-Crawler nach Ihren Seiten suchen, interpretieren sie Ihre Nicht-Index-Anweisung möglicherweise unterschiedlich. Aus diesem Grund werden Ihre Seiten möglicherweise in den Suchergebnissen angezeigt.

Es wäre also hilfreich, wenn Sie Richtlinien für Seiten gemäß den Crawlern oder Benutzeragenten definieren würden.

Sie können die folgenden Meta-Tags verwenden, um die Richtlinie für verschiedene Crawler anzuwenden:

<meta name="googlebot" content="noindex">

<meta name=“googlebot-news“ content=“nosnippet“>

X-Robots-Tag:

Wir alle kennen die HTTP-Header, die als Antworten auf die Anfrage des Clients oder der Suchmaschine nach zusätzlichen Informationen zu Ihren Webseiten wie Standort oder Server, der sie bereitstellt, verwendet werden. Um diese HTTP-Header-Antworten für die Nicht-Index-Anweisung zu optimieren, können Sie nun X-Robots-Tags als Element der HTTP-Header-Antwort für eine beliebige URL Ihrer Website hinzufügen.

Sie können verschiedene X-Robots-Tags mit den HTTP-Header-Antworten kombinieren. Sie können verschiedene Direktiven in einer durch Komma getrennten Liste angeben. Unten sehen Sie ein Beispiel für eine HTTP-Header-Antwort mit verschiedenen Anweisungen in Kombination mit X-Robots-Tags.

HTTP/1.1 200 OK

Datum: Di, 25. Januar 2020 21:42:43 GMT

(…)

X-Robots-Tag: noarchive

X-Robots-Tag: nicht verfügbar_nach: 25. Juli 2020 15:00:00 PST

(…)

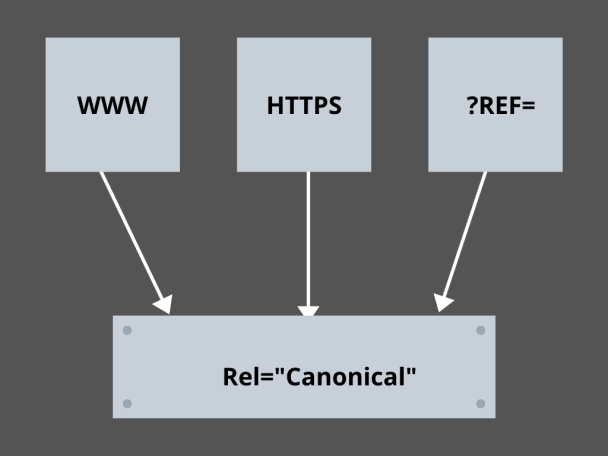

3. Beherrschung der kanonischen Links:

Was ist heute der am meisten gefürchtete Faktor in SEO? Ranglisten? Verkehr? Nein! Es ist die Angst, dass Suchmaschinen Ihre Website für Duplicate Content abstrafen. Während Sie also Ihr Crawl-Budget planen, müssen Sie darauf achten, dass Sie Ihren doppelten Inhalt nicht offenlegen.

Hier hilft Ihnen die Beherrschung Ihrer kanonischen Links, Ihre Probleme mit doppelten Inhalten zu lösen. Das Wort Duplicate Content ist nicht das, was es bedeutet. Nehmen wir als Beispiel zwei Seiten einer E-Commerce-Website:

Sie haben beispielsweise eine E-Commerce-Website mit zwei identischen Seiten für eine Smartwatch, und beide haben ähnliche Inhalte. Wenn die Suchmaschinen-Bots Ihre URL crawlen, suchen sie nach doppelten Inhalten und können eine der URLs auswählen. Um sie auf die für Sie wesentliche URL umzuleiten, kann für die Seiten ein kanonischer Link gesetzt werden. Lassen Sie uns sehen, wie Sie es tun können:

- Wählen Sie eine der beiden Seiten für Ihre kanonische Version aus.

- Wählen Sie diejenige aus, die mehr Besucher empfängt.

- Fügen Sie nun rel="canonical" zu Ihrer nicht-kanonischen Seite hinzu.

- Leiten Sie den nicht-kanonischen Seitenlink auf die kanonische Seite um.

- Es wird beide Seitenlinks zu einem einzigen kanonischen Link zusammenführen.

4. Strukturierung der Website:

Crawler benötigen Markierungen und Schilder, die ihnen helfen, die wichtigen URLs Ihrer Website zu finden, und wenn Sie Ihre Website nicht strukturieren, haben Crawler Schwierigkeiten, das Crawlen auf Ihren URLs auszuführen. Dafür verwenden wir Sitemaps, weil sie den Crawlern Links zu allen wichtigen Seiten Ihrer Website liefern.

Standard-Sitemap-Formate für Websites oder sogar Apps, die durch Entwicklungsprozesse für mobile Apps entwickelt wurden, sind XML-Sitemaps, Atom und RSS. Um das Crawling zu optimieren, müssen Sie XML-Sitemaps und RSS/Atom-Feeds kombinieren.

- Da XML-Sitemaps Crawlern Wegbeschreibungen zu allen Seiten Ihrer Website oder App liefern.

- Und der RSS/Atom-Feed bietet Crawlern Aktualisierungen auf Ihren Seiten der Website.

- Da XML-Sitemaps Crawlern Wegbeschreibungen zu allen Seiten Ihrer Website oder App liefern.

5. Seitennavigation:

Die Seitennavigation ist für Spider und sogar für Besucher Ihrer Website unerlässlich. Diese Boots suchen nach Seiten auf Ihrer Website, und eine vordefinierte hierarchische Struktur kann Crawlern helfen, Seiten zu finden, die für Ihre Website wichtig sind. Weitere Schritte für eine bessere Seitennavigation sind:

- Behalten Sie die Codierung in HTML oder CSS bei.

- Ordnen Sie Ihre Seiten hierarchisch an.

- Verwenden Sie eine flache Website-Struktur für eine bessere Seitennavigation.

- Halten Sie das Menü und die Registerkarten in der Kopfzeile minimal und spezifisch.

- Es wird helfen, die Seitennavigation zu vereinfachen.

6. Vermeidung der Spinnenfallen:

Spinnenfallen sind endlose URLs, die auf denselben Inhalt auf denselben Seiten verweisen, wenn Crawler Ihre Website durchsuchen. Dies ist eher wie das Schießen von Leerzeichen. Letztendlich wird es Ihr Crawl-Budget auffressen. Dieses Problem eskaliert mit jedem Crawling und Ihre Website wird als doppelter Inhalt angesehen, da jede URL, die in der Falle gecrawlt wird, nicht eindeutig ist.

Sie können die Falle durchbrechen, indem Sie den Abschnitt durch Robots.txt blockieren oder eine der Direktiven follow oder no follow verwenden , um bestimmte Seiten zu blockieren. Schließlich können Sie versuchen, das Problem technisch zu beheben, indem Sie das Auftreten unendlicher URLs stoppen.

7. Verknüpfungsstruktur:

Die Verknüpfung ist einer der wesentlichen Bestandteile der Crawl-Optimierung. Crawler können Ihre Seiten mit gut strukturierten Links auf Ihrer gesamten Website besser finden. Einige der wichtigsten Tricks für eine großartige Linkstruktur sind:

- Verwendung von Textlinks, da Suchmaschinen diese leicht crawlen: <a href=“new-page.html“>Textlink</a>

- Verwendung von beschreibendem Ankertext in Ihren Links

- Angenommen, Sie betreiben eine Fitnessstudio-Website und möchten alle Ihre Fitnessstudio-Videos verlinken, können Sie einen Link wie diesen verwenden. Sie können gerne alle unsere <a href=”videos.html”>Fitness-Videos</a> durchsuchen.

8. HTML-Glück:

Es ist wichtig, Ihre HTML-Dokumente zu bereinigen und die Nutzlastgröße der HTML-Dokumente minimal zu halten, da dies den Crawlern ermöglicht, die URLs schnell zu crawlen. Ein weiterer Vorteil der HTML-Optimierung ist, dass Ihr Server durch mehrere Crawls durch Suchmaschinen stark belastet wird, was das Laden Ihrer Seite verlangsamen kann, was kein gutes Zeichen für SEO oder das Crawlen der Suchmaschine ist. Die HTML-Optimierung kann die Crawling-Last auf dem Server verringern und dafür sorgen, dass die Seiten schnell geladen werden. Es hilft auch bei der Lösung von Crawling-Fehlern aufgrund von Server-Timeouts oder anderen wichtigen Problemen.

9. Einfach einbetten:

Keine Website wird heute Inhalte ohne großartige Bilder und Videos anbieten, die den Inhalt untermauern, da dies ihren Inhalt optisch attraktiver und für die Suchmaschinen-Crawler zugänglicher macht. Wenn diese eingebetteten Inhalte jedoch nicht optimiert sind, kann dies die Ladegeschwindigkeit verringern und die Crawler von Ihren rankenden Inhalten wegtreiben.

Hier kann das Festhalten am HTML für Ihre eingebetteten Inhalte dazu beitragen, ein besseres Crawling durch die Suchmaschinen zu erreichen. Technologien wie AJAX, Javascript usw. sind ziemlich gut darin, neue Funktionen bereitzustellen, aber sie machen das Crawlen von Suchmaschinen auch ziemlich schwierig.

Fazit:

Mit einem stärkeren Fokus auf SEO und höherem Traffic sucht jeder Website-Besitzer nach besseren Möglichkeiten, mit Bot-Herding und Spider-Wrangling umzugehen. Die Lösungen liegen jedoch in den granularen Optimierungen, die Sie an Ihrer Website vornehmen müssen, und beim Crawlen von URLs, die das Suchmaschinen-Crawling spezifischer und optimierter machen können, um das Beste aus Ihrer Website darzustellen, das auf den Suchmaschinen-Ergebnisseiten einen höheren Rang einnehmen kann.