Das Crawl-Budget von Google: Wie es funktioniert und wie Sie Ihres maximieren können

Veröffentlicht: 2021-03-02Für jede Website im Internet hat Google ein festes Budget dafür, wie viele Seiten ihre Bots crawlen können und wollen. Das Internet ist ein großer Ort, daher kann der Googlebot nur begrenzt Zeit damit verbringen, unsere Websites zu crawlen und zu indizieren. Crawl-Budget-Optimierung ist der Prozess, der dafür sorgt, dass die richtigen Seiten unserer Websites im Index von Google landen und den Suchenden letztendlich angezeigt werden.

Die Empfehlungen von Google zur Optimierung des Crawl-Budgets sind eher begrenzt, da der Googlebot die meisten Websites durchkriecht, ohne an sein Limit zu stoßen. Aber Unternehmens- und E-Commerce-Websites mit Tausenden von Zielseiten laufen Gefahr, ihr Budget zu überschreiten. Eine Studie aus dem Jahr 2018 ergab sogar, dass die Crawler von Google es nicht schafften, mehr als die Hälfte der Webseiten größerer Websites im Experiment zu crawlen.

Die Beeinflussung der Verwendung des Crawl-Budgets kann für Strategen eine schwierigere technische Optimierung darstellen. Aber für Unternehmens- und E-Commerce-Websites lohnt es sich, das Crawling-Budget so weit wie möglich zu maximieren. Mit ein paar Optimierungen können Websitebesitzer und SEO-Strategen den Googlebot anleiten, regelmäßig ihre Seiten mit der besten Leistung zu crawlen und zu indizieren.

Wie bestimmt Google das Crawl-Budget?

Das Crawling-Budget ist im Wesentlichen die Zeit und die Ressourcen, die Google bereit ist, für das Crawlen Ihrer Website aufzuwenden. Die Gleichung lautet wie folgt:

Crawl-Budget = Crawl-Rate + Crawl-Nachfrage

Domain-Autorität, Backlinks, Website-Geschwindigkeit, Crawling-Fehler und die Anzahl der Zielseiten wirken sich alle auf die Crawling-Rate einer Website aus. Größere Websites haben normalerweise eine höhere Crawling-Rate, während kleinere Websites, langsamere Websites oder solche mit übermäßigen Weiterleitungen und Serverfehlern normalerweise weniger häufig gecrawlt werden.

Google bestimmt das Crawl-Budget auch anhand der „Crawl-Nachfrage“. Beliebte URLs haben eine höhere Crawling-Nachfrage, da Google den Nutzern die aktuellsten Inhalte bereitstellen möchte. Google mag keine veralteten Inhalte in seinem Index, daher werden auch Seiten, die längere Zeit nicht gecrawlt wurden, eine höhere Nachfrage haben. Wenn Ihre Website eine Website-Migration durchläuft, erhöht Google die Crawling-Nachfrage, um den Index schneller mit Ihren neuen URLs zu aktualisieren.

Das Crawl-Budget Ihrer Website kann schwanken und ist sicherlich nicht festgelegt. Wenn Sie Ihr Server-Hosting oder die Website-Geschwindigkeit verbessern, beginnt der Googlebot möglicherweise häufiger mit dem Crawlen Ihrer Website, da er weiß, dass dies die Web-Erfahrung für die Nutzer nicht verlangsamt. Um eine bessere Vorstellung von der aktuellen durchschnittlichen Crawling-Rate Ihrer Website zu erhalten, sehen Sie sich Ihren Crawling-Bericht der Google Search Console an.

Muss sich jede Website Gedanken über ihr Crawl-Budget machen?

Kleinere Websites, die sich nur darauf konzentrieren, ein paar Zielseiten zu platzieren, müssen sich keine Gedanken über das Crawl-Budget machen. Aber größere Websites – insbesondere ungesunde Websites mit übermäßig vielen kaputten Seiten und Weiterleitungen – können leicht ihr Crawling-Limit erreichen.

Die Arten von großen Websites, bei denen das größte Risiko besteht, dass sie ihr Crawl-Budget ausschöpfen, haben normalerweise Zehntausende von Zielseiten. Insbesondere große E-Commerce-Websites werden oft durch Crawl-Budgets negativ beeinflusst. Ich bin auf mehrere Unternehmenswebsites gestoßen, bei denen eine beträchtliche Anzahl ihrer Zielseiten nicht indexiert ist, was bedeutet, dass sie keine Chance haben, in Google zu ranken.

Es gibt einige Gründe, warum insbesondere E-Commerce-Websites mehr darauf achten müssen, wohin ihr Crawl-Budget fließt.

- Viele E-Commerce-Websites bauen programmgesteuert Tausende von Zielseiten für ihre SKUs oder für jede Stadt oder jeden Staat auf, in dem sie ihre Produkte verkaufen.

- Diese Arten von Websites aktualisieren regelmäßig ihre Zielseiten, wenn Artikel nicht mehr vorrätig sind, neue Produkte hinzugefügt werden oder andere Bestandsänderungen auftreten.

- E-Commerce-Websites neigen zu doppelten Seiten (z. B. Produktseiten) und Sitzungskennungen (z. B. Cookies). Beide werden vom Googlebot als URLs mit „geringem Mehrwert“ wahrgenommen, was sich negativ auf die Crawling-Rate auswirkt

Eine weitere Herausforderung bei der Beeinflussung des Crawl-Budgets besteht darin, dass Google es jederzeit erhöhen oder verringern kann. Obwohl eine Sitemap ein wichtiger Schritt für große Websites ist, um das Crawling und die Indexierung ihrer wichtigsten Seiten zu verbessern, reicht sie nicht aus, um sicherzustellen, dass Google Ihr Crawling-Budget nicht auf minderwertigen oder leistungsschwachen Seiten ausschöpft.

Wie also können Webmaster eine Crawl-Budget-Optimierung durchführen?

Obwohl Websitebesitzer in ihren Google Search Console-Konten höhere Crawling-Limits festlegen können, garantiert die Einstellung keine erhöhten Crawling-Anfragen oder beeinflusst nicht, welche Seiten Google letztendlich crawlt. Es scheint, als wäre die natürlichste Lösung, Google dazu zu bringen, Ihre Website häufiger zu crawlen, aber es gibt sehr begrenzte Optimierungen, die in direktem Zusammenhang mit einer erhöhten Crawling-Rate stehen.

Wir alle wissen, dass es bei guter Budgetierung nicht darum geht, Ihre Ausgabengrenzen zu erhöhen; Es geht darum, selektiver zu sein, wofür Sie Ihr Geld ausgeben. Wenn Sie dasselbe Konzept auf das Crawl-Budget anwenden, kann es zu enormen Ergebnissen führen. Hier sind einige strategische Schritte, mit denen Sie Google dabei helfen können, Ihr Budget zu Ihrem Vorteil einzusetzen.

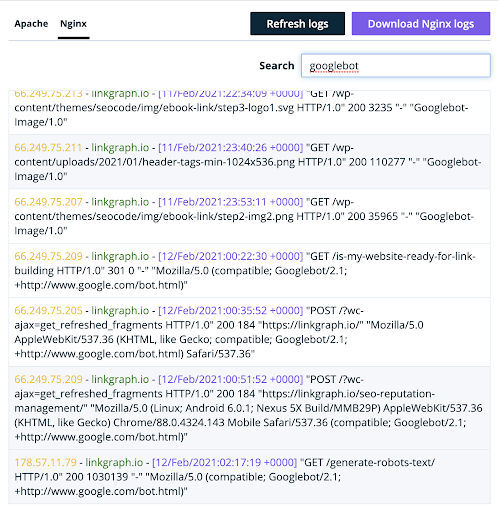

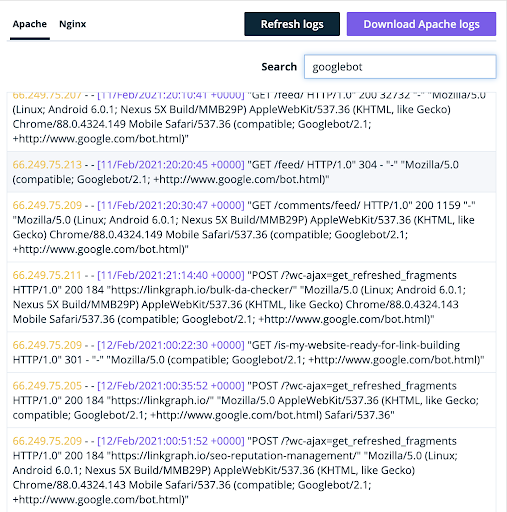

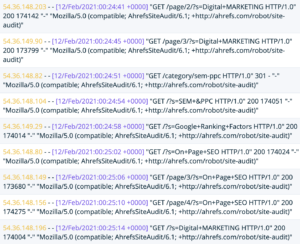

Schritt 1: Identifizieren Sie, welche Seiten Google tatsächlich auf Ihrer Website crawlt

Bis vor kurzem informierte der Crawling-Bericht der Google Search Console nur über Websitebesitzer, wie viele Crawling-Anfragen ihre Website an bestimmten Tagen erhalten hat. Obwohl der neue Crawl-Statistikbericht von Google weitaus detailliertere Informationen zum Crawling bietet, ist der beste Ort, um zu verstehen, wie Google Ihre Website crawlt, immer noch in Ihren Server-Logdateien.

Wenn Google Ihre Website besucht, verwenden sie einen bestimmten Benutzeragenten. Dadurch weiß Ihr Server, dass es sich bei dem Datenverkehr tatsächlich um einen Googlebot und nicht um eine echte Person handelt.

(Sie finden dort auch den Bot von Bingbot und Ahrefs).

Oncrawl Log Analyzer

Websitebesitzer, die den Inhalt dieser Protokolldatei analysieren, erhalten zahlreiche Informationen über das Crawl-Budget von Google für ihre Website. Die Datei wird einige Dinge enthüllen:

- Welche Seiten der User Agent besucht

- Wie viele Seiten dieser Agent pro Tag durchsucht

- Ob eine der gecrawlten Seiten 404ing oder defekt ist oder nicht

Im Idealfall möchten Sie, dass Google die Zielseiten Ihrer Website crawlt, die für die wertvollsten Keywords optimiert sind. Außerdem sollten Websitebesitzer niemals Crawl-Budget für 404-Fehler verschwenden. Die Google Search Console zeigt Ihnen nur einige Ihrer Soft-404-Fehler an, aber Sie können sie alle in Ihren Serverprotokollen identifizieren.

Sobald Sie detailliertere Informationen darüber haben, welche Seiten Ihrer Website gecrawlt werden, führen Sie die folgenden Aktionselemente aus:

- Robots-Tags hinzufügen: Wenn der Googlebot diese 404er oder defekten Seiten crawlt, sollte Priorität Nummer eins das Hinzufügen von Robots-Tags [noindex, nofollow] sein, um zu verhindern, dass der Googlebot diese Seiten crawlt und indexiert.

- Passen Sie Ihre Sitemap an: Wenn Ihre Serverprotokolle zeigen, dass Google Ihre potenziell leistungsstarken Seiten nicht crawlt, platzieren Sie sie in Ihrer Sitemap weiter oben, um sicherzustellen, dass sie gecrawlt werden.

Schritt 2: Akzeptieren Sie, dass nicht alle Ihre Zielseiten in Google ranken müssen

Der Hauptgrund, warum so viele Websites auf Unternehmensebene ihr Crawl-Budget verschwenden, liegt darin, dass sie Google erlauben, jede Zielseite auf ihrer Website zu crawlen. Viele Websites stellen sogar gerne alle ihre Seiten in ihre mobile App, damit Google sie alle finden und crawlen kann. Das ist ein Fehler, denn in Wirklichkeit werden nicht alle unsere Landingpages ranken.

Was ist der Wert einer Zielseite im Google-Index? Ranking und Konvertierung. Wenn Ihre Website Zielseiten hat, die nicht durch Rankings für mehrere Schlüsselwörter oder durch Umwandlung von Websitebesuchern in Leads und Einnahmen überzeugen, warum sollten Sie dann das Risiko eingehen, sie von Google crawlen zu lassen?

Eigentümer von Unternehmens- und E-Commerce-Websites sollten wissen, welche Seiten ihrer Websites für Conversions optimiert sind und die größten Chancen auf Ranking und Conversion haben. Dann sollten sie jeden möglichen Vorteil nutzen, um sicherzustellen, dass Google das Crawl-Budget für diese leistungsstarken Seiten ausgibt.

Die Zielseiten Ihrer Website, die ein hohes Ranking- und Conversion-Potenzial haben, sind es wert, Crawl-Budget dafür auszugeben. Hier sind einige Tipps, um sicherzustellen, dass der Googlebot diese Seiten in Ihr Budget einbezieht.

- Reduzieren Sie die Anzahl der Seiten in Ihrer Sitemap . Konzentrieren Sie sich nur auf die Seiten, die tatsächlich gute Chancen auf ein Ranking und organischen Traffic haben.

- Löschen Sie leistungsschwache oder unnötige Seiten . Entfernen Sie die Seiten, die keinen Wert bringen, weil sie keinen Ranking-, Konvertierungs- oder funktionalen Zweck haben.

- Inhalt beschneiden . Beschneiden Sie die Seiten, die eigentlich keinen organischen Traffic erhalten, und leiten Sie sie auf andere Zielseiten auf Ihrer Website weiter, die relevant sind und Traffic erhalten. Beachten Sie, dass Weiterleitungen einen Teil Ihres Crawl-Budgets auffressen, also versuchen Sie, sie sparsam einzusetzen und verwenden Sie sie niemals zweimal hintereinander.

Es ist für jeden Websitebesitzer schwierig, Inhalte loszulassen, aber es ist viel einfacher, Google daran zu hindern, bestimmte Seiten zu crawlen, als Google dazu zu bringen, Ihr gesamtes Crawl-Budget zu erhöhen. Das Bereinigen Ihrer Website, damit die Crawler von Google mit größerer Wahrscheinlichkeit die besten Inhalte finden und indizieren, hat höchste Priorität, wenn Sie Ihr Crawl-Budget sinnvoll einsetzen möchten.

Schritt 3: Verwenden Sie interne Links, um leistungsstarke Seiten für die Crawler von Google zu verbessern

Sobald Sie festgestellt haben, welche Seiten Google crawlt, notwendige Robots-Tags hinzugefügt, leistungsschwache Seiten gelöscht oder beschnitten und Anpassungen an Ihrer Sitemap vorgenommen haben, werden die Crawler von Google eher dazu neigen, ihr Budget für die richtigen Seiten Ihrer Website auszugeben.

Aber um dieses Budget wirklich zu maximieren, müssen Ihre Seiten das Zeug zum Ranking haben. Best Practices für On-Page-SEO sind der Schlüssel, aber eine fortgeschrittenere technische Strategie besteht darin, Ihre interne Linkstruktur zu verwenden, um diese potenziell leistungsstarken Seiten zu verbessern.

So wie der Googlebot nur über ein begrenztes Crawl-Budget verfügt, hat Ihre Website basierend auf ihrem Internet-Fußabdruck nur eine bestimmte Menge an Website-Eigenkapital. Es liegt in Ihrer Verantwortung, Ihr Eigenkapital intelligent zu konzentrieren. Das bedeutet, dass Sie den Standortwert auf die Seiten lenken, die auf Keywords abzielen, für die Sie eine gute Chance haben, zu ranken, und auf diejenigen, die Ihnen Traffic mit den richtigen Arten von Kunden bringen, die wahrscheinlich konvertieren und tatsächlich einen wirtschaftlichen Wert haben.

Diese SEO-Strategie ist als PageRank Sculpting bekannt. Wenn Sie eine große Website mit Tausenden von Zielseiten haben, kann ein erfahrener Stratege SEO-Experimente durchführen, um das interne Verlinkungsprofil Ihrer Website für eine bessere PageRank-Verteilung zu optimieren. Wenn Sie eine neue Website haben, können Sie der Kurve einen Schritt voraus sein, indem Sie PageRank Sculpting in Ihre Website-Architektur integrieren und bei jeder neuen Landingpage, die Sie erstellen, an den Standortwert denken.

Hier sind zwei meiner Lieblingsstrategien zur Analyse meiner Seiten, um festzustellen, welche am meisten von PageRank Sculpting profitieren würden.

- Finden Sie die Seiten Ihrer Website, die gut besucht werden, aber nicht genügend PageRank haben . Finden Sie Möglichkeiten, diesen Seiten mehr interne Links zu geben und dort mehr PageRank zu senden. Das Hinzufügen zur Kopf- oder Fußzeile Ihrer Website ist eine großartige Möglichkeit, dies schnell zu tun, aber übertreiben Sie die Links in Ihrem Navigationsmenü nicht.

- Konzentrieren Sie sich auf die Seiten, die viele interne Links haben, aber nicht viel Verkehr, Suchimpressionen und Rang für sehr wenige Keywords erhalten . Seiten, die viele interne Links erhalten, enthalten normalerweise viel PageRank. Wenn sie diesen PageRank nicht verwenden, um organischen Traffic auf Ihre Website zu bringen, verschwenden sie ihn. Es ist besser, diesen PageRank auf Seiten zu verschieben, die tatsächlich die Nadel bewegen können.

Der letzte Schritt zur Optimierung des Crawl-Budgets ist das Verständnis der Rolle, die jeder Link auf Ihrer Website nicht nur dabei spielt, den Googlebot auf Ihrer Website herumzuschicken, sondern auch bei der Verteilung Ihres Link-Equity. Die richtige interne Linkstruktur kann zu dramatischen Ranking-Verbesserungen für Ihre Geldseiten führen. Letztendlich geben Sie Ihr Crawl-Budget am besten für Zielseiten aus, die Ihnen am ehesten Einnahmen bringen werden.

Nachdem Sie Ihre Änderungen implementiert haben, behalten Sie die Keyword-Rankings für diese verbesserten Seiten in einem Tool der Google Search Console im Auge. Wenn sich die Rankings für diese Seiten verbessern, zeigt dies, dass Ihre Crawl-Budget-Optimierung funktioniert. Wenn Sie dann neue Seiten zu Ihrer Website hinzufügen, seien Sie wählerischer, ob sie es verdienen, Ihr Crawl-Budget aufzufressen oder nicht. Wenn nicht, leiten Sie Crawler weiterhin nur auf die Seiten weiter, die für Ihre Marke am härtesten arbeiten.