A/B-Teststatistiken: Warum Statistiken beim Experimentieren wichtig sind

Veröffentlicht: 2020-11-16

Eine Kurzanleitung zu Statistiken und A/B-Tests: Die Begriffe, die Sie kennen müssen

Es ist fast unmöglich, ein vernünftiges A/B-Testing-Experiment durchzuführen, ohne die Statistik im Griff zu haben.

Während eine Plattform wie Convert Experiences alle statistischen Messungen, Argumente und Analysen für Sie erledigen kann, wird Ihnen ein grundlegendes Verständnis einiger statistischer Begriffe sicherlich helfen.

Beginnen wir mit den Grundlagen.

Stichprobe und Population

Wenn Sie den gesamten Datenverkehr Ihrer Website für A/B-Tests verwenden, erhalten Sie theoretisch eine allgemeine Vorstellung von Ihrer Bevölkerung. Dies kann jedoch eine suboptimale Ressourcennutzung darstellen, da die Population in ihrer Gesamtheit nicht erfasst werden kann. Hier kommen Proben ins Spiel. Es gibt zwar verschiedene Methoden der Stichprobenziehung, aber die Verwendung eines zufälligen Stichprobenansatzes hilft sicherzustellen, dass es keine inhärenten Verzerrungen bei der Stichprobenauswahl gibt. Dieser Ansatz ist inspiriert von der pharmakologischen Praxis randomisierter kontrollierter Studien.

Mittelwert, Median und Modus

Einfach ausgedrückt steht Mittelwert für den Durchschnitt, Median für die Werte, die sich in der Mitte befinden, wenn alle Zahlen linear ausgerichtet sind (das 50. Perzentil in der Verteilung), und Modus ist der am häufigsten wiederholte Wert. Diese drei Begriffe sind praktisch, wenn Sie die zusammenfassenden Statistiken eines A/B-Tests durchgehen.

Varianz und Standardabweichung

Dies sind sehr wichtige Konzepte, die die Streuung in den Datenpunkten messen. Mit anderen Worten, wie weit die Daten vom Mittelwert entfernt sind. Die Standardabweichung ist die Quadratwurzel der Varianz. Aus diesem Grund ist die Standardabweichung ein besserer Maßstab für die Streuung, da sie dieselbe Maßeinheit wie der Mittelwert hat. Beispielsweise beträgt die durchschnittliche Größe erwachsener Männer in den USA 70 Zoll mit einer Standardabweichung von 3 Zoll. Wenn wir in diesem Beispiel Varianz verwenden würden, wäre der Wert 9 Quadratzoll, also weniger intuitiv. Stellen Sie sich die Standardabweichung als die „übliche“ Abweichung der Daten vor.

Null- und Alternativhypothese

EIN Die Nullhypothese appelliert an den Status quo. Ihre Nullhypothese würde besagen, dass jede Änderung, die Sie in den Daten beobachtet haben, zum Beispiel der Anstieg, auf reinen Zufall zurückzuführen ist. Eine alternative Hypothese wäre, dass die Änderung nicht zufällig ist, sondern auf einen kausalen Effekt hinweist, was bedeutet, dass Ihre Änderungen Auswirkungen auf Ihre Benutzer hatten.

Nehmen Sie zum Beispiel an, dass Sie versuchen, die beste Überschrift für Ihre Zielseite zu konkretisieren. Sie haben eine Steuerungsvariante und eine alternative Variante. Sie führen einen A/B-Test durch und erhalten für beide unterschiedliche Conversion-Raten, also gibt es einen Anstieg (positiv oder negativ). Die Nullhypothese hier wäre, dass der Unterschied auf Zufälligkeit zurückzuführen ist. Die Alternativhypothese besagt, dass die Veränderung auf eine bestimmte Variante zurückzuführen ist.

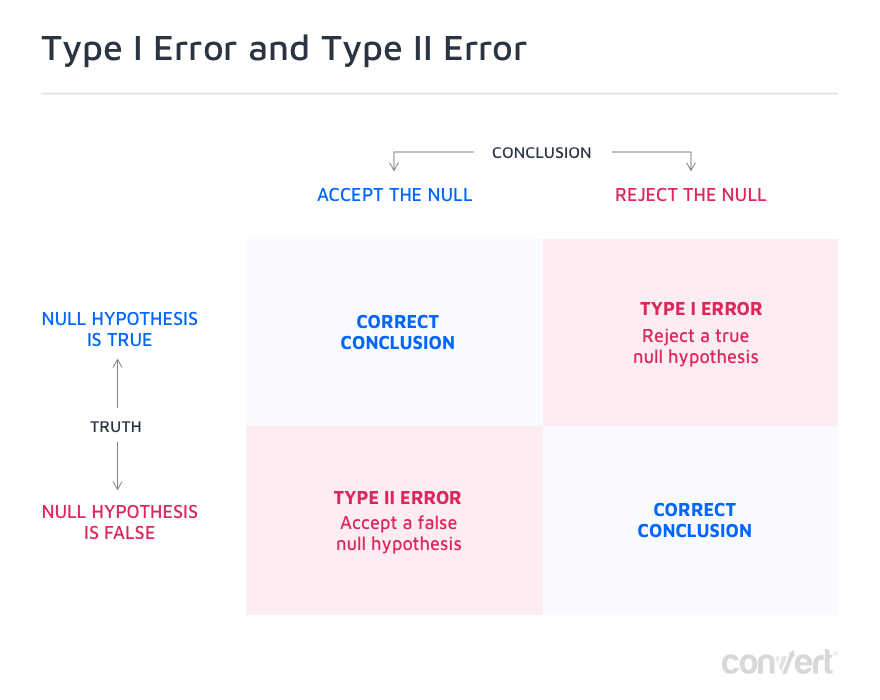

Wenn Sie einen A/B-Test durchführen, erhalten Sie eines der folgenden vier Ergebnisse:

- Sie lehnen die Nullhypothese ab.

- Sie lehnen die Nullhypothese nicht ab.

- Sie lehnen die Nullhypothese fälschlicherweise ab.

- Sie lehnen die Nullhypothese fälschlicherweise nicht ab.

Idealerweise sollten die Ergebnisse a und b angestrebt werden, da Sie aus diesen Szenarien etwas lernen können. So können Sie Ihr Produkt verbessern und letztendlich Ihren Gewinn steigern. Die Ergebnisse c und d entsprechen den nachstehenden Fehlern.

Fehler vom Typ I und Typ II

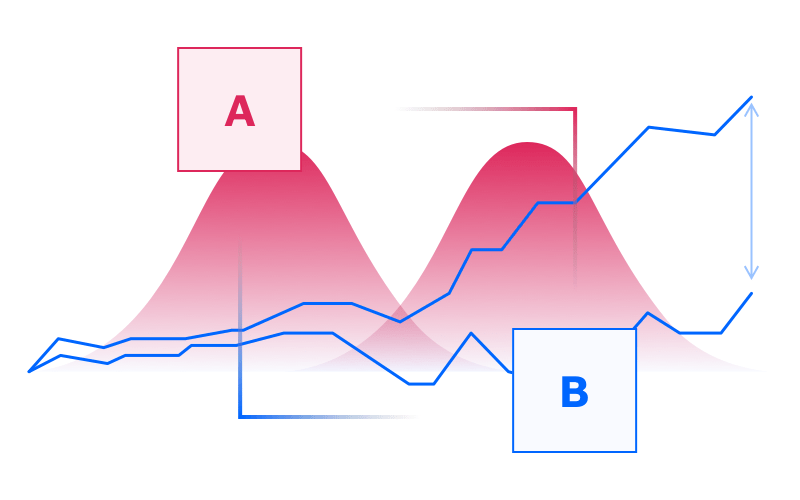

Die letzten beiden Optionen in den möglichen Ergebnissen Ihres A/B-Tests sind Typ-I- und Typ-II-Fehler, auch bekannt als falsch positive und falsch negative.

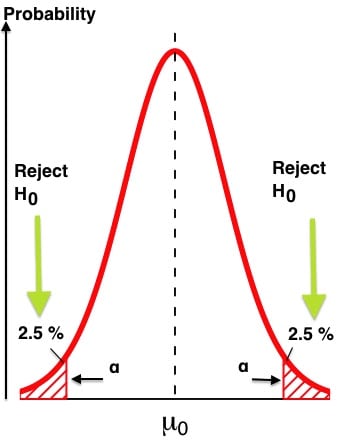

Ein Fehler erster Art liegt vor, wenn Sie eine wahre Nullhypothese fälschlicherweise ablehnen. Das heißt, die von Ihnen beobachtete Änderung war zufällig, aber Sie sind zu einem anderen Schluss gekommen, also ist es ein falsch positives Ergebnis. In den meisten Fällen ist alles, was erforderlich ist, um falsch positive Ergebnisse zu verringern, das Konfidenzniveau zu erhöhen, das erforderlich ist, um statistische Signifikanz zu erreichen. Dies ist normalerweise auf 95 % eingestellt, aber für unternehmenskritische Experimente sollten Sie es auf 99 % Konfidenz setzen, wodurch die Wahrscheinlichkeit, einen solchen Fehler zu machen, auf nur 1 % reduziert wird.

Fehler vom Typ II sind das genaue Gegenteil. Hier versäumen Sie es, eine falsche Nullhypothese zurückzuweisen. Dies bedeutet, dass es eine echte positive oder negative Auswirkung auf die Conversion-Rate gab, diese jedoch statistisch nicht signifikant zu sein schien und Sie fälschlicherweise erklärten, dass dies auf Zufall zurückzuführen sei. Meistens liegt dies an einem Mangel an statistischer Aussagekraft.

In der statistischen Potenzsprache steht der griechische Buchstabe α für Fehler vom Typ I und β für Fehler vom Typ II. Es ist leicht, zwischen statistischer Aussagekraft und statistischer Signifikanz zu verwechseln.

Diese Tabelle macht deutlich:

Statistisches Vertrauen

Je mehr Besucher Ihr Test bekommt, desto mehr steigt Ihr statistisches Vertrauen, bis es 99 % erreicht, wenn Sie es lange genug laufen lassen. Aber normalerweise, sofern es nicht unternehmenskritisch ist, wird ein Konfidenzniveau von 95 % für die meisten A/B-Tests als ausreichend angesehen (es stellt sicher, dass die Wahrscheinlichkeit eines falsch positiven Ergebnisses, dh eines Fehlers 1. Art, höchstens 5 % beträgt).

Statistische Macht

Die statistische Aussagekraft bezieht sich auf die Wahrscheinlichkeit, einen Effekt zu entdecken, wenn es einen gibt.

Statistische Aussagekraft und statistisches Vertrauen sind verwandte Konzepte, die zusammenwirken, um die Entwicklung eines A/B-Tests zu messen. Idealerweise sollten beide Schwellenwerte überschreiten, bevor der Test beendet wird (mehr dazu weiter unten).

Konfidenzintervall und Fehlerspanne

Im Allgemeinen lautet die Ausgabe Ihres A/B-Testexperiments etwa so: „Die Conversion-Rate beträgt 3 % +/- 1 %“. In dieser Aussage stellen die "1 %" Ihre Fehlerspanne dar. Kurz gesagt, dies ist die Abweichung der Konvertierungsergebnisse, die angemessen ist, um die Testergebnisse akzeptabel zu halten. Je kleiner die Fehlerspanne, desto zuverlässiger werden Ihre Testergebnisse. Wenn Sie Ihre Stichprobengröße erhöhen, werden Sie feststellen, dass die Fehlerspanne abnimmt.

Wenn Sie A/B-Tests mit Convert Experiences durchführen, erhalten Sie Zugriff auf den Erfahrungsbericht, in dem Variation, Conversion-Rate, Verbesserung, Vertrauen und Conversions bei einzelnen monatlichen Besuchern aufgeführt sind . Sie sollten mindestens 97 % Vertrauen erreichen, um einen Gewinner zu erklären. Standardmäßig wurde die Convert-Plattform so optimiert, dass die Analyse des Experiments erst nach fünf Conversions gemeldet wird. Um die Zuverlässigkeit der Tests zu gewährleisten, verwendet Convert zweiseitige Z-Tests.

Wenn zu Beginn Ihres Experiments eine der Varianten deutlich besser abschneidet, sollten Sie dennoch mit der vorgeschriebenen Testdauer fortfahren. Frühe Ergebnisse können durch Rauschen oder Zufall verursacht werden.

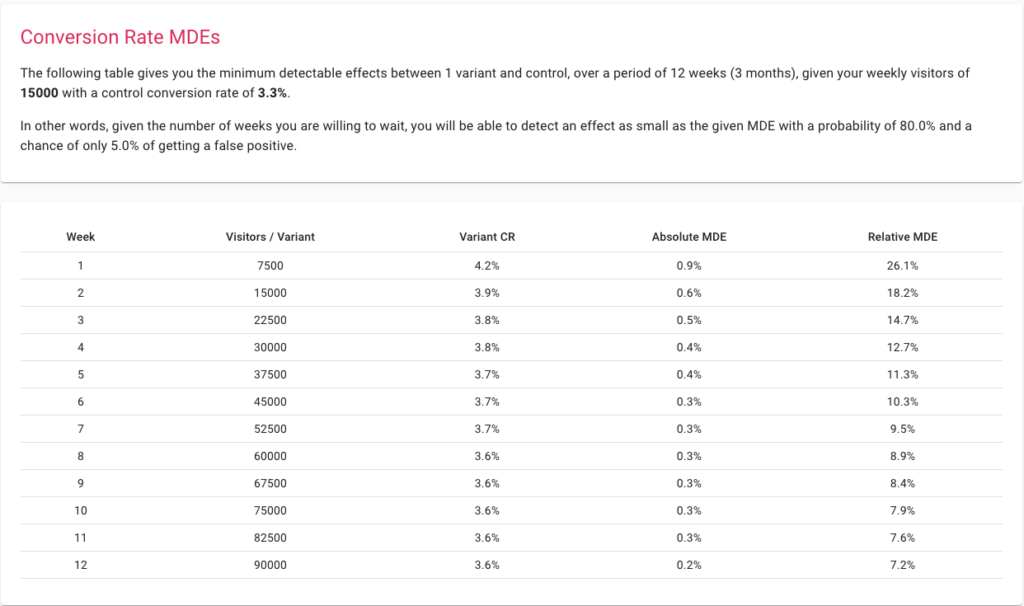

Minimal nachweisbare Effekte

MDE ist der minimal zu erreichende Lift, oberhalb dessen sich die Änderung lohnt. Wenn Sie sich auf einen Test vorbereiten, indem Sie ein niedriges MDE auswählen, kann Ihr Experiment detailliertere Änderungen erfassen. Die Einstellung eines höheren MDE bedeutet, dass Ihr Experiment nur größere Änderungen erkennen kann und daher auch mit kleineren Stichprobenumfängen funktioniert. Der Haken dabei ist, dass eine drastische Änderung zur Generierung einer ausreichend großen Steigerung in den meisten Fällen nicht möglich ist, es sei denn, Ihre Website wurde noch nie zuvor optimiert.

Der beste Weg, über MDE nachzudenken, ist die Verwendung unseres Stichprobengrößenrechners. Beginnen Sie mit der Eingabe Ihres wöchentlichen Traffics und Ihrer Conversions und sehen Sie, was über einen bestimmten Zeitraum erreichbar ist.

P-Wert

Cassie Kozyrkov, Googles Chief Decision Scientist, prägte eine sehr einfache Definition zur Erklärung des P-Werts: „Je niedriger der P-Wert, desto lächerlicher sieht die Nullhypothese aus!“

Was ist der P-Wert bei A/B-Tests?

Der p-Wert ist definiert als die Wahrscheinlichkeit, ein Ergebnis als extrem oder extremer als das beobachtete zu beobachten, unter der Annahme, dass die Nullhypothese wahr ist. Daher ist der p-Wert ein mathematisches Hilfsmittel, um die Gültigkeit der Nullhypothese zu überprüfen. Je kleiner der p-Wert, desto sicherer sind wir, dass wir die Nullhypothese ablehnen sollten.

Wir verwenden es, indem wir es mit dem Signifikanzniveau vergleichen. Angenommen, wir haben ein Signifikanzniveau von 5 %, das direkt einem Konfidenzniveau von 95 % entspricht, dann können wir sagen, dass unser Test statistische Signifikanz erreicht hat, sobald der p-Wert kleiner als 5/100 = 0,05 wird kann die Nullhypothese ablehnen.

Wenn wir noch sicherer sein wollen, setzen wir unser Signifikanzniveau auf 1 % und warten dann, bis der p-Wert unter 0,01 fällt. Das würde einem Vertrauen von 99 % in unsere Ergebnisse entsprechen.

Verkehrsverteilung

Die Traffic-Verteilung hilft dabei, dem Test einen bestimmten Prozentsatz des Traffics zuzuweisen. Angenommen, Sie haben jeden Monat 100 Besucher auf Ihrer Website. Davon können Sie dem Test 30 % des Traffics zuweisen. Standardmäßig erhält jede Variante in Ihrem A/B-Test einen gleichen Anteil des Traffics. Wenn Sie also zwei Varianten haben, erhält jede 15 % des Traffics.

Mithilfe von Convert Experiences können Sie diese Traffic-Zuweisung mit wenigen Klicks konfigurieren. Wenn sich Ihr Experimentierprozess weiterentwickelt, können Sie weitere Varianten erstellen und die Zuweisung an Ihre Anforderungen anpassen.

Wie können Statistiken beim A/B-Testen helfen?

Warum können Sie nicht einfach die Leistung von Variante A und B vergleichen?

Das Ausführen eines A/B-Testexperiments selbst unter Verwendung einer praktischen Plattform wie Convert Experiences erfordert einige Ressourcen in Bezug auf Zeit und Energie. Wäre es dann nicht sinnvoll, einfach zwei Varianten zu erstellen, ihre jeweiligen Conversion-Raten zu messen und die mit der besseren Leistung auszuwählen?

Das klingt zwar pragmatisch und einfallsreich, kann aber zu falschen Schlussfolgerungen und sogar zu falsch interpretierten Ergebnissen führen, da die Daten nicht statistisch getestet wurden. Es reicht also nicht aus, eine Veränderung zu beobachten, man muss wissen, wie lange man warten muss, um sich dieser Veränderung sicher zu sein, und dafür muss man einen statistischen Test wie einen Z-Test, T-Test oder G-Test durchführen.

Allein auf den Lift oder die Effektgröße zu schauen, wird Ihnen nicht weiterhelfen:

a. Bestimmen Sie die wahrscheinlichen kausalen Faktoren, die mit dem Gewinn einer Variante verbunden sind

Ein A/B-Test würde Sie konstruktionsbedingt dazu zwingen, zwei Varianten zu wählen, die nur einige materielle Unterschiede aufweisen. Bei einem größeren Satz von Unterschieden würden Sie sich im Allgemeinen für einen umfangreicheren multivariaten Test entscheiden.

A/B-Testing funktioniert nach der Regel, dass man von Anfang an die abhängigen und unabhängigen Variablen im Experiment kennt. Wenn Sie beispielsweise zwei Sätze mit unterschiedlichen CTAs im selben Layout erstellen, wissen Sie, dass der Unterschied in den CTAs der ursächliche Faktor ist, wenn Sie die Hypothese widerlegen und eine Änderung der Conversions feststellen können.

Wenn Sie einfach zwei völlig unterschiedliche Varianten ausführen, selbst wenn Sie mit einer relativ besser ankommen, würde es Ihnen nicht helfen, Einblicke in Ihr Publikum zu gewinnen oder festzustellen, warum es funktioniert.

b. Unterscheide zwischen Zufälligkeit und Kausalität

Die Struktur eines A/B-Tests würde eine Nullhypothese und eine Alternativhypothese erfordern. Die Nullhypothese würde sich im Allgemeinen mit der Zufälligkeit als ursächlichem Faktor und nicht mit der Wirksamkeit einer Ihrer Varianten bei der Bestimmung der Konversionsraten befassen. Eine Nullhypothese wird nicht widerlegt, wenn die statistische Signifikanz nicht rechtzeitig erreicht wird und jede nachfolgende Variabilität als Ergebnis von Zufälligkeit angenommen wird. Wenn Sie dagegen die Nullhypothese ablehnen können, bedeutet dies, dass Sie mit hoher Wahrscheinlichkeit (auf dem eingestellten Konfidenzniveau, z. B. 95 % oder 99 %) einen kausalen Faktor entdeckt haben, der sich positiv oder negativ auf die auswirkt Konvertierungen.

c. Ordnen Sie Kosten nur den Änderungen zu, bei denen eine höhere Wahrscheinlichkeit für verbesserte Conversions besteht

Die durchgeführten A/B-Tests würden auch statistische Maße wie Signifikanzniveaus, Konfidenzintervalle und Fehlermargen enthalten. Solche analytischen Konzepte sind in den meisten Ad-hoc-Analysen nicht vorhanden.

Nehmen Sie zum Beispiel einen Vergleich zwischen zwei Formularübermittlungsseiten mit einigen wesentlichen Unterschieden in Informationslayout und -anzeige. Der eine schneidet relativ besser ab als der andere. Wie stellen Sie nun fest, dass Sie die Ergebnisse replizieren können? Da Sie keine Daten haben, die zeigen, wie signifikant die Ergebnisse des Experiments waren, gibt es keine Möglichkeit zu beurteilen, ob die Ergebnisse des Experiments repliziert werden können oder nicht.

Bewertung und Eliminierung Ihrer Anfälligkeit für Typ-I- und Typ-II-Fehler für A/B-Tests

Fehler vom Typ I (eine wahre Nullhypothese wird abgelehnt oder falsch positiv) und Fehler vom Typ II (eine falsche Nullhypothese wird nicht abgelehnt oder falsch negativ) können schwerwiegende Folgen für die Marktwerte haben, die Sie mit A/B-Tests optimieren.

Kein Tool kann Ihnen Fehler vom Typ I oder Typ II explizit anzeigen, aber es kann Ihnen helfen, sie zu minimieren, indem es beispielsweise sicherstellt, dass ein Konfidenzniveau von 95 % oder mehr erreicht wird und die statistische Aussagekraft mindestens 80 % erreicht hat.

Angenommen, Sie erstellen zwei Varianten der letzten Seite in Ihrem Kaufzyklus, zeigen sie über 10 Tage etwa 10.000 Besuchern und erhalten die Ergebnisse. Sie sehen eine bessere Leistung für eine Variante und wenden sie daher auf Ihrer E-Commerce-Website an.

Das Problem hierbei ist, dass Sie in Ihrem A/B-Testexperiment von einem Typ-I- oder Typ-II-Fehler erfahren, nachdem Sie die Ergebnisse Ihres Experiments nicht in der Realität reproduzieren können. Es gibt bessere Möglichkeiten, um sicherzustellen, dass Sie in Ihrem A/B-Test keine Fehler vom Typ I und Typ II haben.

Stellen Sie zunächst sicher, dass Ihre Stichprobengröße groß genug ist, um solide statistische Experimente zu gewährleisten. Sie können den Rechner von Convert verwenden, um die richtige Stichprobengröße zu ermitteln.

Stellen Sie dann sicher, dass Sie ein Signifikanzniveau von mindestens 95 % haben, und beenden Sie den Test nicht, bis Ihre Trennschärfe 80 % erreicht hat. Mit dem richtigen MDE und der vom Rechner angegebenen Länge des Experiments können Sie praktisch sicher sein, Fehler vom Typ I oder Typ II zu kontrollieren. Ersteres ist direkt durch das von Ihnen eingestellte Signifikanzniveau beeinflussbar, letzteres durch die statistische Aussagekraft, mit der Sie leben möchten. Idealerweise sollte Ihr Konfidenzniveau größer oder gleich 95 % sein und Ihre statistische Aussagekraft sollte sich auf mindestens 80 % angesammelt haben. In beiden Fällen gilt: je mehr desto besser. Wenn beide Parameter 99 % erreichen, ist das Risiko von Fehlern des Typs I oder II gut kontrolliert und unter 1 %.

Sowohl die Entdeckung als auch die Beseitigung solcher Probleme sind nur aufgrund des statistischen Denkens möglich, auf dem A/B-Tests basieren.

Bestimmen, ob Ihr A/B-Testexperiment skalierbar ist oder nicht

Selbst wenn Sie im obigen Beispiel sehen, dass eine Variante ihre Alternative über einen Monat hinweg gewinnt, können Sie Ihr Experiment nicht einfach skalieren. Dies liegt daran, dass die Stichprobengröße mit 10.000 Besuchern recht klein war.

A/B-Teststatistiken geben Ihnen viele heuristische Leitfäden, um sicherzustellen, dass Ihr Test und seine Ergebnisse skalierbar sind. Die Ergebnisse jedes A/B-Testexperiments werden den Weg für weitere Tests in der Zukunft ebnen.

Stellen Sie zunächst sicher, dass Sie jeden Monat genügend Traffic erhalten, um jede Variante der UI- oder UX-Elemente Ihrer Plattform zu testen. Die Experten von Convert empfehlen einen Traffic von mindestens 10.000 Besuchern und 1.000 Conversions für jede Variante, um statistisch fundierte Ergebnisse zu erzielen. Sobald Sie diese haben, stellen Sie sicher, dass Sie nicht mehrere Elemente gleichzeitig testen, den Test über eine beträchtliche Dauer laufen lassen und ein angemessenes Signifikanzniveau erreichen können.

Wenn Sie eine kleine Gruppe von Besuchern haben, können Sie trotzdem A/B-Tests für E-Mail-Kampagnen, Social-Media-Kampagnen und sogar Google-Anzeigengruppen durchführen. Oder Sie entscheiden sich für einen hohen MDE, um umfassende Einblicke in Ihr Publikum zu erhalten.

Experimente kostengünstig gestalten

Die Zuordnung eines beliebigen Prozentsatzes Ihres Datenverkehrs für einen A/B-Test ist mit Kosten verbunden. Sie zeigen Ihrem Publikum möglicherweise eine suboptimale Seite oder ein UX-Element und verlieren daher möglicherweise potenzielle Einnahmen. Während der A/B-Test Ihnen eine definitive Idee gibt, ein optimierteres Element oder eine Seite zu skalieren, die diese verlorenen wahrscheinlichen Einnahmen wieder hereinholen kann, können diese Kosten als Einschränkung für die Optimierung Ihres Testprozesses verwendet werden.

Nachdem Sie einen A/B-Test durchgeführt haben, können Sie mit einem A/B/n-Test fortfahren, bei dem Sie mehrere weitere Varianten testen müssen.

Viele kostenlose Online-Rechner zeigen Ihnen die Stichprobengröße, die Sie für genaue Ergebnisse dieses Tests benötigen. Diese Rechner gehen von einer vereinfachten Annahme aus – berechnen Sie die Stichprobengröße für einen A/B-Test und multiplizieren Sie sie dann mit der Anzahl der Varianten mit dem Experiment. Dies ist eine ineffiziente Vorgehensweise. Unser Rechner bietet effiziente Mehrfachvergleichs-Korrekturoptionen wie Šidak. Verwenden Sie also bei jedem Schritt Ihres Experimentierens immer die richtigen Tools, um sicherzustellen, dass Sie die erforderlichen Ergebnisse erhalten, ohne die zusätzlichen Kosten zu verlieren, die durch Fehlkalkulationen entstehen.

Beginnen Sie mit der Planung Ihrer Tests mit dem A/B-Testrechner von Convert

Schätzung und Kontrolle der Zufälligkeit in Ihrer Stichprobe

Während es mehrere komplexe mathematische Prinzipien der Zufälligkeit gibt, weisen die meisten von ihnen auf dieselbe Eigenschaft hin – Unvorhersehbarkeit.

Zufälligkeit kann als Gegenteil von klar definierter Kausalität wahrgenommen werden. Anstatt zu wissen, welche Elemente für die höhere Conversion verantwortlich waren, müssen Sie sich auf einige undefinierte externe Faktoren als wahrscheinliche kausale Faktoren für die Ergebnisse verlassen. Da Sie diese externen Faktoren nicht kontrollieren können, können Sie Ihre Testergebnisse nicht im großen Maßstab replizieren.

Wenn Sie keinen statistisch fundierten A/B-Testprozess verwenden, würden Sie sich nicht die Mühe machen, die Auswirkungen der Zufälligkeit zu untersuchen. Aber die Zufälligkeit wird immer noch bestehen. Möglicherweise setzen Sie am Ende Kapital für ein Marketing-Asset ein, das während des Tests konvertiert, aber nicht in großem Maßstab funktioniert. Schlimmer noch, Sie könnten am Ende die Wirkung Ihres bestehenden Conversion-Trichters verwässern.

A/B-Teststatistiken können Ihnen bei der Lösung dieses Problems helfen. Wenn Sie eine Hypothese formulieren, erstellen Sie ein Szenario, in dem Zufälligkeit der Grund für die veränderten Ergebnisse sein könnte. Wenn Sie dieses Szenario widerlegen können, haben Sie im Wesentlichen die Zufälligkeit als Ursache für bessere Conversions widerlegt. Mit weiteren Tests, die sich auf andere Bereiche im Conversion-Funnel konzentrieren, können Sie den Raum für Zufälligkeiten im Conversion-Optimierungsprozess weiter eliminieren.

Das Ideal wäre, ein Gesamtbewertungskriterium (OEC) mit einer Hauptmetrik und anderen Leitplankenmetriken zu definieren und Experimente durchzuführen, um erstere zu optimieren, während sichergestellt wird, dass letztere sich nicht verschlechtern. Sie möchten beispielsweise die Konversionsraten (primäre Metrik) erhöhen, aber nicht, dass die Benutzerbindung abnimmt, da dies auf unzufriedene Kunden hindeuten würde.

Ein großartiges Buch, wahrscheinlich das bisher wichtigste Buch zum Thema Experimentieren, ist Trustworthy Online Controlled Experiments: A Practical Guide to A/B Testing, von Ron Kohavi, Diane Tang, Ya Xu.

Stellen Sie sicher, dass Sie keinen umfassenderen multivariaten Test benötigen

Umfassende Tools wie Convert Experiences können Ihnen dabei helfen, mehrere A/B-Tests durchzuführen. Auch wenn dies wie eine triviale Funktion klingen mag, kann es Ihnen helfen zu verstehen, ob Sie einen umfassenderen multivariaten Test benötigen oder ob die Ergebnisse Ihres A/B-Tests zufriedenstellend genug sind.

All dies hängt davon ab, was Sie tun, nachdem Sie die Ergebnisse des Tests verstanden haben. Beginnen Sie mit der Bereitstellung der Gewinnerseite oder des Elements oder führen Sie weitere Tests durch? Wenn Ihre Stichprobengröße, Ihr Signifikanzniveau und Ihr MDE zufriedenstellend sind, können Sie normalerweise die erfolgreiche Alternative einsetzen. Wer auf der anderen Seite steht, kann mit weiteren Tests die Ursache für die unterschiedlichen Conversion-Raten finden.

Angenommen, Sie testen zum Beispiel, ob ein bestimmter CTA auf Ihrer Zielseite zu besseren Conversions beiträgt oder nicht. Sie führen Ihren A/B-Test durch und haben einen klaren Gewinner. Einige statistische Maße wie das Signifikanzniveau sind jedoch nicht erfüllt. Sie nehmen also die Gewinnervariante und erstellen eine weitere Variante, um einen weiteren A/B-Test durchzuführen.

Wenn die Ergebnisse repliziert werden, können Sie der Gewinnervariante mehr vertrauen. Wenn Sie die Konversionsraten des ersten Tests nicht replizieren können, benötigen Sie möglicherweise einen multivariaten Test, um das Element zu finden, das für die Steigerung der Konversionen verantwortlich ist.

A/B-Tests können Ihnen helfen, die Abhängigkeit von selbst gemeldeten Daten zu vermeiden

Bereits kleinste Variablen können einen großen Einfluss auf das erkannte Nutzerverhalten haben. So hat beispielsweise der Flimmereffekt einen erheblichen Einfluss auf die Conversion-Rate. Flimmern ist die Situation, in der Ihre Standardzielseite vor Ihrer Variantenseite angezeigt wird, wenn ein Besucher Teil Ihres Beispielverkehrs ist, der für A/B-Tests verwendet wird. Dies kann zu verfälschten Ergebnissen führen – selbst wenn Sie einen analytisch konsistenten Prozess durchführen.

Wenn es mögliche Probleme mit statistischen und analytischen Prozessen wie A/B-Tests geben kann, kann die Ausführung eines selbstberichteten Prozesses nur zu suboptimaleren oder sogar falschen Ergebnissen führen. Selbstauskunftsprozesse werden oft durch verschiedene Vorurteile und verrauschte Daten verunreinigt, da die gesamte Verantwortung, sich an Präferenzen zu erinnern und diese zu melden, beim Benutzer liegt, der keinen Anreiz hat, ehrlich zu sein. Außerdem gibt es Reihenfolgeverzerrungen und andere externe Faktoren, die zu fehlerhaften Daten führen können.

A/B-Tests setzen Sie auf den Beobachtungsstuhl und machen jegliche Form von Benutzerberichten überflüssig. Mit Tools wie Convert müssen Sie sich nicht einmal um Flackern kümmern.

Organisationsbasierte Entscheidungsfindung datengesteuert machen

Ein A/B-Testing-Experiment lässt dabei keinen Raum für Vermutungen. Bei jedem Schritt sammelt Ihre Testplattform Beobachtungen, zeichnet Daten auf und führt Analysen durch. Auf diese Weise erhalten Sie unabhängig von den Präferenzen Ihrer Vorgesetzten oder Investoren oder Agenturen datengesteuerte Ergebnisse.

Wenn mehrere Stakeholder an dem Prozess beteiligt sind, kann das Endergebnis leicht suboptimal sein. A/B-Testing ist ein analytischer Prozess, der den Raum für eine solche hierarchische Entscheidungsfindung oder voreingenommenes Denken eliminiert.

Beispielsweise empfiehlt Ihre Agentur möglicherweise eine Überholung der Benutzeroberfläche für Ihre Zielseite, da dies zu ihren monatlichen Kosten beiträgt und bei richtiger Durchführung möglicherweise nicht einmal Ihre Conversions beeinträchtigt. Wenn Ihre Nullhypothese jedoch stark bleibt, wissen Sie bei einem A/B-Test mit Sicherheit, dass solche Änderungen vorerst nicht erforderlich sind. Da Sie die Daten haben, um Ihre Argumentation zu untermauern, müssen Sie sich nicht der Pose hingeben, nicht einmal der Führung in Ihrem Unternehmen. Dies kann Ihnen auch dabei helfen, HiPPO (Highest Paid Person's Opinion) zu bekämpfen. Die Daten lügen nicht und ein A/B-Test ist der beste Beweis, den Sie zur Verfügung haben.

Experimentergebnisse mit transparenten Berechnungen verstehen

Das Verständnis der Ergebnisse Ihres A/B-Tests ist fast so wichtig wie die Durchführung eines statistisch strengen Tests. Jedes Tool kann den Test durchführen, die Alternativen vergleichen und Ihnen einen Gewinner zuwerfen. Was Sie brauchen, ist ein Hinweis auf einen kausalen Zusammenhang. Während die statistischen Maße dies hervorheben können, wurde Convert Experiences für Transparenz bei den Berechnungen entwickelt.

Die Plattform hat eine Betriebszeit von 99,99 %, ermöglicht über 90 Integrationen von Drittanbietern, ermöglicht die Zielverfolgung von Drittanbietern und unterstützt Code- und Fehlerprüfungen. Auf diese Weise haben Sie am Ende des Testprozesses eine klare Vorstellung davon, welches Element der Gewinner ist, warum es vorzuziehen ist und ob Sie weitere Tests benötigen, um sicherer zu sein, es zu skalieren.

Nutzung von A/B-Statistiken, um CRO-Reife zu erreichen

Was ist CRO-Reife und wie können statistisch fundierte A/B-Tests Ihnen dabei helfen, dorthin zu gelangen?

Während die Conversion-Rate-Optimierung wie eine isolierte Denkweise erscheinen mag, erfordert sie prozessbasierte Änderungen im gesamten Unternehmen, um sich stärker auf Conversions zu konzentrieren. Die Herausforderung besteht darin, dass CRO ein relativ neues Feld ist. In einer Umfrage aus dem Jahr 2018 arbeiteten fast 62 % der Marketer seit weniger als 4 Jahren im CRO.

Ein CRO-Spezialist von Shopify hat eine Hierarchie erstellt, wie Unternehmen dazu neigen, die CRO-Reife zu erreichen. Wenn Sie sich mit dieser Hierarchie befassen, werden Sie feststellen, wie wichtig solide statistische Experimente für die Weiterentwicklung Ihrer Organisationsprozesse sind:

1. Durchführung qualitativer und quantitativer Forschung zur Identifizierung suboptimaler Berührungspunkte

Ihr Google Analytics-Dashboard hilft Ihnen oft dabei, die Seiten oder Berührungspunkte in der Verbrauchererfahrung zu erkunden, die sofortige Aufmerksamkeit erfordern. Die Lösung eines bestimmten Problems wie hohe Absprungraten auf der Startseite, aufgegebene Warenkörbe, unvollständiges Ausfüllen von Formularen und das Überspringen von E-Mail-Abonnements kann als Ausgangspunkt für die Optimierung des Konversionstrichters verwendet werden.

2. Formulierung von Test- und Experimentierideen basierend auf der früher durchgeführten Forschung

A/B-Teststatistiken können Ihnen helfen, die Benchmark-Leistung Ihrer Website und sogar der Konkurrenz zu verstehen. Sie können dies verwenden, um zu verstehen, welche Elemente hinterherhinken, und A/B-Testvarianten starten, die eine bessere Leistung erzielen können.

3. Laufendes Testen und Experimentieren von Ideen mit höchsten Prioritäten

Wenn Sie Ihre A/B-Testideen in Convert Experiences einrichten, legen Sie Metriken wie MDE fest. Solche Metriken helfen Ihnen, Tests zu priorisieren, die die maximale Auswirkung auf Ihr Unternehmen haben, in Bezug auf die Ressourcenzuweisung, die für die Durchführung des Experiments erforderlich ist.

4. Analysieren und Aufzeichnen von Testergebnissen

Nachdem Sie den Test durchgeführt haben, ist es wichtig zu verstehen, warum Sie die Ergebnisse erhalten haben, die Sie sehen. Hier können Plattformen wie Convert Experiences Ihnen helfen, zwischen Zufälligkeit und Kausalität mit hoher Wahrscheinlichkeit zu filtern. Mit seinen transparenten Berechnungen hilft Ihnen Convert Experiences zu verstehen, warum Ihre Gewinnervariante besser abschneidet.

5. Erstellen von Follow-up-Tests

Nachdem Sie die A/B-Tests durchgeführt und die Ergebnisse erhalten haben, können Sie zu umfassenderen multivariaten Tests übergehen oder einen A/B-Test mit einer anderen Variante durchführen. Convert macht es einfach, eine Vielzahl von statistischen Tests durchzuführen, die Ihnen helfen können, Ihr Vertrauen in die Unterstützung der Gewinnervariante zu stärken.

Das CRO-Reifemodell konzentriert sich auf einen ganzheitlichen Prozess über Strategie und Kultur, Tools und Technologie, Mitarbeiter und Fähigkeiten sowie Prozess und Methodik eines Unternehmens, bei dem der Fortschritt des Unternehmens über verschiedene Reifegrade hinweg verfolgt wird, wie z. und transformativ.

Convert Experiences bringt eine rigorose Datenanalyse in Ihren A/B-Testprozess, erfordert keine Programmierung für die Durchführung der Tests, liefert visuell und analytisch zugängliche Ergebnisse und ist transparent in Bezug auf Testergebnisse. Mit der Plattform im Mittelpunkt Ihrer A/B-Testpläne kann Ihr CRO-Reifegrad Ihres Unternehmens leichter auf die transformativen Stufen zusteuern.

A/B-Tests in Aktion: Benchmarking-Fallstudien

1. Verwendung von Google Analytics und Konvertierung von Erfahrungen zur Hypothesengenerierung

Google Analytics kann ein guter Ausgangspunkt sein, um die potenziellen Verbesserungsbereiche Ihrer Website zu verstehen. Ein plötzlicher Rückgang des Datenverkehrs, hohe Absprungraten im Vergleich zu Seitenzeiten usw. können starke Indikatoren für potenzielle Probleme sein.

Stellen Sie alle Herausforderungen dar, die Sie in Ihren Google Analytics-Berichten sehen. Führen Sie parallel dazu eine qualitative Umfrage auf Ihrer Website, in den sozialen Medien und in E-Mail-Kampagnen durch, in der Sie Ihr Publikum fragen, wonach es sucht. Darüber hinaus können Sie Hotjar verwenden, um zu verstehen, wie Besucher durch die Elemente auf jeder Seite navigieren.

Basierend auf all diesen Daten können Sie dann aufschlussreiche Varianten erstellen und A/B-Tests durchführen. Wenn Sie Convert Experiences bereits verwenden, können Sie auch das Hypothesengenerierungstool Convert Compass verwenden, um den Prozess weiter zu beschleunigen.

2. Steigerung der Conversions aus verlassenen Warenkörben durch A/B-Tests

Abgebrochene Warenkörbe sind teuer für Ihre Website und ziemlich unbequem für Ihre Besucher, da Sie beide viel Zeit und Ressourcen investiert haben, um zu diesem Punkt zu gelangen, aber die Konvertierung nicht funktioniert hat.

Durch die Integration von Convert Experiences mit anderen Plattformen können Sie einen strukturierten Ansatz zur Bewältigung dieser Herausforderung formulieren.

- Beginnen Sie zunächst mit der Integration von Convert Experiences in Ihre Shopify-, WooCommerce-, PrestaShop-, BigCommerce- oder eine andere E-Commerce-Plattform, die Sie verwenden.

- Verwenden Sie dann Google Analytics, um Ziele auf Ihren Plattformen festzulegen, und verwenden Sie Tools wie Hotjar oder Crazy Egg, um das mögliche Problem zu bewerten.

- Mit Convert Experiences können Sie diese Daten nutzen, Hypothesen formulieren und A/B-Tests auf organisierte Weise durchführen. Kunden haben mit einem ähnlichen Ansatz eine Umsatzsteigerung von über 26 % beobachtet.

Convert Experiences lässt sich in weit über 100 Tools integrieren. Sehen Sie sich unsere Datenbank an, um herauszufinden, ob wir die Tools in Ihren aktuellen Tech-Stack integrieren. Wenn nicht, schreiben Sie uns eine Nachricht und wir bauen es!

3. Zielseitenoptimierung

Landing Pages sind für den gesamten Conversion-Prozess von zentraler Bedeutung. Um den maximalen Nutzen aus Ihren Zielseiten zu ziehen, können Sie eine Vielzahl von Tools wie Google Analytics, Adobe Analytics, Kissmetrics, Baidu Analytics oder andere führende Tools für den Anwendungsfall verwenden. Convert Experiences lässt sich nahtlos in diese Plattformen integrieren, um Ihnen beim Filtern von Zielseiten mit geringer Conversion zu helfen.

Als nächstes können Sie die Hotjar- und Convert-Integration verwenden, um zu verstehen, welche Elemente Ihrer Seite nicht funktionieren. Mit fortschrittlichen Tools wie Heatmaps können Sie sich ein visuelles Bild davon machen, wie die Besucher auf die verschiedenen Elemente auf Ihrer Seite zugreifen. Darüber hinaus können Sie mit Convert Compass Hypothesen generieren und dann Tests auf der Plattform durchführen.

Nachdem Sie Ihren Test durchgeführt haben, können Sie die Integration zwischen Convert und führenden Landingpage-Plattformen wie LanderApp, Instapage oder Hubspot CMS nutzen. Diese Integrationen helfen Ihnen, einfache A/B-Testexperimente auf Ihren Zielseiten durchzuführen.

Unter Verwendung des gleichen Arbeitsablaufs haben CRO-Experten Conversion-Steigerungen von 27 % festgestellt, wobei die Raten für das Hinzufügen zum Warenkorb um 13 % gestiegen sind.

Erzielen Sie einen höheren ROI mit „hygienischen“ A/B-Tests

- Website-Traffic-Schwellenwert : Convert empfiehlt, dass Sie für jede getestete Variante einen Traffic von mindestens 10.000 Besuchern und Conversions von über 1.000 haben.

- Verwenden des richtigen Tools für A/B-Tests : Wenn Sie nicht über die richtige Testplattform verfügen, kann dies zu verschmutzten Ergebnissen führen, dazu führen, dass Sie suboptimale Tests durchführen oder Ihre Ressourcen stark einschränken. Convert Experiences wurde entwickelt, um diese Schlüsselparameter zu eliminieren und gleichzeitig sicherzustellen, dass der Testprozess zugänglich, transparent und nahtlos ist.

Sie können jetzt bis zu 15 Tage lang kostenlos Tests in Convert Experiences durchführen. Sie werden eine klare Vorstellung davon bekommen, wie sich eine nahtlose, flimmerfreie und transparente Plattform anfühlt, die sich in Ihre anderen Conversion-Analysetools integrieren lässt.

- Definieren von Testzielen : Ihre Ziele als Unternehmen müssen aufeinander abgestimmt sein. Zum Beispiel – während Sie für maximale Anmeldungen optimieren, sollten einige andere Einheiten in Ihrem Team die Folgeprozesse nicht für maximale Verkäufe optimieren. Inkohärente UX kann mehr Schaden anrichten als eine suboptimale UX.

Halten Sie daher die Einheitlichkeit der Ziele unter allen Teammitgliedern aufrecht. Stellen Sie auf Testebene sicher, dass Sie Stichprobengröße, Dauer, statistische Signifikanz, Hypothese und MDE vor, während und nach der Durchführung Ihres A/B-Tests klar definieren.

- Ohne internen Traffic: Wenn Sie einen A/B-Test durchführen, würden viele Ihrer Teammitglieder die Seiten oder Punkte in der Customer Journey besuchen, um die Seite objektiv zu bewerten. Dies kann zu Rauschen in Ihren Testergebnissen führen.

Convert Experiences wurde entwickelt, um solchen Traffic zu filtern und sich nur auf die von Ihnen definierten Zielgruppensegmente zu konzentrieren, um Daten im A/B-Testprozess aufzuzeichnen, zu aggregieren und zu analysieren.

Abschließende Gedanken zu A/B-Teststatistiken

A/B-Tests sind eine rigorose analytische Übung, die nur mit statistischer Strenge durchgeführt werden kann. Ohne die in den Prozess eingebauten Statistiken sind A/B-Tests reine Vermutungen.

Convert Experiences ermöglicht Ihnen optimierte, zugängliche, zuverlässige und dennoch ressourceneffiziente A/B-Testexperimente. While the process of A/B testing can seem a little overwhelming at first, it certainly unlocks value in the form of the right insight and analytical proven ideas it gives you. Make sure you never run an A/B test in isolation – it has to be followed up with more tests, and even multivariate tests.

With consistent optimization and unlimited tests made available by Convert Experiences, you can expect your enterprise to become a more analytical and data-driven operation in no time.