Crawl Budget Tracking vor und nach einem Update

Veröffentlicht: 2019-12-10Psst… Es gibt ein Geheimnis, das ich dir verraten möchte.

Ihre Website verfügt über ein von Google festgelegtes „Crawling-Budget“.

Dies ist die geheime Metrik, die von Google verwendet wird, um zwei Dinge zu messen:

- Wie gut Ihre Website aufgebaut ist

- Wie beliebt Ihre Website ist

Dieser Artikel konzentriert sich auf den ersten Punkt.

Die Verbesserung der Erstellungsqualität Ihrer Website erhöht Ihr Crawl-Budget.

Je größer Ihr Crawl-Budget ist, desto häufiger kommt Google vorbei und liest Ihre Seiten.

Lassen Sie uns zunächst erklären, was ein Crawl-Budget ist.

Was ist Crawl-Budget

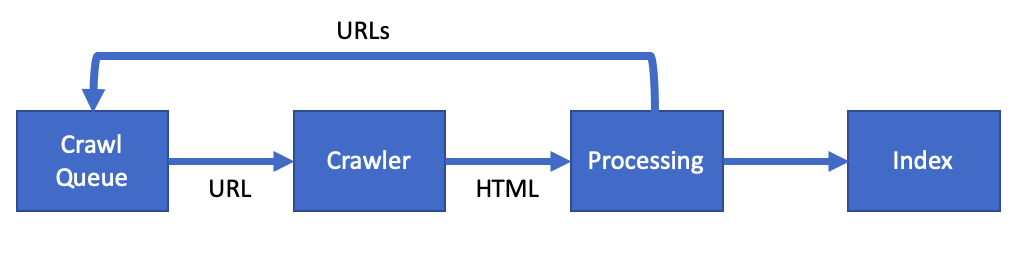

Google verwendet ein spezielles Softwareprogramm namens Webcrawler (oder Spider), um Seiten auf Ihrer Website zu lesen.

Sie nennen diesen Web-Crawler Googlebot.

Crawling-Budget ist der Begriff, der beschreibt, wie oft der Googlebot Ihre Seiten crawlt.

Durch die Optimierung Ihrer Website können Sie Ihr Crawl-Budget erhöhen.

Laut Google ist Ihr Crawl-Budget eine Kombination aus:

- Crawling-Rate – Die Geschwindigkeit, mit der der Googlebot Ihre Website crawlen kann, ohne Ihre Server zu beschädigen

- Crawl-Nachfrage – Wie wichtig Ihre Webseite für die Nutzer von Google ist

Wenn sich diese Metriken verbessern, werden Sie Googlebot öfter besuchen sehen. Lesen Sie mehr Seiten bei jedem Besuch.

Sobald Google eine Seite crawlt, fügt es den Inhalt dem Google-Index hinzu. Dadurch werden die in den Google-Suchergebnissen angezeigten Informationen aktualisiert.

Durch die Optimierung des Crawl-Budgets können Sie die Geschwindigkeit der Aktualisierungen von Ihrer Website in der Google-Suche verbessern.

Warum Sie Ihr Crawl-Budget verbessern sollten

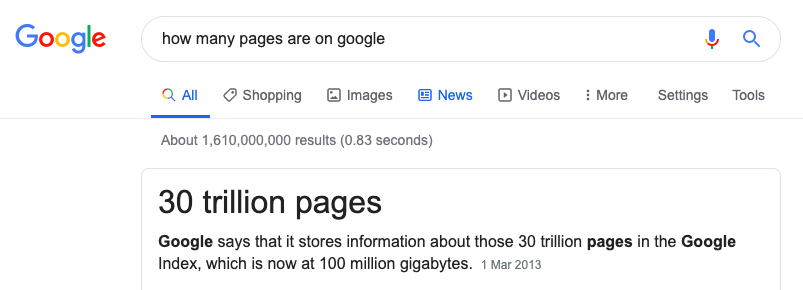

Google hat eine schwierige Aufgabe. Sie müssen jede Seite im Internet crawlen und indizieren.

Die Leistung, die sie dafür benötigen, ist enorm und sie können nicht jede Seite indizieren.

Die Optimierung Ihres Crawling-Budgets gibt Ihrer Website die besten Chancen, in der Suche zu erscheinen.

[Fallstudie] Verwaltung des Bot-Crawlings von Google

So verbessern Sie Ihr Crawl-Budget

Bei der Verbesserung einer Website geht es darum, die Zeit des Googlebots auf einer Website so effizient wie möglich zu gestalten.

Wir wollen nicht:

- Googlebot liest Seiten, die wir nicht in der Google-Suche haben möchten.

- Googlebot erkennt Serverfehler

- Googlebot verfolgt defekte/tote Links

- Googlebot wartet darauf, dass die Seite geladen wird

- Googlebot liest doppelte Inhalte

All dies verschwendet die wertvollen Ressourcen von Google und könnte dazu führen, dass Ihre Crawling-Rate sinkt.

Crawl-Budget und technisches SEO

Vieles, was Sie im Rahmen der technischen SEO tun müssen, ist dasselbe wie die Optimierung des Crawl-Budgets.

Wir brauchen:

- Optimieren Sie die robots.txt und suchen Sie nach Fehlern

- Korrigieren Sie alle hreflang- und kanonischen Link-Tags

- Nicht 200 Seiten auflösen

- Korrigieren Sie Umleitungen und Umleitungsschleifen

- Stellen Sie sicher, dass alle Sitemaps fehlerfrei sind

Sehen wir uns als Nächstes an, wie Sie die perfekte Seite für den Googlebot erstellen.

So erstellen Sie die perfekte Seite

OK, vielleicht nicht die perfekte Seite, aber wir sollten versuchen, die Seite so weit wie möglich zu verbessern.

Sehen wir uns einige häufige Probleme auf der Seite an, die Sie verbessern können.

Seitenprobleme

- Duplicate Content – Markieren Sie doppelte Inhalte auf Ihrer Website mit einem kanonischen Link-Tag.

- Nicht-SSL-Seiten – Finden Sie alle HTTP-Links und konvertieren Sie sie in HTTPS. Wenn Sie kein SSL-Zertifikat haben, erhalten Sie ein kostenloses von Let's Encrypt.

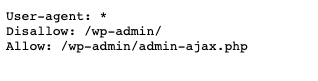

- Nur nützliche Seiten crawlen – Verwenden Sie Ihre robots.txt-Datei, um den Googlebot einzuschränken. Wenn Sie beispielsweise Seiten haben, die für einen Administrator verwendet werden, lehnen Sie dies in Ihrer robots.txt-Datei ab.

- Dünner Inhalt – Erwägen Sie, das Scraping von Seiten mit dünnem oder sehr niedrigem Inhalt zu blockieren. Wenn Sie Seiten haben, die für einen Nutzer wenig Wert haben, dann verschwenden Sie nicht die Zeit des Googlebots mit diesen Seiten.

- Serverfehler – Serverfehler sind ein Zeichen für einen fehlerhaften Webserver. Wenn Ihre Website 5xx-Fehler zurückgibt, kann die Behebung dieser Fehler die Crawling-Rate erhöhen.

Seiten werden langsam geladen

Eine Möglichkeit, das Crawling-Budget zu verbessern, besteht darin, die Seite schnell zu machen.

Schnelle Seiten machen den Googlebot schneller und dies ist ein Zeichen für Google, dass der Webserver „gesund“ ist.

Google hat bereits gesagt, dass die Seitengeschwindigkeit die Crawling-Rate erhöht:

Eine Website schneller zu machen, verbessert die Benutzererfahrung und erhöht gleichzeitig die Crawling-Rate.

- Seitengewicht – Diese Metrik ist die Gesamtgröße Ihrer Seite. Dazu gehören alle Javascript-CSS und Bilder auf der Seite. Dies sollte insgesamt unter 1 MB liegen.

- Optimierte Bilder – Bilder sollten in KB so klein wie möglich sein, ohne an Qualität zu verlieren. Die Verwendung eines Tools wie Squoosh kann dabei helfen.

- Minimiertes CSS und JS – Minimieren Sie Ihre JS- und CSS-Dateien. Dabei werden alle unnötigen Zeichen aus der Datei entfernt. Verwenden Sie CSSNano und UglifyJS, um die Dateien zu verkleinern.

- Komprimierung und Caching – Stellen Sie sicher, dass die GZip- oder BR-Komprimierung auf dem Server vorhanden ist. Dies beschleunigt die Zeit, die zum Abrufen einer Datei benötigt wird. Fügen Sie Caching hinzu, damit die Datei nur einmal heruntergeladen wird.

Eine Liste der Verbesserungen der Seitengeschwindigkeit finden Sie in dieser ausführlichen Überprüfung der Website-Leistung. Es hat 30 Schritte, um die Leistung der Website zu verbessern.

Methoden zur Messung Ihrer Veränderungen

Als kluger SEO wissen Sie, dass Sie die Änderungen verfolgen müssen, bevor Sie mit der Optimierung beginnen.

Sie müssen einen Datenpunkt mit zwei Eigenschaften auswählen:

- Sie müssen in der Lage sein, den Datenpunkt über die Zeit zu verfolgen.

- Sie müssen in der Lage sein, diese Daten durch Ihre Handlungen zu beeinflussen.

Was ist also der Datenpunkt, den wir für das Crawl-Budget verfolgen sollten?

Wir haben bereits gesagt, dass Google bei der Entscheidung über ein Crawl-Budget zwei Faktoren berücksichtigt:

- Crawling-Rate – Die Geschwindigkeit, mit der der Googlebot Ihre Website crawlen kann, ohne Ihre Server zu beschädigen

- Crawl-Nachfrage – Wie wichtig Ihre Webseite für die Nutzer von Google ist

Da wir technische SEOs sind, ist es unsere Aufgabe, die Crawling-Rate zu verbessern.

Das ist also der Datenpunkt, den wir verfolgen sollten.

Tracking-Crawling-Rate

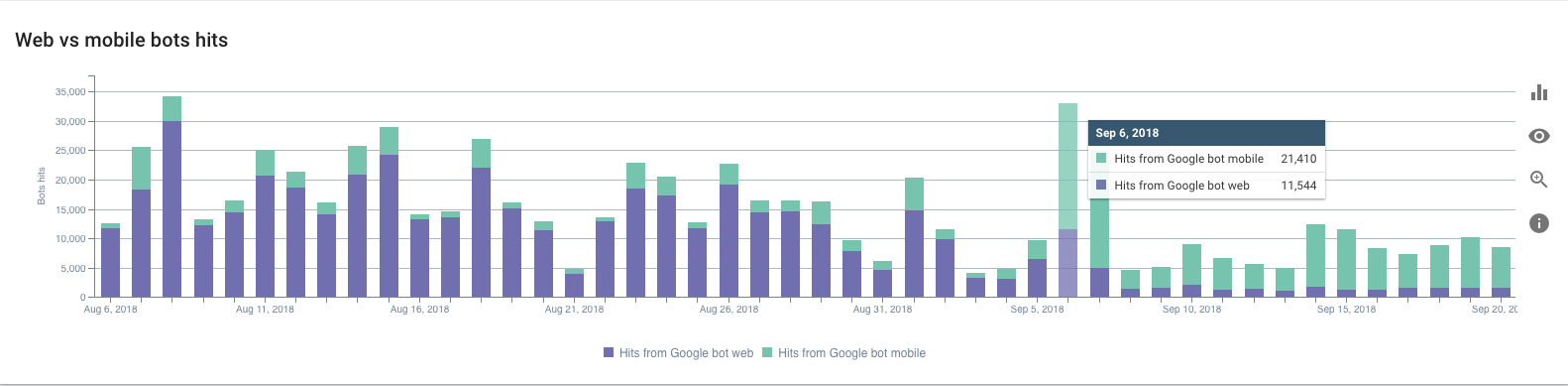

Wie verfolgen wir also die Googlebot-Crawling-Rate?

Wir müssen Ihre Webserver-Zugriffsprotokolle verwenden.

Die Protokolle speichern jede Anfrage an Ihren Webserver. Jedes Mal, wenn ein Nutzer oder Googlebot Ihre Website besucht, wird der Zugriffsprotokolldatei ein Protokolleintrag hinzugefügt.

So würde ein Eintrag für den Googlebot aussehen:

127.0.0.1 - - [11/Nov/2019:08:29:01 +0100] "GET /example HTTP/1.1" 200 2326 "-" "Mozilla/5.0 (kompatibel; Googlebot/2.1; +http://www .google.com/bot.html)"

In jedem Protokoll gibt es drei wichtige Datenpunkte. Das Datum:

[11/Nov/2019:08:29:01 +0100]

Die URL:

„GET /Beispiel HTTP/1.1“

Und der User-Agent, der uns mitteilt, dass der Googlebot die Anfrage stellt:

"Mozilla/5.0 (kompatibel; Googlebot/2.1; +http://www.google.com/bot.html)"

Das obige Protokoll stammt von einem Nginx-Webserver. Alle Webserver wie Apache oder IIS haben jedoch einen ähnlichen Zugriffsprotokolleintrag.

Abhängig von Ihrer Einrichtung verfügen Sie möglicherweise über ein Content Delivery Network (CDN). Ein CDN wie Cloudflare oder Fastly erstellt auch Zugriffsprotokolle.

Das manuelle Analysieren eines Zugriffsprotokolls macht nicht den größten Spaß, obwohl es möglich ist.

Sie könnten die access.log herunterladen und diese mit Excel analysieren. Ich würde jedoch empfehlen, dass Sie einen Protokollanalysator wie den von OnCrawl verwenden.

Dadurch können Sie die Googlebot-Crawling-Rate in einem Diagramm und in Echtzeit sehen. Sobald Sie dieses Monitoring-Setup zur Verfolgung der Crawling-Rate eingerichtet haben, können Sie damit beginnen, es zu verbessern.

Änderungen machen

Jetzt wissen wir, was wir verfolgen, und können einige Verbesserungen vornehmen. Nehmen Sie jedoch nicht viele Änderungen gleichzeitig vor. Gehen Sie methodisch vor und nehmen Sie Änderungen nacheinander vor.

Bauen, Messen, Lernen.

Mit dieser Technik können Sie die Änderungen, die Sie vornehmen, anpassen, während Sie lernen. Konzentration auf die Aufgaben, die die Crawling-Rate verbessern.

Wenn Sie sich beeilen und zu viel auf einmal ändern, kann es schwierig sein, die Ergebnisse zu verstehen.

Es ist schwer zu sagen, was funktioniert hat und was nicht.

Im Laufe der Zeit, wenn sich die Seite verbessert, werden Sie eine Erhöhung des Crawling-Budgets feststellen, wenn die Crawling-Rate steigt.

Zusammenfassung, Crawl-Budgetverfolgung vor und nach einem Update

Wir haben genau beschrieben, was ein Crawl-Budget ist.

Als technischer SEO haben Sie die Möglichkeit, die Crawling-Rate der Website zu erhöhen.

Durch die Verbesserung des technischen Zustands können Sie die Zeit des Googlebots auf Ihrer Website effizienter gestalten.

Verfolgen Sie die Crawling-Rate mithilfe Ihrer Protokolle, um genaue Ergebnisse zu erhalten.

Verwenden Sie „Build, Measure, Learn“ als Technik, um eine Änderung nach der anderen vorzunehmen und sich im Laufe der Zeit zu verbessern.

Im Laufe der Zeit wird Ihre Crawling-Rate steigen. Ihre Seiten werden schneller in den Google-Suchergebnissen angezeigt. Und die Benutzer werden eine großartige Erfahrung auf Ihrer Website haben.