8 häufige Fehler, die bei SEO-Audits aufgedeckt werden

Veröffentlicht: 2019-02-26Nachdem ich über 10 Jahre lang SEO-Audits auf Websites durchgeführt habe, habe ich viele Websites auditiert. In den letzten Jahren habe ich einen unglücklichen Trend bei einigen sehr häufigen Fehlern bemerkt, die Website-Eigentümer gemacht haben. Am Ende muss ich bei fast jedem SEO-Audit, das ich im letzten Jahr oder so durchgeführt habe, auf dieselben Fehler hinweisen. Die Fehler sind das, was ich allgemeine Website- und Webdesign-Fehler nennen würde – es handelt sich um Website-Probleme und nicht um Probleme der Suchmaschinenoptimierung. Unabhängig davon wirken sich diese Probleme auf den Traffic und die Sichtbarkeit einer Website in den Suchmaschinenergebnissen aus. Daher muss ich sie während der technischen SEO-Audits, die ich für Kunden durchführe, hervorheben.

Ich nenne diese Fehler allgemeine Fehler, weil 8 von 10 technischen SEO-Audits, die ich in den letzten zwei Jahren durchgeführt habe, mindestens 80 Prozent dieser Probleme aufweisen. Es macht mir nichts aus, dass Websites diese Probleme haben, bevor sie zu mir für ein Suchmaschinenoptimierungs-Audit kommen. Ich kann es der Jobsicherheit als SEO-Berater zuschreiben. Lassen Sie uns jedoch diese 8 häufigen Fehler überprüfen, auf die ich bei SEO-Audits stoße. Überprüfen Sie, ob Ihre Website einen dieser Fehler macht. Wenn dies der Fall ist, hilft die Verwendung von OnCrawl dabei, diese Probleme zu identifizieren und zu beheben. Ich habe jedes Problem unten detailliert beschrieben, erklärt, warum das Problem wichtig ist und wie die Verwendung von OnCrawl Ihnen helfen kann, das Problem zu beheben.

1. Schlechte HTTP-zu-HTTPs-Migration

2. Probleme mit doppelten Inhalten

3. Mega-Menüs und interne Links

4. Probleme mit der Site-Struktur

5. Verwaiste Inhalte und Seiten

6. Linkprobleme, schlechte und qualitativ minderwertige Links

7. Überoptimierung oder keine Optimierung

8. Falsche Verwendung von Kodex oder Richtlinien

Häufiger Fehler: Schlechte HTTP-zu-HTTPs-Migration

Ich sehe diesen Fehler nicht nur bei SEO-Audits, sondern einfach beim Surfen im Internet. Der Hauptindikator für ein Problem ist das defekte Schlosssymbol im Browser. Wenn Sie eine Website besuchen, die ein kaputtes Schlosssymbol hat, dann hat die Website dieses Problem. Wenn Websites von HTTP auf HTTPs umgestellt werden (von der unsicheren auf eine sichere Version (SSL), muss jede Erwähnung und jeder interne Link auf dem Domainnamen auf HTTPs geändert werden. Das heißt, wenn der Quellcode der Website auf ein Bild verweist ( alle Seiten haben Bilder), sollte es dieses Bild über HTTPs und nicht über HTTP laden. Wenn es wie folgt auf HTTP verweist:

< img src=”https://www.oncrawl.com/images/logo.png” alt=”OnCrawl-Logo” />

Die Seite, auf der dieser Code erscheint, würde ein kaputtes Schlosssymbol zeigen. Die URL für OnCrawl.com sollte HTTPs und nicht HTTP sein, wie oben gezeigt. Ein weiteres damit zusammenhängendes Problem wären interne Links und wie Seiten auf der Website miteinander verlinkt sind. Eine ordnungsgemäß von HTTP zu HTTPs migrierte Website wird immer mit einer HTTPs-URL im Link und nicht mit HTTP von einer Seite zur anderen verlinken. Wenn die Links auf der Website so aussehen:

< a href=" https://www.oncrawl.com/support/">Support kontaktieren

und auf die HTTP-URL verlinken, dann würde dies höchstwahrscheinlich zu einer permanenten 301-Umleitung führen, die Besucher auf https://www.oncrawl.com/support/ umleitet, die die HTTPs-Version dieser Seite ist. Wenn Sie die Website mit OnCrawl crawlen, meldet OnCrawl eine Menge Weiterleitungen. Das ist nicht gut. Eine ordnungsgemäße Website-Migration von HTTP zu HTTPs führt zu keinen Weiterleitungen auf der Website, wenn diese gecrawlt wird.

So beheben Sie diesen häufigen Fehler

Im Allgemeinen sollten alle internen Links Ihrer Website und Verweise auf Ihre vollständige Website-URL im Quellcode Ihrer Website auf die HTTPs-Version Ihrer Website und nicht auf HTTP verweisen. Wenn Sie WordPress verwenden, können Sie die gesamte Datenbank Ihrer Website nach der HTTP-URL Ihrer Website (einschließlich des Domänennamens) durchsuchen und diese durch die HTTPs-Version ersetzen. Sie können dies auch in anderen CMS tun, die über eine Datenbank verfügen. Für weitere Informationen habe ich dies kürzlich in einem früheren OnCrawl-Artikel mit dem Titel „Sicherstellen, dass Ihre Domain-Migration reibungslos verläuft“ (https://www.oncrawl.com/technical-seo/domain-migration/) behandelt.

Häufiger Fehler: Probleme mit doppelten Inhalten

Probleme mit doppelten Inhalten sind ziemlich häufig, und es ist tatsächlich sehr schwierig, Ihre Website zu 100 Prozent frei von doppelten Inhalten zu machen. Wenn Sie eine Hauptnavigation auf Ihrer Website haben, wird diese auf allen Seiten der Website angezeigt, daher ist es üblich, dass zumindest einige doppelte Inhalte vorhanden sind. Einer der häufigsten Fehler, auf die ich stoße, ist jedoch, wenn eine Website einen Textabschnitt (oder sogar mehr!) aufweist, der auf allen Seiten der Website erscheint. Beispielsweise könnten Sie in der Fußzeile der Website einen Textabschnitt „über Ihr Unternehmen“ haben. Das verursacht nicht wirklich ein großes Problem, es sei denn, es gibt Seiten Ihrer Website, die weniger Inhalt enthalten als der Textabsatz in der Fußzeile der Website. Wenn der Absatz in der Fußzeile 200 Wörter umfasst und der Rest der Seite weniger als 200 Wörter (was üblich ist), überwiegt der Fußzeilentext den anderen Inhalt der Seite. Das kann zu einem Problem werden, wenn Sie mehrere Seiten auf Ihrer Website haben.

Eine Website, die ich geprüft habe, hatte eine Seitenleiste mit aktuellen Erfahrungsberichten von Kunden. Es scrollte durch die Testimonials, sodass die Besucher jeweils nur ein Testimonial sahen. Das wäre im Allgemeinen kein Problem, aber der Quellcode der Seite hatte über 30 Testimonials, die „durchgeblättert“ wurden. Der gesamte Text aller 30 Testimonials, die auf jeder Seite der Website geladen werden. Das waren buchstäblich über 3500 Worte Inhalt in den Testimonials. Keine Seite der Website enthielt mehr als 3500 Wörter. Jede einzelne Seite der Website hatte also die gleichen 3500 Wörter Inhalt. Wir entfernten die Testimonials aus der Seitenleiste und die Rankings und der Traffic der Website stiegen sprunghaft an.

Technisch gesehen gibt es keine Strafe für doppelten Inhalt auf Ihrer Website, es sei denn, der doppelte Inhalt ist so schlimm, dass er eine Spam-Strafe von Google rechtfertigt. Das ist ziemlich selten, wenn Sie Seiten und/oder Websites kopieren, wissen Sie wahrscheinlich bereits von den doppelten Inhalten. Die meisten Websites duplizieren ihren Inhalt nicht absichtlich, sodass es zu Crawling-Problemen kommen kann. Eine Website kann ihr „Crawl-Budget“ leicht aufbrauchen, indem sie es für doppelte Inhalte verschwendet. Es ist wichtig, die Crawler der Suchmaschine dahin zu lenken, dass Seiten gecrawlt werden, die einzigartig sind und den besten Inhalt haben.

So beheben Sie diesen häufigen Fehler

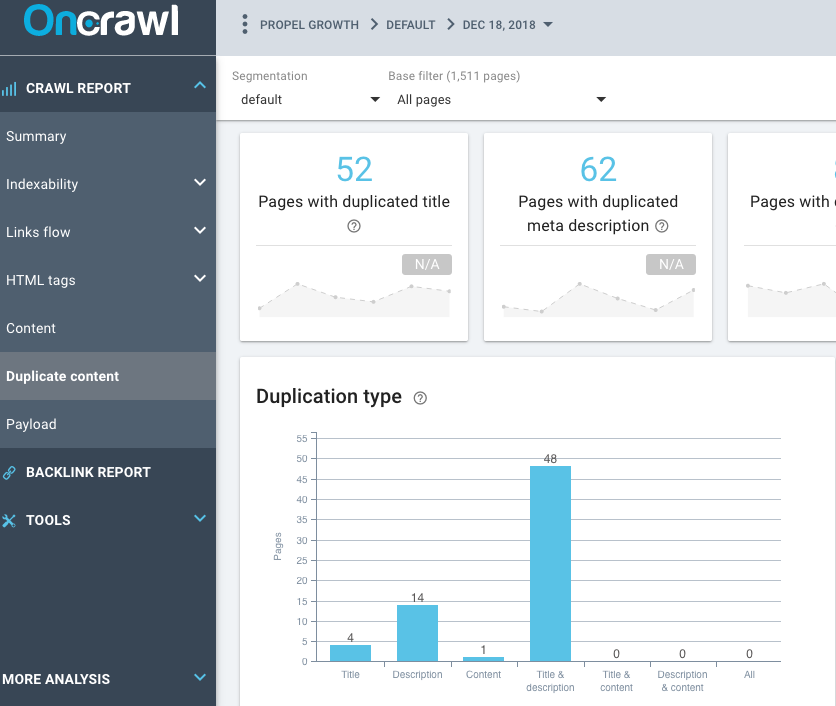

Verwenden Sie die Duplicate Content-Funktion von OnCrawl im Crawling-Bericht, um mehr über die Menge an Duplicate Content auf Ihrer Website zu erfahren. Wenn die Website beispielsweise doppelte Titel-Tags, doppelte Meta-Beschreibungs-Tags und doppelte Überschriften-Tags aufweist, sollten Sie untersuchen, ob es sich bei diesen Seiten um Duplikate handelt oder nicht. Einige WordPress-Sites generieren doppelte Seiten mit Tags, Kategorien und archivierten Seiten wie Seiten nach Datum.

Häufiger Fehler: Mega-Menüs

Wie viele Links hat die Website in ihrer Navigation? Ich habe buchstäblich Hunderte von Links (über 200-300 Links) in der Hauptnavigation einer Website gesehen. Es ist nicht nur überwältigend für Website-Besucher, zu versuchen, das zu finden, wonach sie suchen, es ist auch nicht sehr gut für SEO im Allgemeinen. Es ist ein Mega-Menü, wenn eine Website über 10 Dropdown-Hauptelemente verfügt und jedes dieser Dropdown-Hauptelemente mehr als 10 Elemente enthält und einige sogar Untermenüelemente haben. Das bedeutet letztendlich, dass Sie über 100 Seiten haben, die alle miteinander verlinkt sind. Das sind 100 Seiten, die direkt auf 100 Seiten verlinken.

Seiten wie diese können (und sollten) leicht neu bewertet werden, da die Seitenstruktur nicht sehr gut kategorisiert ist. Eine Website, auf der ich ein SEO-Audit durchgeführt habe, ist eine E-Commerce-Website mit über 300.000 Produktseiten. Die Website verkauft Büromöbel, aber auch Kirchenmöbel und Trainingsgeräte. Sie könnten buchstäblich auf einer Seite über Kirchenbänke sein und dann direkt zu einer Seite über Yogamatten navigieren. Ich kenne niemanden, der Kirchenbänke kauft und gleichzeitig Yogamatten kauft.

Dies ist ein extremes Beispiel, aber die Hauptnavigation hat Dropdown-Menüs, die es jemandem ermöglichen, direkt zu Seiten zu diesen Themen zu navigieren (auf die die Website verlinkt). Stellen Sie sich eine Website als mehrere verschiedene „thematische“ Bereiche oder Miniseiten innerhalb einer größeren Website vor. Es gibt eine Homepage, aber diese Homepage sollte nur zu den Hauptkategorien verlinken. Diese Kategorieseiten sollten dann auf Seiten innerhalb dieser Kategorie verlinken. Navigieren Sie dann zu einer Unterkategorie und dann nach unten zu einer Produktseite. Besucher sollten zu einer anderen Kategorie klicken müssen, bevor sie direkt zu einer Off-Topic-Seite gelangen können.

200 Seiten auf 200 Seiten in der Navigation zu verlinken kann nie gut sein. Wenn es sich um ein Mega-Menü handelt, muss es repariert werden, was bedeutet, dass es mit den allgemeinen Problemen der Site-Struktur zusammenhängt, die auch auf der Site auftreten.

So beheben Sie diesen häufigen Fehler

Es gibt mehrere Dinge, die Sie überprüfen müssen, um das Mega-Menü einer Website loszuwerden. Werfen Sie einen Blick auf die interne Site-Struktur, überprüfen Sie Themensilos (sofern auf der Site überhaupt vorhanden) und überprüfen Sie Ihre Content-Cluster. Like-Seiten sollten auf Like-Seiten (Seiten zum gleichen Thema) verlinken.

Häufiger Fehler: Probleme mit der Site-Struktur

Dies ist eigentlich dem Mega-Menü-Problem sehr ähnlich. Wenn eine Site ein Mega-Menü hat, dann ist es nicht so eingerichtet, dass die Struktur der Site ideal ist. Wie ich bereits erwähnt habe, sollte die Seitenstruktur so aufgebaut sein, dass ähnliche Themen gruppiert werden. Es ist ziemlich selten, dass eine Site eine Seite hat, die unter einem Unterthema und dann unter einer Kategorie verlinkt ist und trotzdem Hunderte von internen Links hat, die darauf verweisen. Gibt es verwaiste Seiten auf der Website? Hat der OnCrawl-Bericht nach einem Website-Crawling verwaiste Seiten identifiziert, deren Traffic und Rang nicht Teil der Websitestruktur sind?

So beheben Sie diesen häufigen Fehler

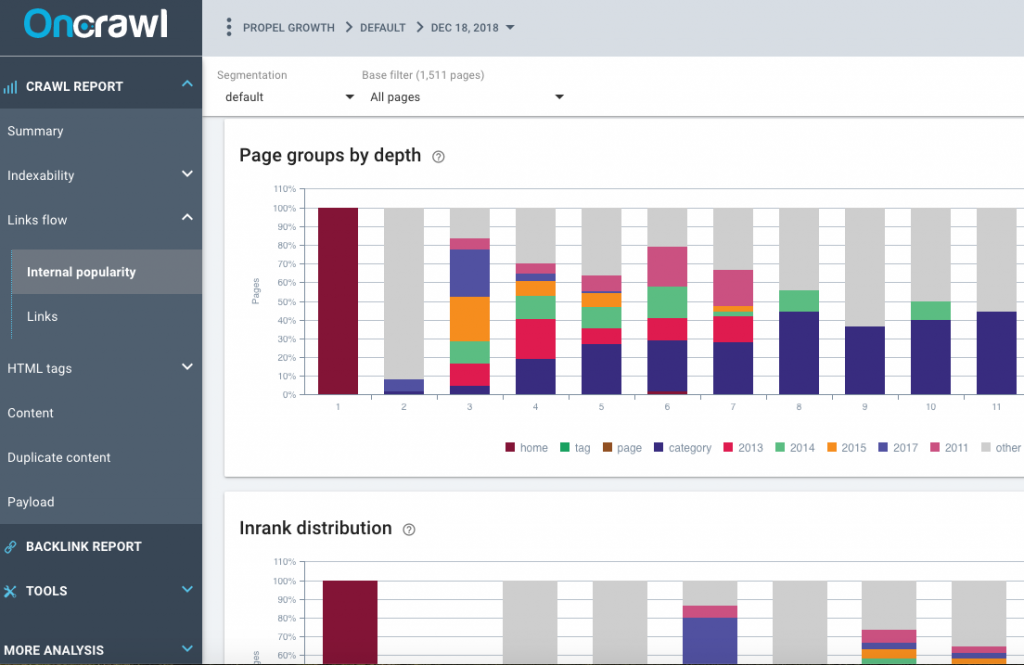

Werfen Sie einen Blick auf die internen Popularitätsberichte, die OnCrawl erstellt, überprüfen Sie die Seitengruppen nach Tiefe, die Inrank-Verteilung und den Inrank-Fluss. Verfügt die Website über ein Mega-Menü auf der Homepage der Website? Verlinkt das Megamenü auf die Unterkategorieseiten? Es sollte nicht. Es sollte eine kleine Anzahl von Kategorieseiten geben, die im Hauptmenü auf der Homepage der Site verlinkt sind.

Gibt es klare Themen oder Bereiche der Website? Dies erfordert eine manuelle Überprüfung der Website. Sie sollten ziemlich einfach erkennen können, ob es ein Mega-Menü mit allen Seiten auf der Website gibt oder ob es Abschnitte gibt. Ein weiterer zu prüfender Punkt ist der Abschnitt „Links“ im OnCrawl-Bericht.

Beachten Sie die durchschnittliche Anzahl von Inlinks pro Seite und die durchschnittlichen internen verfolgten Gliederungen pro Seite. Im Allgemeinen sollte es mehr eingehende Links zu Seiten geben als ausgehende Seiten. Wenn diese Zahlen sehr nahe beieinander liegen oder mehr ausgehende Links als eingehende Links vorhanden sind, könnte ein Problem mit der Websitestruktur vorliegen. Gibt es Seiten auf der Website mit weniger als 10 Follow-Links? Gibt es verwaiste Seiten, die nicht Teil der Site-Struktur sind?

Häufiger Fehler: Verwaiste Inhalte und Seiten

Verwaiste Seiten sind häufiger als Sie denken. Verwaiste Seiten sind einfach das: Als der Crawler auf der Homepage der Website startete und auf der Website von Link zu Link ging, konnte er keinen Link zu einer verwaisten Seite finden. Verwaiste Seiten werden von OnCrawl gefunden, weil es Google Analytics-Daten, Google Search Console-Daten und (hoffentlich) die Protokolldateidaten Ihrer Website analysiert. OnCrawl findet Seiten, die nicht auf der Website verlinkt sind, und identifiziert sie als verwaiste Seiten. Sie sind tatsächlich häufiger, als Sie vielleicht erwarten, weil wir dazu neigen, unsere Websites neu zu gestalten und Seiten auf dem Webserver zu belassen, aber nicht darauf zu verlinken. Es könnte sich um eine alte Version der Website handeln oder um Inhalte, die nicht für die Aufnahme in die neue Version der Website geeignet sind. Aber nichtsdestotrotz existieren die Seiten immer noch auf der Website, obwohl sie nicht direkt von der aktuellen öffentlich zugänglichen Website verlinkt sind. Das passiert – und verwaiste Seiten können viel Verkehr haben und gut ranken.

So beheben Sie diesen häufigen Fehler

Es gibt mehrere Möglichkeiten, wie Sie dieses Problem beheben können. Wenn Sie OnCrawl mit den richtigen Daten wie Google Analytics, Majestic, Google Search Console und Protokolldateidaten versorgen, werden verwaiste Seiten tatsächlich sehr gut identifiziert. Stellen Sie OnCrawl also all diese Daten zur Verfügung, wenn Sie Zugriff darauf haben. Protokolldateien können sehr wichtig sein, da sie andere Daten wie 404-Fehler und Weiterleitungen aufdecken können, die Ihnen helfen, verlorenen Traffic und Rankings wiederherzustellen.

Um diesen häufigen Fehler zu beheben, identifizieren Sie die verwaisten Seiten, die wichtig sind, und verlinken Sie sie dann ordnungsgemäß auf der Website. Wenn Links von anderen Websites auf Ihre Website verweisen, können Sie dies anhand der Majestic.com-Linkdaten erkennen. Links zu verwaisten Seiten, die auf der gesamten Website verlinkt sind, können Inrank und PageRank ordnungsgemäß an andere Seiten der Website weitergeben und ihr beim Ranking helfen.

Häufiger Fehler: Link-Probleme, schlechte und qualitativ minderwertige Links

Werfen Sie einen Blick auf die Majestic Domain Trust Flow- und Domain Citation Flow-Zahlen. Generell sollte der Trust Flow um mindestens 10 Punkte höher sein als der Citation Flow. Wenn der Citation Flow höher ist als der Trust Flow, haben Sie möglicherweise Links von geringer Qualität, die auf die Website verweisen. Sie sollten im Allgemeinen gute, qualitativ hochwertige Links haben, die auf Ihre Website verweisen, und nicht viele nicht vertrauenswürdige Websites von geringerer Qualität, die auf Ihre Website verlinken. Es ist üblich, dass einige Links von geringerer Qualität auf Ihre Website verweisen, da wir nicht alle kontrollieren können, die auf unsere Website verlinken. Einige der Links können wir jedoch kontrollieren.

So beheben Sie diesen häufigen Fehler

Nehmen Sie sich die Zeit, alle Links zu Ihrer Website zu überprüfen. Sehen Sie sich auch die Liste der Seiten mit Links an. Gibt es Seiten mit Links, die derzeit nicht aufgelöst werden? Vielleicht gibt es eine alte Seite, die nicht mehr existiert, die Links hat? Bringen Sie entweder diese Inhaltsseite unter derselben URL zurück oder leiten Sie diese Seite per 301 auf eine andere verwandte Seite zum selben Thema weiter – auf diese Weise stellen Sie diese Links wieder her.

Häufiger Fehler: Überoptimierung oder keine Optimierung

Ein weiterer häufiger Fehler, den ich ständig sehe, ist die On-Page-Optimierung, die anscheinend vor über 10 Jahren durchgeführt wurde, oder SEO, das auf einer Website durchgeführt wurde, die den SEO-Standards von vor 10 Jahren folgt. Die aktuellen SEO-Best Practices werden nicht befolgt, und normalerweise geht es dabei um Keyword-Stuffing, schlecht geschriebene Metadaten wie schlecht geschriebene Titel-Tags oder Meta-Beschreibungs-Tags oder sogar um die unsachgemäße Verwendung von Überschriften-Tags.

So beheben Sie diesen häufigen Fehler

Es ist ziemlich einfach, diesen häufigen Fehler zu beheben – lernen Sie die Best Practices zum Schreiben von Titel-Tags und Metadaten kennen und verwenden Sie akzeptable HTML-Codierungspraktiken. Geordnete Listen, Aufzählungen, die Verwendung von Fett, Kursiv und die richtigen Schriftgrößen und Farben sind heutzutage ein Muss. Das Bereinigen von HTML-Code und die Verwendung von geeignetem Markup-Code wie Schema.org-Code und JSON-LD-Code können einen großen Beitrag zu besseren Rankings und mehr Suchmaschinenverkehr leisten.

Häufiger Fehler: Falsche Verwendung von Code oder Richtlinien

Wenn Sie zu viel oder den unangemessenen oder falschen Schema.org-Code verwenden, kann dies zu einer manuellen Maßnahme von Google führen. Obwohl strukturierte Daten gut sind, müssen sie korrekt implementiert werden, sonst kann es schwerwiegende Folgen haben – sie können nach hinten losgehen. Viele Websites verwenden kein strukturiertes Markup, und das ist heutzutage nur eine verpasste Gelegenheit.

Andere verwandte Probleme können eine falsche Implementierung des Codes oder sogar widersprüchliche Anweisungen auf Seiten beinhalten. Wenn Sie beispielsweise ein kanonisches Tag auf einer Seite verwenden, verbieten Sie den Suchmaschinen nicht, diese Seite in der robots.txt-Datei zu crawlen. Wenn sie die Seite nicht crawlen können, können sie das kanonische Tag nicht sehen.

Andere falsche Implementierung von Code oder widersprüchliche Anweisungen, die ich häufig sehe, sind:

- falsche Verwendung von rel next/prev

- falsche kanonische Tag-Anweisungen

- falsche robots.txt-Anweisungen

So beheben Sie diesen häufigen Fehler

Ehrlich gesagt, um diese Probleme erkennen und beheben zu können, müssen Sie verstehen, was jede dieser Anweisungen bewirkt und warum sie verwendet werden. Sie müssen kein Programmierer sein, um den schema.org-Code zu verstehen, aber Sie müssen ein grundlegendes Verständnis dafür haben, warum und wann er verwendet wird. Ich bin kein Programmierer, aber ich kann den Code kopieren und einfügen – und es gibt viele Codegeneratoren, die Ihnen helfen, es richtig zu machen.

Oncrawl SEO-Crawler

Abschließend

Wir alle machen Fehler – und zum Glück sind alle diese Fehler sehr gut behebbar, was zu einer besser optimierten Website, einer viel suchmaschinenfreundlicheren und besucherfreundlicheren Website führen kann. Ein ordentliches SEO-Audit, auch wenn es selbst auf Ihrer eigenen Website durchgeführt wird, wird mit Sicherheit einen oder mehrere dieser häufigen Fehler aufdecken. Ich persönlich habe meine eigenen Websites geprüft und Probleme gefunden, die mir nicht bewusst waren, die ich aber beheben konnte, nachdem mich Tools wie OnCrawl darauf hingewiesen hatten. Und dennoch müssen wir unsere Schlachten wählen, da einige der gefundenen Probleme möglicherweise nicht so wichtig sind wie andere.