Die 25 besten Web-Crawling-Tools für die effiziente Datenextraktion von Websites

Veröffentlicht: 2023-06-15Eine Einführung in Web-Crawling-Tools

Web-Crawling-Tools, auch Spider oder Web Scraper genannt, sind für Unternehmen, die wertvolle Daten von Websites für Analyse- und Data-Mining-Zwecke extrahieren möchten, unverzichtbar. Diese Tools haben ein breites Anwendungsspektrum, von der Marktforschung bis zur Suchmaschinenoptimierung (SEO). Sie sammeln Daten aus verschiedenen öffentlichen Quellen und präsentieren sie in einem strukturierten und nutzbaren Format. Durch den Einsatz von Web-Crawling-Tools können Unternehmen den Überblick über Nachrichten, soziale Medien, Bilder, Artikel, Konkurrenten und vieles mehr behalten.

Die 25 besten Web-Crawling-Tools zum schnellen Extrahieren von Daten von Websites

Scrapy

Scrapy ist ein beliebtes Open-Source-Webcrawler-Framework auf Python-Basis, mit dem Entwickler skalierbare Webcrawler erstellen können. Es bietet einen umfassenden Satz an Funktionen, die die Implementierung von Webcrawlern und das Extrahieren von Daten von Websites erleichtern. Scrapy ist asynchron, das heißt, es stellt Anfragen nicht einzeln, sondern parallel, was zu einem effizienten Crawling führt. Als etabliertes Web-Crawling-Tool eignet sich Scrapy für groß angelegte Web-Scraping-Projekte.

Hauptmerkmale

- Es generiert Feed-Exporte in Formaten wie JSON, CSV und XML.

- Es verfügt über eine integrierte Unterstützung für das Auswählen und Extrahieren von Daten aus Quellen entweder über XPath- oder CSS-Ausdrücke.

- Es ermöglicht das automatische Extrahieren von Daten aus Webseiten mithilfe von Spidern.

- Es ist schnell und leistungsstark und verfügt über eine skalierbare und fehlertolerante Architektur.

- Es ist leicht erweiterbar , mit einem Plug-in-System und einer umfangreichen API.

- Es ist portabel und läuft unter Linux, Windows, Mac und BSD.

Preisgestaltung

- Es ist ein kostenloses Tool.

ParseHub

ParseHub ist ein Webcrawler-Tool, das Daten von Websites sammeln kann, die AJAX-Technologie, JavaScript, Cookies und mehr verwenden. Seine maschinelle Lerntechnologie kann Webdokumente lesen, analysieren und dann in relevante Daten umwandeln. Die Desktop-Anwendung von ParseHub unterstützt die Betriebssysteme Windows, Mac OS X und Linux. Durch die Bereitstellung einer benutzerfreundlichen Oberfläche ist ParseHub für Nicht-Programmierer konzipiert, die Daten von Websites extrahieren möchten.

Hauptmerkmale

- Es kann dynamische Websites durchsuchen, die AJAX, JavaScript, Infinite Scroll, Paginierung, Dropdowns, Anmeldungen und andere Elemente verwenden.

- Es ist einfach zu bedienen und erfordert keine Programmierkenntnisse.

- Es ist cloudbasiert und kann Daten auf seinen Servern speichern.

- Es unterstützt IP-Rotation , geplante Sammlung , reguläre Ausdrücke , API und Web-Hooks.

- Es kann Daten in den Formaten JSON und Excel exportieren.

Preisgestaltung

- ParseHub bietet sowohl kostenlose als auch kostenpflichtige Pläne. Die Preise für kostenpflichtige Pläne beginnen bei 149 US-Dollar pro Monat und bieten verbesserte Projektgeschwindigkeiten, eine höhere Begrenzung der Anzahl der gescrapten Seiten pro Durchlauf und die Möglichkeit, mehr Projekte zu erstellen.

Octoparse

Octoparse ist ein clientbasiertes Web-Crawling-Tool, mit dem Benutzer Webdaten ohne Programmieraufwand in Tabellenkalkulationen extrahieren können. Mit einer Point-and-Click-Oberfläche ist Octoparse speziell für Nicht-Programmierer konzipiert. Benutzer können ihre eigenen Webcrawler erstellen, um Daten von jeder Website zu sammeln, und Octoparse bietet vorgefertigte Scraper für beliebte Websites wie Amazon, eBay und Twitter. Das Tool bietet außerdem erweiterte Funktionen wie geplante Cloud-Extraktion, Datenbereinigung und die Umgehung der Blockierung mit IP-Proxyservern.

Hauptmerkmale

- Point-and-Click-Schnittstelle : Sie können die Webelemente, die Sie scannen möchten, ganz einfach auswählen, indem Sie darauf klicken. Octoparse erkennt dann automatisch die Datenmuster und extrahiert die Daten für Sie.

- Erweiterter Modus : Sie können Ihre Scraping-Aufgaben mit verschiedenen Aktionen anpassen, z. B. Text eingeben, auf Schaltflächen klicken, Seiten scrollen, Listen durchlaufen usw. Sie können auch XPath oder RegEx verwenden, um die Daten genau zu lokalisieren.

- Cloud-Service : Sie können Ihre Scraping-Aufgaben rund um die Uhr auf den Cloud-Servern von Octoparse ausführen und Ihre Daten auf der Cloud-Plattform speichern. Sie können Ihre Aufgaben auch planen und die automatische IP-Rotation verwenden, um eine Blockierung durch Websites zu vermeiden.

- API : Sie können über eine API auf Ihre Daten zugreifen und diese in andere Anwendungen oder Plattformen integrieren. Sie können mit Octoparse auch beliebige Daten in benutzerdefinierte APIs umwandeln.

Preisgestaltung

- Es gibt sowohl kostenlose als auch kostenpflichtige Pläne. Die kostenpflichtigen Pläne beginnen bei 89 $/Monat.

WebHarvy

WebHarvy ist eine Point-and-Click-Web-Scraping-Software für Nicht-Programmierer. Es kann automatisch Text, Bilder, URLs und E-Mails von Websites entfernen und sie in verschiedenen Formaten wie XML, CSV, JSON oder TSV speichern. WebHarvy unterstützt auch das anonyme Crawlen und Bearbeiten dynamischer Websites durch den Einsatz von Proxyservern oder VPN-Diensten für den Zugriff auf Zielwebsites.

Hauptmerkmale

- Point-and-Click-Schnittstelle zum Auswählen von Daten ohne Codierung oder Skripterstellung

- Mehrseiten-Mining mit automatischem Crawling und Scraping

- Kategorie-Scraping zum Auslesen von Daten aus ähnlichen Seiten oder Auflistungen

- Herunterladen von Bildern von Produktdetailseiten von E-Commerce-Websites

- Automatische Mustererkennung für Scraping-Listen oder -Tabellen ohne zusätzliche Konfiguration

- Schlüsselwortbasierte Extraktion durch Übermittlung eingegebener Schlüsselwörter an Suchformulare

- Reguläre Ausdrücke für mehr Flexibilität und Kontrolle beim Scraping

- Automatisierte Browserinteraktion zum Ausführen von Aufgaben wie Klicken auf Links, Auswählen von Optionen, Scrollen und mehr

Preisgestaltung

- WebHarvy ist eine Web-Scraping-Software, für die eine einmalige Lizenzgebühr anfällt.

- Ihre Lizenzpreise beginnen bei 139 US-Dollar für ein Jahr.

Wunderschöne Suppe

Beautiful Soup ist eine Open-Source-Python-Bibliothek, die zum Parsen von HTML- und XML-Dokumenten verwendet wird. Es erstellt einen Analysebaum, der das Extrahieren von Daten aus dem Web erleichtert. Obwohl Beautiful Soup nicht so schnell wie Scrapy ist, wird es vor allem für seine Benutzerfreundlichkeit und die Unterstützung der Community bei Problemen gelobt.

Hauptmerkmale

- Parsen : Sie können Beautiful Soup mit verschiedenen Parsern wie html.parser, lxml, html5lib usw. verwenden, um verschiedene Arten von Webdokumenten zu analysieren.

- Navigieren : Sie können mit Pythonic-Methoden und -Attributen wie find(), find_all(), select(), .children, .parent, .next_sibling usw. im Analysebaum navigieren.

- Suchen : Sie können den Analysebaum mithilfe von Filtern wie Tag-Namen, Attributen, Text, CSS-Selektoren, regulären Ausdrücken usw. durchsuchen, um die gewünschten Elemente zu finden.

- Ändern : Sie können den Analysebaum ändern, indem Sie Elemente und ihre Attribute hinzufügen, löschen, ersetzen oder bearbeiten.

Preisgestaltung

Beautiful Soup ist eine kostenlose Open-Source-Bibliothek, die Sie mit pip installieren können.

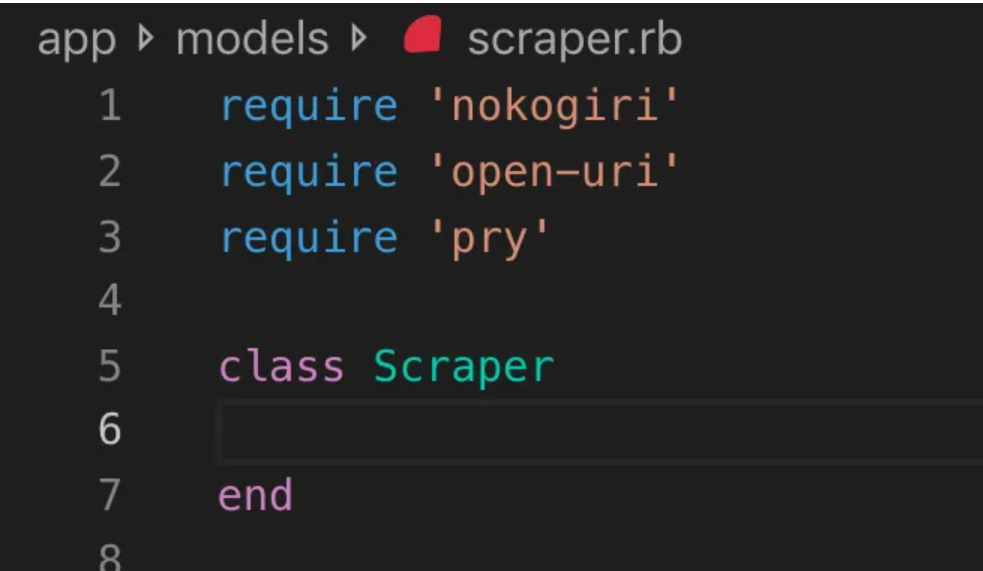

Nokogiri

Nokogiri ist ein Webcrawler-Tool, das das Parsen von HTML- und XML-Dokumenten mit Ruby, einer Programmiersprache, die für Anfänger in der Webentwicklung geeignet ist, erleichtert. Nokogiri basiert auf nativen Parsern wie libxml2 von C und xerces von Java und ist damit ein leistungsstarkes Tool zum Extrahieren von Daten aus Websites. Es eignet sich gut für Webentwickler, die mit einer Ruby-basierten Web-Crawling-Bibliothek arbeiten möchten.

Hauptmerkmale

- DOM-Parser für XML, HTML4 und HTML5

- SAX-Parser für XML und HTML4

- Push-Parser für XML und HTML4

- Dokumentensuche über XPath 1.0

- Dokumentensuche über CSS3-Selektoren mit einigen JQuery-ähnlichen Erweiterungen

- Validierung des XSD-Schemas

- XSLT-Transformation

- „Builder“ DSL für XML- und HTML-Dokumente

Preisgestaltung

- Nokogiri ist ein Open-Source-Projekt, dessen Nutzung kostenlos ist.

Zyte (ehemals Scrapinghub)

Zyte (ehemals Scrapinghub) ist ein cloudbasiertes Datenextraktionstool, das Tausenden von Entwicklern hilft, wertvolle Daten von Websites abzurufen. Das Open-Source-Tool zum visuellen Scraping ermöglicht Benutzern das Scrapen von Websites ohne Programmierkenntnisse. Zyte verwendet Crawlera, einen intelligenten Proxy-Rotator, der die Umgehung von Bot-Gegenmaßnahmen unterstützt, um große oder durch Bots geschützte Websites einfach zu crawlen, und der Benutzern das Crawlen von mehreren IP-Adressen und Standorten ohne den Aufwand der Proxy-Verwaltung über eine einfache HTTP-API ermöglicht.

Hauptmerkmale

- Daten auf Abruf: Stellen Sie Zyte Websites und Datenanforderungen zur Verfügung, und Zyte liefert die angeforderten Daten nach Ihrem Zeitplan.

- Zyte AP I: Ruft mithilfe der effizientesten Proxy- und Extraktionskonfiguration automatisch HTML von Websites ab, sodass Sie sich ohne technische Bedenken auf die Daten konzentrieren können.

- Scrapy Cloud : Skalierbares Hosting für Ihre Scrapy-Spider mit einer benutzerfreundlichen Weboberfläche zur Verwaltung, Überwachung und Steuerung Ihrer Crawler, komplett mit Überwachungs-, Protokollierungs- und Daten-QA-Tools.

- Automatische Datenextraktions -API : Greifen Sie über die KI-gestützte Extraktions-API von Zyte sofort auf Webdaten zu und liefern Sie schnell hochwertige strukturierte Daten. Mit dieser patentierten Technologie wird das Onboarding neuer Quellen einfacher.

Preisgestaltung

Zyte verfügt über ein flexibles Preismodell, das von der Komplexität und dem Volumen der von Ihnen benötigten Daten abhängt. Sie können aus drei Plänen wählen:

- Entwickler: 49 $/Monat für 250.000 Anfragen

- Geschäftlich: 299 $/Monat für 2 Millionen Anfragen

- Unternehmen: Individuelle Preise für mehr als 10 Millionen Anfragen

- Sie können Zyte auch kostenlos mit 10.000 Anfragen pro Monat testen.

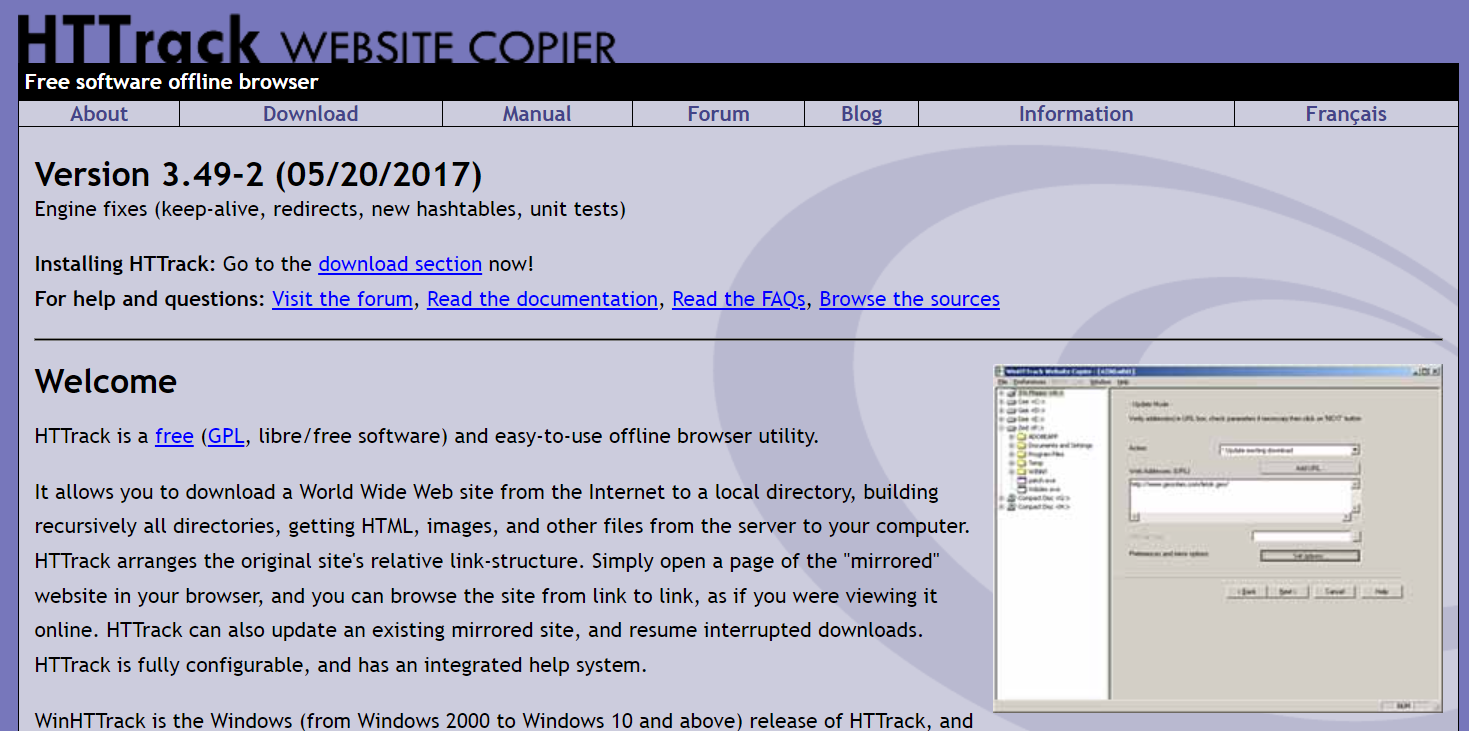

HTTrack

HTTrack ist ein kostenloses Open-Source-Webcrawler-Tool, mit dem Benutzer ganze Websites oder bestimmte Webseiten zum Offline-Browsen auf ihr lokales Gerät herunterladen können. Es bietet eine Befehlszeilenschnittstelle und kann auf Windows-, Linux- und Unix-Systemen verwendet werden.

Hauptmerkmale

- Die relative Linkstruktur der ursprünglichen Website bleibt erhalten.

- Es kann eine vorhandene gespiegelte Site aktualisieren und unterbrochene Downloads fortsetzen.

- Es ist vollständig konfigurierbar und verfügt über ein integriertes Hilfesystem.

- Es unterstützt verschiedene Plattformen wie Windows, Linux, OSX, Android usw.

- Es gibt eine Befehlszeilenversion und eine Version mit grafischer Benutzeroberfläche.

Preisgestaltung

- HTTrack ist freie Software, die unter der GNU GPL lizenziert ist.

Apache Nutch

Apache Nutch ist ein erweiterbarer Open-Source-Webcrawler, der häufig in Bereichen wie der Datenanalyse eingesetzt wird. Es kann Inhalte über Protokolle wie HTTPS, HTTP oder FTP abrufen und Textinformationen aus Dokumentformaten wie HTML, PDF, RSS und ATOM extrahieren.

Hauptmerkmale

- Es basiert auf Apache Hadoop-Datenstrukturen, die sich hervorragend für die Stapelverarbeitung großer Datenmengen eignen.

- Es verfügt über eine hochmodulare Architektur, die es Entwicklern ermöglicht, Plug-ins für das Parsen von Medientypen, den Datenabruf, Abfragen und Clustering zu erstellen.

- Es unterstützt verschiedene Plattformen wie Windows, Linux, OSX, Android usw.

- Es gibt eine Befehlszeilenversion und eine Version mit grafischer Benutzeroberfläche.

- Es lässt sich in Apache Tika für die Analyse, Apache Solr und Elasticsearch für die Indizierung sowie Apache HBase für die Speicherung integrieren.

Preisgestaltung

- Apache Nutch ist freie Software, die unter der Apache-Lizenz 2.0 lizenziert ist.

Heliumschaber

Helium Scraper ist ein visuelles Tool zum Crawlen von Webdaten, das von Benutzern angepasst und gesteuert werden kann, ohne dass eine Programmierung erforderlich ist. Es bietet erweiterte Funktionen wie Proxy-Rotation, schnelle Extraktion und Unterstützung für mehrere Datenformate wie Excel, CSV, MS Access, MySQL, MSSQL, XML oder JSON.

Hauptmerkmale

- Schnelle Extraktion : Delegieren Sie Extraktionsaufgaben automatisch an separate Browser

- Big Data : Die SQLite-Datenbank kann bis zu 140 Terabyte speichern

- Datenbankgenerierung : Tabellenbeziehungen werden basierend auf extrahierten Daten generiert

- SQL-Generierung : Verknüpfen und filtern Sie Tabellen schnell zum Exportieren oder für Eingabedaten

- API-Aufruf : Integrieren Sie Web Scraping und API-Aufruf in einem einzigen Projekt

- Textmanipulation : Generieren Sie Funktionen zum Zuordnen, Teilen oder Ersetzen von extrahiertem Text

- JavaScript-Unterstützung: Fügen Sie benutzerdefinierten JavaScript-Code ein und führen Sie ihn auf jeder Website aus

- Proxy-Rotation : Geben Sie eine Liste von Proxys ein und rotieren Sie diese in einem bestimmten Intervall

- Erkennung ähnlicher Elemente : Erkennt ähnliche Elemente aus einer oder zwei Proben

- Listenerkennung : Listen und Tabellenzeilen auf Websites automatisch erkennen

- Datenexport : Exportieren Sie Daten nach CSV, Excel, XML, JSON oder SQLite

- Planung : Startbar über die Befehlszeile oder den Windows-Taskplaner

Preisgestaltung

- Die Basislizenz kostet 99 $ pro Benutzer.

Content Grabber (Sequentum)

Content Grabber ist eine Web-Crawling-Software für Unternehmen, mit der Benutzer eigenständige Web-Crawling-Agenten erstellen können. Es bietet erweiterte Funktionen wie die Integration in Datenanalyse- oder Berichtsanwendungen von Drittanbietern, leistungsstarke Skriptbearbeitungs- und Debugging-Schnittstellen sowie Unterstützung für den Export von Daten in Excel-Berichte, XML, CSV und die meisten Datenbanken.

Hauptmerkmale

- Benutzerfreundliche Point-and-Click-Oberfläche : Erkennt automatisch Aktionen basierend auf HTML-Elementen

- Robuste API : Unterstützt die einfache Drag-and-Drop-Integration in vorhandene Datenpipelines

- Anpassung : Passen Sie Ihre Scraping-Agenten mit gängigen Programmiersprachen wie Python, C#, JavaScript und regulären Ausdrücken an

- Integration : Integrieren Sie KI-, ML-, NLP-Bibliotheken oder APIs von Drittanbietern zur Datenanreicherung

- Zuverlässigkeit und Skalierbarkeit : Halten Sie die Infrastrukturkosten niedrig und profitieren Sie gleichzeitig von der Echtzeitüberwachung des End-to-End-Betriebs

- Einhaltung gesetzlicher Vorschriften : Reduzieren Sie Ihre Haftung und mindern Sie das Risiko, das mit kostspieligen Klagen und Bußgeldern verbunden ist

- Datenexport : Exportieren Sie Daten in ein beliebiges Format und liefern Sie sie an jeden Endpunkt

- Planung : Starten Sie Ihre Scraping-Agenten über die Befehlszeile oder den Windows-Taskplaner

Preisgestaltung

- Die Basislizenz kostet 27.500 US-Dollar pro Jahr und ermöglicht die Nutzung der Software auf einem Computer.

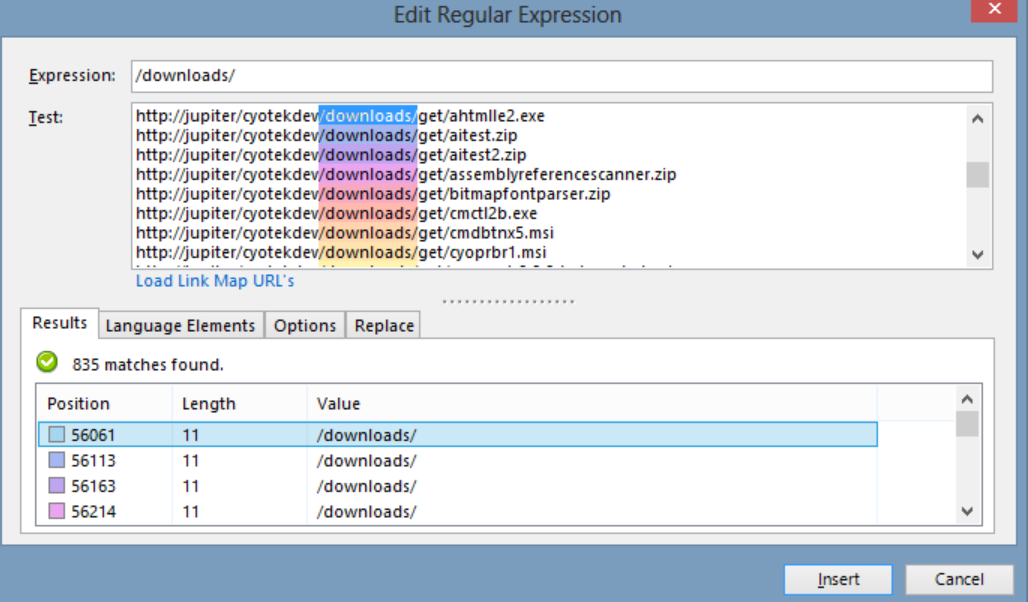

Cyotek WebCopy

Cyotek WebCopy ist ein kostenloser Website-Crawler, der es Benutzern ermöglicht, Websites teilweise oder vollständig lokal auf ihre Festplatte zu kopieren, um sie offline zu nutzen. Es kann Links innerhalb einer Website erkennen und verfolgen und Links automatisch neu zuordnen, damit sie dem lokalen Pfad entsprechen. Allerdings enthält WebCopy weder ein virtuelles DOM noch irgendeine Form der JavaScript-Analyse, sodass dynamische Website-Layouts aufgrund der starken Verwendung von JavaScript möglicherweise nicht richtig verarbeitet werden können.

Hauptmerkmale

- Einfach zu bedienende Point-and-Click-Oberfläche mit automatischer Aktionserkennung basierend auf HTML-Elementen

- Robuste API für die nahtlose Integration in bestehende Datenpipelines durch einfache Drag-and-Drop-Funktionalität

- Anpassungsoptionen mit gängigen Programmiersprachen wie Python, C#, JavaScript und regulären Ausdrücken, um Scraping-Agents an spezifische Anforderungen anzupassen

- Integrationsfunktionen mit KI-, ML-, NLP-Bibliotheken oder APIs von Drittanbietern zur Anreicherung von Scraped-Daten

- Zuverlässige und skalierbare Infrastruktur mit Echtzeitüberwachung für kostengünstigen Betrieb

- Funktionen zur Einhaltung gesetzlicher Vorschriften reduzieren die Haftung und mindern das Risiko von Klagen und Bußgeldern

- Datenexport in jedes gewünschte Format und Bereitstellung an verschiedene Endpunkte

- Planungsoptionen ermöglichen das Starten von Scraping-Agenten über die Befehlszeile oder den Windows-Taskplaner

Preisgestaltung

- Die Basislizenz kostet 27.500 US-Dollar pro Jahr und ermöglicht die Nutzung der Software auf einem Computer.

80 Beine

80legs ist ein leistungsstarkes Web-Crawling-Tool, das je nach individuellen Anforderungen konfiguriert werden kann. Es unterstützt das Abrufen großer Datenmengen und bietet die Möglichkeit, die extrahierten Daten sofort herunterzuladen. Das Tool bietet Benutzern eine API zum Erstellen von Crawlern, zum Verwalten von Daten und mehr. Zu den Hauptfunktionen gehören die Scraper-Anpassung, IP-Server für Web-Scraping-Anfragen und ein JS-basiertes App-Framework zum Konfigurieren von Web-Crawlings mit benutzerdefiniertem Verhalten.

Hauptmerkmale

- Skalierbar und schnell : Sie können bis zu 2 Milliarden Seiten pro Tag mit über 50.000 gleichzeitigen Anfragen crawlen.

- Flexibel und anpassbar: Sie können Ihren eigenen Code verwenden, um die Crawling-Logik und Datenextraktion zu steuern, oder die integrierten Tools und Vorlagen verwenden.

Preisgestaltung

- Sie können je nach Bedarf aus verschiedenen Preisplänen wählen, angefangen bei 29 $/Monat für 100.000 URLs/Crawl bis zu 299 $/Monat für 10 Millionen URLs/Crawl.

Webhose.io

Mit Webhose.io können Benutzer Echtzeitdaten abrufen, indem sie Online-Quellen aus der ganzen Welt crawlen und diese in verschiedenen sauberen Formaten präsentieren. Dieses Webcrawler-Tool kann Daten crawlen und mithilfe mehrerer Filter, die ein breites Spektrum an Quellen abdecken, Schlüsselwörter in verschiedenen Sprachen weiter extrahieren. Benutzer können die Scraped-Daten in den Formaten XML, JSON und RSS speichern und über das Archiv auf die Verlaufsdaten zugreifen. Webhose.io unterstützt mit seinen Crawling-Datenergebnissen bis zu 80 Sprachen, sodass Benutzer die vom Tool gecrawlten strukturierten Daten einfach indizieren und durchsuchen können.

Hauptmerkmale

- Mehrere Formate : Sie können Daten in den Formaten XML, JSON, RSS oder Excel abrufen.

- Strukturierte Ergebnisse : Sie können Daten erhalten, die entsprechend Ihren Anforderungen normalisiert, angereichert und kategorisiert werden.

- Historische Daten : Sie können auf archivierte Daten der letzten 12 Monate oder länger zugreifen.

- Breite Abdeckung : Sie können Daten aus über einer Million Quellen in 80 Sprachen und 240 Ländern abrufen.

- Vielzahl von Quellen : Sie können Daten von Nachrichtenseiten, Blogs, Foren, Message Boards, Kommentaren, Rezensionen und mehr abrufen.

- Schnelle Integration : Sie können Webhose.io mit einer einfachen REST-API in wenigen Minuten in Ihre Systeme integrieren.

Preisgestaltung

- Es gibt einen kostenlosen Plan, mit dem Sie 1000 Anfragen pro Monat kostenlos stellen können. Es gibt auch individuelle Pläne, bei denen Sie sich für ein Angebot kontaktieren können.

Mozenda

Mozenda ist eine cloudbasierte Web-Scraping-Software, die es Benutzern ermöglicht, Webdaten zu extrahieren, ohne eine einzige Codezeile schreiben zu müssen. Es automatisiert den Datenextraktionsprozess und bietet Funktionen wie geplante Datenextraktion, Datenbereinigung und Umgehung der Blockierung mit IP-Proxyservern. Mozenda wurde für Unternehmen entwickelt und verfügt über eine benutzerfreundliche Oberfläche und leistungsstarke Scraping-Funktionen.

Hauptmerkmale

- Textanalyse: Sie können Textdaten von jeder Website mithilfe natürlicher Sprachverarbeitungstechniken extrahieren und analysieren.

- Bildextraktion: Sie können Bilder von Webseiten herunterladen und speichern oder Bildmetadaten wie Größe, Format, Auflösung usw. extrahieren.

- Unterschiedliche Datenerfassung: Sie können Daten aus mehreren Quellen und Formaten wie HTML, XML, JSON, RSS usw. sammeln.

- Dokumentenextraktion: Sie können Daten aus PDF-, Word-, Excel- und anderen Dokumenttypen mithilfe der optischen Zeichenerkennung (OCR) oder Textextraktionsmethoden extrahieren.

- Extraktion von E-Mail-Adressen : Sie können E-Mail-Adressen mithilfe regulärer Ausdrücke oder Mustervergleiche aus Webseiten oder Dokumenten suchen und extrahieren.

Preisgestaltung

- Der kostenpflichtige Plan beginnt bei 99 $ pro Monat.

UiPath

UiPath ist eine Robotic Process Automation (RPA)-Software für kostenloses Web-Scraping. Es automatisiert das Crawlen von Web- und Desktop-Daten aus den meisten Drittanbieter-Apps. UiPath ist mit Windows kompatibel und kann tabellarische und musterbasierte Daten über mehrere Webseiten hinweg extrahieren. Die Software bietet außerdem integrierte Tools zum weiteren Crawlen und Bearbeiten komplexer Benutzeroberflächen.

Hauptmerkmale

- Textanalyse : Extrahieren und analysieren Sie Textdaten mithilfe natürlicher Sprachverarbeitung, regulärer Ausdrücke und Mustervergleich für Aufgaben wie die Extraktion von E-Mail-Adressen.

- Bildextraktion : Laden Sie Bilder von Webseiten herunter und speichern Sie sie. Extrahieren Sie Bildmetadaten, einschließlich Größe, Format und Auflösung.

- Unterschiedliche Datenerfassung : Sammeln Sie Daten aus verschiedenen Quellen und Formaten wie HTML, XML, JSON, RSS, mit Integrationsmöglichkeiten für die Verbindung zu anderen Onlinediensten und APIs.

- Dokumentenextraktion : Extrahieren Sie Daten aus PDF-, Word-, Excel- und anderen Dokumenttypen mithilfe von OCR- oder Textextraktionsmethoden. Verarbeiten und extrahieren Sie Informationen über verschiedene Dokumenttypen und -strukturen hinweg mit Dokumentenverständnisfunktionen.

- Web-Automatisierung : Automatisieren Sie webbasierte Aktivitäten wie Anmelden, Navigieren durch Seiten, Ausfüllen von Formularen und Klicken auf Schaltflächen. Nutzen Sie die Rekorderfunktion, um Aktionen zu erfassen und Automatisierungsskripts zu generieren.

Preisgestaltung

- Die bezahlt Der Plan beginnt bei 420 $ pro Monat.

OutWit Hub

OutWit Hub ist ein Firefox-Add-on mit Dutzenden Datenextraktionsfunktionen, um die Websuche der Benutzer zu vereinfachen. Dieses Webcrawler-Tool kann Seiten durchsuchen und die extrahierten Informationen in einem geeigneten Format speichern. OutWit Hub bietet eine einzige Schnittstelle zum Scrapen kleiner oder großer Datenmengen je nach Bedarf und kann automatische Agenten erstellen, um in wenigen Minuten Daten von verschiedenen Websites zu extrahieren.

Hauptmerkmale

- Webinhalte anzeigen und exportieren: Sie können die auf einer Webseite enthaltenen Links, Dokumente, Bilder, Kontakte, Datentabellen, RSS-Feeds, E-Mail-Adressen und andere Elemente anzeigen. Sie können sie auch in HTML, SQL, CSV, XML, JSON oder andere Formate exportieren.

- Daten in Tabellen und Listen organisieren: Sie können die in Tabellen und Listen gesammelten Daten sortieren, filtern, gruppieren und bearbeiten. Sie können auch mehrere Kriterien verwenden, um die Daten auszuwählen, die Sie extrahieren möchten.

- Automatisierte Funktionen einrichten : Mit der Scraper-Funktion können Sie benutzerdefinierte Scraper erstellen, die mit einfachen oder erweiterten Befehlen Daten von jeder Website extrahieren können. Sie können die Makrofunktion auch verwenden, um Webbrowsing- und Scraping-Aufgaben zu automatisieren.

- Abfragen und URLs generieren: Mit der Abfragefunktion können Sie Abfragen basierend auf Schlüsselwörtern oder Mustern generieren. Sie können die URL-Funktion auch verwenden, um URLs basierend auf Mustern oder Parametern zu generieren.

Preisgestaltung

- Die Light-Lizenz ist kostenlos und voll funktionsfähig, umfasst jedoch nicht die Automatisierungsfunktionen und beschränkt die Extraktion je nach Extraktor auf eine oder einige hundert Zeilen.

- Die Pro-Lizenz kostet 110 US-Dollar pro Jahr und beinhaltet alle Funktionen der Light-Lizenz sowie die Automatisierungsfunktionen und unbegrenzte Extraktion.

Visueller Schaber

Visual Scraper ist nicht nur eine SaaS-Plattform, sondern bietet auch Web-Scraping-Dienste wie Datenbereitstellungsdienste und die Erstellung von Software-Extraktoren für Kunden an. Dieses Web-Crawling-Tool deckt den gesamten Lebenszyklus eines Crawlers ab, vom Herunterladen über die URL-Verwaltung bis hin zur Inhaltsextraktion. Es ermöglicht Benutzern, Projekte so zu planen, dass sie zu bestimmten Zeiten ausgeführt werden, oder Sequenzen jede Minute, jeden Tag, jede Woche, jeden Monat oder jedes Jahr zu wiederholen. Visual Scraper ist ideal für Benutzer, die regelmäßig Nachrichten, Updates und Foren extrahieren möchten. Allerdings scheint die offizielle Website derzeit nicht aktualisiert zu sein, und diese Informationen sind möglicherweise nicht aktuell.

Hauptmerkmale

- Einfach zu bedienende Oberfläche

- Unterstützt mehrere Datenformate (CSV, JSON, XML usw.)

- Unterstützt Paginierung, AJAX und dynamische Websites

- Unterstützt Proxyserver und IP-Rotation

- Unterstützt Planung und Automatisierung

Preisgestaltung

- Es gibt einen kostenlosen Plan und kostenpflichtige Pläne ab 39,99 $ pro Monat.

Import.io

Import.io ist ein Web-Scraping-Tool, mit dem Benutzer Daten von einer bestimmten Webseite importieren und in CSV exportieren können, ohne Code schreiben zu müssen. Es kann problemlos Tausende von Webseiten in wenigen Minuten durchsuchen und über 1000 APIs basierend auf den Anforderungen der Benutzer erstellen. Import.io integriert Webdaten mit nur wenigen Klicks in die App oder Website eines Benutzers und erleichtert so das Web-Scraping.

Hauptmerkmale

- Point-and-Click-Auswahl und Schulung

- Authentifizierte und interaktive Extraktion

- Bild-Downloads und Screenshots

- Premium-Proxys und länderspezifische Extraktoren

- CSV-, Excel-, JSON-Ausgabe und API-Zugriff

- Datenqualitäts-SLA und Reporting

- E-Mail-, Ticket-, Chat- und Telefonsupport

Preisgestaltung

- Starter: 199 $ pro Monat für 5.000 Abfragen

Dexi.io

Dexi.io ist ein browserbasierter Webcrawler, der es Benutzern ermöglicht, Daten basierend auf ihrem Browser von jeder Website zu scrapen und drei Arten von Robotern zum Erstellen einer Scraping-Aufgabe bereitstellt – Extractor, Crawler und Pipes. Die Freeware stellt anonyme Web-Proxy-Server bereit und die extrahierten Daten werden zwei Wochen lang auf den Servern von Dexi.io gehostet, bevor die Daten archiviert werden. Alternativ können Benutzer die extrahierten Daten direkt in JSON- oder CSV-Dateien exportieren. Es bietet kostenpflichtige Dienste für Benutzer, die eine Datenextraktion in Echtzeit benötigen.

Hauptmerkmale

- Point-and-Click-Auswahl und Schulung

- Authentifizierte und interaktive Extraktion

- Bild-Downloads und Screenshots

- Premium-Proxys und länderspezifische Extraktoren

- CSV-, Excel-, JSON-Ausgabe und API-Zugriff

- Datenqualitäts-SLA und Reporting

- E-Mail-, Ticket-, Chat- und Telefonsupport

Preisgestaltung

- Standard: 119 $ pro Monat oder 1.950 $ pro Jahr für 1 Arbeitnehmer

Puppenspieler

Puppeteer ist eine von Google entwickelte Node-Bibliothek, die Programmierern eine API zur Steuerung von Chrome oder Chromium über das DevTools-Protokoll bietet. Es ermöglicht Benutzern, mit Puppeteer und Node.js ein Web-Scraping-Tool zu erstellen. Puppeteer kann für verschiedene Zwecke verwendet werden, z. B. zum Erstellen von Screenshots oder zum Erstellen von PDFs von Webseiten, zum Automatisieren von Formularübermittlungen/Dateneingaben und zum Erstellen von Tools für automatisierte Tests.

Hauptmerkmale

- Erstellen Sie Screenshots und PDFs von Webseiten

- Crawlen und Scrapen von Daten von Websites

- Automatisieren Sie die Formularübermittlung, UI-Tests, Tastatureingaben usw.

- Erfassen Sie Leistungsmetriken und Traces

- Testen Sie Chrome-Erweiterungen

- Führen Sie im Headless- oder Headful-Modus aus

Preisgestaltung

- Puppeteer ist kostenlos und Open Source.

Crawler4j

Crawler4j ist ein Open-Source-Java-Webcrawler mit einer einfachen Schnittstelle zum Crawlen des Webs. Es ermöglicht Benutzern die Erstellung von Multithread-Crawlern bei gleichzeitig effizienter Speichernutzung. Crawler4j eignet sich gut für Entwickler, die eine unkomplizierte und anpassbare Java-basierte Web-Crawling-Lösung wünschen.

Hauptmerkmale

- Mithilfe regulärer Ausdrücke können Sie festlegen, welche URLs gecrawlt und welche ignoriert werden sollen.

- Damit können Sie die heruntergeladenen Seiten verwalten und Daten daraus extrahieren.

- Es respektiert das robots.txt-Protokoll und vermeidet das Crawlen unzulässiger Seiten.

- Es kann HTML, Bilder und andere Dateitypen crawlen.

- Es kann Statistiken sammeln und mehrere Crawler gleichzeitig ausführen.

Preisgestaltung

- Crawler4j ist ein Open-Source-Java-Projekt, mit dem Sie ganz einfach Ihre eigenen Webcrawler einrichten und ausführen können.

Gemeinsames Kriechen

Common Crawl ist ein Webcrawler-Tool, das einen offenen Korpus von Webdaten für Forschungs-, Analyse- und Bildungszwecke bereitstellt.

Hauptmerkmale

- Es bietet Benutzern Zugriff auf Web-Crawling-Daten wie rohe Webseitendaten, extrahierte Metadaten und Text sowie auf den Common Crawl Index.

Preisgestaltung

- Diese kostenlosen und öffentlich zugänglichen Webcrawl-Daten können von Entwicklern, Forschern und Unternehmen für verschiedene Datenanalyseaufgaben verwendet werden.

Mechanische Suppe

MechanicalSoup ist eine Python-Bibliothek zum Parsen von Websites, die auf der Beautiful Soup-Bibliothek basiert und von der Mechanize-Bibliothek inspiriert ist. Es eignet sich hervorragend zum Speichern von Cookies, zum Verfolgen von Weiterleitungen, Hyperlinks und zum Bearbeiten von Formularen auf einer Website.

Hauptmerkmale

- MechanicalSoup bietet eine einfache Möglichkeit, Websites zu durchsuchen und Daten daraus zu extrahieren, ohne sich mit komplexen Programmieraufgaben befassen zu müssen.

Preisgestaltung

- Es ist ein kostenloses Tool.

Knoten-Crawler

Node Crawler ist ein beliebtes und leistungsstarkes Paket zum Crawlen von Websites mit der Node.js-Plattform. Es läuft auf Basis von Cheerio und verfügt über viele Optionen zum Anpassen der Art und Weise, wie Benutzer das Web crawlen oder scrapen, einschließlich der Begrenzung der Anzahl der Anfragen und der zwischen ihnen benötigten Zeit. Node Crawler ist ideal für Entwickler, die für ihre Web-Crawling-Projekte lieber mit Node.js arbeiten.

Hauptmerkmale

- Einfach zu verwenden

- Ereignisgesteuerte API

- Konfigurierbare Wiederholungsversuche und Zeitüberschreitungen

- Automatische Kodierungserkennung

- Automatische Cookie-Verarbeitung

- Automatische Umleitungsbehandlung

- Automatische gzip/deflate-Verarbeitung

Preisgestaltung

- Es ist ein kostenloses Tool.

Faktoren, die bei der Auswahl eines Web-Crawling-Tools zu berücksichtigen sind

Preisgestaltung

Berücksichtigen Sie die Preisstruktur des gewählten Tools und stellen Sie sicher, dass diese transparent ist und keine versteckten Kosten entstehen. Entscheiden Sie sich für ein Unternehmen, das ein klares Preismodell bietet und detaillierte Informationen zu den verfügbaren Funktionen bereitstellt.

Benutzerfreundlichkeit

Wählen Sie ein Web-Crawling-Tool, das benutzerfreundlich ist und keine umfassenden technischen Kenntnisse erfordert. Viele Tools bieten Point-and-Click-Schnittstellen, die es auch Nicht-Programmierern erleichtern, Daten aus Websites zu extrahieren.

Skalierbarkeit

Überlegen Sie, ob das Web-Crawling-Tool das Datenvolumen bewältigen kann, das Sie extrahieren müssen, und ob es mit Ihrem Unternehmen wachsen kann. Einige Tools eignen sich eher für kleine Projekte, während andere für die Datenextraktion im großen Maßstab konzipiert sind.

Datenqualität und Genauigkeit

Stellen Sie sicher, dass das Web-Crawling-Tool die extrahierten Daten bereinigen und in einem verwendbaren Format organisieren kann. Die Datenqualität ist für eine genaue Analyse von entscheidender Bedeutung. Wählen Sie daher ein Tool, das effiziente Datenbereinigungs- und Organisationsfunktionen bietet.

Kundendienst

Wählen Sie ein Web-Crawling-Tool mit reaktionsschnellem und hilfreichem Kundensupport, der Sie bei Problemen unterstützt. Testen Sie den Kundensupport, indem Sie ihn kontaktieren und notieren, wie lange es dauert, bis er antwortet, bevor er eine fundierte Entscheidung trifft.

Abschluss

Web-Crawling-Tools sind für Unternehmen, die wertvolle Daten von Websites für verschiedene Zwecke extrahieren möchten, wie z. B. Marktforschung, SEO und Wettbewerbsanalyse, unerlässlich. Durch die Berücksichtigung von Faktoren wie Preis, Benutzerfreundlichkeit, Skalierbarkeit, Datenqualität und -genauigkeit sowie Kundensupport können Sie das richtige Web-Crawling-Tool auswählen, das Ihren Anforderungen entspricht. Die oben genannten Top-25-Webcrawler-Tools richten sich an ein breites Spektrum an Benutzern, von Nicht-Programmierern bis hin zu Entwicklern, und stellen sicher, dass für jeden das passende Tool dabei ist. Sie können sich auch für eine 7-tägige kostenlose Testversion bei Scalenut anmelden, um den Inhalt Ihrer Website zu optimieren und Ihr Ranking zu verbessern.