Optimieren Sie Ihre SEO-Bemühungen mit den besten Robot-TXT-Generator-Tools: Top 5 Tipps für Profis

Veröffentlicht: 2023-06-15Suchmaschinenoptimierung (SEO) bleibt ein wesentlicher Bestandteil des Online-Erfolgs in der sich ständig weiterentwickelnden digitalen Landschaft. Da SEO-Experten bestrebt sind, die Sichtbarkeit und Platzierung von Websites auf Suchmaschinen-Ergebnisseiten (SERPs) zu verbessern, greifen sie auf verschiedene Strategien und Tools zur Optimierung ihrer Websites zurück. Ein solches wichtiges Tool im SEO-Arsenal ist die Datei Robots.txt.

Die Datei „Robots.txt“ spielt eine entscheidende Rolle dabei, Suchmaschinen-Crawlern bei der Navigation und Indexierung des Inhalts einer Website zu helfen.

Mithilfe dieser Datei können Websitebesitzer effektiv steuern, welche Teile ihrer Website für Suchmaschinen zugänglich und welche privat bleiben sollen. Die Erstellung einer gut optimierten Robots.txt-Datei erfordert Präzision und Liebe zum Detail, weshalb SEO-Experten häufig auf Robots.txt-Generator-Tools zurückgreifen.

In diesem Blog werden die fünf besten Robots.txt-Generator-Tools und -Verzeichnisse untersucht, die jeder SEO-Experte in seinen Workflow integrieren sollte.

Die Bedeutung von Robots.txt-Dateien verstehen

Robots.txt ist eine wichtige Datei, die Suchmaschinen beim Crawlen und Indexieren von Websites anleitet. Im Stammordner einer Website abgelegt, ermöglicht es Websitebesitzern, mit Suchmaschinen-Crawlern wie dem Googlebot zu kommunizieren und festzulegen, welche Teile ihrer Website gecrawlt und indiziert und welche ausgeschlossen werden sollen.

Durch die angemessene Verwaltung von robots.txt-Dateien können Websitebesitzer sicherstellen, dass ihre Websites effizient indiziert werden und eine gute Benutzererfahrung aufrechterhalten werden.

Die 5 besten TXT-Generator-Tools für Roboter

Das manuelle Erstellen einer robots.txt-Datei kann zeitaufwändig und fehleranfällig sein. Um den Prozess einfacher und genauer zu gestalten, stehen zahlreiche robots.txt-Generator-Tools zur Verfügung, die diese Arbeit für Sie erledigen. Hier sind die Top 5 robots.txt-Generator-Tools:

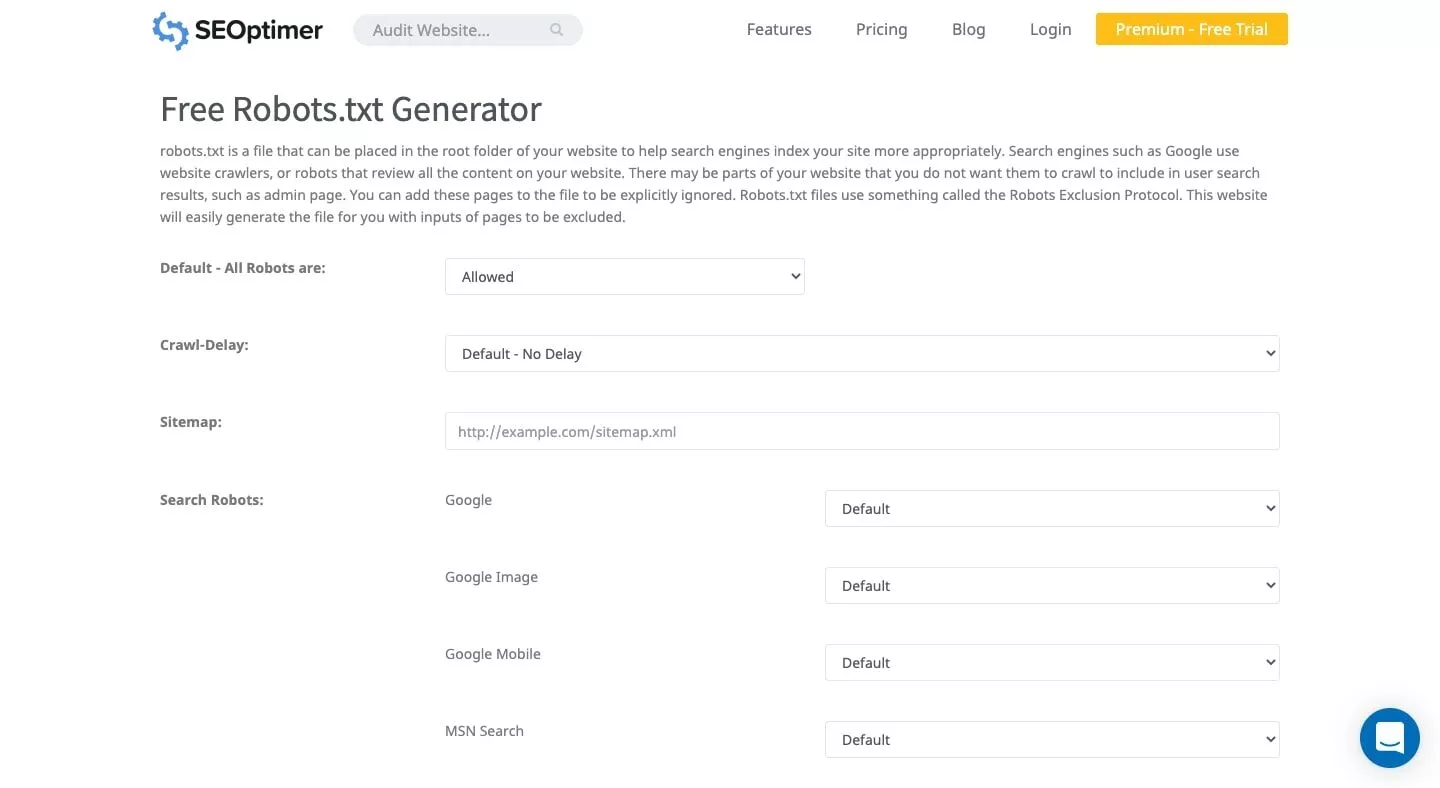

1. SEOptimer

SEOptimer bietet eine übersichtliche Benutzeroberfläche, mit der Sie kostenlos eine robots.txt-Datei erstellen können. Mit diesem benutzerfreundlichen Tool können Sie einen Crawl-Verzögerungszeitraum festlegen und festlegen, welche Bots das Crawlen Ihrer Website zulassen oder verweigern. Die generierte Datei kann heruntergeladen und zum Stammordner Ihrer Website hinzugefügt werden.

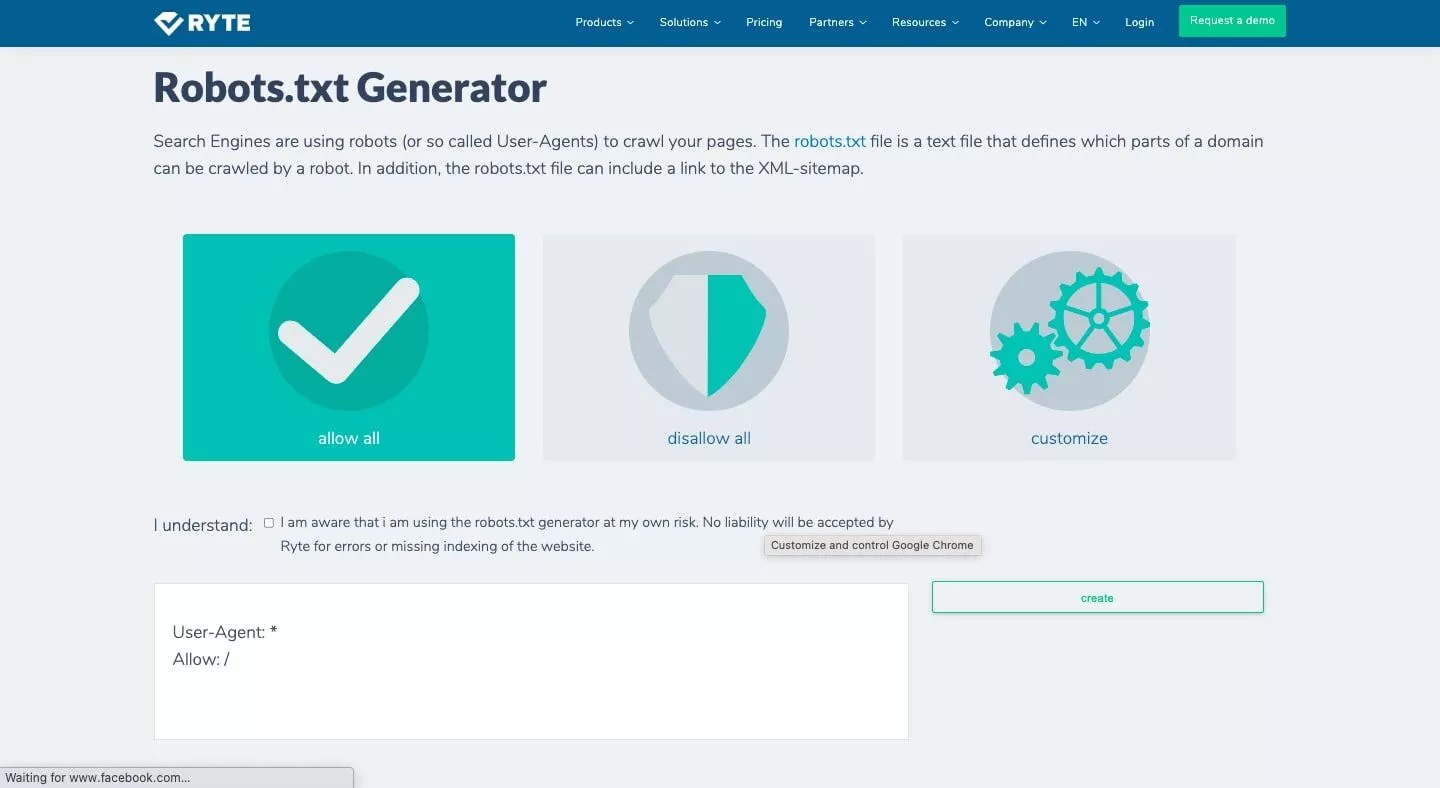

2. Ryte

Der kostenlose Generator/Checker von Ryte bietet drei Optionen zum Generieren einer robots.txt-Datei: Alle zulassen, Alle nicht zulassen und Anpassen. Mit der Anpassungsoption können Sie angeben, welche Bots Sie beeinflussen möchten, und enthalten Schritt-für-Schritt-Anleitungen. Dieser Robots-TXT-Dateigenerator sorgt für eine umfassende Analyse Ihrer Website und hilft bei der Erstellung einer gut strukturierten Robots.txt-Datei.

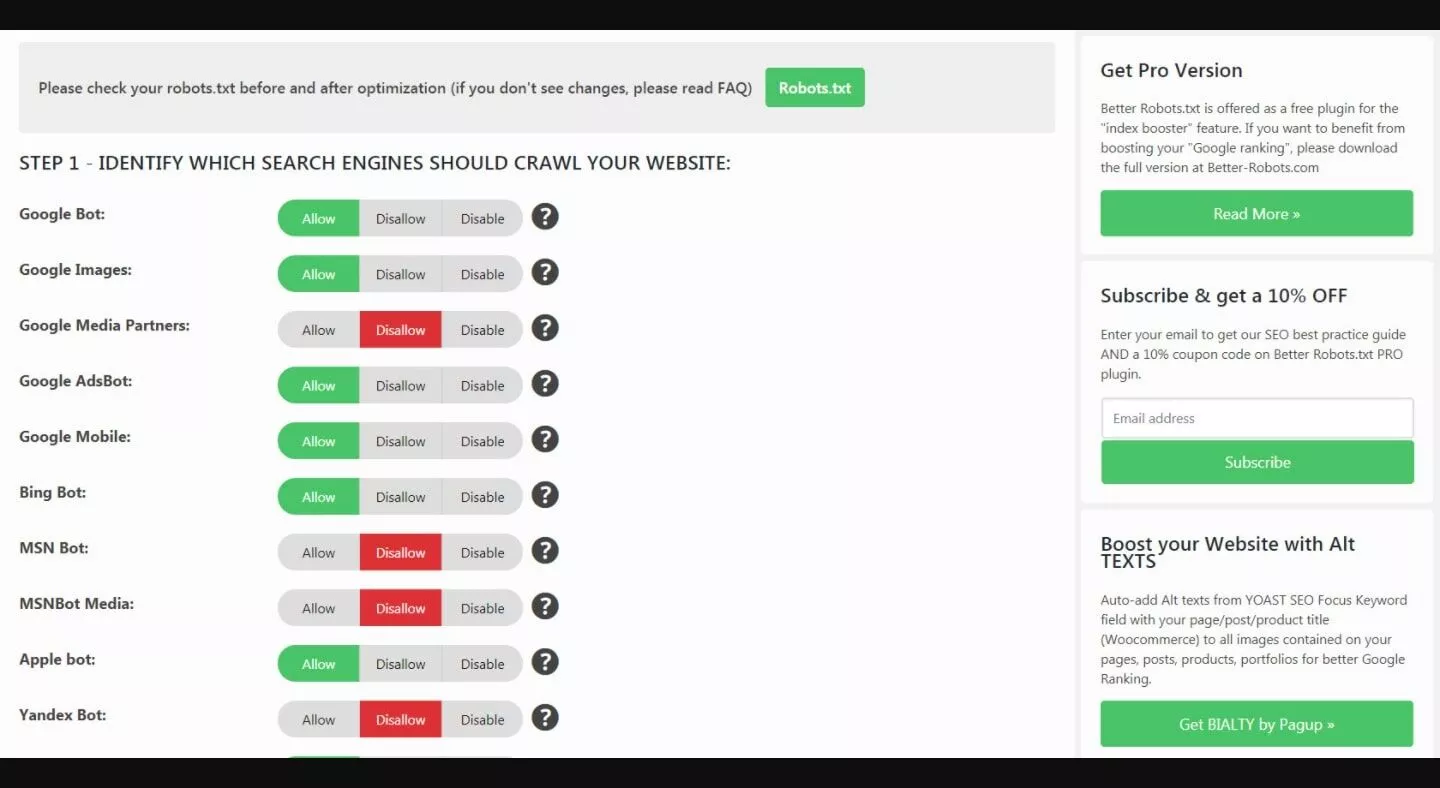

3. Bessere Robots.txt (WordPress)

Das Better Robots.txt WordPress-Plugin trägt dazu bei, die SEO- und Ladefähigkeiten Ihrer Website zu verbessern. Es wird in 7 Sprachen unterstützt und kann Ihre Daten und Inhalte vor schädlichen Bots schützen. Dieses Plugin wurde speziell für WordPress-Sites entwickelt und ist daher eine ausgezeichnete Wahl für Websitebesitzer, die die WordPress-Plattform nutzen.

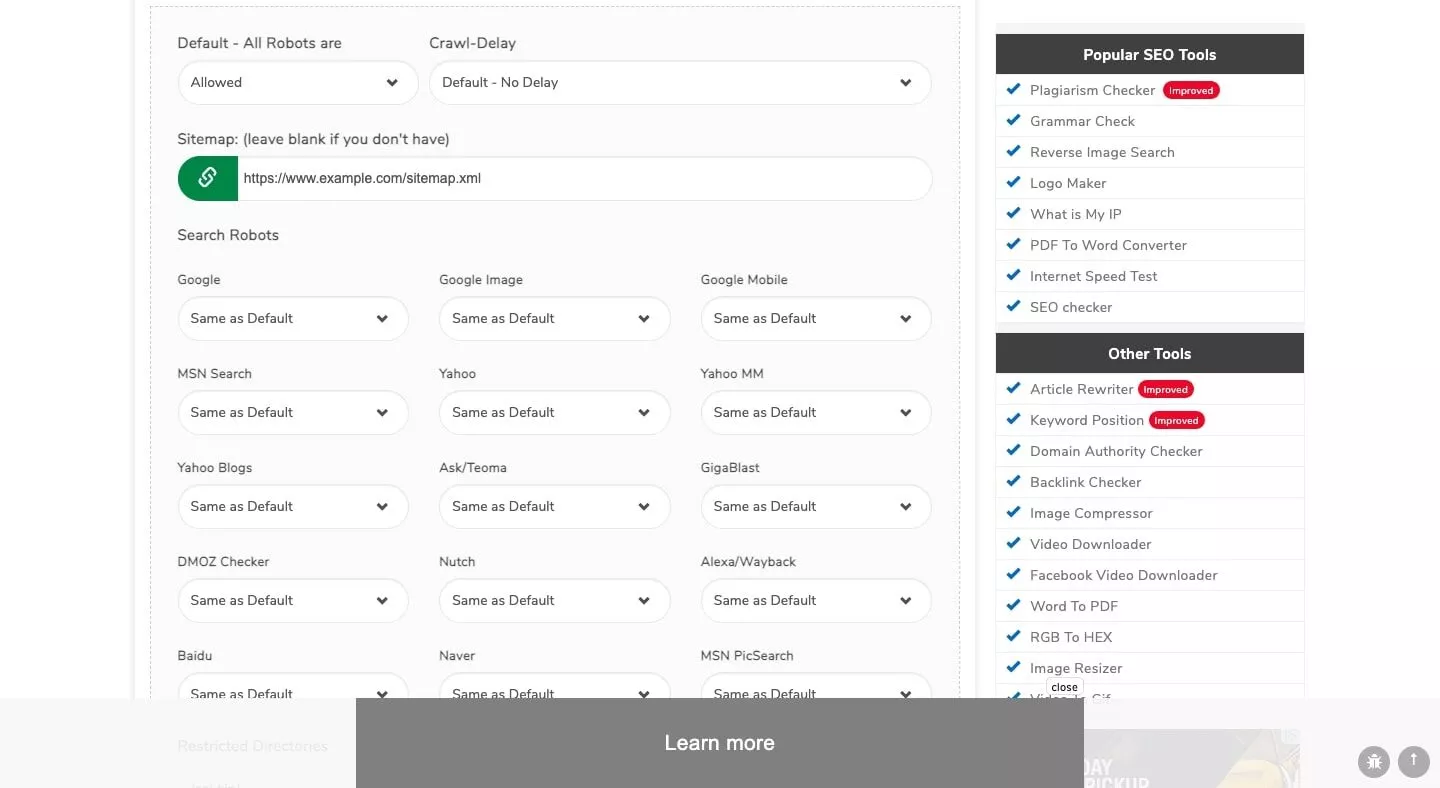

4. Kleine SEO-Tools

Der Generator von Small SEO Tools verfügt über eine einfache Schnittstelle, mit der Sie mühelos eine robots.txt-Datei erstellen können. Das Tool verwendet Dropdown-Leisten für die Einstellungen jedes einzelnen Bots, sodass Sie für jeden Bot „erlaubt“ oder „abgelehnt“ auswählen können. Dieser Generator ist Teil einer Suite von SEO-Tools und -Ressourcen, die Small SEO Tools bereitstellt.

5. Robots.txt-Tester der Google Search Console

Die Google Search Console verfügt über einen robots.txt-Tester, den Sie nach dem Generieren Ihrer robots.txt-Datei verwenden können. Senden Sie die URL Ihrer Website an das Tester-Tool, um zu prüfen, ob sie richtig formatiert ist, um den Googlebot vor bestimmten Elementen zu schützen, die Sie ausblenden möchten.

Dieses offizielle Google-Tool und einer der besten Sitemap-Prüfer stellt sicher, dass Ihre Textdatei den Google-Richtlinien entspricht und den Crawler-Zugriff effektiv verwaltet.

Wichtige Funktionen, auf die Sie bei einem Robots.txt-Generator achten sollten

Berücksichtigen Sie bei der Auswahl eines robots.txt-Generator-Tools die folgenden Funktionen:

1. Benutzerfreundlichkeit: Das Tool sollte über eine benutzerfreundliche Oberfläche verfügen, die es Ihnen ermöglicht, Ihre robots.txt-Datei mit minimalem Aufwand zu erstellen und zu verwalten.

2. Anpassungsoptionen: Der Generator sollte Anpassungsoptionen bieten, z. B. die Angabe, welche Bots auf Ihre Website zugreifen können, und das Festlegen von Crawling-Verzögerungszeiten.

3. Kompatibilität : Stellen Sie sicher, dass das Tool mit der Plattform Ihrer Website, z. B. WordPress, kompatibel ist, um eine nahtlose Integration und Funktionalität zu gewährleisten.

4. Sprachunterstützung: Wenn sich Ihre Website an ein nicht englischsprachiges Publikum richtet, sollte das Tool Unterstützung für mehrere Sprachen bieten.

5. Zusätzliche Ressourcen: Einige Generatoren verfügen über zusätzliche SEO-Tools und -Ressourcen, die Ihnen dabei helfen können, die Leistung Ihrer Website weiter zu optimieren.

Bei der Auswahl eines Robots.txt-Generators zu berücksichtigende Faktoren

Berücksichtigen Sie bei der Auswahl eines robots.txt-Generator-Tools zusätzlich zu den oben genannten Hauptfunktionen die folgenden Faktoren:

1. Die spezifischen Anforderungen Ihrer Website: Abhängig von der Struktur und dem Inhalt Ihrer Website benötigen Sie möglicherweise ein Tool, das erweiterte Anpassungsoptionen oder eine bessere Integration in Ihre Plattform bietet.

2. Ihr Fachwissen: Wenn Sie neu in der Suchmaschinenoptimierung oder der Verwaltung von robots.txt-Dateien sind, entscheiden Sie sich für ein Tool mit einer übersichtlichen Benutzeroberfläche und klaren Anweisungen. Andererseits bevorzugen erfahrene Benutzer möglicherweise ein Tool, das erweiterte Funktionen und Anpassungsoptionen bietet.

3. Support und Updates: Wählen Sie ein Tool, das regelmäßig Updates erhält und zuverlässigen Kundensupport bietet, um alle Probleme zu lösen, auf die Sie stoßen.

4. Budget: Während viele robots.txt-Generator-Tools kostenlos verfügbar sind, bieten einige Premium-Tools möglicherweise zusätzliche Funktionen und Vorteile. Berücksichtigen Sie Ihr Budget, wenn Sie das richtige Werkzeug für Ihre Anforderungen auswählen.

Die Rolle von Robots.txt bei der Suchmaschinenoptimierung (SEO)

Robots.txt spielt eine entscheidende Rolle bei der Suchmaschinenoptimierung, indem es Suchmaschinen-Crawlern dabei hilft, Ihre Website effektiver zu indizieren. Durch die ordnungsgemäße Verwaltung Ihrer robots.txt-Datei wird sichergestellt, dass Suchmaschinen den wichtigsten Seiten Ihrer Website Priorität einräumen und gleichzeitig irrelevante oder doppelte Inhalte ausschließen.

Dies trägt dazu bei, die Sichtbarkeit Ihrer Website in den Suchergebnissen zu verbessern, was zu mehr organischem Traffic und einer besseren Benutzererfahrung führt. Darüber hinaus trägt eine gut strukturierte robots.txt-Datei dazu bei, das Crawling-Budget zu schonen und zu verhindern, dass Suchmaschinen-Crawler Ihren Server überlasten oder Zeit mit unwichtigen Seiten verschwenden.

Dies wiederum sorgt für eine schnellere Indexierung der wichtigen Inhalte Ihrer Website und trägt positiv zur allgemeinen SEO-Leistung Ihrer Website bei.

Abschluss

Die Verwaltung der robots.txt-Datei Ihrer Website ist für die Optimierung des Crawlings und der Indexierung durch Suchmaschinen von entscheidender Bedeutung. Durch die Verwendung eines zuverlässigen robots.txt-Generator-Tools können Sie Ihre Datei effizient erstellen und verwalten und so eine bessere SEO-Leistung für Ihre Website sicherstellen.

Die oben genannten robots.txt-Generator-Tools wie SEOptimer, Ryte, Better Robots.txt (WordPress), Small SEO Tools und der Google Search Console Robots.txt Tester können Ihnen dabei helfen, eine effektive robots.txt-Datei zu erstellen, die Ihren Bedürfnissen entspricht spezifischen Anforderungen des Standorts.

Berücksichtigen Sie die wichtigsten Funktionen, Preise und zusätzlichen Faktoren, die in diesem Artikel erwähnt werden, wenn Sie das beste robots.txt-Generator-Tool für Ihre Anforderungen auswählen.

Über Scalenut

Scalenut ist eine KI-gestützte SEO- und Content-Marketing-Plattform , die den Prozess der Content-Erstellung und -Optimierung revolutioniert hat. Dieses flexible Tool optimiert den gesamten Arbeitsablauf, einschließlich der Formulierung von Content-Strategien, der präzisen Brieferstellung, der fesselnden Content-Erstellung und der effizienten SEO-Optimierung. Durch die Bereitstellung einer 7-tägigen Testphase ermöglicht Scalenut Benutzern, das breite Spektrum an Funktionen zu erkunden und seine volle Leistungsfähigkeit auszuschöpfen.