57 Häufige Fehler beim A/B-Testen und wie man sie vermeidet

Veröffentlicht: 2021-06-15

Führen Sie A/B-Tests durch, sind sich aber nicht sicher, ob sie richtig funktionieren?

Möchten Sie die häufigsten Fehler beim A/B-Testen lernen, damit Sie keine wertvolle Zeit mit einer kaputten Kampagne verlieren?

Nun, gute Neuigkeiten! In diesem Artikel führen wir Sie durch 57 häufige (und manchmal ungewöhnliche) A/B-Testfehler, die wir sehen, damit Sie sie entweder umgehen oder erkennen können, wann sie passieren, und sie schnell beheben können.

Wir haben diese in 3 Hauptabschnitte unterteilt:

- Fehler, bevor Sie mit dem Testen beginnen,

- Probleme, die während des Tests auftreten können,

- Und Fehler, die Sie machen können, sobald der Test abgeschlossen ist.

Sie können einfach durchlesen und sehen, ob Sie eines davon selbst machen.

Und merke dir:

Jeder Fehler ist eine wertvolle Lektion, sowohl beim Testen als auch bei Fehlern beim Einrichten. Der Schlüssel ist, von ihnen zu lernen!

Tauchen wir also ein…

- Häufige A/B-Testfehler, die gemacht werden können, bevor Sie Ihren Test überhaupt durchführen

- #1. Vor dem Testen etwas live pushen!

- #2. Es wird kein tatsächlicher A/B-Test durchgeführt

- #3. Testen Sie nicht, ob das Tool funktioniert

- #4. Verwenden eines minderwertigen Tools und Flashen von Inhalten

- #5. Keine Test-QA

- #6. Funktioniert die neue Behandlung/Variante?

- #7. Nicht einer Hypothese folgen und einfach irgendein altes Ding testen

- #8. Eine nicht überprüfbare Hypothese haben

- #9. Setzen Sie sich im Voraus kein klares Ziel für Ihren Test

- #10. Konzentration auf oberflächliche Metriken

- #11. Verwenden Sie nur quantitative Daten, um Testideen zu bilden

- #12. Kopieren Sie Ihre Konkurrenten

- #13. Nur „Best Practices der Branche“ testen

- #14. Konzentrieren Sie sich zuerst auf Aufgaben mit geringer Wirkung, wenn große Belohnungen/niedrig hängende Früchte mit hoher Wirkung verfügbar sind

- #fünfzehn. Mehrere Dinge gleichzeitig testen und nicht wissen, welche Änderung das Ergebnis verursacht hat

- #16. Es wird keine ordnungsgemäße Vortestanalyse durchgeführt

- #17. Falsche Kennzeichnung der Tests

- #18. Tests mit der falschen URL ausführen

- #19. Hinzufügen beliebiger Anzeigeregeln zu Ihrem Test

- #20. Testen Sie den falschen Traffic für Ihr Ziel

- #21. Das Versäumnis, wiederkehrende Besucher von einem Test auszuschließen und die Ergebnisse zu verfälschen

- #22. Entfernen Sie Ihre IPs nicht aus dem Test

- #23. Keine Segmentierung der Kontrollgruppenvariationen (Netzwerkeffekt)

- #24. Durchführung von Tests während saisonaler Ereignisse oder wichtiger Website-/Plattformereignisse

- #25. Ignorieren kultureller Unterschiede

- #26. Mehrere verbundene Kampagnen gleichzeitig ausführen

- #27. Ungleiche Verkehrsgewichtung

- Häufige A/B-Testfehler, die Sie während Ihres Tests machen können

- #28. Läuft nicht lange genug, um genaue Ergebnisse zu erhalten

- #29. Hubschrauberüberwachung/Peeking

- #30. Benutzerfeedback nicht verfolgen (besonders wichtig, wenn der Test eine direkte, unmittelbare Aktion betrifft)

- #31. Änderungen während des Tests vornehmen

- #32. Ändern der Verkehrszuweisung % mitten im Test oder Entfernen von schlechten Leistungen

- #33. Einen Test nicht abbrechen, wenn Sie genaue Ergebnisse haben

- #34. Emotional in das Verlieren von Variationen investiert sein

- #35. Laufende Tests zu lange und Tracking bricht ab

- #36. Verwenden Sie kein Tool, mit dem Sie den Test stoppen/durchführen können!

- Häufige A/B-Testfehler, die Sie nach Abschluss Ihres Tests machen können

- #37. Nach einem Test aufgeben!

- #38. Eine gute Hypothese aufgeben, bevor Sie alle Versionen davon getestet haben

- #39. Erwarten Sie die ganze Zeit riesige Gewinne

- #40. Validität nach dem Test nicht prüfen

- #41. Ergebnisse nicht richtig lesen

- #42. Betrachten Sie die Ergebnisse nicht nach Segmenten

- #43. Nicht aus Ergebnissen lernen

- #44. Die Verlierer nehmen

- #45. Nicht auf die Ergebnisse reagieren

- #46. Nicht Iterieren und Verbessern von Gewinnen

- #47. Gewinnende Erkenntnisse nicht in anderen Bereichen oder Abteilungen teilen

- #48. Testen Sie diese Änderungen nicht in anderen Abteilungen

- #49. Zu viele Iterationen auf einer einzelnen Seite

- #50. Nicht genug testen!

- #51. Tests nicht dokumentieren

- #52. Vergessen Sie Fehlalarme und überprüfen Sie große Werbekampagnen nicht doppelt

- #53. Downline-Ergebnisse werden nicht verfolgt

- #54. Nichtberücksichtigung von Vorrang- und Neuheitseffekten, die die Behandlungsergebnisse verfälschen können

- #55. Laufender Betrachtungszeitraum ändert sich

- #56. Kein erneutes Testen nach X-Zeit

- #57. Testen Sie nur den Pfad und nicht das Produkt

- Fazit

Häufige A/B-Testfehler, die gemacht werden können, bevor Sie Ihren Test überhaupt durchführen

#1. Vor dem Testen etwas live pushen!

Vielleicht haben Sie ein fantastisches neues Seiten- oder Website-Design und möchten es unbedingt live schalten, ohne es zu testen.

Halt ab!

Führen Sie zunächst einen Schnelltest durch, um zu sehen, wie es funktioniert. Sie möchten keine radikale Änderung live vorantreiben, ohne einige Daten zu erhalten, oder Sie könnten Verkäufe und Konversionen verlieren.

Manchmal kann diese neue Änderung zu einem erheblichen Leistungseinbruch führen. Also erstmal kurz testen.

#2. Es wird kein tatsächlicher A/B-Test durchgeführt

Ein A/B-Test funktioniert, indem eine einzelne Verkehrsquelle zu einer Kontrollseite und einer Variation dieser Seite geleitet wird. Das Ziel ist herauszufinden, ob die von Ihnen implementierte Änderung dazu führt, dass das Publikum besser konvertiert und Maßnahmen ergreift.

Die Sache ist die, um sicherzustellen, dass dieser Test kontrolliert und fair ist, müssen wir diesen Test mit bestimmten Parametern durchführen. Wir brauchen die gleichen Traffic-Quellen, die die Kampagne während des gleichen Zeitraums sehen, damit wir keine externen Faktoren haben, die den einen Test beeinflussen und den anderen nicht.

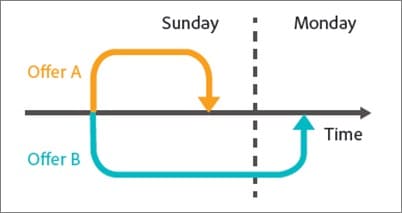

Einige Leute machen den Fehler, einen Test nacheinander durchzuführen. Sie führen ihre aktuelle Seite X Zeit lang aus, dann die neue Version X Zeit danach und messen dann den Unterschied.

Diese Ergebnisse sind nicht ganz genau, da während dieser Testfenster viele Dinge passieren könnten. Sie könnten einen Ausbruch von neuem Traffic erhalten, eine Veranstaltung durchführen, was dazu führen würde, dass die beiden Seiten völlig unterschiedliche Zielgruppen und Ergebnisse haben.

Stellen Sie also sicher, dass Sie einen tatsächlichen A/B-Test durchführen, bei dem Sie den Datenverkehr zwischen Ihren beiden Versionen aufteilen und sie genau zur gleichen Zeit testen.

#3. Testen Sie nicht, ob das Tool funktioniert

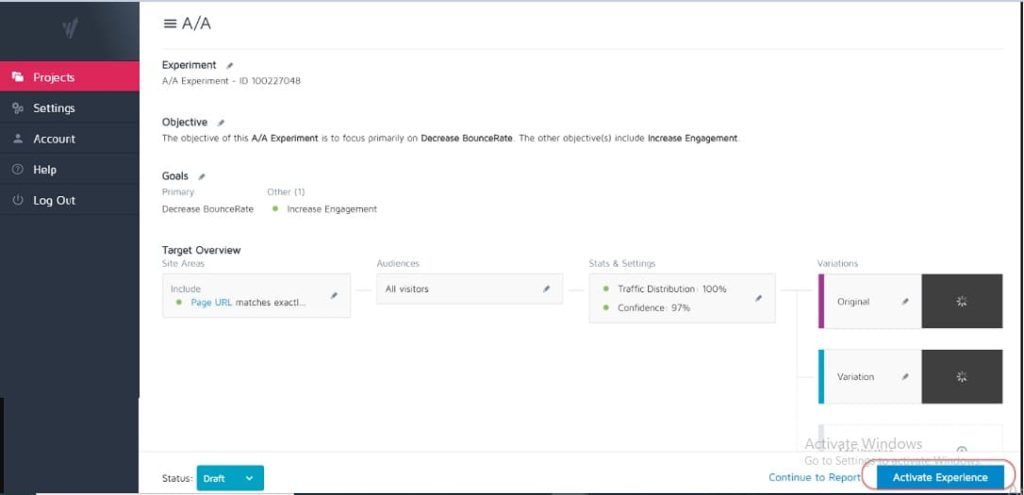

Kein Testtool ist zu 100 % genau. Das Beste, was Sie tun können, wenn Sie anfangen, ist, einen A/A-Test durchzuführen, um zu sehen, wie genau Ihr Tool ist.

Wie? Führen Sie einfach einen Test durch, bei dem Sie den Traffic 50:50 auf eine einzelne Seite aufteilen. (Stellen Sie sicher, dass es sich um eine Seite handelt, auf der Ihr Publikum konvertieren kann, damit Sie ein bestimmtes Ergebnis messen können.)

Wieso den?

Da beide Zielgruppen genau dieselbe Seite sehen, sollten die Conversion-Ergebnisse auf beiden Seiten des Tests identisch sein, richtig?

Nun, manchmal sind sie es nicht, was bedeutet, dass Ihr Tool möglicherweise falsch eingerichtet ist. Überprüfen Sie also Ihr Testtool, bevor Sie Kampagnen durchführen.

#4. Verwenden eines minderwertigen Tools und Flashen von Inhalten

Einige Tools sind einfach nicht so gut wie andere. Sie erledigen die Arbeit, kämpfen aber unter Verkehrslast oder „blinken“ und flackern.

Dies kann tatsächlich dazu führen, dass Ihr Test fehlschlägt, selbst wenn Sie eine potenzielle Gewinnervariante haben.

Angenommen, Sie testen ein Bild auf Ihrer Seite. Die Kontrollseite lädt einwandfrei, aber die Variation flimmert nur für den Bruchteil einer Sekunde zwischen dem neuen Testbild und dem Original. (Oder vielleicht jedes Mal, wenn der Benutzer auf der Seite nach oben und unten scrollt.)

Dies kann ablenken und zu Vertrauensproblemen führen, was Ihre Konversionsrate senkt.

Tatsächlich könnte Ihr neues Bild theoretisch sogar besser konvertiert werden, aber das Flackern des Werkzeugs verringert die Ergebnisse und gibt Ihnen einen ungenauen Test dieses Bildes.

Stellen Sie sicher, dass Sie ein ausreichend gutes Tool zum Testen haben.

(Dies ist ein so wichtiger Faktor für das Benutzererlebnis, dass Google derzeit seine Rankings für Websites anpasst, die keine flackernden oder sich bewegenden Elemente haben).

#5. Keine Test-QA

Ein super einfacher Fehler, aber hast du überprüft, ob alles funktioniert?

- Haben Sie den Verkaufsprozess durchlaufen?

- Haben Sie andere? (Und auf nicht zwischengespeicherten Geräten, weil das, was in Ihrem Browser gespeichert ist, manchmal nicht so aussieht, wie die Seite aussieht.)

- Werden die Seiten geladen? Sind sie langsam? Sind die Designs durcheinander?

- Funktionieren alle Tasten?

- Funktioniert die Umsatzverfolgung?

- Haben Sie überprüft, ob die Seite auf mehreren Geräten funktioniert?

- Haben Sie Fehlerberichte eingerichtet, wenn etwas kaputt geht?

Dies alles ist es wert, überprüft zu werden, BEVOR Sie beginnen, Traffic zu einer Kampagne zu leiten.

Holen Sie sich unsere Qualitätssicherungs-Checkliste für A/B-Tests. Es ist ein ausfüllbares PDF, zu dem Sie jedes Mal zurückkehren möchten, wenn Sie einen Test der Qualitätskontrolle unterziehen.

#6. Funktioniert die neue Behandlung/Variante?

Haben Sie auch Ihre neue Variante durchgesehen und getestet, bevor Sie einen Test durchführen?

Dies mag ein übersehener Teil des QA-Tests sein, aber Kampagnen können oft mit defekten Schaltflächen, alten Links und mehr ausgeführt werden. Erst prüfen, dann testen.

#7. Nicht einer Hypothese folgen und einfach irgendein altes Ding testen

Manche Leute testen einfach alles, ohne es wirklich durchdacht zu haben.

Sie haben eine Idee für eine Änderung und wollen sie testen, aber ohne wirkliche Analyse, wie die Seite derzeit konvertiert, oder warum die Änderung, die sie testen, einen Unterschied machen könnte. (Es könnte sein, dass sie die Conversion senken, es aber nicht einmal wissen, da sie noch kein Basisergebnis verfolgt haben).

Das Aufstellen einer Hypothese darüber, wo ein Problem liegt, was es verursacht und wie Sie es lösen können, wird einen großen Unterschied für Ihr Testprogramm machen.

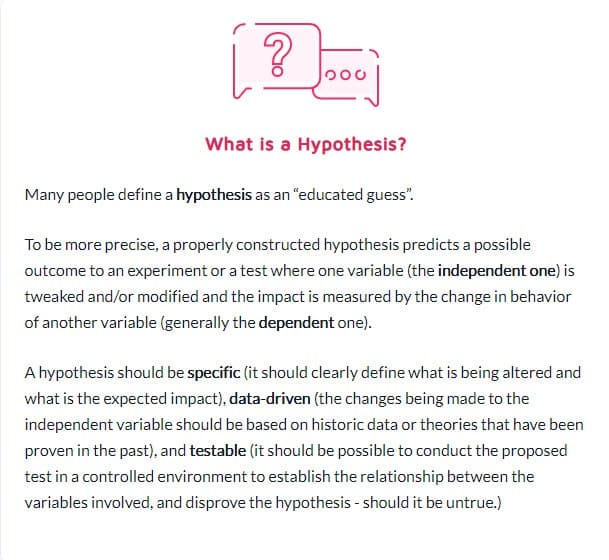

#8. Eine nicht überprüfbare Hypothese haben

Nicht jede Hypothese ist richtig. Das ist in Ordnung. Tatsächlich bedeutet das Wort wörtlich „Ich habe eine Idee, die auf X-Informationen basiert, und ich denke, Y könnte unter Z-Umständen passieren“.

Aber Sie brauchen eine Hypothese, die testbar ist, was bedeutet, dass sie durch Tests bewiesen oder widerlegt werden kann. Überprüfbare Hypothesen setzen Innovation in Gang und fördern aktives Experimentieren. Sie könnten entweder zum Erfolg führen (in diesem Fall war Ihre Vermutung richtig) oder zum Scheitern – was zeigt, dass Sie sich die ganze Zeit geirrt haben. Aber sie werden dir Einblicke geben. Es kann bedeuten, dass Ihr Test besser ausgeführt werden muss, Ihre Daten falsch waren/falsch gelesen wurden oder Sie etwas gefunden haben, das nicht funktioniert hat, was oft einen Einblick in einen neuen Test gibt, der viel besser funktionieren könnte.

#9. Setzen Sie sich im Voraus kein klares Ziel für Ihren Test

Sobald Sie eine Hypothese haben, können Sie diese verwenden, um sie an einem bestimmten Ergebnis auszurichten, das Sie erreichen möchten.

Manchmal führen Leute einfach eine Kampagne durch und sehen, was sich ändert, aber Sie werden definitiv mehr Leads/Conversions oder Verkäufe erhalten, wenn Sie sich darüber im Klaren sind, bei welchem spezifischen Element Sie eine Steigerung sehen möchten.

(Dies hindert Sie auch daran, einen Rückgang eines wichtigen Elements zu sehen, den Test jedoch als Gewinn zu betrachten, weil er „mehr Anteile erhalten hat“.)

Apropos…

#10. Konzentration auf oberflächliche Metriken

Ihr Test sollte immer mit Guardrail-Metriken oder einem Element verknüpft sein, das sich direkt auf Ihre Verkäufe auswirkt. Wenn es um mehr Leads geht, sollten Sie auf den Dollar genau wissen, was ein Lead wert ist und welchen Wert es hat, diese Conversion-Rate zu erhöhen.

Gleichzeitig sollten Metriken, die nicht mit messbaren Ergebnissen verbunden sind oder diese vorantreiben, in der Regel vermieden werden. Mehr Facebook-Likes bedeuten nicht unbedingt mehr Umsatz. Entfernen Sie diese Social-Share-Buttons und beobachten Sie einfach, wie viele weitere Leads Sie erhalten. Seien Sie vorsichtig mit Eitelkeitsmetriken und denken Sie daran, dass nur weil ein Leck behoben ist, es nicht bedeutet, dass es nicht auch ein anderes an anderer Stelle zu beheben gibt!

Hier ist Ben Labays Liste gängiger Leitplankenmetriken für Experimentierprogramme:

#11. Verwenden Sie nur quantitative Daten, um Testideen zu bilden

Die Verwendung quantitativer Daten zur Ideenfindung ist großartig, aber auch leicht fehlerhaft. Vor allem, wenn die einzigen Daten, die wir verwenden, aus unseren Analysen stammen.

Wieso den?

Wir können aus unseren Daten wissen, dass X Personen nicht geklickt haben, aber wir wissen vielleicht nicht warum.

- Ist die Schaltfläche zu weit unten auf der Seite?

- Ist es unklar?

- Stimmt es mit dem überein, was der Betrachter will?

- Funktioniert es überhaupt?

Die besten Tester hören auch auf ihr Publikum. Sie finden heraus, was sie brauchen, was sie vorantreibt, was sie zurückhält, und nutzen dies dann, um neue Ideen, Tests und schriftliche Texte zu formulieren.

Manchmal werden Ihre Benutzer durch Vertrauensprobleme und Selbstzweifel zurückgehalten. In anderen Fällen sind es Klarheit und gebrochene Formen oder schlechte Designs. Der Schlüssel ist, dass dies Dinge sind, die Ihnen quantitative Daten nicht immer sagen können, also fragen Sie immer Ihr Publikum und nutzen Sie es, um Ihnen bei der Planung zu helfen.

#12. Kopieren Sie Ihre Konkurrenten

Bereit für ein Geheimnis?

Ihre Konkurrenten machen oft nur mit. Sofern sie nicht jemanden haben, der langfristige Steigerungskampagnen durchgeführt hat, versuchen sie möglicherweise nur Dinge, um zu sehen, was funktioniert, manchmal ohne Daten für ihre Ideen zu verwenden.

Und selbst dann funktioniert das, was für sie funktioniert, möglicherweise nicht für Sie. Also ja, verwenden Sie sie als Inspiration, aber beschränken Sie Ihre Testideen nicht nur auf das, was Sie sehen. Sie können sich sogar außerhalb Ihrer Branche inspirieren lassen und sehen, ob dies zu Hypothesen führt.

#13. Nur „Best Practices der Branche“ testen

Nochmals, was für den einen funktioniert, funktioniert nicht immer für den anderen.

Zum Beispiel haben Slider-Bilder normalerweise eine schreckliche Leistung, aber auf einigen Websites können sie tatsächlich mehr Conversions erzielen. Alles testen. Sie haben nichts zu verlieren und alles zu gewinnen.

#14. Konzentrieren Sie sich zuerst auf Aufgaben mit geringer Wirkung, wenn große Belohnungen/niedrig hängende Früchte mit hoher Wirkung verfügbar sind

Wir alle können uns schuldig machen, uns auf die Kleinigkeiten zu konzentrieren. Möglicherweise haben wir eine Seite, die wir verbessern möchten, und testen Layoutdesigns und Bilder und sogar Schaltflächenfarben. (Ich persönlich habe eine Verkaufsseite, die in der 5. Iteration ist.)

Die Sache ist die, dass es wahrscheinlich viel wichtigere Seiten gibt, die Sie gerade testen können.

Priorisieren Sie vor allem die Wirkung:

- Wird sich diese Seite direkt auf den Verkauf auswirken?

- Gibt es andere Seiten im Verkaufsprozess, die massiv unterdurchschnittlich abschneiden?

Wenn ja, konzentrieren Sie sich zuerst auf diese.

Ein Anstieg um 1 % auf einer Verkaufsseite ist großartig, aber ein Anstieg um 20 % auf der Seite, die sie dorthin bringt, könnte viel wichtiger sein. (Vor allem, wenn Sie auf dieser bestimmten Seite den größten Teil Ihres Publikums verlieren.)

Manchmal suchen wir nicht nur nach mehr Auftrieb, sondern wollen stattdessen einen Engpass beheben.

Testen und verbessern Sie zuerst die größte Wirkung, die niedrigsten hängenden Früchte. Das tun Agenturen und deshalb führen sie die gleiche Anzahl von Tests durch wie Inhouse-Teams, aber mit einem höheren ROI. Agenturen erzielen 21 % mehr Siege bei gleichem Testvolumen!

#fünfzehn. Mehrere Dinge gleichzeitig testen und nicht wissen, welche Änderung das Ergebnis verursacht hat

Es ist nichts Falsches daran, radikale Tests durchzuführen, bei denen Sie mehrere Dinge gleichzeitig ändern und eine komplette Seite neu gestalten.

Tatsächlich können diese radikalen Neugestaltungen manchmal den größten Einfluss auf Ihren ROI haben, selbst wenn Sie eine Website mit geringem Traffic haben und besonders wenn Sie ein Plateau haben und scheinbar keinen Auftrieb mehr bekommen können.

Aber bedenken Sie, dass nicht jeder A/B-Test für eine solche radikale Veränderung sein sollte. In 99 % der Fälle testen wir nur eine Änderung einer einzelnen Sache, z

- Neue Schlagzeilen

- Neue Bilder

- Neues Layout mit gleichem Inhalt

- Neue Preise usw.

Der Schlüssel bei der Durchführung eines Einzelelementtests ist jedoch genau das. Beschränken Sie Ihren Test auf die Änderung EINES Elements, damit Sie sehen können, was den Unterschied ausmacht, und daraus lernen können. Zu viele Änderungen und Sie wissen nicht, was funktioniert hat.

#16. Es wird keine ordnungsgemäße Vortestanalyse durchgeführt

Haben Sie genügend Besucher in Ihrer Testgruppe? Lohnt sich der Test überhaupt?

Rechne nach! Stellen Sie sicher, dass Sie genügend Traffic haben, bevor Sie einen Test durchführen – sonst ist es nur Zeit- und Geldverschwendung. Viele Tests scheitern aufgrund von unzureichendem Datenverkehr oder schlechter Empfindlichkeit (oder beidem).

Führen Sie eine Vortestanalyse durch, um die Stichprobengröße und den minimal nachweisbaren Effekt für Ihr Experiment zu bestimmen. Ein A/B-Testing-Signifikanzrechner wie der von Convert gibt Ihnen die Stichprobengröße und den MDE für Ihren Test an, was Ihnen bei der Entscheidung hilft, ob es sich lohnt, ihn durchzuführen. Sie können diese Informationen auch verwenden, um zu bestimmen, wie lange der Test laufen soll und wie wenig Steigerung Sie nicht verpassen möchten, bevor Sie zu dem Schluss kommen, dass ein Test erfolgreich war oder nicht.

#17. Falsche Kennzeichnung der Tests

Ein super einfacher Fehler, aber er passiert. Sie beschriften die Tests falsch und erhalten dann die falschen Ergebnisse. Die Variante gewinnt, aber sie heißt Kontrolle, und dann setzt man den Gewinn nie um und bleibt beim Verlierer!

Immer doppelt prüfen!

#18. Tests mit der falschen URL ausführen

Ein weiterer einfacher Fehler. Entweder wurde die Seiten-URL falsch eingegeben oder der Test läuft zu einer "Testseite", auf der Sie Ihre Änderungen vorgenommen haben, und nicht zur Live-Version.

Es mag für Sie in Ordnung aussehen, aber es wird für Ihr Publikum nicht wirklich geladen.

#19. Hinzufügen beliebiger Anzeigeregeln zu Ihrem Test

Auch hier müssen Sie eine Sache mit Ihrer Behandlung testen und nichts anderes.

Wenn es sich um ein Bild handelt, testen Sie das Bild. Alles andere sollte gleich sein, einschließlich der Tageszeit, zu der die Leute beide Seiten sehen können!

Mit einigen Tools können Sie verschiedene Tageszeiten testen, um zu sehen, wie sich der Datenverkehr in verschiedenen Zeiträumen verhält. Dies ist hilfreich, wenn Sie sehen möchten, wann der beste Traffic auf Ihrer Website ist, aber nicht hilfreich, wenn Seiten nach dem, wer sie sieht, aufgeteilt werden UND unterschiedliche Variationen aufweisen.

Zum Beispiel geht unser eigener Blog-Traffic am Wochenende zurück (wie bei den meisten Business-Blogs).

Stellen Sie sich vor, wir hätten einen Test von Montag bis Mittwoch auf der Kontrollseite durchgeführt und dann den Verkehr von Freitag bis Sonntag auf der Behandlung angezeigt? Es hätte viel weniger Verkehr zum Testen und wahrscheinlich ganz andere Ergebnisse.

#20. Testen Sie den falschen Traffic für Ihr Ziel

Idealerweise möchten Sie bei der Durchführung eines Tests sicherstellen, dass Sie nur ein einzelnes Segment Ihrer Zielgruppe testen. Normalerweise sind es neue organische Besucher, um zu sehen, wie sie beim ersten Mal auf Ihrer Website reagieren.

Manchmal möchten Sie vielleicht wiederkehrende Besucher, E-Mail-Abonnenten oder sogar bezahlten Traffic testen. Der Trick besteht darin, jeweils nur einen von ihnen zu testen, damit Sie eine genaue Darstellung der Leistung dieser Gruppe mit dieser Seite erhalten.

Wählen Sie beim Einrichten Ihres Tests die Zielgruppe aus, mit der Sie arbeiten möchten, und entfernen Sie alle anderen, die das Ergebnis verfälschen könnten, z. B. wiederkehrende Besucher.

#21. Das Versäumnis, wiederkehrende Besucher von einem Test auszuschließen und die Ergebnisse zu verfälschen

Wir nennen dies Probenverschmutzung.

Wenn ein Besucher die Seite Ihrer Website sieht, zurückkehrt und Ihre Variante sieht, wird er im Grunde ganz anders reagieren, als wenn er nur eine davon gesehen hätte.

Sie können verwirrt sein, abprallen oder sogar höher konvertieren, einfach wegen dieser zusätzlichen Interaktionen.

Die Sache ist, dass Ihre Daten dadurch verschmutzt und weniger genau werden. Idealerweise möchten Sie ein Tool verwenden, das randomisiert, welche Seite sie sehen, ihnen dann aber immer dieselbe Version anzeigt, bis der Test vorbei ist.

#22. Entfernen Sie Ihre IPs nicht aus dem Test

Apropos Probenverschmutzung, hier ist eine weitere Möglichkeit, Ihre Daten zu verschmutzen (und es ist sowieso eine gute Praxis für die Analyse).

Stellen Sie sicher, dass Sie und die IP-Adressen Ihrer Mitarbeiter von Ihrem Analyse- und Testtool blockiert werden. Das Letzte, was Sie wollen, ist, dass Sie oder ein Teammitglied auf einer Seite „einchecken“ und in Ihrem Test markiert werden.

#23. Keine Segmentierung der Kontrollgruppenvariationen (Netzwerkeffekt)

Eine weitere Verschmutzungsoption, die selten ist, aber vorkommen kann, insbesondere wenn Sie ein Netzwerk für Ihr Publikum haben.

Hier ist ein Beispiel.

Angenommen, Sie haben eine Plattform, auf der Ihr Publikum kommunizieren kann. Vielleicht eine Facebook-Seite oder ein Kommentarbereich, aber JEDER kann darauf zugreifen.

In dieser Situation kann es vorkommen, dass Personen eine Seite sehen und andere eine Variation, aber alle befinden sich im selben sozialen Netzwerk. Dies kann Ihre Daten tatsächlich verzerren, da sie die Entscheidungen und Interaktionen der anderen mit der Seite beeinflussen können. LinkedIn hat sein Publikum beim Testen neuer Funktionen segmentiert, um Probleme mit Netzwerkeffekten zu vermeiden.

Idealerweise möchten Sie die Kommunikation zwischen den beiden Testgruppen trennen, bis der Test abgeschlossen ist.

#24. Durchführung von Tests während saisonaler Ereignisse oder wichtiger Website-/Plattformereignisse

Sofern Sie nicht für ein saisonales Ereignis testen, möchten Sie niemals eine Testkampagne während der Feiertage oder eines anderen wichtigen Ereignisses durchführen, z. B. eines Sonderangebots oder eines Weltereignisses.

Manchmal kann man nicht anders. Sie haben einen Testlauf und Google implementiert einfach ein neues Kern-Update und spielt mitten in der Kampagne mit Ihren Verkehrsquellen herum *hust*.

Das Beste, was Sie tun können, ist, es einfach erneut auszuführen, nachdem alles abgeklungen ist.

#25. Ignorieren kultureller Unterschiede

Möglicherweise haben Sie ein Ziel für eine Seite, führen aber auch eine globale Kampagne mit mehreren Variationen durch, die in verschiedenen Sprachen und verschiedenen Ländern angezeigt werden.

Dies müssen Sie bei der Durchführung Ihres Tests berücksichtigen. Einige Änderungen können global vorgenommen werden, z. B. eine einfache Layoutänderung oder das Hinzufügen von Vertrauenssignalen usw.

In anderen Fällen müssen Sie kulturelle Unterschiede berücksichtigen. Wie die Leute das Layout sehen, wie sie Bilder und die Avatare auf Ihrer Seite sehen.

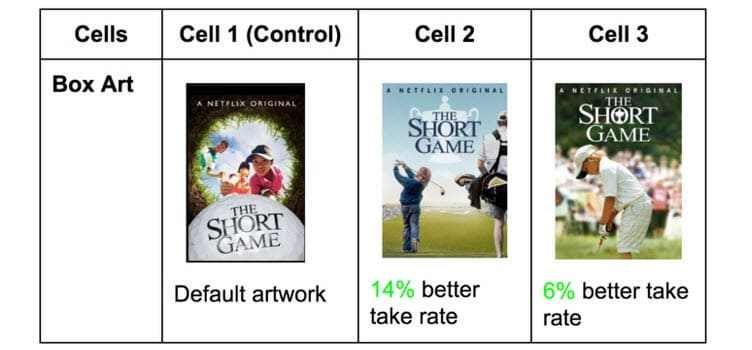

Netflix tut dies mit den Thumbnails all seiner Shows und testet auf verschiedene Elemente, die unterschiedliche Zielgruppen ansprechen können (mit stattdessen bestimmten Schauspielern, die in diesem Land berühmt sind).

Was in einem Land Klicks erzielt, kann in anderen unglaublich unterschiedlich sein. Sie wissen es jedoch nicht, bis Sie testen!

#26. Mehrere verbundene Kampagnen gleichzeitig ausführen

Es ist leicht, aufgeregt zu sein und mehrere Tests gleichzeitig durchführen zu wollen.

Denken Sie daran: Sie können mehrere Tests für ähnliche Punkte im Verkaufsprozess gleichzeitig durchführen, aber führen Sie nicht mehrere Tests für mehrere verbundene Punkte im Trichter durch.

Hier ist, was ich meine.

Sie könnten ganz einfach Tests auf jeder Lead-Generierungsseite, die Sie haben, gleichzeitig durchführen.

Sie möchten jedoch nicht Lead-Seiten, Verkaufsseiten und Checkout-Seiten gleichzeitig testen, da dies so viele verschiedene Elemente in Ihren Testprozess einführen kann, was ein enormes Volumen an Traffic und Konversionen erfordert, um nützliche Erkenntnisse zu erhalten.

Nicht nur das, jedes Element kann auf der nächsten Seite unterschiedliche Auswirkungen haben, sowohl gute als auch schlechte. Wenn Sie nicht Hunderttausende von Besuchern pro Woche haben, werden Sie wahrscheinlich Schwierigkeiten haben, genaue Ergebnisse zu erhalten.

Seien Sie also geduldig und testen Sie jeweils nur eine Stufe oder Seiten, die dabei nicht miteinander verbunden sind.

Randnotiz:

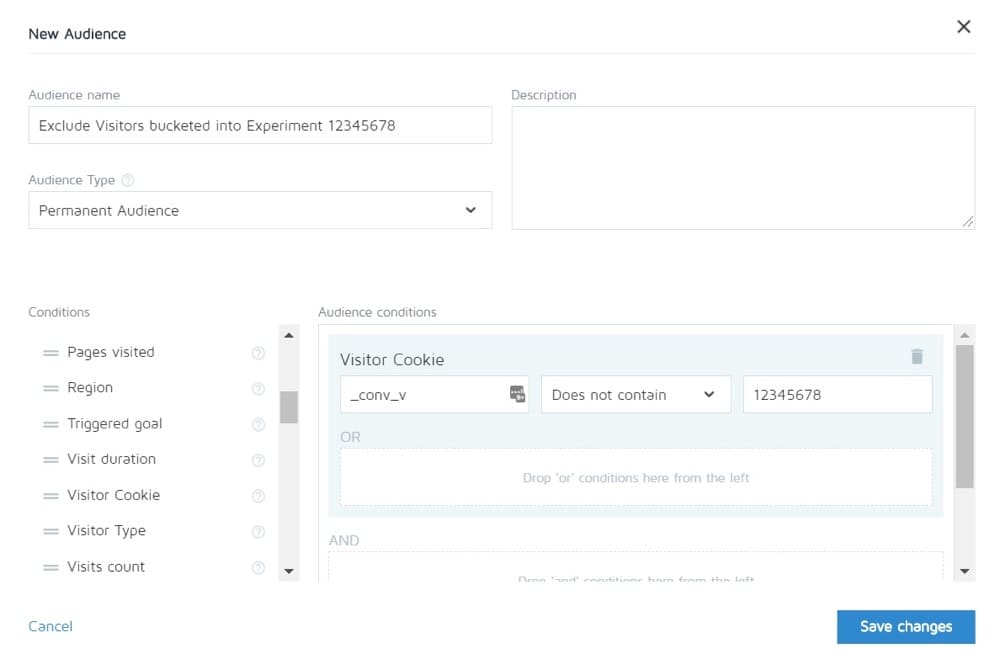

Mit Convert können Sie Personen in einem Experiment davon ausschließen, andere zu sehen. So können Sie theoretisch den kompletten Verkaufszyklus testen und sehen dann nur die Steuerung der anderen Seiten.

#27. Ungleiche Verkehrsgewichtung

Es spielt keine Rolle, ob Sie einen A/B-, einen A/B/n- oder einen multivariaten Test durchführen. Sie müssen jeder Version das gleiche Verkehrsvolumen zuweisen, damit Sie eine genaue Messung erhalten.

Richten Sie sie von Anfang an gleich ein. Die meisten Tools ermöglichen Ihnen dies.

Häufige A/B-Testfehler, die Sie während Ihres Tests machen können

#28. Läuft nicht lange genug, um genaue Ergebnisse zu erhalten

Es gibt 3 wichtige Faktoren, die Sie berücksichtigen müssen, wenn Sie testen und genaue Ergebnisse erhalten möchten:

- Statistische Signifikanz,

- Verkaufszyklus und

- Probengröße.

Also lass es uns aufschlüsseln.

Die meisten Menschen beenden Tests, sobald ihr Testtool ihnen sagt, dass ein Ergebnis besser ist als das andere UND das Ergebnis statistisch signifikant ist, dh wenn der Test weiterhin so abläuft, dann ist dies ein definitiver Gewinner.

Die Sache ist, dass Sie manchmal mit nur wenig Verkehr ziemlich schnell auf „Statistik“ treffen können. Zufällig finden alle Conversions auf einer Seite statt und keine auf der anderen.

Das wird aber nicht immer so bleiben. Es könnte sein, dass der Test gestartet wurde, es Zahltag ist und Sie an diesem Tag eine Menge Verkäufe erzielt haben.

Deshalb müssen wir den Verkaufszyklus berücksichtigen. Verkäufe und Traffic können je nach Wochentag oder Monat schwanken. Um eine genauere Darstellung des Verlaufs Ihres Tests zu erhalten, sollten Sie idealerweise zwischen 2 und 4 Wochen lang laufen.

Schließlich haben Sie die Stichprobengröße.

Wenn Sie Ihren Test einen Monat lang durchführen, werden Sie wahrscheinlich genug Traffic erhalten, um genaue Ergebnisse zu erhalten. Zu wenig und der Test kann Ihnen einfach kein Vertrauensniveau geben, dass er so funktioniert, wie er sollte.

Also als Faustregel,

- Streben Sie eine Vertrauensbewertung von 95 % an.

- Einen Monat laufen.

- Finden Sie im Voraus heraus, welche Stichprobengröße Sie benötigen, und stoppen Sie den Test nicht, bis diese erreicht ist ODER Sie ein erstaunliches Ergebnis erhalten, das ohne den Schatten eines Zweifels beweist, dass Sie einen Gewinner haben.

#29. Hubschrauberüberwachung/Peeking

Peeking ist ein Begriff, der verwendet wird, um zu beschreiben, wann ein Tester einen Blick auf seinen Test wirft, um zu sehen, wie er abschneidet.

Im Idealfall möchten wir unseren Test nie wieder ansehen, sobald er läuft, und wir treffen keine Entscheidung darüber, bis er einen vollständigen Zyklus abgeschlossen hat, mit der richtigen Stichprobengröße und seiner statistischen Signifikanz.

Allerdings… Was ist, wenn der Test nicht läuft?

Was ist, wenn etwas kaputt ist?

Nun, in diesem Fall möchten Sie nicht wirklich einen Monat warten, um zu sehen, dass es kaputt ist, oder? Aus diesem Grund überprüfe ich immer 24 Stunden, nachdem ich ihn gestartet habe, um zu sehen, ob ein Test Ergebnisse in der Kontrolle und Variation liefert.

Wenn ich sehe, dass sie sowohl Traffic erhalten als auch Klicks/Conversions erhalten, dann gehe ich weg und lasse es sein Ding machen. Ich treffe KEINE Entscheidungen, bis der Test seinen Lauf genommen hat.

#30. Benutzerfeedback nicht verfolgen (besonders wichtig, wenn der Test eine direkte, unmittelbare Aktion betrifft)

Nehmen wir an, der Test erhält Klicks und der Traffic verteilt sich, es sieht also so aus, als würde es funktionieren, aber plötzlich erhalten Sie Berichte, dass die Leute das Verkaufsformular nicht ausfüllen können. (Oder noch besser, Sie haben eine automatische Warnung erhalten, dass eine Leitplankenmetrik weit unter ein akzeptables Niveau gefallen ist.)

Nun, dann sollte dein erster Gedanke sein, dass etwas kaputt ist.

Es ist nicht immer. Möglicherweise erhalten Sie Klicks von einer Zielgruppe, die nicht mit Ihrem Angebot übereinstimmt, aber für alle Fälle lohnt es sich, dieses Formular zu überprüfen.

Wenn es kaputt ist, reparieren Sie es und starten Sie es neu.

#31. Änderungen während des Tests vornehmen

Aus diesen letzten paar Punkten war vielleicht klar, aber wir wollen niemals Änderungen an einem Test vornehmen, sobald er live gegangen ist.

Sicher, etwas kann kaputt gehen, aber das ist die einzige Änderung, die wir jemals vornehmen sollten. Wir ändern nicht das Design oder kopieren oder irgendetwas.

Wenn der Test funktioniert, lassen Sie ihn laufen und lassen Sie die Daten entscheiden, was funktioniert.

#32. Ändern der Verkehrszuweisung % mitten im Test oder Entfernen von schlechten Leistungen

Genauso wie wir die getesteten Seiten nicht ändern, entfernen wir auch keine Variationen oder ändern die Traffic-Verteilung während des Tests.

Wieso den?

Angenommen, Sie führen einen A/B/n-Test mit einer Kontrolle und drei Variationen durch. Sie beginnen den Test und nach einer Woche werfen Sie einen ungezogenen Blick darauf und stellen fest, dass 2 Versionen großartig und eine schlecht abschneiden.

Jetzt wäre es verlockend, die „verlierende“ Variante auszuschalten und den Datenverkehr auf die anderen Varianten umzuverteilen, richtig? Verdammt… Sie möchten vielleicht sogar diese zusätzlichen 25 % des Verkehrs nehmen und sie einfach an den Top-Performer senden, aber tun Sie es nicht.

Wieso den?

Diese Umverteilung wirkt sich nicht nur auf die Testleistung aus, sondern kann sich auch direkt auf die Ergebnisse und deren Darstellung im Berichtstool auswirken.

Alle Benutzer, die zuvor der entfernten Variante zugewiesen wurden, müssen einer Variante neu zugewiesen werden und sehen in kurzer Zeit eine geänderte Webseite, die sich auf ihr Verhalten und nachfolgende Entscheidungen auswirken könnte.

Aus diesem Grund ändern Sie nie den Verkehr oder schalten Variationen mittendrin aus. (Und auch, warum Sie nicht gucken sollten!)

#33. Einen Test nicht abbrechen, wenn Sie genaue Ergebnisse haben

Manchmal hat man einfach vergessen, einen Test abzubrechen!

Es läuft weiter und führt 50 % Ihres Publikums zu einer schwächeren Seite und 50 % zum Gewinner. Hoppla!

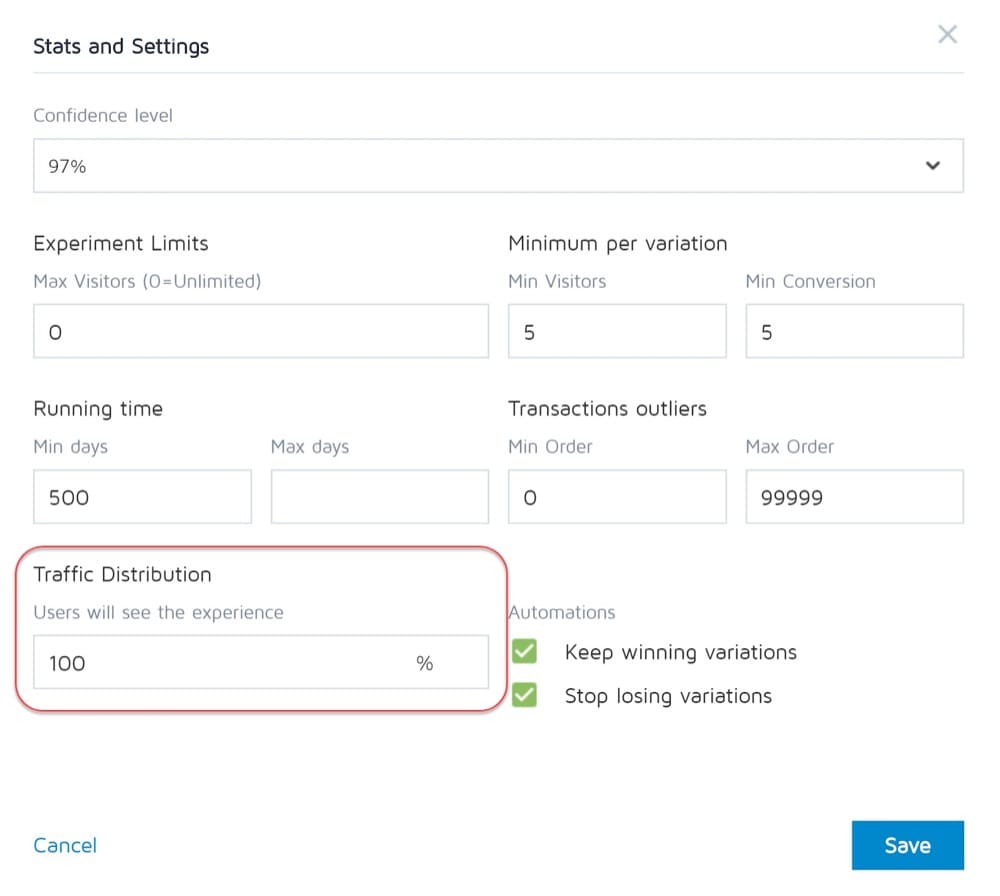

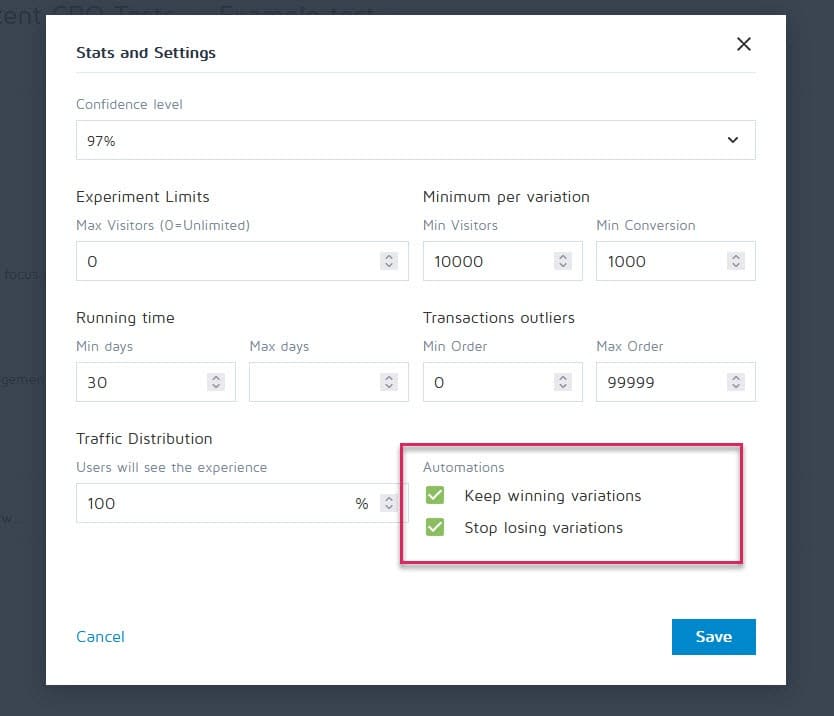

Glücklicherweise können Tools wie Convert Experiences eingerichtet werden, um eine Kampagne zu stoppen und automatisch den Gewinner anzuzeigen, sobald sie bestimmte Kriterien (wie Stichprobengröße, Statistik, Conversions und Zeitrahmen) erfüllt.

#34. Emotional in das Verlieren von Variationen investiert sein

Als Tester müssen wir unparteiisch sein. Manchmal haben Sie jedoch vielleicht ein bestimmtes Design oder eine bestimmte Idee, die Sie einfach lieben und davon überzeugt sind, dass es hätte gewinnen sollen, also verlängern Sie den Test immer länger, um zu sehen, ob es sich durchsetzt.

Ziehe das Pflaster ab.

Möglicherweise haben Sie eine gute Idee, die nur verbessert werden muss, aber Sie können dies erst tun, wenn Sie den aktuellen Test beendet haben.

#35. Laufende Tests zu lange und Tracking bricht ab

Hier ist ein weiteres potenzielles Problem der Probenverschmutzung.

Wenn Sie einen Test länger als 4 Wochen durchführen, besteht die Möglichkeit, dass die Cookies der Benutzer gelöscht werden. Dies kann dazu führen, dass Ereignisse nicht nachverfolgt werden, aber sie können sogar zurückkehren und die Beispieldaten erneut verunreinigen.

#36. Verwenden Sie kein Tool, mit dem Sie den Test stoppen/durchführen können!

Eine weitere seltene Ausgabe.

Einige Testprogramme bestehen darauf, hartcodierte Tests zu erstellen. dh ein Entwickler und Ingenieur erstellen die Kampagne von Grund auf neu.

Es ist jedoch nicht großartig, wenn der Test vorbei ist und Sie warten müssen, bis derselbe Entwickler ihn abschaltet und die Gewinnervariante installiert. Das ist nicht nur frustrierend, sondern kann auch die Anzahl der Tests, die Sie ausführen können, und sogar den ROI der Seite ernsthaft verlangsamen, während Sie darauf warten, dass sie live geht.

Häufige A/B-Testfehler, die Sie nach Abschluss Ihres Tests machen können

#37. Nach einem Test aufgeben!

9 von 10 Tests sind normalerweise fehlgeschlagen.

Das bedeutet, dass Sie 10 Tests durchführen müssen, um diesen Gewinner zu erhalten. Es ist anstrengend, aber es lohnt sich immer, also hören Sie nicht nach einer Kampagne auf!

#38. Eine gute Hypothese aufgeben, bevor Sie alle Versionen davon getestet haben

Ein Fehler kann einfach bedeuten, dass Ihre Hypothese richtig ist, aber besser ausgeführt werden muss.

Probieren Sie neue Wege, neue Designs, neues Layout, neue Bilder, neue Avatare, neue Sprache aus. Sie haben die Idee und sehen, ob Sie sie besser umsetzen können.

Es dauerte 21 CXL-Iterationen, um die Seite ihres Kunden zu verbessern, aber es brachte sie von einer Conversion-Rate von 12,1 % auf 79,3 %.

#39. Erwarten Sie die ganze Zeit riesige Gewinne

Tatsache ist, dass Sie möglicherweise nur in 1 von 10 oder mehr erfolgreichen Kampagnen einen großen Gewinn erzielen.

Das ist in Ordnung. Wir testen weiter und verbessern uns ständig, denn selbst eine 1%ige Steigerung der Verbindungen im Laufe der Zeit. Verbessern Sie es und bringen Sie es auf 2% und Sie haben jetzt die Wirksamkeit verdoppelt.

Welche Testarten liefern die besten Ergebnisse?

Die Wahrheit ist, dass verschiedene Experimente unterschiedliche Auswirkungen haben. Laut der Recherche von Jakub Linowski aus über 300 Tests führen Layout-Experimente tendenziell zu besseren Ergebnissen.

Welcher Bildschirmtyp ist am schwierigsten zu optimieren? Die gleiche Untersuchung zeigt seine Checkout-Bildschirme (mit einem mittleren Effekt von +0,4 % aus 25 Tests).

#40. Validität nach dem Test nicht prüfen

Der Test ist also beendet. Sie sind lange genug gelaufen, haben Ergebnisse gesehen und Statistiksignale erhalten, aber können Sie der Genauigkeit der Daten vertrauen?

Es könnte sein, dass während des Tests etwas kaputt gegangen ist. Kontrollieren schadet nie.

#41. Ergebnisse nicht richtig lesen

Was sagen Ihnen Ihre Ergebnisse wirklich? Wenn Sie sie nicht richtig lesen, kann dies leicht einen potenziellen Gewinner nehmen und wie ein kompletter Fehlschlag erscheinen.

- Tauchen Sie tief in Ihre Analysen ein.

- Sehen Sie sich alle qualitativen Daten an, die Sie haben.

Was hat funktioniert und was nicht? Warum ist es passiert?

Je mehr Sie Ihre Ergebnisse verstehen, desto besser.

#42. Betrachten Sie die Ergebnisse nicht nach Segmenten

Es lohnt sich immer, etwas tiefer zu tauchen.

Zum Beispiel könnte eine neue Variante scheinbar schlecht konvertieren, aber auf Mobilgeräten hat sie eine 40%ige Steigerung der Conversions!

Sie können das nur herausfinden, indem Sie es in Ihre Ergebnisse segmentieren. Schauen Sie sich die verwendeten Geräte und die Ergebnisse dort an. Vielleicht finden Sie wertvolle Erkenntnisse!

Seien Sie sich nur der Bedeutung Ihrer Segmentgröße bewusst. Möglicherweise hatten Sie nicht genug Traffic für jedes Segment, um ihm voll zu vertrauen, aber Sie können jederzeit einen Test nur für Mobilgeräte (oder welchen Kanal es auch immer war) durchführen und sehen, wie es abschneidet.

#43. Nicht aus Ergebnissen lernen

Das Verlieren von Tests kann Ihnen einen Einblick geben, wo Sie sich weiter verbessern oder mehr recherchieren müssen. Das Ärgerlichste als CRO ist es, Kunden zu sehen, die sich weigern, aus dem zu lernen, was sie gerade gesehen haben. Sie haben die Daten, nutzen sie aber nicht…

#44. Die Verlierer nehmen

Oder noch schlimmer, sie nehmen die verlierende Variante.

Vielleicht bevorzugen sie das Design und die Conversion-Rate unterscheidet sich nur um 1 %, aber im Laufe der Zeit verstärken sich diese Effekte. Holen Sie sich diese kleinen Gewinne!

#45. Nicht auf die Ergebnisse reagieren

Schon wieder schlimmer?

Gewinnen, aber nicht umsetzen! Sie haben die Daten und tun einfach nichts damit. Keine Veränderung, keine Einsicht und keine neuen Tests.

#46. Nicht Iterieren und Verbessern von Gewinnen

Manchmal können Sie mitfahren, aber es gibt noch mehr zu tun. Wie wir bereits gesagt haben, ist es sehr selten, dass Ihnen jeder Gewinn einen zweistelligen Auftrieb verschafft.

Aber das bedeutet nicht, dass Sie nicht dorthin gelangen können, indem Sie neue Iterationen und Verbesserungen durchführen und sich jeweils um 1 % nach oben kratzen.

Es summiert sich alles, also verbessern Sie sich weiter!

#47. Gewinnende Erkenntnisse nicht in anderen Bereichen oder Abteilungen teilen

Eines der größten Dinge, die wir bei überaus erfolgreichen/reifen CRO-Teams sehen, ist, dass sie ihre Gewinne und Erkenntnisse mit anderen Abteilungen im Unternehmen teilen.

Dies gibt anderen Abteilungen Einblicke, wie sie sich ebenfalls verbessern können.

- Finden Sie eine erfolgreiche Kopie der Verkaufsseite? Rahmen Sie es in Ihren Anzeigen vor, die sie auf die Seite bringen!

- Finden Sie einen Bleimagneten, der großartig funktioniert? Testen Sie es auf der gesamten Website.

#48. Testen Sie diese Änderungen nicht in anderen Abteilungen

Und das ist hier der Schlüssel. Auch wenn Sie Erkenntnisse mit anderen Abteilungen teilen, sollten Sie trotzdem testen, wie es funktioniert.

Ein Stildesign, das in einem Bereich Auftrieb verleiht, kann in anderen nachlassen, also immer testen!

#49. Zu viele Iterationen auf einer einzelnen Seite

Wir nennen dies das Erreichen des „lokalen Maximums“.

Die Seite, auf der Sie Tests durchführen, hat ein Plateau erreicht und Sie können einfach keinen Auftrieb mehr daraus ziehen.

Sie können radikale Neugestaltungen ausprobieren, aber wie geht es weiter?

Wechseln Sie einfach auf eine andere Seite im Verkaufsprozess und verbessern Sie diese. (Ironischerweise kann dies ohnehin zu einem höheren ROI führen.)

Eine Verkaufsseite von 10 % auf 11 % Conversion zu bringen, kann weniger wichtig sein, als die Seite, die den Traffic zu ihr führt, von 2 % auf 5 % zu bringen, da Sie den Traffic auf dieser vorherigen Seite im Wesentlichen mehr als verdoppeln werden.

Suchen Sie im Zweifelsfall den nächstwichtigsten Test auf Ihrer Liste und verbessern Sie sich dort. Sie werden vielleicht sogar feststellen, dass es ohnehin zu einer Conversion auf dieser festgefahrenen Seite beiträgt, indem Sie ihr einfach bessere Interessenten zuführen.

#50. Nicht genug testen!

Tests brauchen Zeit und wir können nur so viele gleichzeitig ausführen.

Also was können wir tun?

Reduzieren Sie einfach die Ausfallzeit zwischen den Tests!

Führen Sie einen Test durch, analysieren Sie das Ergebnis und wiederholen Sie den Test oder führen Sie einen anderen Test aus. (Idealerweise stehen sie in einer Warteschlange und sind bereit zu gehen).

Auf diese Weise sehen Sie eine viel höhere Rendite für Ihre investierte Zeit.

#51. Tests nicht dokumentieren

Eine weitere Gewohnheit, die ausgereifte CRO-Teams haben, ist das Erstellen einer internen Datenbank mit Tests, die Daten über die Seite, die Hypothese, was funktioniert hat, was nicht funktioniert hat, die Steigerung usw. enthält.

Sie können dann nicht nur aus älteren Tests lernen, sondern auch verhindern, dass Sie einen Test versehentlich wiederholen.

#52. Vergessen Sie Fehlalarme und überprüfen Sie große Werbekampagnen nicht doppelt

Manchmal ist ein Ergebnis einfach zu schön, um wahr zu sein. Entweder wurde etwas falsch eingestellt oder aufgezeichnet, oder dies ist zufällig der 1 von 20 Tests, der ein falsches Positiv ergibt.

Also, was kannst du machen?

Führen Sie den Test einfach erneut aus, stellen Sie ein hohes Konfidenzniveau ein und stellen Sie sicher, dass Sie ihn lange genug ausführen.

#53. Downline-Ergebnisse werden nicht verfolgt

Wenn Sie Ihre Testergebnisse verfolgen, ist es auch wichtig, sich an Ihr Endziel zu erinnern und Downline-Metriken zu verfolgen, bevor Sie sich für einen Gewinner entscheiden.

Eine neue Variante könnte technisch gesehen weniger Klicks erzielen, aber mehr Verkäufe von den Leuten erzielen, die klicken.

In diesem Fall wäre es tatsächlich rentabler, diese Seite zu betreiben, vorausgesetzt, der Verkehr, der auf Klicks klickt, wird auch weiterhin konvertiert …

#54. Nichtberücksichtigung von Vorrang- und Neuheitseffekten, die die Behandlungsergebnisse verfälschen können

Angenommen, Sie zielen mit einer Änderung nicht nur auf neue Besucher ab, sondern auf den gesamten Datenverkehr.

Wir segmentieren sie immer noch, sodass 50 % das Original und 50 % die neue Version sehen, aber wir lassen frühere Besucher an der Kampagne teilnehmen. Das bedeutet Personen, die Ihre Website schon einmal gesehen, Ihre Inhalte gelesen, Ihre Handlungsaufforderungen gesehen haben usw.

Außerdem sehen sie für die Dauer der Kampagne nur ihre spezifische Testversion.

Wenn Sie eine neue Änderung vornehmen, kann dies tatsächlich einen neuen Effekt auf Ihr bisheriges Publikum haben.

Vielleicht sehen sie die ganze Zeit denselben CTA und ignorieren ihn jetzt einfach, oder? In diesem Fall kann eine neue CTA-Schaltfläche oder ein neues Design bei früheren Besuchern tatsächlich Anklang finden, nicht weil sie es jetzt mehr wollen, sondern weil es neu und interessant ist.

Manchmal erhalten Sie sogar mehr Klicks, weil sich das Layout geändert hat und sie das Design erkunden.

Aus diesem Grund erhalten Sie normalerweise einen anfänglichen Auftrieb als Reaktion, der jedoch mit der Zeit wieder abklingt.

Der Schlüssel bei der Durchführung Ihres Tests besteht darin, das Publikum danach zu segmentieren und zu sehen, ob die neuen Besucher genauso gut reagieren wie die alten.

Wenn es viel niedriger ist, könnte es sich um einen Neuheitseffekt handeln, bei dem die alten Benutzer herumklicken. Wenn es auf einem ähnlichen Niveau ist, haben Sie vielleicht einen neuen Gewinner in der Hand.

Lassen Sie es in jedem Fall für den gesamten Zyklus laufen und balancieren Sie es aus.

#55. Laufender Betrachtungszeitraum ändert sich

Eine weitere Sache, die beim Testen berücksichtigt werden sollte, ist jede Variante, die den Betrachtungszeitraum des Publikums verändern könnte.

Was meine ich?

Nehmen wir an, Sie erzielen normalerweise keine sofortigen Verkäufe. Leads können sich in einem 30-tägigen oder noch längeren Verkaufszyklus befinden.

Wenn Sie einen Call-to-Action testen, der sich direkt auf die Bedenk- und Kaufzeit auswirkt, wird das Ihre Ergebnisse verfälschen. Zum einen könnte Ihre Kontrolle Verkäufe erzielen, aber außerhalb des Testzeitraums liegen, sodass Sie sie verpassen.

Ein anderes Szenario ist, wenn Sie einen CTA haben, der einen Deal anbietet, einen Preispunkt von irgendetwas anderem, der sie dazu bringt, jetzt Maßnahmen zu ergreifen, dann wird dies Ihre Ergebnisse fast immer verzerren, sodass diese Version so aussieht, als würde sie viel besser konvertieren.

Denken Sie daran und überprüfen Sie Ihre Analysen während und nach dem Test, um sicherzugehen.

#56. Kein erneutes Testen nach X-Zeit

Dabei geht es weniger um einen bestimmten Seiten- oder Testfehler, sondern mehr um die Testphilosophie.

Ja, Sie haben vielleicht eine tolle Seite, und ja, Sie haben vielleicht 20 Iterationen daran gemacht, um sie dahin zu bringen, wo sie heute ist.

Die Sache ist die, dass Sie in ein paar Jahren möglicherweise die gesamte Seite erneut überarbeiten müssen. Umgebungen ändern sich, Sprache und verwendete Begriffe, das Produkt kann optimiert werden.

Seien Sie immer bereit, zu einer alten Kampagne zurückzukehren und erneut zu testen. (Ein weiterer Grund, warum ein Test-Repository großartig funktioniert.)

#57. Testen Sie nur den Pfad und nicht das Produkt

Fast alle von uns konzentrieren sich auf den Weg zum Verkauf und testen dafür. Aber die Realität ist, dass das Produkt auch A/B-getestet und verbessert werden kann und sogar einen höheren Auftrieb bieten kann.

Denken Sie an das iPhone.

Apple hat seine Website getestet und verbessert, aber es sind die Produktiterationen und -verbesserungen, die weiterhin für noch mehr Auftrieb sorgen.

Jetzt haben Sie vielleicht kein physisches Produkt. Sie haben vielleicht ein Programm oder digitales Angebot, aber mehr über die Bedürfnisse Ihres Publikums zu erfahren und es zu testen und es dann zurück auf Ihre Verkaufsseite zu bringen, kann in Bezug auf die Steigerung RIESIG sein.

Fazit

Da haben Sie es also. Die 57 häufigen und ungewöhnlichen A/B-Testfehler, die wir sehen, und wie Sie sie vermeiden können.

Sie können diesen Leitfaden verwenden, um diese Probleme für alle zukünftigen Kampagnen zu umgehen.