26 Beispiele für A/B-Tests als Inspiration für Ihren nächsten Test

Veröffentlicht: 2022-02-01

Auf Ihrer Reise in das A/B-Testen sind Sie wahrscheinlich diesem beliebten Zitat von Jeff Bezos aus dem Jahr 2004 begegnet:

Wenn Sie die Anzahl der Experimente pro Jahr verdoppeln, verdoppeln Sie Ihren Erfindungsreichtum.

Das ist alles schön und gut, aber was ist, wenn Sie nicht wissen, was Sie testen sollen?

Sie wissen, dass A/B-Tests Erkenntnisse liefern, die sich in Geschäftswachstum niederschlagen und neue Rekorde bei der Umsatzgenerierung aufstellen können, aber das Problem ist, wenn Sie sich hinsetzen, um etwas auf Ihrer Website, Zielseite, E-Mail usw. zu testen, und leer ausgehen.

Wo liegt die Chance zur Optimierung?

Zum Glück können Sie Hinweise von jemand anderem erhalten. Es gibt Beispiele für A/B-Tests im Marketing, die erfolgreich waren und Unternehmen dabei geholfen haben, ihre Konversionsraten zu steigern.

Diese Beispiele können ein Sprungbrett für Ihre eigene Reise zur Conversion-Rate-Optimierung sein – etwas, um einen Gedankengang auszulösen, der Sie Ihrer Erfolgshypothese näher bringt.

Ich habe tief gegraben und die besten herausgeholt, sortiert nach dem, was für Sie relevant ist; nach Branche oder Kanal. Sie erhalten Informationen darüber, die Ihnen helfen, A/B-Testmuster zu erkennen, um Ihnen Testideen zu geben und Ihre eigene Erfolgsgeschichte zu inspirieren.

- So extrahieren Sie maximale Erkenntnisse aus einem A/B-Testbeispiel

- Beispiele für A/B-Tests, von denen Sie lernen und die Sie für Ihre eigenen Tests inspirieren können

- Beispiele für B2B-A/B-Tests

- Csek Creative: Homepage-Slogan-Test

- Highrise: Schlagzeilen der Anmeldeseite

- Techinsurance.com: Zielseitenkonvertierung

- DTC A/B-Testbeispiele

- NuFace: Anreiztest

- Handgefertigte Luxusglasmarke: Rentabilität des kostenlosen Versands

- Vancouver 2010 Olympic Store: Einzelne Seite vs. mehrstufiger Checkout

- E-Commerce-A/B-Testbeispiele

- Lampenlicht.nl: Technische Daten unter Produktbilder

- Online-Pflegegeschäft: Kaufberatung anbieten

- Schaltflächentext: In den Warenkorb oder in den Warenkorb

- NGO-A/B-Testbeispiele

- Kiva.org: Above the Fold of Donation Landing Page

- John C. Cook: Text vs. Video

- Beispiele für SaaS-A/B-Tests

- Earth Class Mail: Zielseitenoptimierung

- HubSpot: Website-Suchfunktion

- Netflix: Vorgestelltes Video-Artwork

- A/B-Testing-Landingpage

- Humana: Zielseitenbanner

- Brookdale Living: Visuelle Elemente

- Position des Zielseitenformulars

- E-Mail-Beispiele für A/B-Tests

- Designhill.com: Stil der E-Mail-Überschrift

- E-Mail-Überschrift „Frohe Weihnachten“ vs. „Frohe Feiertage“.

- Microsoft: E-Mail-Farbschema

- PPC-Beispiele für A/B-Tests

- Adspresso: Facebook-Anzeigentext

- Sony: Personalisierte Bannerwerbung

- PPC-Anzeige: CTA-Kopie

- Shopify-Beispiele für A/B-Tests

- Oflara: Mega-Menü

- BattlBox: Personalisierte E-Commerce-Content-Marketing-Strategie

- Sternebewertungen vs. keine Sternebewertungen

- Beispiele für B2B-A/B-Tests

- Fazit

So extrahieren Sie maximale Erkenntnisse aus einem A/B-Testbeispiel

Bevor wir beginnen, lassen Sie uns die richtigen Erwartungen in Bezug auf A/B-Testbeispiele setzen und wie man sie richtig verwendet.

Es ist einfach zu überprüfen, was Ihr Konkurrent oder jemand anderes tut, und sich zu denken: „Weißt du was? Ich werde genau das tun und sehen, was passiert.“

Die Chancen stehen gut, dass das für Sie nicht funktionieren wird. Am Ende verschwenden Sie Ressourcen, indem Sie etwas testen, das nicht mit Ihrem einzigartigen Geschäftsmodell, Ihrer Zielgruppe und Ihrer Marke funktioniert.

Stattdessen lassen Sie sich von dem inspirieren, was sie tun – nicht nur von ihren erfolgreichen Tests, sondern auch von denen, die verloren haben.

Aber wenn wir ehrlich sind, hört man kaum Geschichten über fehlgeschlagene Tests, auch wenn sie voller Erkenntnisse sind. Zumindest hat der Tester gelernt, was nicht funktioniert.

Lassen Sie sich von diesen Beispielen inspirieren und verwenden Sie Elemente der getesteten Lösung, um Ihre Hypothese zu entwickeln (sofern dies mit der von Ihnen durchgeführten qualitativen und quantitativen Forschung übereinstimmt). Führen Sie dann einen A/B-Test durch, um zu sehen, ob dies Ihre gewünschte Metrik verändert.

Diese Fallstudien zu A/B-Tests sollen Ihnen dabei helfen, über den Tellerrand hinauszublicken und vor allem zu sehen, wie die oft unterschiedlichen Datenpunkte, die Sie durch Ihre Forschung sammeln, mit spezifischen Lösungen verknüpft werden können.

Für sich genommen können sie wie Einzelfälle erscheinen, aber zusammengenommen ergibt es Sinn, warum ein bestimmter Lösungstrend funktioniert. Daraus ergeben sich oft „Best Practices“. Aber wie ich bereits sagte, sollten Sie dies nur an Ihren individuellen Fall anpassen, nicht kopieren und einfügen.

Unabhängig davon, ob die Elemente und Lösungen aus der DTC- oder B2B-Branche stammen oder in einer PPC-Kampagne oder einem E-Mail-Newsletter verwendet wurden, wenn Sie die Steigerungen und Ergebnisse verfolgen, können Sie Muster erkennen . (Dies ist die Grundlage der Arbeit von Jakub Linowski bei GoodUI).

Diese Muster können Ihre nächste große Erkenntnis inspirieren und Ihr Experimentierprogramm zu einem neuen Triumph führen.

Beispiele für A/B-Tests, von denen Sie lernen und die Sie für Ihre eigenen Tests inspirieren können

Alle A/B-Testbeispiele unten sind in verschiedene Kategorien unterteilt, basierend auf den Branchen, in denen sie bedient wurden, und den Kanälen, auf denen sie liefen.

A/B-Testbeispiele nach Branche

Beginnen wir mit ein paar Beispielen aus verschiedenen Branchen und sehen, welche Parallelen wir zwischen ihnen ziehen können.

Beispiele für B2B-A/B-Tests

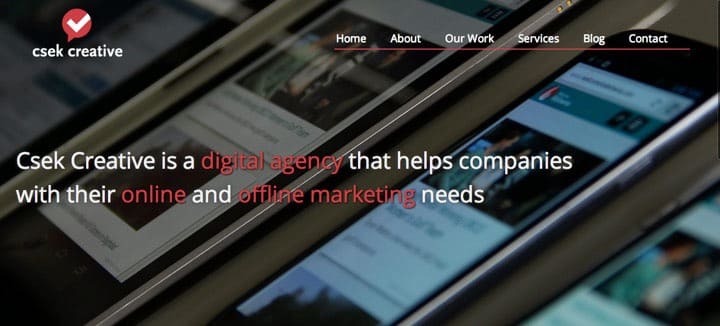

Csek Creative: Homepage-Slogan-Test

Csek ist eine Digitalagentur, deren Homepage-Slogan lautet: „Csek Creative ist eine in Kelowna ansässige Digitalagentur, die Ergebnisse liefert, die geschäftlich sinnvoll sind“.

Wenn Sie etwas Erfahrung mit dem Verfassen von Texten haben, können Sie sofort die Unbestimmtheit dieser Zeile spüren. Es trifft kein unmittelbares Bedürfnis im Kopf des Lesers. Es könnte also der Grund sein, warum die Leute von der Seite abprallten.

Und Csek wollte seine Absprungrate senken. Das Ziel war also zu testen, ob der Slogan der Übeltäter war.

Hypothese: Ändern Sie den Slogan in etwas Erklärenderes und Spezifischeres über die angebotenen Dienste, um zu sehen, ob es eine Verbesserung der Absprungrate und der Klickraten zu anderen Seiten auf der Website geben wird.

Der „B“-Slogan lautete: „Csek Creative ist eine digitale Agentur, die Unternehmen bei ihren Online- und Offline-Marketinganforderungen unterstützt.“

Der aktualisierte Text wurde über 600 Website-Besuchern angezeigt und führte zu einer 8,2-prozentigen Steigerung der Klicks auf andere Seiten auf der Website von Csek.

Was Sie daraus lernen können: Klarheit über Ihr Angebot in den ersten Sekunden nach dem Besuch Ihrer Seite ist entscheidend. Das Online-Publikum hat eine geringe Toleranz gegenüber Mehrdeutigkeiten und möchte keine Kalorien verbrennen, wenn es darum geht, herauszufinden, was Sie tun. Wenn die Absprungraten auf Ihrer Homepage steigen, überprüfen Sie, ob die Leute sofort verstehen können, was Sie tun.

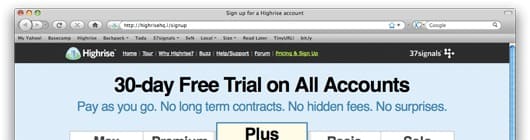

Highrise: Schlagzeilen der Anmeldeseite

Highrise wollte mehr Anmeldungen und beschloss, zu prüfen, wie effektiv verschiedene Überschriften und Untertitel auf die Konversionsrate sein würden. Also entschieden sie sich, einen multivariaten Test für eine Stichprobe von 4000 Seitenaufrufen durchzuführen.

Hypothese: Wenn die Überschrift und die Unterüberschrift geändert werden, um unterschiedliche Vorteile hervorzuheben, wird einer dieser Vorteile eine bessere Leistung erbringen als das Original.

Varianten:

Der Gewinner (derjenige, der 30 % besser abschneidet als das Original) legte Wert auf „kostenlose 30-Tage-Testversion“ und die Anmeldegeschwindigkeit. Und die CTA-Schaltfläche war super einfach: „Wählen Sie einfach einen Plan aus, um loszulegen“.

Was Sie aus diesem multivariaten Test lernen können: Wenn es mehrere Vorteile für Ihr Produkt oder Ihre Dienstleistung gibt, sollten Sie wissen, welchen Sie auf Ihrer Zielseite, Startseite oder Anmeldeseite hervorheben sollten. Testen Sie sie, vielleicht alle gleichzeitig, mit A/B/n-Tests und finden Sie heraus, welcher bei Ihrer Zielgruppe am besten ankommt.

Techinsurance.com: Zielseitenkonvertierung

Techinsurance.com wollte eine höhere Konversionsrate für seine Pay-per-Click-Kampagne. Ursprünglich wurde der gesamte Datenverkehr auf die Homepage ihrer Website geleitet.

Also entschieden sie sich, eine dedizierte Zielseite für die Kampagne zu erstellen, den Verkehr darauf zu lenken und zu sehen, wie sie im Vergleich zur Homepage der Website abschneidet.

Hypothese: Erstellen Sie eine dedizierte Zielseite, leiten Sie den Verkehr dorthin und sie konvertiert besser als die Homepage der Website.

Variante:

Die Zielseite, die für die PPC-Kampagne entworfen wurde, konvertierte 73 % besser als die Homepage der Website.

Was Sie daraus lernen können: Potenzielle Kunden würden nicht lange genug auf Ihrer Website bleiben, um zu sehen, ob Ihre Botschaft sie direkt anspricht. Es muss einen sofortigen Funken von „Oh ja, da ist noch mehr“ geben. Um die Leistung Ihrer Werbekampagnen zu verbessern, testen Sie eine bestimmte Zielseite, die speziell die Zielgruppe anspricht, die Ihre PPC-Anzeigen ansprechen.

DTC A/B-Testbeispiele

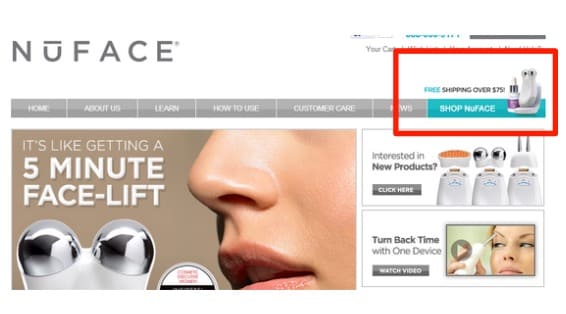

NuFace: Anreiztest

NuFace bietet seinen Kunden Anti-Aging-Hautpflegeprodukte direkt an. Sie stellten fest, dass die Menschen zwar an ihren Produkten interessiert waren, aber nicht viele ihre Einkäufe abschlossen. Und dies entsprach nicht den Zielen von NuFace, den Online-Prozess auszubauen und den Umsatz zu steigern.

Hypothese: Wenn wir Kunden einen Anreiz für kostenlosen Versand anbieten, wenn ihre Bestellung insgesamt 75 $ und mehr beträgt, werden mehr Verkäufe und Auftragsabschlüsse getätigt.

Variante: Sie fanden heraus, dass die Anreize die Leute dazu ermutigten, ihre Bestellungen abzuschließen. Über 90 % mehr Bestellungen wurden abgeschlossen und der Bestellwert um 7,32 % gesteigert.

Was Sie daraus lernen können: Ein versandkostenfreier Anreiz ab einem bestimmten Mindestpreis kann den durchschnittlichen Bestellwert verbessern. Dies ist etwas, das es wert ist, getestet zu werden.

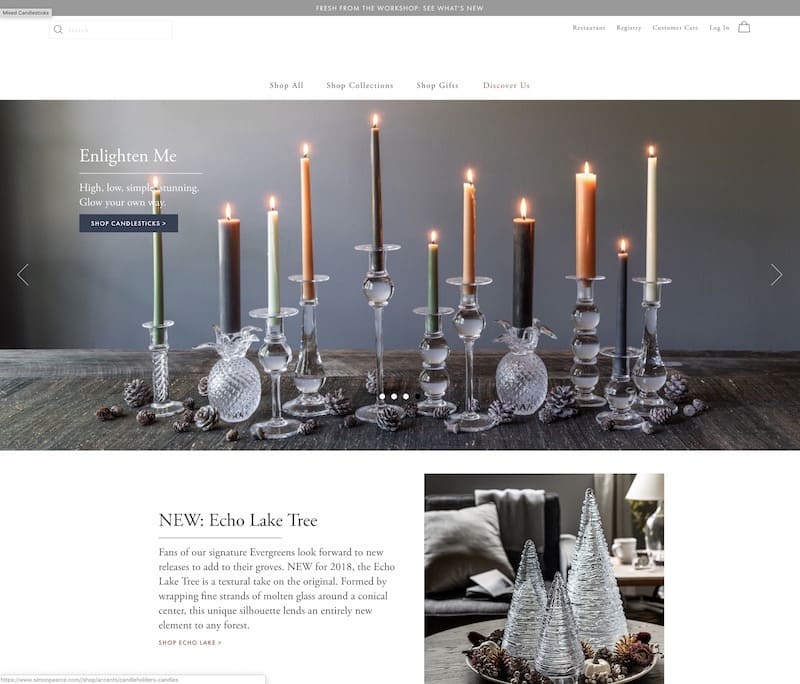

Handgefertigte Luxusglasmarke: Rentabilität des kostenlosen Versands

Wenn Sie Ihren Kunden kostenlosen Versand anbieten, woher wissen Sie, dass Sie mit diesem Angebot noch profitabel sind? Woher wissen Sie, dass Sie mit dem kostenlosen Versandangebot profitabler sind als ohne?

Das wollte diese handgefertigte Luxusglasmarke herausfinden, als sie Brave One engagierten, um zu helfen.

Hypothese: Es ging eher um die Frage: Bringt das Gratisversand-Angebot genug Umsatz, um die Versandkosten auszugleichen und trotzdem Gewinne zu machen?

Variante:

Als die 25.000 Webbesucher 50/50 zwischen der Kontrolle und dem Herausforderer (mit der Werbeleiste für kostenlosen Versand) aufgeteilt wurden und 15 Tage lang liefen, stellten sie fest, dass das Angebot für kostenlosen Versand den Umsatz um 20 % steigerte. Das sind zusätzliche Einnahmen in Höhe von 16.000 US-Dollar.

Was Sie daraus lernen können: Kostenloser Versand verbessert definitiv die Konversionsraten, aber Sie müssen testen, ob er sich langfristig positiv auf Ihr Endergebnis auswirkt. Mit A/B-Tests müssen Sie Ihr Geschäft nie auf Annahmen stützen.

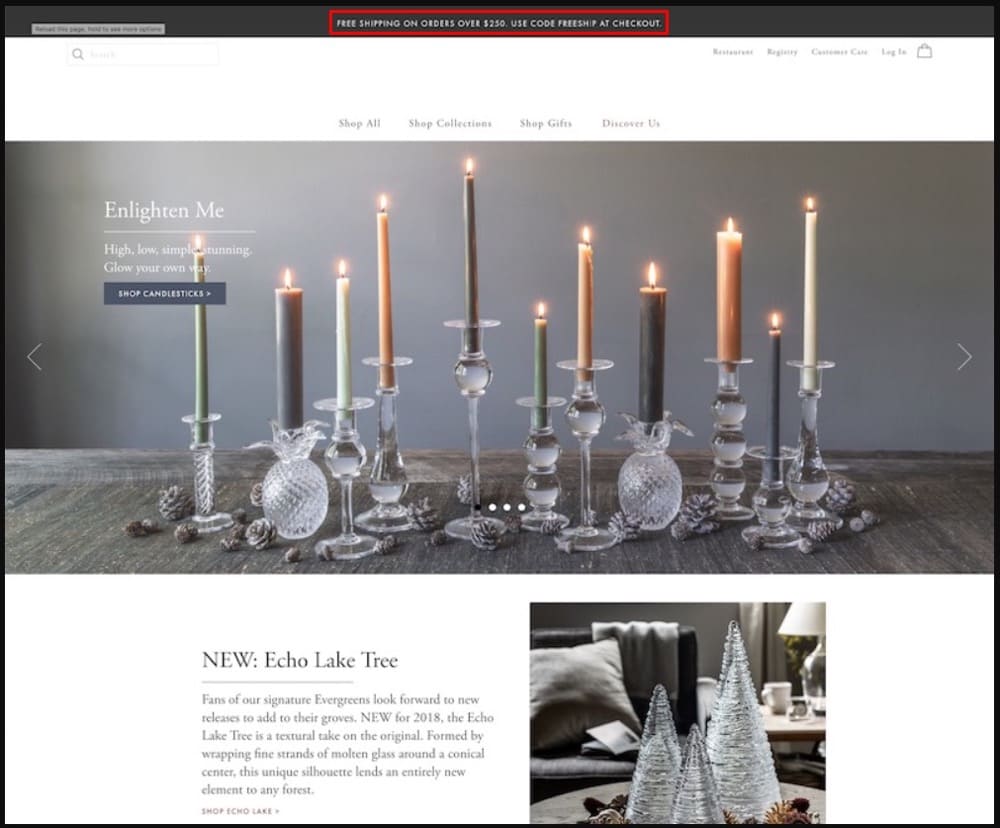

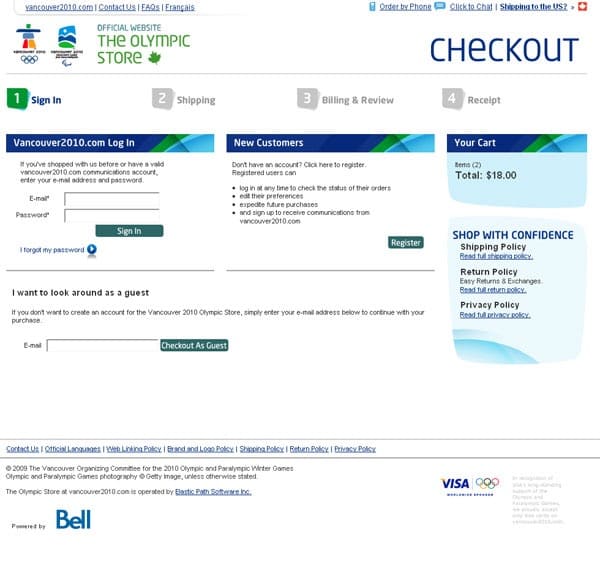

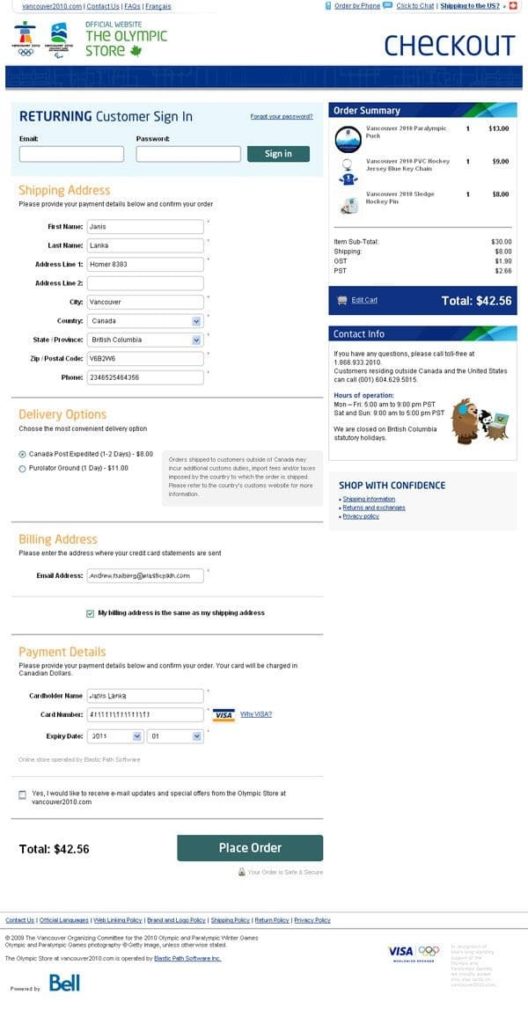

Vancouver 2010 Olympic Store: Einzelne Seite vs. mehrstufiger Checkout

Sollten Sie den Checkout-Prozess auf mehrere Seiten aufteilen oder nur eine Seite für den gesamten Prozess haben? Wie wirkt sich dies auf die Conversion-Raten aus? Diese Frage hat dieser Test für den Official Vancouver Olympic Store beantwortet.

Hypothese: Kombinieren Sie den mehrstufigen Checkout-Prozess auf einer einzigen Seite und es werden mehr Bestellungen abgeschlossen.

Variante: Da 50 % des Traffics auf beide Versionen des Checkout-Prozesses entfielen, reichten 300 Transaktionen aus, um den Gewinner zu ermitteln. Aber sie ließen es bis zu 606 Transaktionen laufen und stellten fest, dass der einseitige Checkout den mehrstufigen Prozess um 21,8 % übertraf.

Was Sie daraus lernen können: Nicht alle Checkout-Prozesse laufen gleich ab. Für diesen Zielmarkt und diese Produktnische zeigen die Testergebnisse, dass die Zielgruppe einen Single-Page-Checkout bevorzugte. Was bevorzugt Ihr Publikum?

E-Commerce-A/B-Testbeispiele

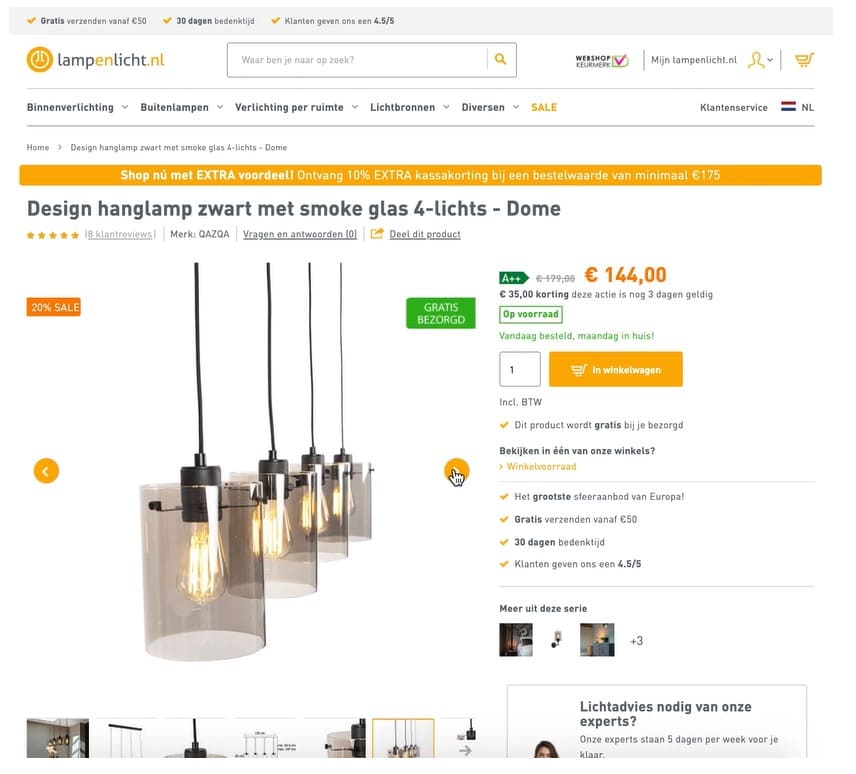

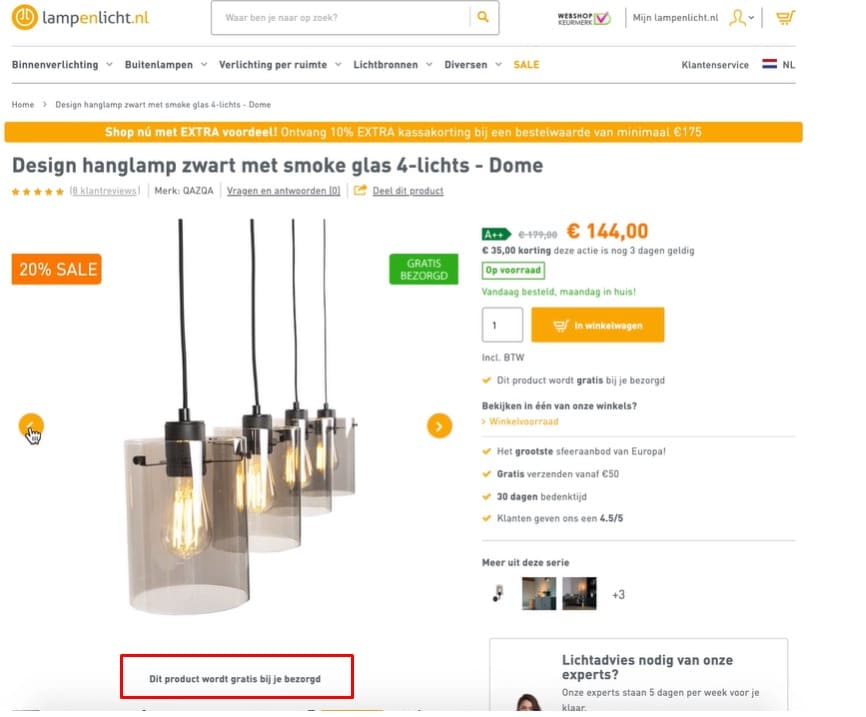

Lampenlicht.nl: Technische Daten unter Produktbilder

Lampenlicht.nl beauftragte Mintminds, die Add-to-Cart-Rate ihrer Produktseiten und den Umsatz pro Besucher zu verbessern.

Also vertiefte sich Mintminds in ihre qualitativen und quantitativen Daten und stellte fest, dass Besucher die Produkte im Online-Shop aus verschiedenen Blickwinkeln sehen wollten und sich nicht wirklich für hochtechnische Spezifikationen interessierten. Auch Alleinstellungsmerkmale wie „auf Lager“ und „schnelle Lieferung“ begeisterten sie.

Sie entwarfen einen Test, der diesen Anforderungen im Vergleich zu den ursprünglichen Produktseiten gerecht wurde.

Hypothese: „Wenn unter jedem Produktbild ab dem zweiten Produktbild (im Karussell) ein wichtiges Produktmerkmal oder Alleinstellungsmerkmal textlich angezeigt wird, dann wird die Anzahl der Transaktionen steigen, da die Informationsbedürfnisse der Käufer an einem Ort besser erfüllt werden, an dem dies der Fall ist schon oft angeschaut.“

Ergebnis: Die Kontrolle und die Variante wurden 28 Tage lang serviert und im Vergleich zur Kontrolle zeigte die Variante:

- 13 % mehr in den Warenkorb legen

- 4,96 % Steigerung der Auftragsumwandlungsrate und

- 6,58 % Umsatzsteigerung pro Besucher

Insgesamt lag der ROI des Tests bei 116 %.

Wichtigste Erkenntnis: Sammeln Sie wertvolle Daten darüber, wie Ihre Besucher Ihre Website nutzen. Sie werden Lecks oder Verstopfungen in Ihrem Conversion-Funnel entdecken. Dies kann Ihnen helfen, Lösungen für das Problem zu testen und einen neuen und besseren Weg zu finden, das zu tun, was Sie bereits tun.

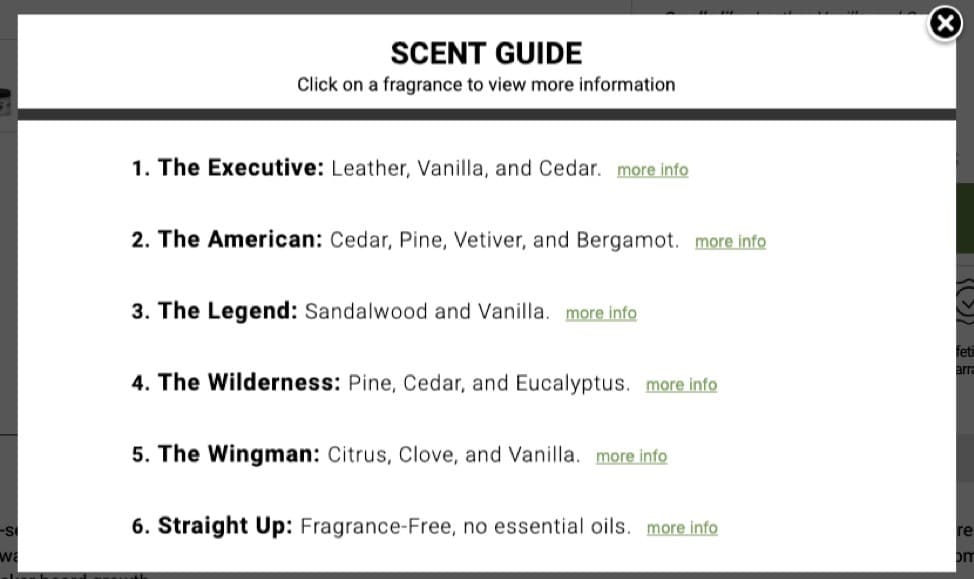

Online-Pflegegeschäft: Kaufberatung anbieten

Ein Online-Pflegegeschäft suchte nach Möglichkeiten, sein Angebot an Düften für Männer zu optimieren. Sie baten Conversion Fanatics um Hilfe, damit sie lernen können, wie sie mehr Menschen davon überzeugen können, ihr Produkt zu kaufen (oder zu abonnieren).

Conversion Fanatics führte eine Umfrage durch, um das Hindernis aufzudecken, und stellte fest, dass die Leute mit dem Kauf zögerten, weil es ihnen schwer fiel, eine Wahl zu treffen.

Hypothese: Menschen bei der Auswahl von Düften zu helfen, wird den Umsatz steigern.

Ergebnis: Als das Geschäft einen Leitfaden präsentierte, der erklärte, wie die Düfte riechen, Anleitungen zur Auswahl eines Dufts gab und sie 2000 Besuchern gleichermaßen zeigte, stellten sie fest, dass der Umsatz pro Besucher um 37 % und die Zahl der abgeschlossenen Produkte um 53 % anstieg Aufträge.

Was Sie daraus lernen können: Die Leute schalten bei der geringsten Reibung ab. Dies könnte ein UI- oder sogar ein Entscheidungsproblem sein. Im Falle eines Entscheidungsproblems müssen Sie mit Ihren Kunden sprechen, um zu wissen, wo es juckt, und eine Lösung testen.

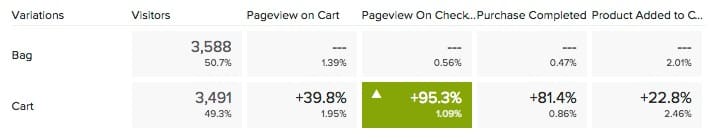

Schaltflächentext: In den Warenkorb oder in den Warenkorb

Viele erfolgreiche E-Commerce-Marken verwenden „In den Warenkorb“ in ihrer Schaltflächenkopie. Andere E-Commerce-Websites halten sich immer noch an „In den Warenkorb“. Die Mode- und Accessoire-Marken neigen eher zum Text „in den Warenkorb legen“, aber würde das auch für Sie funktionieren?

Conversion Fanatics hat einen Test durchgeführt, um zu sehen, wie „in den Warenkorb“ im Vergleich zu „in den Warenkorb“ bei einem ihrer Kunden abschneidet.

Hypothese: Die Änderung des Button-Textes von „In den Warenkorb“ zu „In den Warenkorb“ führt zu einer Erhöhung der Button-Conversion.

Ergebnis:

In diesem Fall, wenn „In den Warenkorb“ verwendet wurde:

- Seitenaufrufe auf der Checkout-Seite stiegen um 95 %

- Die Käufe stiegen um 81,4 %

- Warenkorb hinzufügen um 22,4 % verbessert

Dies ist eine große Steigerung – aber beachten Sie: Es war für diesen speziellen E-Commerce-Shop. Aber einen Test wert, finden Sie nicht?

Was Sie daraus lernen können: In Ihrem Warenkorb-Button-Text könnte viel Auftrieb versteckt sein. Nur 1, 2, 3 Wörter zu ändern, kann einen großen Unterschied bedeuten. Dasselbe gilt für die Schaltflächenfarbe.

NGO-A/B-Testbeispiele

Kiva.org: Above the Fold of Donation Landing Page

Kiva.org ist eine gemeinnützige Organisation, die hilft, Armut zu lindern, indem sie Menschen über das Internet mit Kreditgebern verbindet. Sie beginnen bei 25 $ und helfen jemandem irgendwo auf der Welt, ein bestimmtes Ziel zu erreichen.

Ihre Zielseite für Erstbesucher schien reif für eine Optimierung. Nach einem Brainstorming kamen sie auf einige Verbesserungsmöglichkeiten und beschlossen, diese zu testen.

Sie stellten 3 Varianten auf, um das Original herauszufordern (das bereits großartig aussah):

- Eine Plus-Version (mit einigen Erklärungen, Formatänderungen und Karussell mit automatischer Drehung)

- Eine große Slider-Version (optisch ansprechend mit Fortschrittsanzeige)

- Eine Videoversion (90-Sekunden-Erklärung, wie es bei der automatischen Wiedergabe funktioniert)

Es gab auch eine zusätzliche Variante, die sich darauf konzentrierte, Vertrauenselemente am Ende der Seite hinzuzufügen.

Hypothese: Wenn wir den Besuchern mehr Informationen über die Funktionsweise in einer Text-, Bild- und Videoversion zur Verfügung stellen, werden mehr Menschen spenden. Die Idee war, mehr Vertrauen zu wecken.

Ergebnis:

Die ersten 3 Varianten zeigten nur kleine Aufzüge, aber die Statistiken waren nicht solide genug, um zuversichtlich einen Gewinner zu erklären. Aber die Variante mit den Vertrauenselementen im unteren Bereich steigerte die Konversionsrate um 11,5 % bei über 95 % Vertrauen.

Was Sie daraus lernen können: Die Leute wollen mehr wissen, besonders wenn sie Geld spenden. Sie möchten wissen, wohin ihr Geld geht und ob sie Ihnen genug vertrauen können, um es dorthin zu bringen, wo sie es senden möchten. Hilft Ihre Spendenseite den Besuchern, Ihnen besser zu vertrauen?

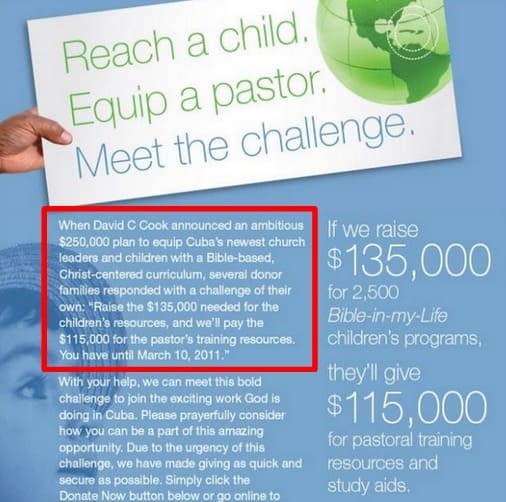

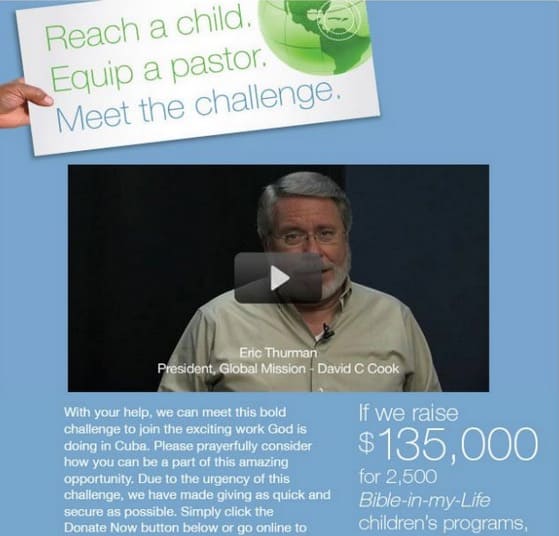

John C. Cook: Text vs. Video

Die Non-Profit-Organisation John C. Cook weiß um die Engagement-Vorteile von Videos. Also beschlossen sie, es in ihren E-Mails zu testen, um zu sehen, wie gut es im Vergleich zu Text-E-Mails in Bezug auf Engagements und Spenden abschneidet.

Hypothese: Gestalten Sie die Marketingbotschaft in E-Mails von Text zu Video neu und es wird Engagements und Spenden erhöhen.

Die Videobotschaft führte zu 43 % mehr Click-Throughs und Spenden stiegen durch diese Version um 114 %.

Was Sie daraus lernen können: Haben Sie von einer Best Practice gehört, die eine Ihrer Lieblingsmetriken verbessert? Testen Sie es zuerst, um zu sehen, ob es für Sie funktioniert. Beweisen Sie seine Gültigkeit, bevor es eine große Delle macht.

Erwägen Sie auch die Verwendung von Videos oder anderen interaktiven Elementen, um mehr Vertrauen zu wecken und der Persönlichkeit Ihres Unternehmens eine weitere Dimension hinzuzufügen.

Beispiele für SaaS-A/B-Tests

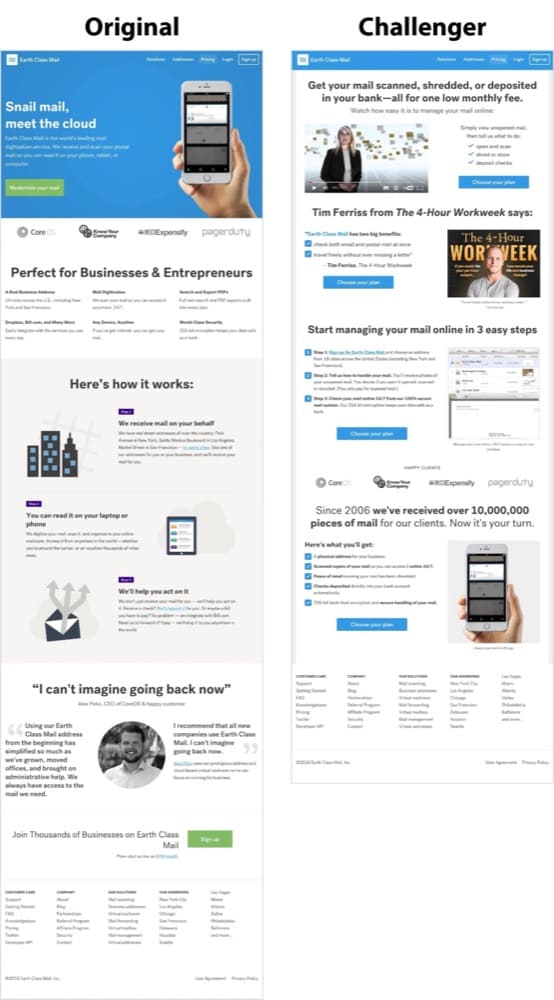

Earth Class Mail: Zielseitenoptimierung

Earth Class Mail wurde von Xenon Ventures übernommen, und Xenon lud Konversionsraten-Experten ein, um das Unternehmen dabei zu unterstützen, sein volles Potenzial auszuschöpfen.

Eines der Dinge, die sie taten, war die Optimierung der Zielseite in dieser Fallstudie zu A/B-Tests. Sie lehnten Best Practices ab und entschieden sich für eine schlanke und einfache Seite. Hier ist die Kontrolle und der Herausforderer:

Hypothese: Nach dem Studium qualitativer und quantitativer Daten aus Umfragen und Umfragen, Daten des Kundendienstteams und Google Analytics stellten sie die Hypothese auf, dass eine vollständige Überarbeitung der Landingpage zu einer „einfachen und schlanken“ Version das Original übertreffen wird.

Ergebnis: Sie hatten recht. Es gab eine 61%ige Steigerung der generierten Leads auf der Challenger-Version.

Was Sie daraus lernen können: Halten Sie sich nicht immer an Best Practices. Verwenden Sie Ihre eigene Recherche, um Punkte in Ihrem Verkaufstrichter herauszufinden, die etwas weniger Reibung vertragen können.

HubSpot: Website-Suchfunktion

HubSpot führte einen A/B/n-Test durch, um zu sehen, was Menschen dazu bringt, sich mehr mit ihrem Website-Suchtool zu beschäftigen.

Sie entwarfen 3 Varianten:

- Variante A – die Suchleiste der Website war sichtbarer und der Platzhaltertext wurde in „Suche nach Thema“ geändert

- Variante B – die Suchleiste der Website war sichtbarer und der Platzhaltertext wurde in „Suche nach Thema“ geändert, aber nur für den Blog, nicht für die gesamte Website

- Variante C – die Suchleiste war sichtbarer, mit Platzhaltertext „Blog durchsuchen“

Hypothese: Wenn die Website-Suchleiste mit dem richtigen Platzhaltertext visuell auffälliger ist, werden die Leute mehr mit dem Tool interagieren und es wird zu einer höheren Blog-Lead-Conversion-Rate führen.

Ergebnis: Die 3 Varianten schnitten besser ab als das Original. Es gab eine höhere Konversionsrate, wobei Variante C mit 3,4 % gewann, und eine Steigerung der Benutzerinteraktion mit der Suchleiste um 6,46 %.

Was Sie daraus lernen können: Auch scheinbar unbedeutende Features auf Ihrer Webseite können zu höheren Conversion-Raten führen. Verwenden Sie qualitative Daten wie Heatmaps, um herauszufinden, wo Ihre Benutzer klicken, und verwenden Sie diese, um eine Geschichte darüber zu erstellen, wie sie Ihre Website nutzen. Dort finden Sie Ideen, was Sie testen können.

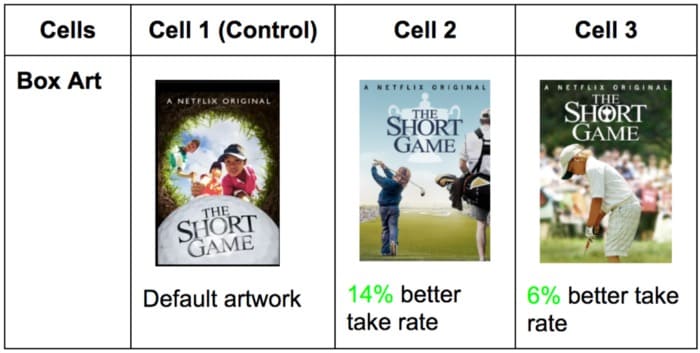

Netflix: Vorgestelltes Video-Artwork

Netflix ist einer der großen Namen in der Welt des Experimentierens. Sie sind dafür bekannt, Tausende von Tests durchzuführen und im The Netflix Tech Blog offen darüber zu sprechen.

Eine der beliebtesten ist die Auswahl der besten Grafik für Videos. Sie tun dies mit A/B-Tests, und das Ziel ist es, den Mitgliedern dabei zu helfen, etwas zum Anschauen zu finden und sich mehr mit jedem Titel zu beschäftigen.

Ein Beispiel ist der Test für ein besseres Artwork für The Short Game.

Hypothese: Das Standard-Artwork hat die Geschichte des Films nicht effektiv erzählt. Ein besseres Kunstwerk würde das Publikum erweitern und das Engagement erhöhen.

Ergebnis:

Eine Variante führte zu einer um 14 % besseren Aufnahmequote.

Was Sie daraus lernen können: Visuelles Storytelling kann optimiert werden, um die Conversion zu steigern. Sagen Ihre Grafiken genau das, was Sie sagen wollen? Oder halten sie ein besseres Kundenerlebnis zurück, das zu höheren Konversionsraten führen könnte?

Nachdem wir Ihnen nun einige Beispiele für A/B-Tests für B2B, DTC, ECOMMERCE, NGO und SaaS gezeigt haben, machen wir dasselbe für verschiedene Kanäle, auf denen Sie Tests durchführen können.

A/B-Testbeispiele nach Kanal:

A/B-Testing-Landingpage

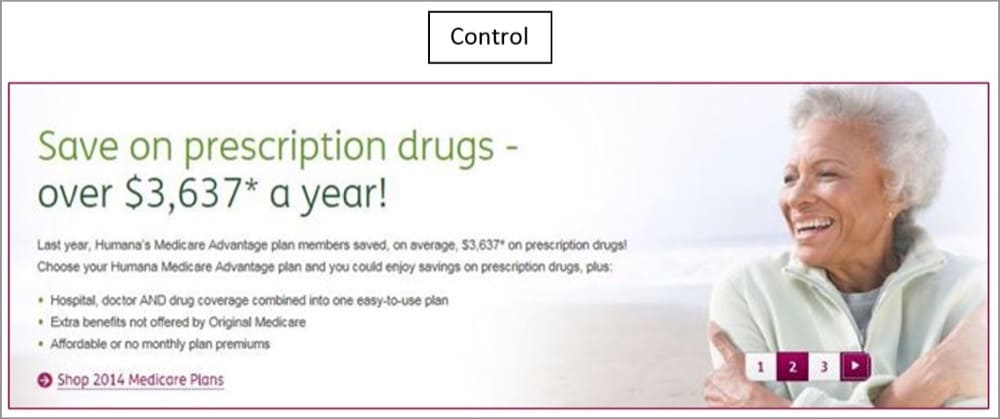

Humana: Zielseitenbanner

Humana wollte die Performance seines Landingpage-Banners verbessern. Die Kontrolle hatte viel Text, der nicht gut funktionierte, zusammen mit dem CTA.

Hypothese: Verbessern Sie die Überschrift, bieten Sie einen kürzeren, prägnanteren Text und einen stärkeren CTA, und dies wird die Klickrate verbessern.

Ergebnis: Sie taten dies und stellten fest, dass Version B eine 433-prozentige Steigerung der Klickrate aufwies als Version „A“. Das ist riesig, aber was, wenn es besser geht?

Für Version „C“ versuchten sie es mit einer anderen (und stärkeren) Überschrift und einem CTA mit dem Wort „Shop“. Dieser stieg um 192 %.

Was Sie daraus lernen können: 5-mal mehr Leute sehen sich das Banner Ihrer Zielseite an als den Rest der Seite. Stellen Sie sicher, dass das, was Sie dort haben, Aufmerksamkeit erregt und Ihre Zielgruppe direkt und klar anspricht.

Auch Ihr Bestes kann besser sein.

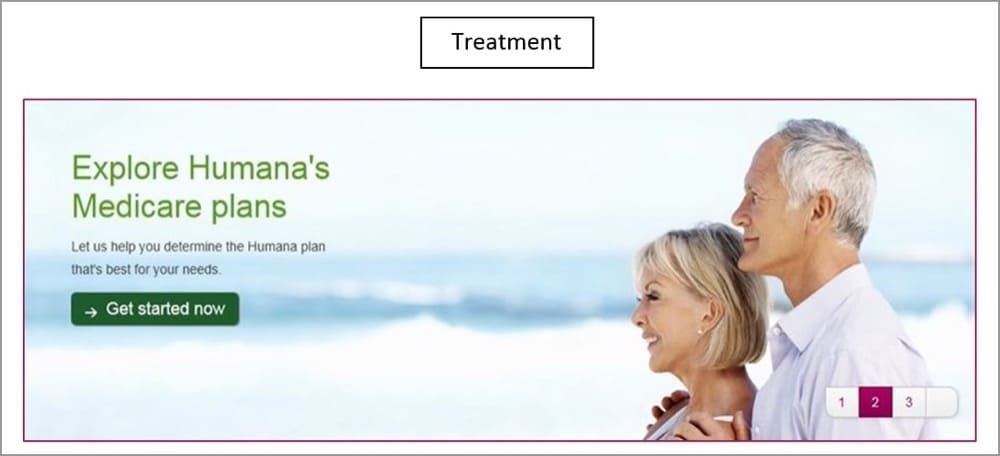

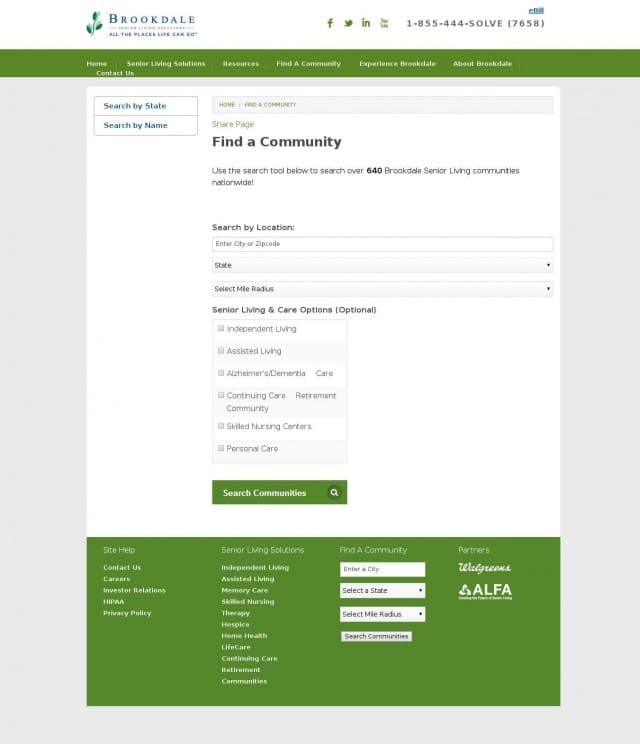

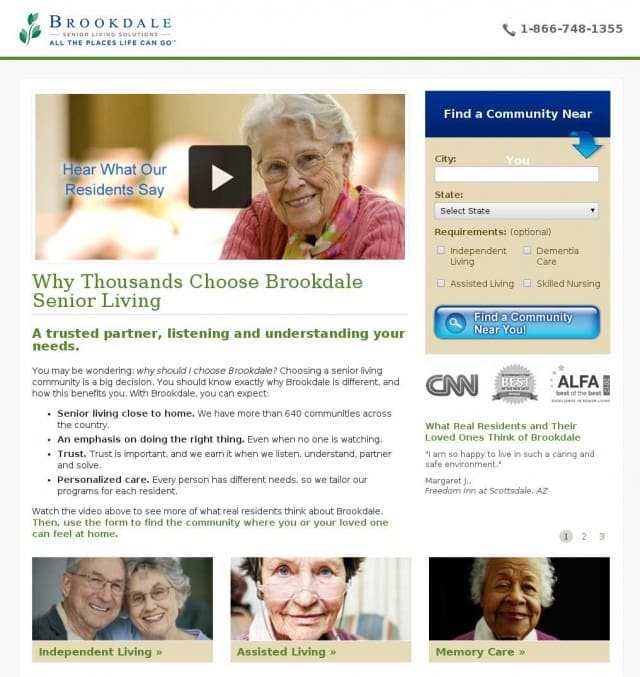

Brookdale Living: Visuelle Elemente

Brookdale Living bietet gemeinschaftliches und betreutes Wohnen für ältere Menschen. Sie wollten, dass ihre „Find a Community“ besser funktioniert, um mehr interessierte Menschen für ihren Dienst zu gewinnen.

Also erkundeten sie die Idee, die Seite mit mehr Vertrauenssignalen, Social Proof und USPs zu verbessern. Ein weiteres Element wurde benötigt, aber sie waren sich nicht sicher, welches besser abschneiden würde: Bild vs. Video.

Hypothese: Mit einer neuen Zielseite, die mit Vertrauenssignalen erstellt wurde, wird ein Video die Leistung der Seite verbessern, als wenn sie ein Bild hätte.

Ergebnis: Die Videoversion, in der Bewohner über ihre erstaunlichen Erfahrungen mit Brookdale sprachen, verlor gegen die Version mit einem statischen Bild. Tatsächlich steigerte das statische Bild den Umsatz um 106.000 US-Dollar.

Was Sie daraus lernen können: Auch hier konnten sich Best Practices in einem A/B-Test nicht wehren. Ich sage nicht, dass alle Best Practices schlecht sind, aber testen Sie immer, um herauszufinden, welche Marketingstrategie für Ihre einzigartige Zielgruppe und Ihr Unternehmen funktioniert.

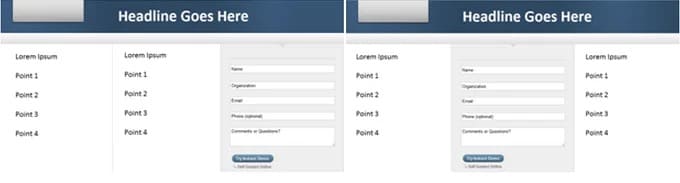

Position des Zielseitenformulars

Hier ist ein Beispiel, das gegen den Strom ging:

Hypothese: Wenn wir das Landingpage-Formular von der rechten Seite in die Mitte der Landingpage verschieben, werden mehr Formularübermittlungen eingehen.

Ergebnis:

Obwohl die Zielseite bereits optimiert war und eine Conversion-Rate von 11 % lieferte, steigerte diese einfache Neupositionierung des Formulars die Conversion-Rate auf 16 %.

Was Sie daraus lernen können: Ihr Formular in der Mitte Ihrer Seite zu haben, ist keine „Best Practice“, aber jemand wollte eine andere Funktionalität ausprobieren und die Gelegenheit ergreifen, eine bereits optimierte Seite weiter zu optimieren.

E-Mail-Beispiele für A/B-Tests

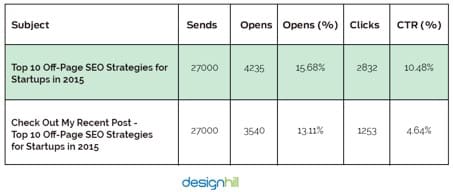

Designhill.com: Stil der E-Mail-Überschrift

Als die Peer-to-Peer-Crowdsourcing-Plattform für Grafiker, Designhill, einige Tage vor Weihnachten einen E-Mail-Newsletter versenden wollte, um einen Blog-Beitrag zu bewerben, fragte sie sich, welche Überschrift die höchsten Klickraten haben würde.

Hypothese: Die Verwendung des Blogtitels als E-Mail-Überschrift reichte aus, um Klicks zu erzielen, verglichen mit einer Überschrift im Call-to-Action-Stil.

Blog-Überschrift: Top 10 Off-Page-SEO-Strategien für Startups im Jahr 2015

Überschrift im CTA-Stil: Schauen Sie sich meinen letzten Beitrag an – Top 10 Off-Page-SEO-Strategien für Startups im Jahr 2015

Ergebnis: Der Blog-Überschriftenstil schnitt mit einer um 5,84 % höheren CTR und einer um 2,57 % höheren Öffnungsrate besser ab als die Version im CTA-Stil.

Was du daraus lernen kannst: Je näher der Nutzen deiner Überschrift am Anfang steht, desto geringer ist die Chance, dass du dein Publikum verlierst. Bringen Sie den Vorteil näher an den Anfang Ihrer E-Mail-Überschriften und testen Sie, ob er besser abschneidet.

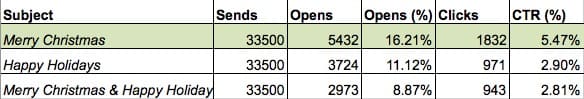

E-Mail-Überschrift „Frohe Weihnachten“ vs. „Frohe Feiertage“.

Wie sollte die Überschrift Ihrer Urlaubs-E-Mail lauten, wenn Sie versuchen, die Leute dazu zu bringen, auf Ihre Website zu kommen und Ihre Sammlung zu durchsuchen?

Hypothese: Wenn wir uns für „Merry Christmas“ entscheiden, wird es „Happy Holidays“ oder eine Kombination aus beiden übertreffen.

Ergebnis: Absolut richtig (in diesem Fall natürlich). „Frohe Weihnachten“ führte zu einer um 2,57 % höheren CTR. Siehe die Details im Screenshot unten:

Was Sie daraus lernen können: Ich persönlich lasse mich lieber mit „Merry Christmas“ begrüßen als mit dem schwammigen „Happy Holidays“ oder seiner Schwester „Compliments of the Season“. Es nervt mich leicht. Letzteres ist jedoch integrativer und funktioniert besser für ein größeres, vielfältigeres Publikum.

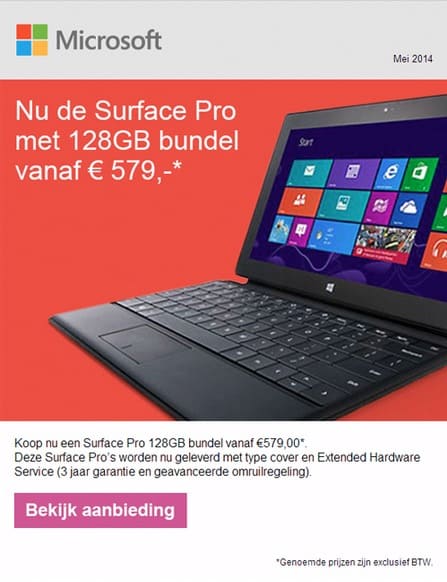

Microsoft: E-Mail-Farbschema

Microsoft wollte, dass mehr Menschen auf die Links in ihren E-Mails klicken und testete die Wirkung des Farbschemas. Dazu gehörten Schaltflächen, Hintergründe und Textfarben.

Hypothese: Ein anderes Farbschema wirkt sich erheblich auf die CTR aus.

Version A (weißer Hintergrund, vollständiges Produktbild und lila CTA) im Vergleich zu Version B (oranger Hintergrund, zugeschnittenes Produktbild und rosa CTA).

Ergebnis: Version A (mit weißem Hintergrund) hatte 325 % mehr Klicks als Version B.

Was Sie daraus lernen können: Ich würde andere Farbschemata testen, da dieser Orangeton optisch möglicherweise zu aggressiv ist. Erwägen Sie also, eine sanftere und friedlichere Farbe zu testen, um die Kontrolle zu schlagen. Einige Dinge wie Hintergrundfarben stehen möglicherweise nicht ganz oben auf Ihren E-Mail-Marketing-Testideen, aber die Auswirkungen könnten Ihr Unternehmen praktisch verändern.

PPC-Beispiele für A/B-Tests

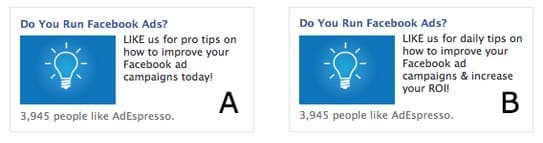

Adspresso: Facebook-Anzeigentext

Adspresso hat zwei Facebook-Anzeigen geschaltet, um zu sehen, welche die meisten Likes anziehen werden.

Hypothese: Eine andere Anzeigenkopie mit der Aufschrift „Profi-Tipps“ schlägt eine mit der Aufschrift „Tägliche Tipps“ + „& Steigern Sie Ihren ROI!“.

Ergebnis: Es stellt sich heraus, dass das Hinzufügen von „& Steigern Sie Ihren ROI!“ konnte Version B nicht davor bewahren, von Version A ausgelöscht zu werden. Version A erhielt 70 Likes und Version B erhielt 0.

Was Sie daraus lernen können: Meistens wollen die Leute Tipps, die ihnen etwas sagen, was sie noch nicht wissen. „Tägliche Tipps“ hört sich so an, als würden Sie viele Tage voller zufälliger Dinge wissen und ab und zu etwas Überraschendes erfahren. Es begeistert Sie nicht wirklich wie „Profi-Tipps“.

Wo in Ihrer Social-Media-Marketing-Kopie können Sie eine spannende Sprache hinzufügen?

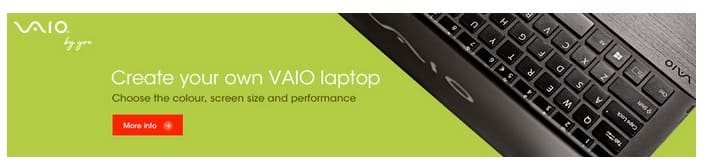

Sony: Personalisierte Bannerwerbung

Als Sony mit seinen Bannerwerbungen nicht die gewünschten Ergebnisse erzielte, entschieden sie sich, die Texte zu optimieren und Möglichkeiten zu testen, damit sie persönlicher klangen.

Hypothese: Personalisierte Anzeigen führen zu höheren Konversionsraten als Werbeanzeigen.

Ergebnis: Es gibt Ebenen der Personalisierung. Man muss es nur sagen und dann das Gefühl der Personalisierung erzeugen.

Version A mit der Aufschrift Erstellen Sie Ihren eigenen VAIO-Laptop schnitt besser ab als die beiden anderen. Es hatte 6 % mehr CTR und wurde 21,3 % häufiger in den Warenkorb gelegt als die Kontrolle.

Was Sie daraus lernen können: Anzeigentexte, die das Publikum in einem persönlichen Ton mit Wörtern wie „Sie“ und „Ihr“ direkt ansprechen, schaffen eine stärkere emotionale Bindung, die sich oft in einem besseren Erfolg mit dieser Anzeige niederschlägt.

PPC-Anzeige: CTA-Kopie

Brad Shorr erzählte Wordstream von einem A/B-Test für PPC-Anzeigen, den sein Team durchgeführt hat, um herauszufinden, welche CTA-Kopie am besten abschneidet zwischen:

A. Erhalten Sie 10 $ Rabatt auf den ersten Einkauf. Jetzt online buchen!

B. Erhalten Sie zusätzlich 10 $ Rabatt. Jetzt online buchen.

Hypothese: CTA A führt zu einer höheren Klickrate als CTA B.

Ergebnis: Die Klickrate von CTA B war sogar doppelt so hoch wie die von Version A.

Was Sie daraus lernen können: Es scheint, als hätte „zusätzlich“ im Vergleich zum „Abnehmen“ gereicht. Es hat mehr positive Verstärkung. Das ist etwas, das es wert ist, getestet zu werden.

Shopify-Beispiele für A/B-Tests

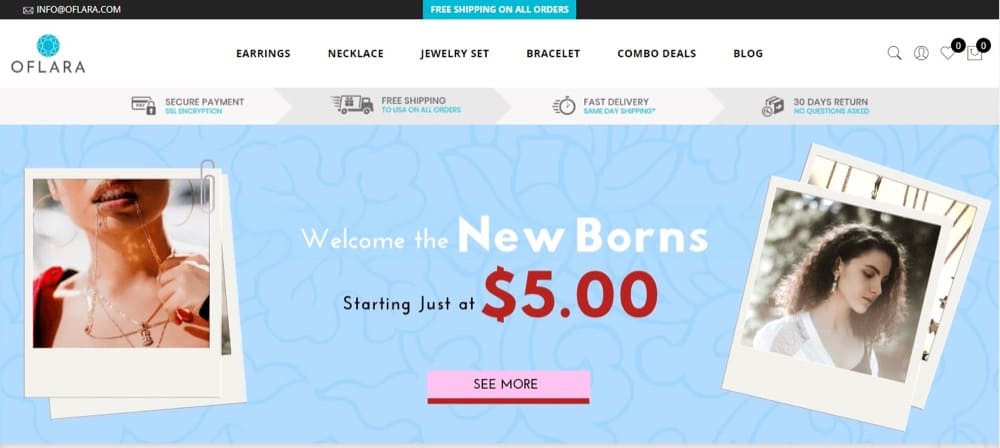

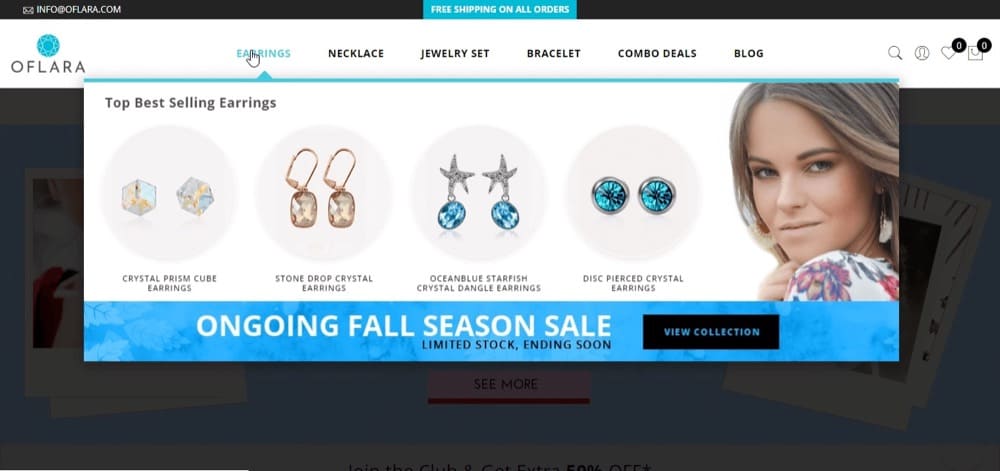

Oflara: Mega-Menü

Oflara experimentierte mit einem Mega-Menü, das in jeder Produktkategorie die meistverkauften Produkte in der Navigationsleiste anzeigte. Diese enthielt auch einen CTA-Link, um die vollständige Sammlung anzuzeigen.

Dies sollte Bestseller in der Navigationsleiste enthalten, im Gegensatz zum einfachen Menü, das keine Dropdown-Menüs hatte.

Hypothese: „Wenn wir das Menü der Website nutzen, um unsere besten Angebote hervorzuheben, wird dies zu einer Steigerung unserer Ladeneinnahmen führen.“

Ergebnis: Nach dem Durchlaufen des Tests war die Variante mit satten 53 % Umsatzsteigerung der klare Gewinner.

Was Sie daraus lernen können: Mega-Menüs können wertvolle Immobilien für Shopify-Sites sein. Sie können dies testen, um zu sehen, ob es bei Ihrem Publikum ankommt.

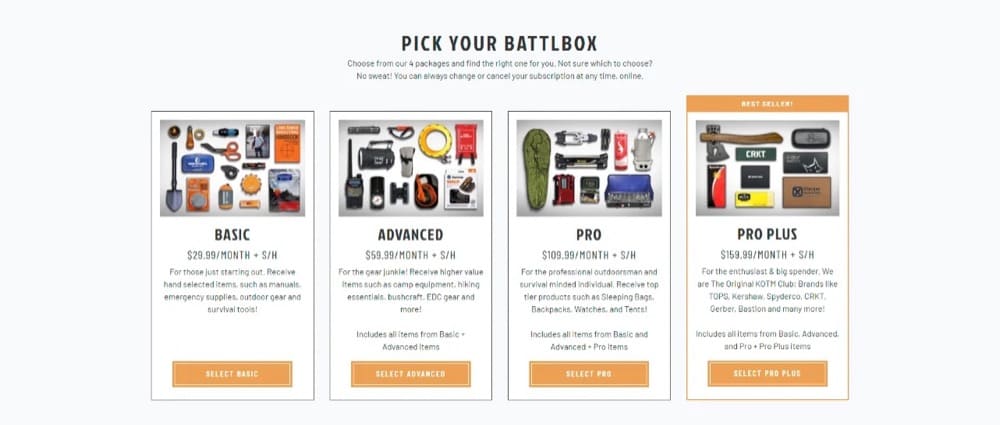

BattlBox: Personalisierte E-Commerce-Content-Marketing-Strategie

BattlBox vertreibt Überlebens-/taktische Abonnementboxen. Sie waren neugierig, wie die Anpassung ihrer Homepage-Erfahrung Erkenntnisse zur Optimierung ihres gesamten Verkaufstrichters liefern kann.

Hypothese: Wenn Sie verschiedenen Segmenten wiederkehrender Kunden ein separates Inhaltserlebnis auf der Homepage der Website zeigen, werden das Engagement und die Konversionsrate gesteigert.

Ergebnis: Nachdem sie mit verschiedenen Inhaltserlebnissen experimentiert hatten, fanden sie eine einzigartige Variante, die die Konversionsrate eines Interessentensegments im Vergleich zu der regulären Variante, die alle anderen erleben, um 30 % steigerte.

Was Sie daraus lernen können: E-Commerce-Marken können personalisierte Inhaltserlebnisse nutzen, um das Website-Engagement für wiederkehrende Benutzer zu steigern. Diese angepasste Benutzererfahrung fühlt sich viel persönlicher an, besonders wenn Sie einen großen und vielfältigen Kundenstamm haben.

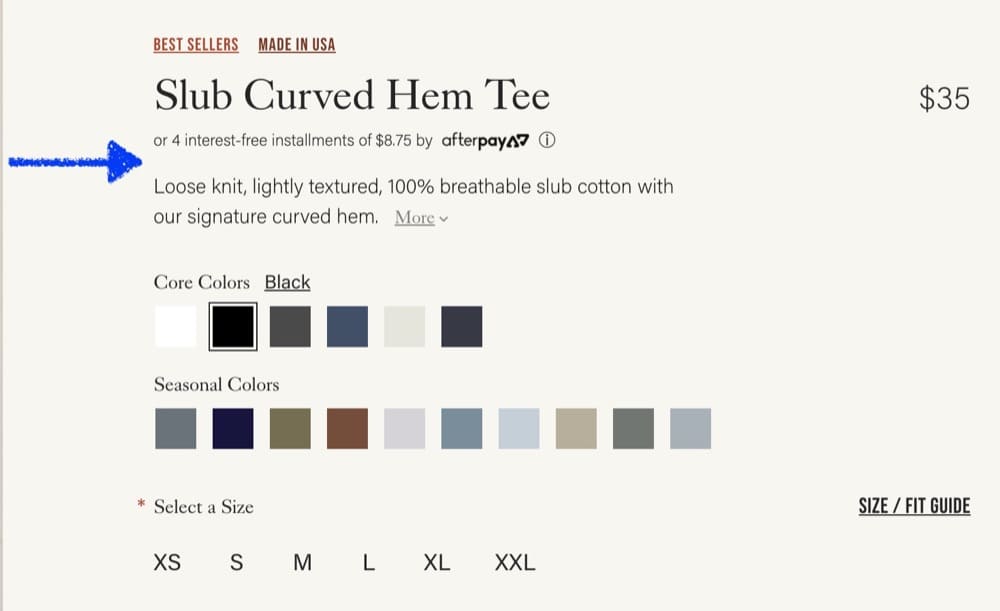

Sternebewertungen vs. keine Sternebewertungen

Einige Shopify-Shops haben keine Produktbewertungen und Sternebewertungen, wie Sie sie bei Amazon finden würden. Ist es möglich, dass das ihre Einnahmen davon abhält, ihr volles Potenzial auszuschöpfen?

Growthrock.co hat dies für einen ihrer Kunden getestet.

Hypothese: Das Hinzufügen einer Bewertungsübersicht mit Bewertungssternen kann das Hinzufügen zum Warenkorb und den durchschnittlichen Bestellwert steigern.

Ergebnis: Als sie in einer Variation Sternebewertungen oben auf den Produktdetailseiten (PDP) hinzufügten, erhöhte sich die Konversionsrate um 15 % mit 94 % statistischer Signifikanz und der Umsatz pro Sitzung um 17 % mit 97 % statistischer Signifikanz.

Auch der durchschnittliche Bestellwert stieg leicht um 2,4 %, was aber vor allem auf die höheren Conversion Rates zurückzuführen ist.

Was Sie daraus lernen können: Die Leute wollen tatsächlich wissen, ob andere Leute Ihre Produkte mögen. Das Fehlen von Sternebewertungen, Testimonials oder Rezensionen auf Ihren PDPs kann für Luxusmarken wie Louis Vuitton funktionieren, aber nicht für alle.

Fazit

Ich hoffe, diese Liste von A/B-Testbeispielen hat eine brillante CRO-Glühbirne in Ihrem Kopf zum Leuchten gebracht und Ihnen geholfen, herauszufinden, wo Sie mit der Durchführung Ihrer eigenen Experimente beginnen können.

Wenn Sie bereits den Schritt-für-Schritt-Prozess für A/B-Tests kennen, wie Sie Hypothesen formulieren, die zu umsetzbaren Erkenntnissen führen, und wie Sie Ihr A/B-Test-Tool zu Ihren Gunsten arbeiten lassen, dann haben Sie jetzt die Ideen, um sich hervorzuheben .