Die 5 Schlüssel der Logfile-Analyse, die jeder SEO braucht

Veröffentlicht: 2018-12-13Protokolldateien spiegeln genau das Leben Ihrer Website wider. Ob von Benutzern oder Bots, auf Seiten oder Ressourcen, alle Aktivitäten auf Ihrer Website werden in Ihren Protokollen gespeichert.

Jede Zeile in Protokollen (serverbasierte Daten) enthält Informationen wie IP-Adressen, Statuscodes, User-Agents, Referrer und andere technische Daten und kann Ihnen dabei helfen, Ihre Website-Analyse zu ergänzen, die normalerweise hauptsächlich auf Analysedaten (Benutzer- orientierte Daten).

Die Daten, die Sie in Ihren Protokollen finden, können Ihnen dabei helfen, Ihre SEO-Strategie zu fokussieren.

1. Gesundheitszustand Ihrer Website

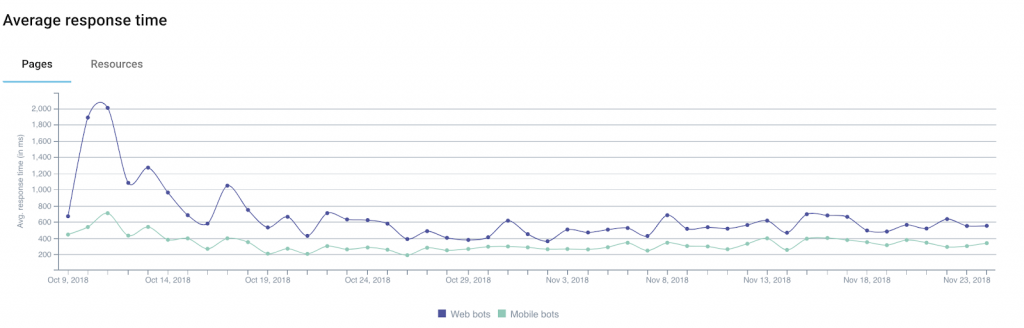

Unter den Informationen, die Sie Ihren Protokollen entnehmen können, sind der Statuscode , die Antwortgröße und die Antwortzeit hervorragende Indikatoren für den Zustand Ihrer Website.

Tatsächlich ist es üblich, Traffic oder Conversions zu verlieren, ohne wirklich zu verstehen, warum. Das liegt daran, dass die Erklärung manchmal technisch sein kann.

Unter den zu berücksichtigenden Hinweisen befinden sich mehrere, die in direktem Zusammenhang mit den drei gerade erwähnten Feldern stehen.

Beispiel 1: Eine Zunahme der Anzahl von Serverfehlern („5xx“) könnte auf technische Probleme hinweisen, die unentdeckt bleiben können, wenn Sie einfach von Seite zu Seite navigieren.

Beispiel 2: Mehrere Studien haben den Einfluss der Ladezeit auf die Konversionsrate für E-Commerce-Websites gezeigt. Ein Rückgang Ihrer Verkaufserlöse könnte mit einer Erhöhung der Ladezeit Ihrer Seiten einhergehen.

Zusätzlich bietet Google einen Rechner an, mit dem Sie das Verhältnis zwischen Ladezeit und Umsatz simulieren können (mit Vorsicht zu genießen).

Beispiel 3: Es kann vorkommen, dass Ihr Server aufgrund verschiedener technischer Probleme leere Seiten zurückgibt. In diesem Fall reicht die einfache Überwachung Ihrer Statuscodes nicht aus, um Sie zu warnen. Aus diesem Grund kann es hilfreich sein, den von Ihnen überwachten Daten eine Antwortgröße hinzuzufügen: Diese leeren (oder leeren) Seiten sind normalerweise heller als gewöhnlich.

Indem Sie Ihre Website basierend auf den verschiedenen Arten von URLs/Seiten segmentieren, können Sie die Quellen der technischen Probleme leichter isolieren, was die Lösung des Problems vereinfacht.

2. Bot-Trefferhäufigkeit

Für Mitglieder der SEO-Community stellen Protokolle eine Fülle nützlicher Informationen darüber dar, wie Bots von Suchmaschinen ihre Websites „verbrauchen“.

Sie teilen uns beispielsweise mit, wann Bots eine Seite zum ersten oder letzten Mal besucht haben.

Nehmen wir das Beispiel einer Nachrichten-Website , die logischerweise Suchmaschinen benötigt, um ihre neuen Inhalte schnell zu finden und zu indizieren. Die Analyse der Protokollfelder, die Datum und Uhrzeit angeben, ermöglicht es, die durchschnittliche Zeit zwischen der Veröffentlichung eines Artikels und seiner Entdeckung durch Suchmaschinen zu bestimmen.

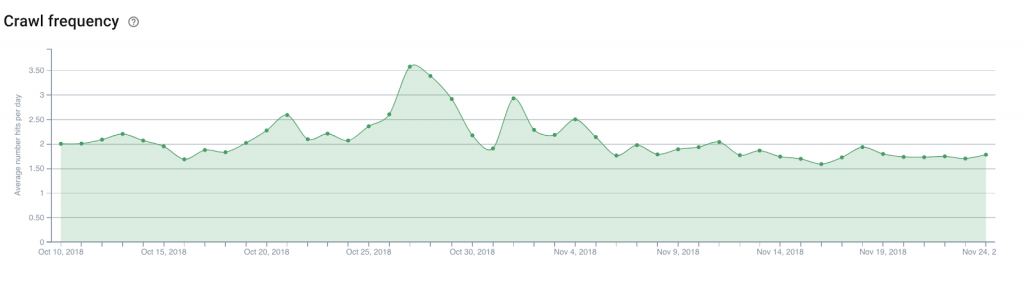

Von dort aus wäre es interessant, die Anzahl der täglichen Bot-Hits (oder die Crawl-Frequenz ) auf der Homepage der Website, den Kategorieseiten usw. zu analysieren. Dadurch lässt sich leicht bestimmen, wo Links zu neuen Artikeln platziert werden müssen, die entdeckt werden müssen.

Die gleiche Theorie kann auf eine E-Commerce-Website angewendet werden, um neue Produkte im Katalog zu entdecken, z. B. solche, die Sie hervorheben möchten, um über aufkommende Trends auf dem Laufenden zu bleiben.

3. Crawl-Budget

Das Crawl-Budget (eine Art Gutschrift der Crawl-Bandbreite, die Google und seine Kollegen einer Website widmen) ist ein beliebtes Thema von SEO-Experten, und seine Optimierung ist zu einer obligatorischen Aufgabe geworden.

Abgesehen von Protokollen gibt Ihnen nur die Google Search Console (derzeit die alte Version) eine grundlegende Vorstellung von dem Budget, das Suchmaschinen Ihrer Website gewähren. Aber der Grad an Genauigkeit in der Search Console hilft Ihnen nicht wirklich zu wissen, worauf Sie Ihre Bemühungen konzentrieren sollten. Vor allem, da es sich bei den gemeldeten Daten tatsächlich um aggregierte Daten handelt, die von allen Googlebots gesammelt wurden.

Protokolle können jedoch dank einer Analyse der User-Agent- und URL -Felder feststellen, welche Seiten (oder Ressourcen) Bots mit welcher Geschwindigkeit besuchen.

Diese Informationen werden Sie darüber informieren, wenn die Googlebots übermäßig Teile Ihrer Website durchsuchen, die für SEO nicht wichtig sind, wodurch Budget verschwendet wird, das für andere Seiten nützlich sein könnte.

Diese Art der Analyse kann verwendet werden, um Ihre interne Verlinkungsstrategie, Ihre robots.txt-Dateiverwaltung, Ihre Verwendung von Meta-Tags, die auf Bots abzielen, zu strukturieren …

4. Mobile-First & Migration

Einige können es kaum erwarten, andere haben Angst davor, aber der Tag wird sicherlich kommen, an dem Sie eine E-Mail von Google erhalten, die besagt, dass Ihre Website auf den berühmten Mobile-First-Index umgestellt wurde.

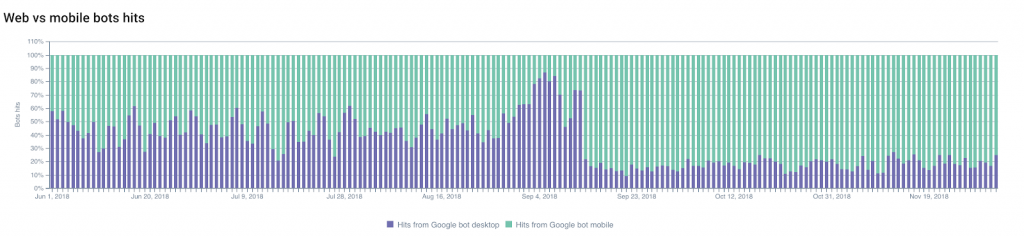

Sie können vorhersagen, wann der Wechsel stattfinden wird, indem Sie Änderungen im Verhältnis zwischen Googlebot-Desktop-Treffern und Googlebot-Mobil-Treffern verfolgen .

Der Anteil des Crawlings durch mobile Googlebots wird im Allgemeinen zunehmen, sodass Sie den Wechsel vorhersagen und planen können.

Andererseits kann auch das Nichtbeachten dieses Verhältnisses ein deutlicher Hinweis darauf sein, ob Ihre Website den Kriterien von Google für den Indexwechsel entspricht.

Sie können auch andere Änderungen überwachen: Migrationen (z. B. von HTTP zu HTTPS ) oder Änderungen an der Struktur Ihrer Website .

Konzentrieren wir uns auf das erste Beispiel – auf eine Modifikation des verwendeten Protokolls – lässt sich die Indexierung der sicheren URLs und Redirects sowie der fortschreitende „Verfall“ der alten URLs dank Logs gut überwachen.

Die Überwachung von Änderungen in Statuscodes wird Ihr bester Verbündeter sein!

5. Neugierige Nachbarn

Sie sind ein ausgezeichneter SEO und Ihre Bemühungen haben sich ausgezahlt!

Dies hat die Neugier Ihrer Konkurrenten (und anderer neugieriger Leute) geweckt, die verstehen wollen, wie Sie es geschafft haben, und die sich entschieden haben, Ihre gesamte Website zu crawlen.

Das ist schlecht. Aber nicht ungewöhnlich (ganz im Gegenteil).

Ihre Aufgabe ist es jetzt, die Schnüffler zu erkennen.

Die subtilsten von ihnen werden versuchen, ihre Bots als Googlebots auszugeben, indem sie Google -Benutzeragenten verwenden . Und hier kann die in den Protokollen gespeicherte IP-Adresse sehr nützlich sein.

Tatsächlich verwenden offizielle Googlebots jedoch nur gut dokumentierte Bereiche von IP-Adressen. Google rät Webmastern, einen Reverse-DNS-Lookup durchzuführen, um die Herkunft der Bots zu verifizieren.

Wenn dieser Test fehlschlägt, können Ihnen die Ergebnisse (oder die Ergebnisse des IP-Geotrackings) bei der Entscheidung helfen, was zu tun ist.

Nur fürs Protokoll: Der Experte für digitale Sicherheit bei Imperva Incapsula führte eine 2016 veröffentlichte Studie durch, die zeigt, dass 28,9 % der analysierten Bandbreite von „bösen Bots“ verbraucht wurden (im Vergleich zu 22,9 % von „guten Bots“ und 48,2 % von Benutzern). ). Ein Blick auf Ihre Protokolle kann Ihnen helfen, eine übermäßige Belastung Ihrer Ressourcen zu vermeiden, indem Sie unerwünschte Bots erkennen.