5 gute Gründe, Ihre Crawl- und Protokolldaten zu kombinieren

Veröffentlicht: 2018-03-27Das Verständnis von Logfile-Daten im SEO hat in der SEO-Community zunehmend zugenommen. Protokolldateien sind eigentlich die einzige qualitative Darstellung dessen, was auf einer Website passiert. Aber wir müssen immer noch in der Lage sein, sie effektiv zum Sprechen zu bringen.

Genaue SEO-Besuche und das Bot-Verhalten sind in Ihren Protokolldateien vorhanden. Andererseits können Daten aus Ihrem Crawling-Bericht gute Erkenntnisse über Ihre Onsite-Performance liefern. Sie müssen Ihre Protokolldateien und Crawl-Daten kombinieren, um bei der Analyse Ihrer Website neue Dimensionen hervorzuheben.

Dieser Artikel zeigt Ihnen fünf hervorragende Möglichkeiten zum Kombinieren von Crawl- und Protokolldateidaten. Offensichtlich gibt es noch viel mehr, die Sie verwenden können.

1# Erkennung verwaister Seiten und Optimierung des Crawl-Budgets

Was ist eine verwaiste Seite? Wenn eine URL in den Protokollen erscheint, ohne in der Architektur der Website enthalten zu sein, wird diese URL als verwaist bezeichnet.

Google hat einen kolossalen Index! Im Laufe der Zeit behält es alle URLs, die es bereits auf Ihrer Website entdeckt hat, auch wenn sie nicht mehr in der Architektur vorhanden sind (Slug-Änderung, gelöschte Seiten, vollständige Site-Migration, fehlerhafte oder transformierte externe Links). Wenn Sie Google diese sogenannten verwaisten Seiten crawlen lassen, kann dies natürlich Auswirkungen auf die Optimierung Ihres Crawling-Budgets haben. Wenn veraltete URLs Ihr Crawl-Budget aufbrauchen, verhindert dies, dass andere URLs regelmäßiger gecrawlt werden, und wirkt sich zwangsläufig auf Ihre SEO aus.

Beim Crawlen Ihrer Website geht OnCrawl alle Links durch, um Tiefe für Tiefe die vollständige Architektur Ihrer Website zu entdecken. Andererseits stellt OnCrawl während der Protokolldateiüberwachung Daten von Google-Bot-Treffern und SEO-Besuchen zusammen.

Der Unterschied zwischen URLs, die Google bekannt sind, und solchen, die in der Architektur verlinkt sind, kann sehr wichtig sein. SEO-Optimierungen, die darauf abzielen, vergessene oder defekte Links zu korrigieren und verwaiste Seiten zu reduzieren, sind unerlässlich.

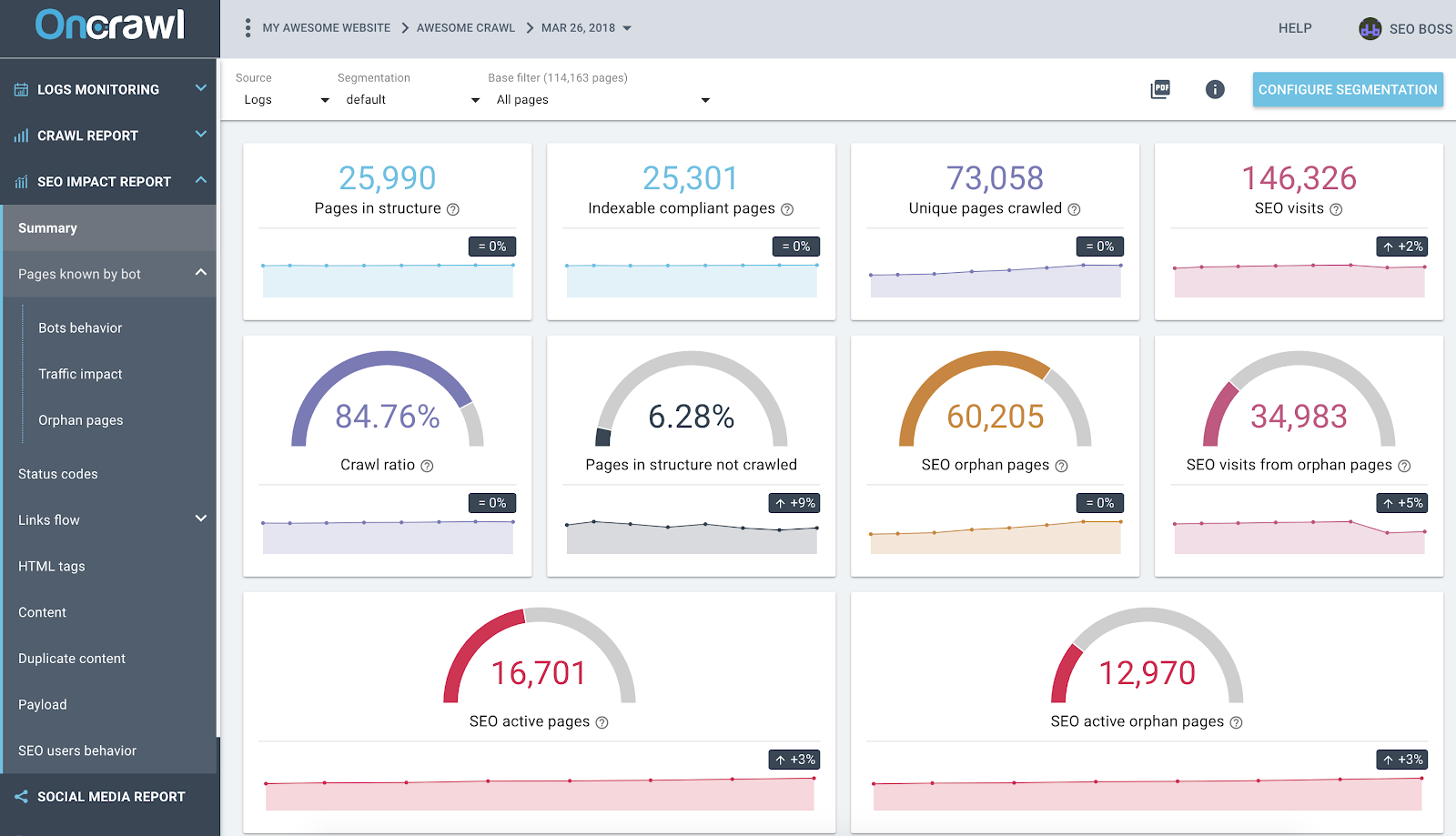

OnCrawl SEO Impact Report basierend auf Protokollen und datenübergreifender Crawl-Analyse

Der obige Screenshot zeigt den aktuellen Stand Ihrer Protokolle und Crawling-Daten. Das merkt man schnell:

- 25.990 Seiten sind in der Struktur – gefunden von unserem Crawler und unter Berücksichtigung aller Links, denen er auf der Website gefolgt ist;

- 73.058 Seiten werden von Google gecrawlt – das ist 3x mehr als in der Struktur;

- Ein Crawling-Verhältnis von 84 % – (OnCrawl-gecrawlte Seiten + aktive Seiten aus Protokollen + von Google gecrawlte Seiten) / von Google gecrawlte Seiten;

- Mehr als 6 % der internen Seiten werden nicht gecrawlt – klicken Sie einfach auf den schwarzen Eimer, um die Liste dieser Seiten im Datenexplorer anzuzeigen;

- 60.000 verwaiste Seiten – das Delta zwischen Seiten in der Struktur und von Google gecrawlten Seiten;

- 34.000 SEO-Besuche auf diesen Seiten – es sieht so aus, als gäbe es ein Problem mit der internen Verlinkung!

Best Practice: OnCrawl bietet Ihnen den Vorteil, Daten hinter jedem Diagramm oder jeder Metrik zu erkunden, indem Sie einfach darauf klicken. Auf diese Weise erhalten Sie eine herunterladbare Liste von URLs, die direkt nach dem von Ihnen untersuchten Bereich gefiltert sind.

2# Finden Sie heraus, welche URLs das meiste (oder das geringste) Crawl-Budget verbrauchen

Alle Ereignisse aus Google-Bot-Besuchen sind der OnCrawl-Datenplattform bekannt. Damit wissen Sie – für jede URL – alle Daten nach Zeit zusammengestellt.

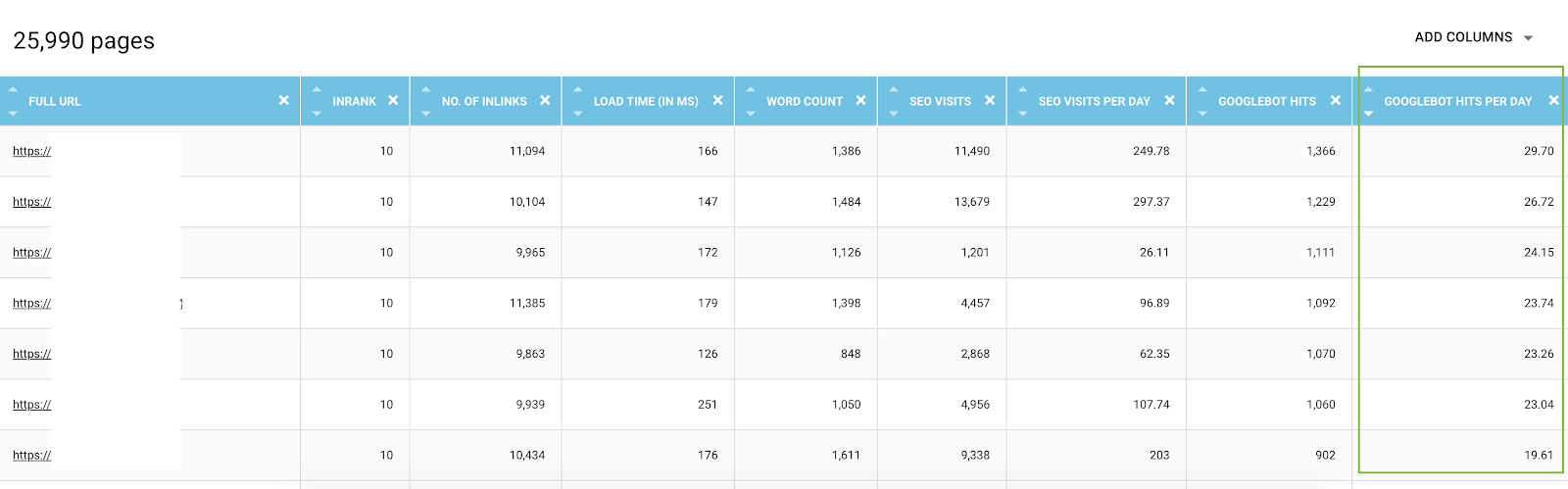

Im Daten-Explorer können Sie für jede URL Bot-Treffer-Spalten (über einen Zeitraum von 45 Tagen) und Treffer nach Tag und nach Bots hinzufügen, was ein Durchschnittswert pro Tag ist. Diese Informationen sind wertvoll, um den Verbrauch des Google-Crawl-Budgets auszuwerten. Oft werden Sie feststellen, dass dieses Budget nicht auf allen Seiten einheitlich ist.

Liste aller URLs aus dem Daten-Explorer mit Crawl-Metriken und gefiltert nach Bot-Treffern pro Tag

Tatsächlich können einige Faktoren das Crawl-Budget auslösen oder reduzieren. Wir haben dann in diesem Artikel über die Wichtigkeit der Google-Seite eine Liste der wichtigsten Metriken erstellt. Tiefe, Anzahl der Links, die auf eine Seite verweisen, Anzahl der Keywords, Seitengeschwindigkeit, InRank (interne Popularität) beeinflussen das Crawling von Bots. Im folgenden Absatz erfahren Sie mehr.

3# Kennen Sie Ihre besten SEO-Seiten, Ihre schlechtesten SEO-Seiten und bestimmen Sie die Erfolgsfaktoren von Seiten

Wenn Sie den Daten-Explorer verwenden, haben Sie Zugriff auf wichtige Metriken zu Seiten – aber es kann kompliziert sein, Hunderte von Zeilen und Metriken miteinander zu vergleichen. Die Verwendung von Spalten zur Segmentierung von Bot-Treffern nach Tag und SEO-Besuchen nach Tag ist ein Verbündeter in Ihrem Data Mining.

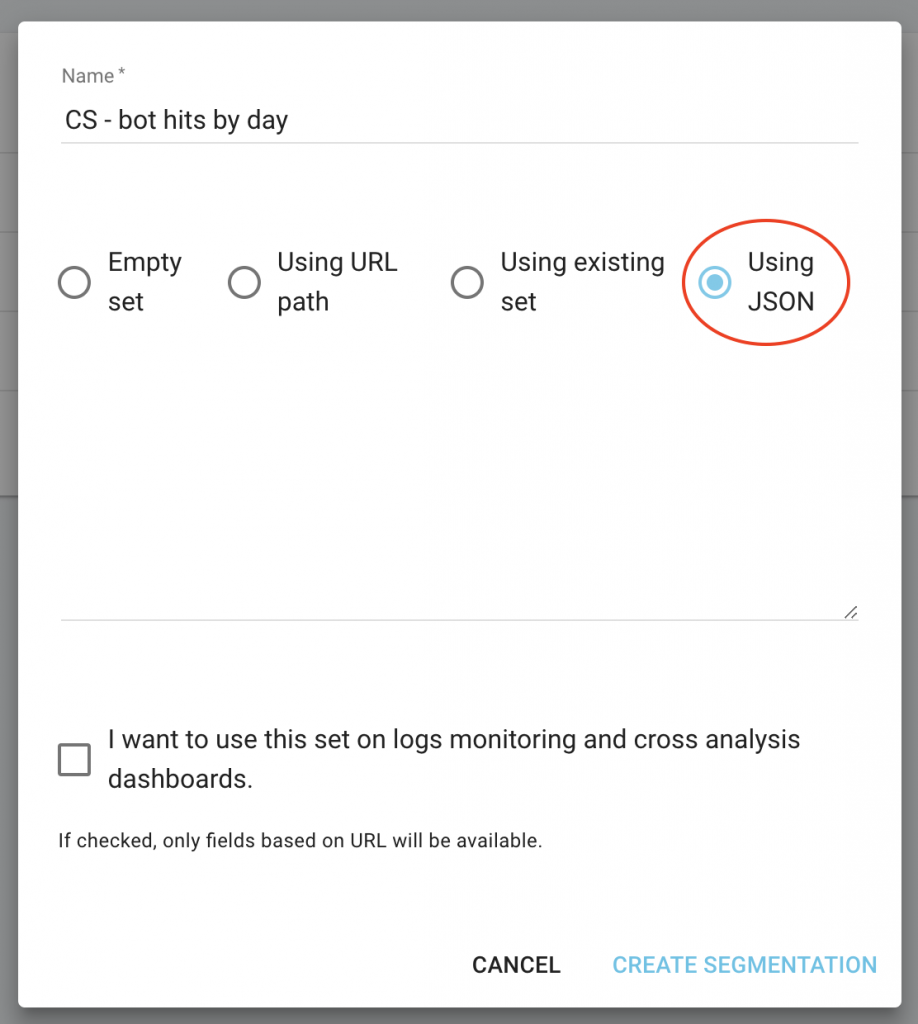

- Laden Sie die JSON-Dateien CS – Bot Hits by Day und CS – SEO visits by day herunter;

- Fügen Sie sie als neue Segmentierungen hinzu.

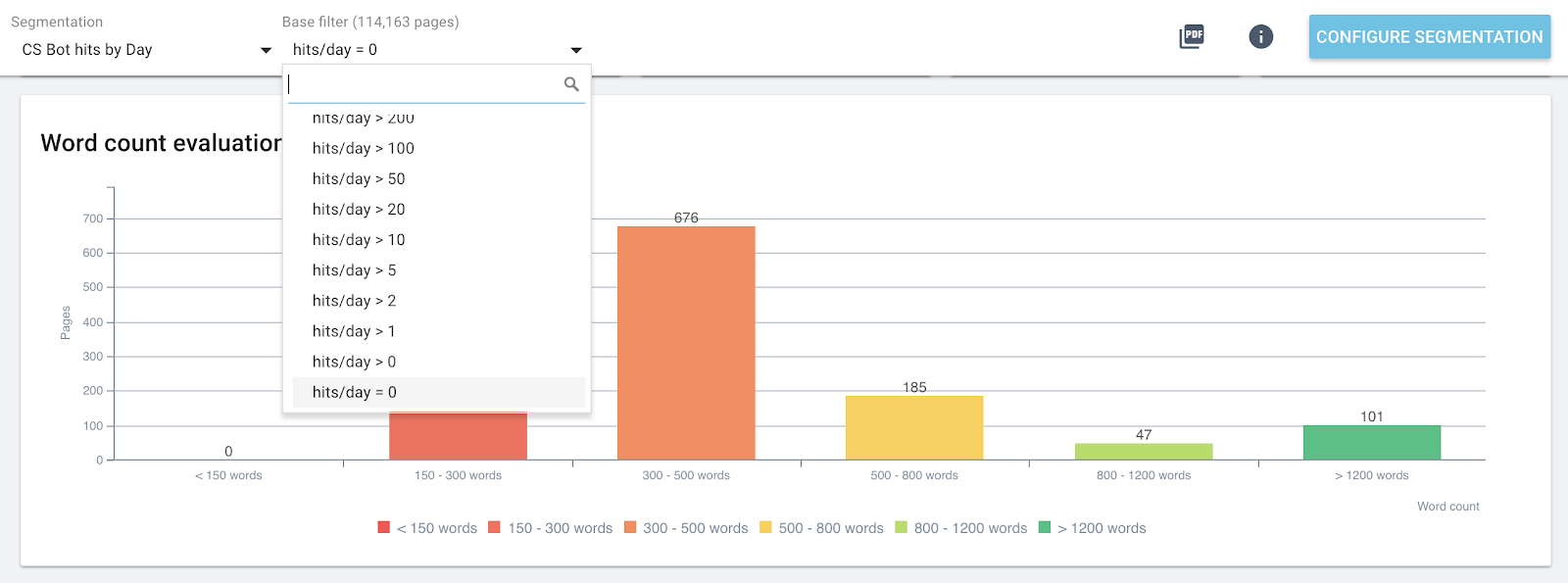

Tatsächlich können Sie basierend auf diesen beiden Werten, die sich aus der Protokollanalyse ergeben, Segmentierungen erstellen, um eine erste Verteilung Ihrer Seiten nach Gruppen zu erhalten. Sie können aber auch jede Gruppe dieser Segmentierungen filtern, um in jedem OnCrawl-Bericht schnell zu erkennen, welche Seiten die erwarteten Werte nicht erreichen.

Klicken Sie auf Ihrer Projekthomepage auf die Schaltfläche „Segmentierung konfigurieren“.

Erstellen Sie dann eine neue Segmentierung

Verwenden Sie den JSON-Import, indem Sie die Kapazität „Using JSON“ auswählen und die heruntergeladenen Dateien kopieren/einfügen.

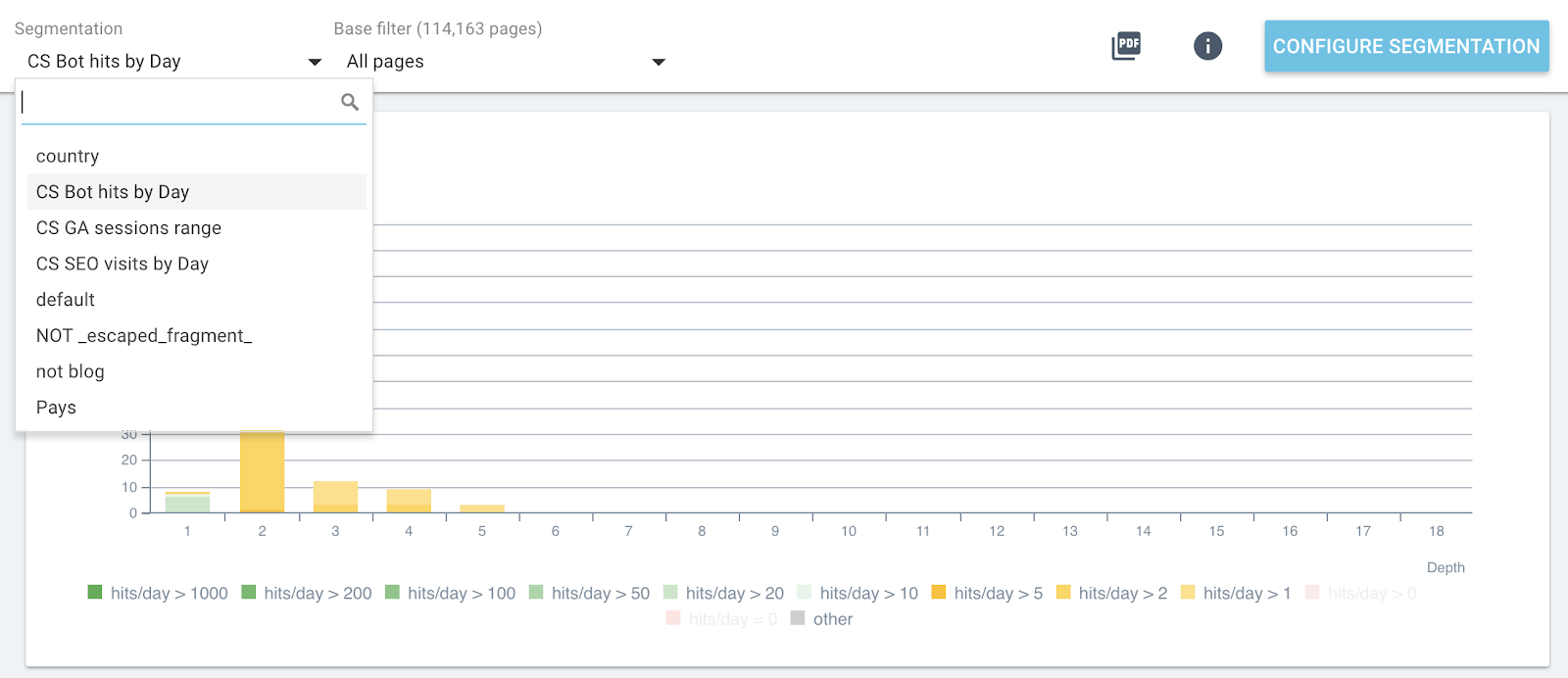

Jetzt können Sie die Segmentierung über das obere Menü in jedem Bericht wechseln.

Live-Segmentierungsänderung in allen OnCrawl-Berichten

Dadurch erhalten Sie auf jeder Grafik die Auswirkungen der Metriken, die Sie analysieren und die sich auf Seiten beziehen, die nach Bot-Treffern oder SEO-Besuchen gruppiert sind.

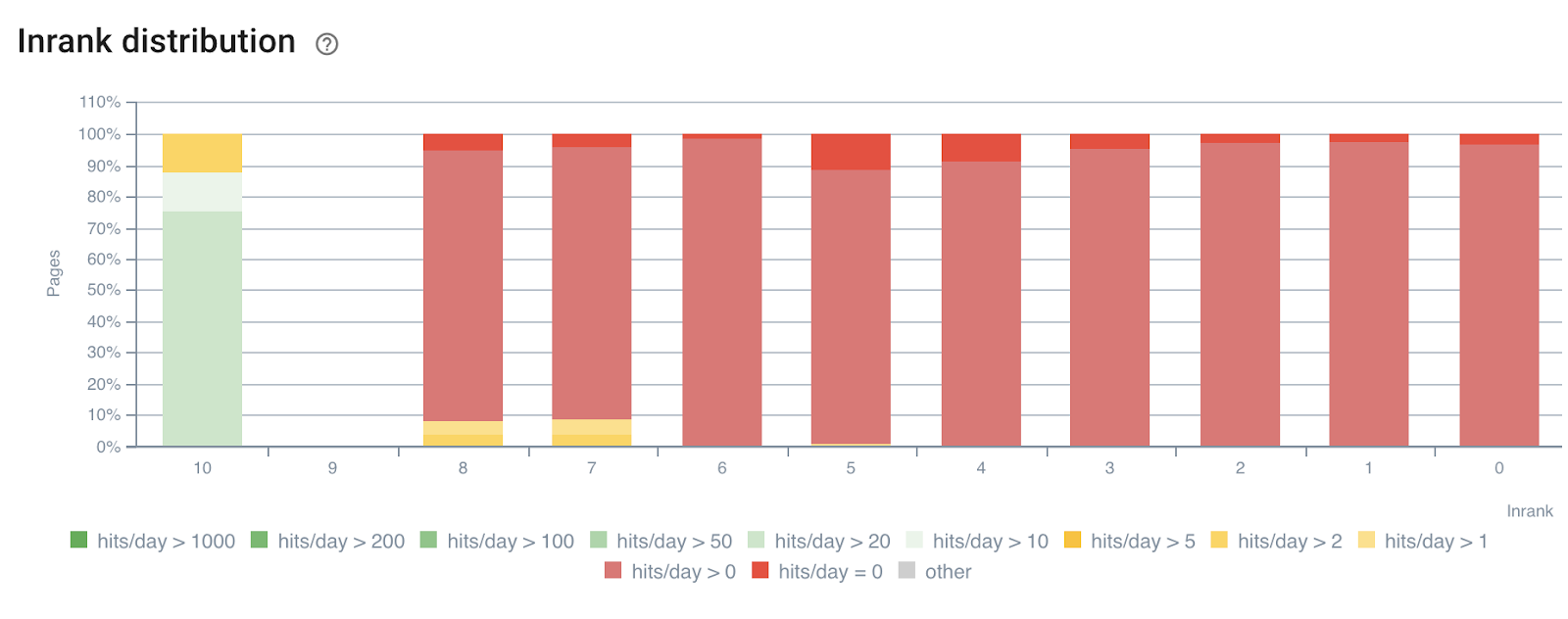

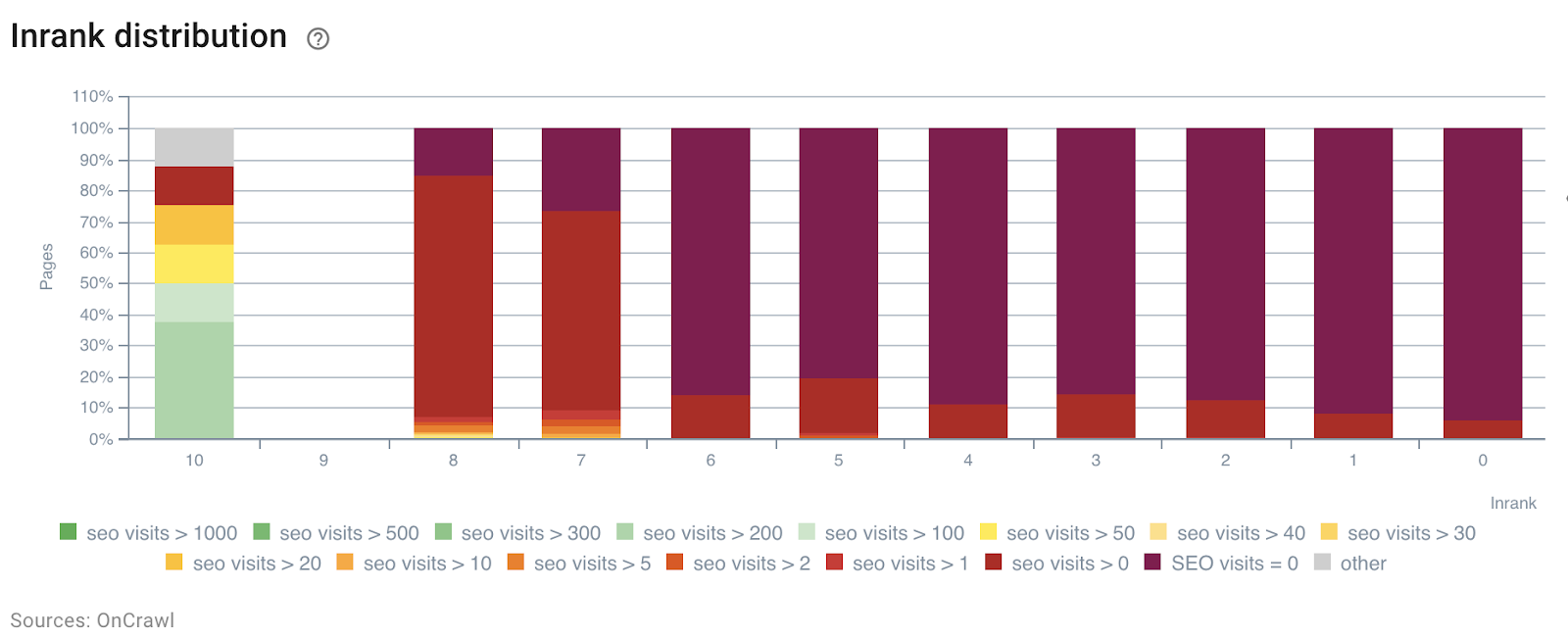

Im folgenden Beispiel haben wir diese Segmente verwendet, um die Auswirkungen der internen InRank-Popularität zu verstehen – basierend auf der Stärke von Links nach Tiefe. Darüber hinaus sind Bot-Treffer und SEO-Besuche auf derselben Achse korreliert.

InRank-Verteilung nach Bot-Hits pro Tag

InRank-Verteilung nach SEO-Besuchen pro Tag

Die Tiefe (die Anzahl der Klicks von der Startseite) hat eindeutig einen Einfluss sowohl auf die Bot-Treffer als auch auf die SEO-Besuche.

Auf die gleiche Weise kann jede Seitengruppe unabhängig ausgewählt werden, um Daten von den am häufigsten aufgerufenen oder besuchten Seiten hervorzuheben.

Dies ermöglicht es, schnell Seiten zu erkennen, die eine bessere Leistung erzielen könnten, wenn sie optimiert würden, beispielsweise die Anzahl der Wörter auf der Seite, die Tiefe oder die Anzahl der eingehenden Links.

Wählen Sie einfach die richtige Segmentierung und die Gruppe von Seiten aus, die Sie analysieren möchten.

Wortverteilung auf der Seite für die Gruppe mit 0 Bot-Treffern pro Tag

4# Bestimmen Sie Schwellenwerte, um das Crawl-Budget und die SEO-Besuche zu maximieren

Um noch weiter zu gehen, kann der SEO Impact Report – Crawling- und Log-übergreifende Datenanalyse – Schwellenwerte erkennen, die dabei helfen, SEO-Besuche, Crawling-Frequenz oder Seitenauffindbarkeit zu erhöhen.

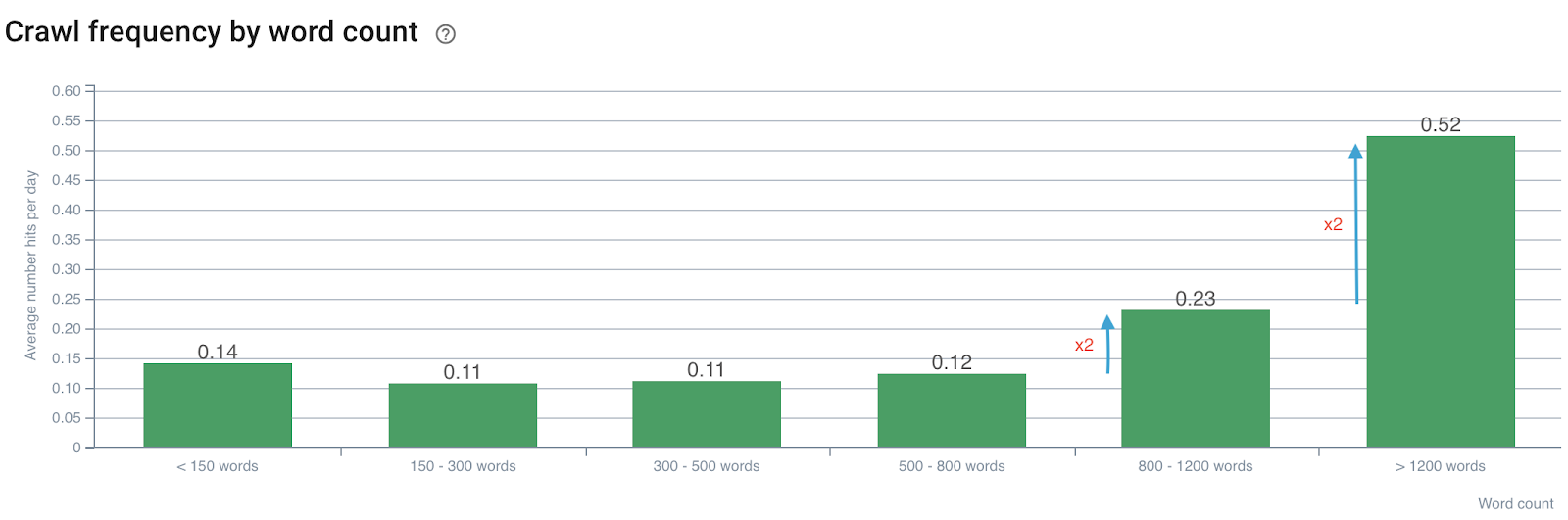

Einfluss der Wortzahl auf die Crawl-Frequenz

Crawling-Frequenz nach Anzahl der Wörter

Wir stellen fest, dass die Crawling-Frequenz verdoppelt wird, wenn die Anzahl der Wörter 800 überschreitet. Dann wird sie auch verdoppelt, wenn die Anzahl der Wörter auf der Seite 1200 Wörter überschreitet.

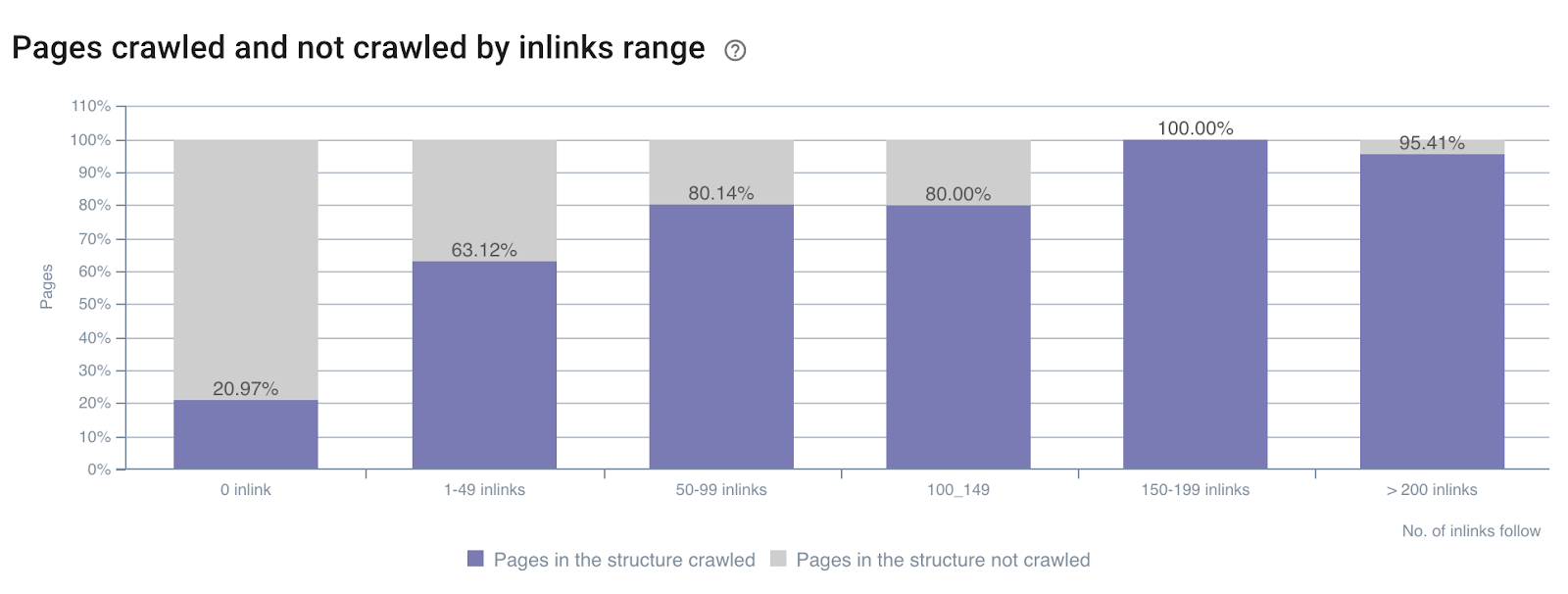

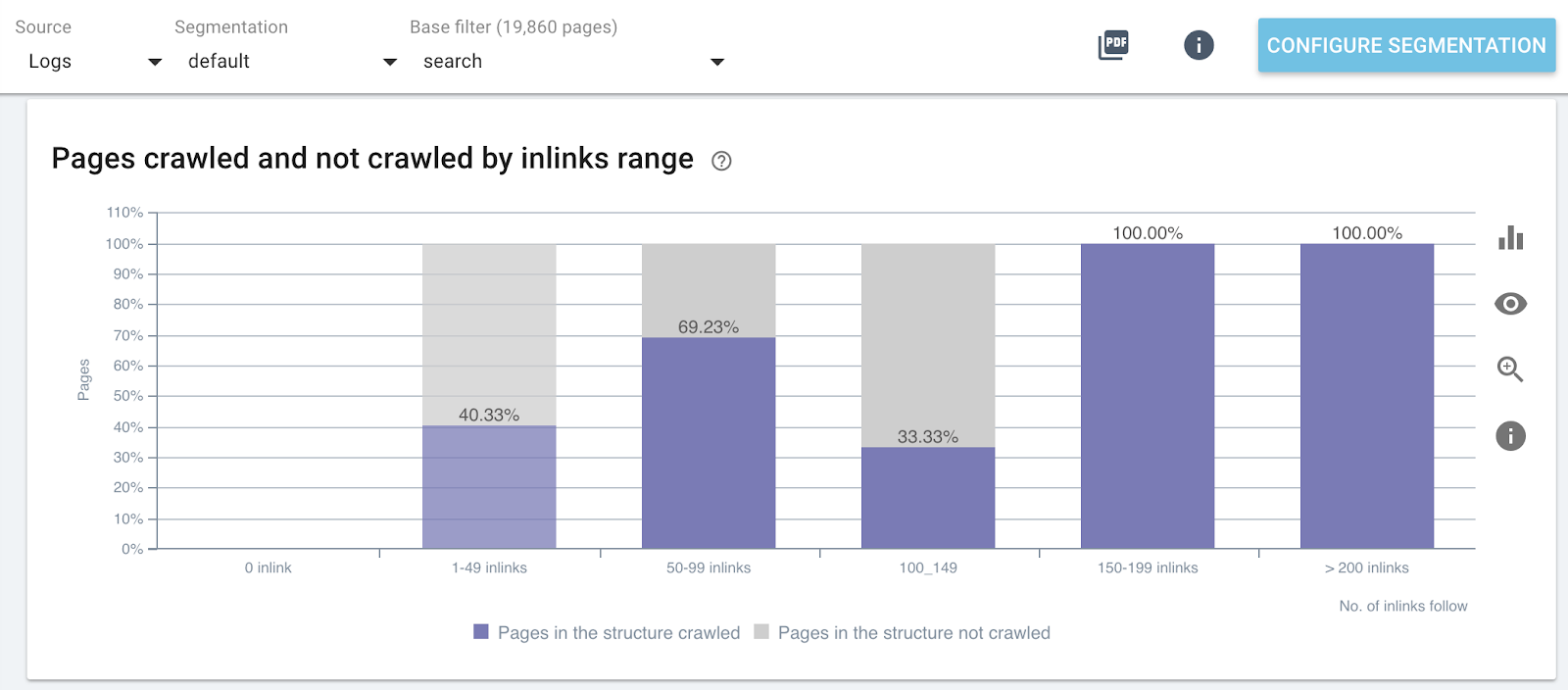

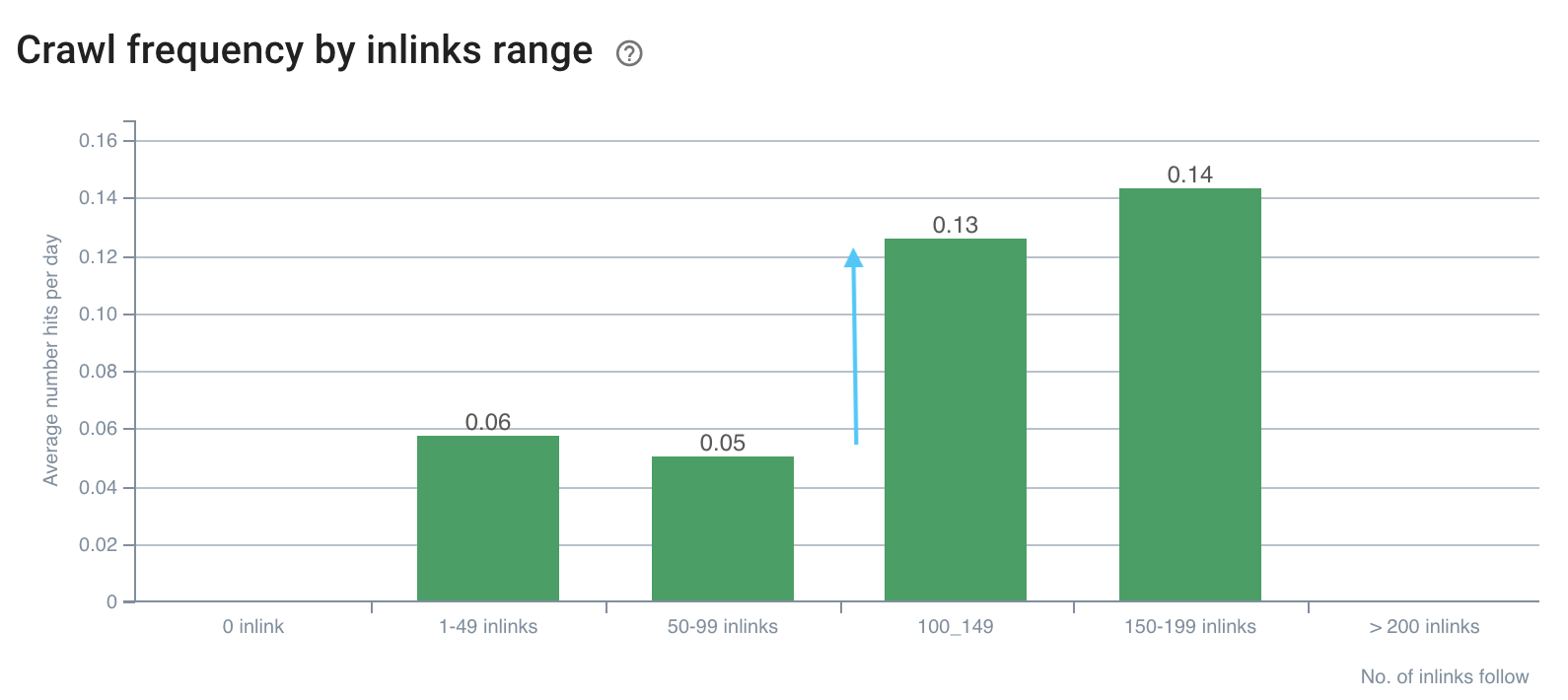

Einfluss der Anzahl der Inlinks auf die Crawl-Rate

Crawl-Verhältnis nach Anzahl der Inlinks auf der gesamten Website

Crawl-Verhältnis nach Anzahl der Inlinks auf bestimmten Teilen der Website (Suchseiten)

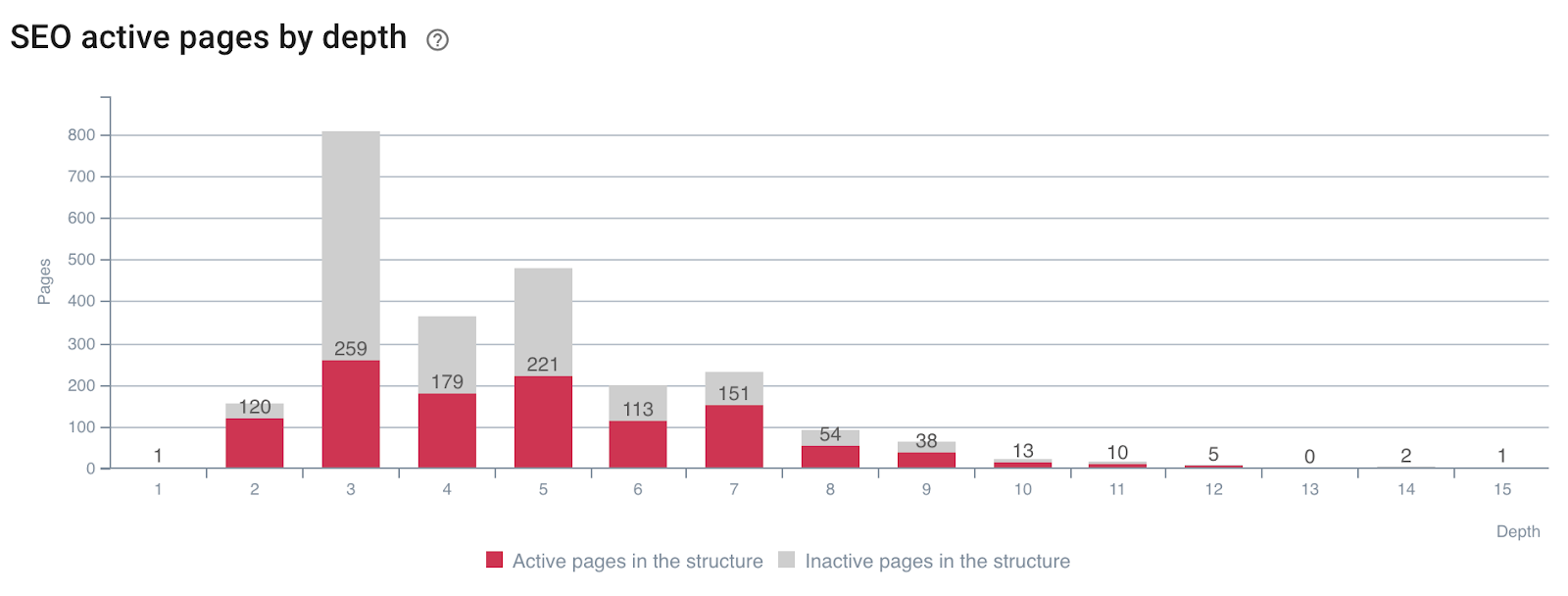

Einfluss der Tiefe auf die Aktivität der Seiten

Seiten, die SEO-Besuche (oder nicht) nach Tiefe generieren

Sie können sehen, dass Sie mit den richtigen Website-Metriken während eines Crawls und dem Überqueren von Protokolldaten sofort erkennen können, welche SEO-Optimierungen erforderlich sind, um das Crawlen von Google zu manipulieren und Ihre SEO-Besuche zu verbessern.

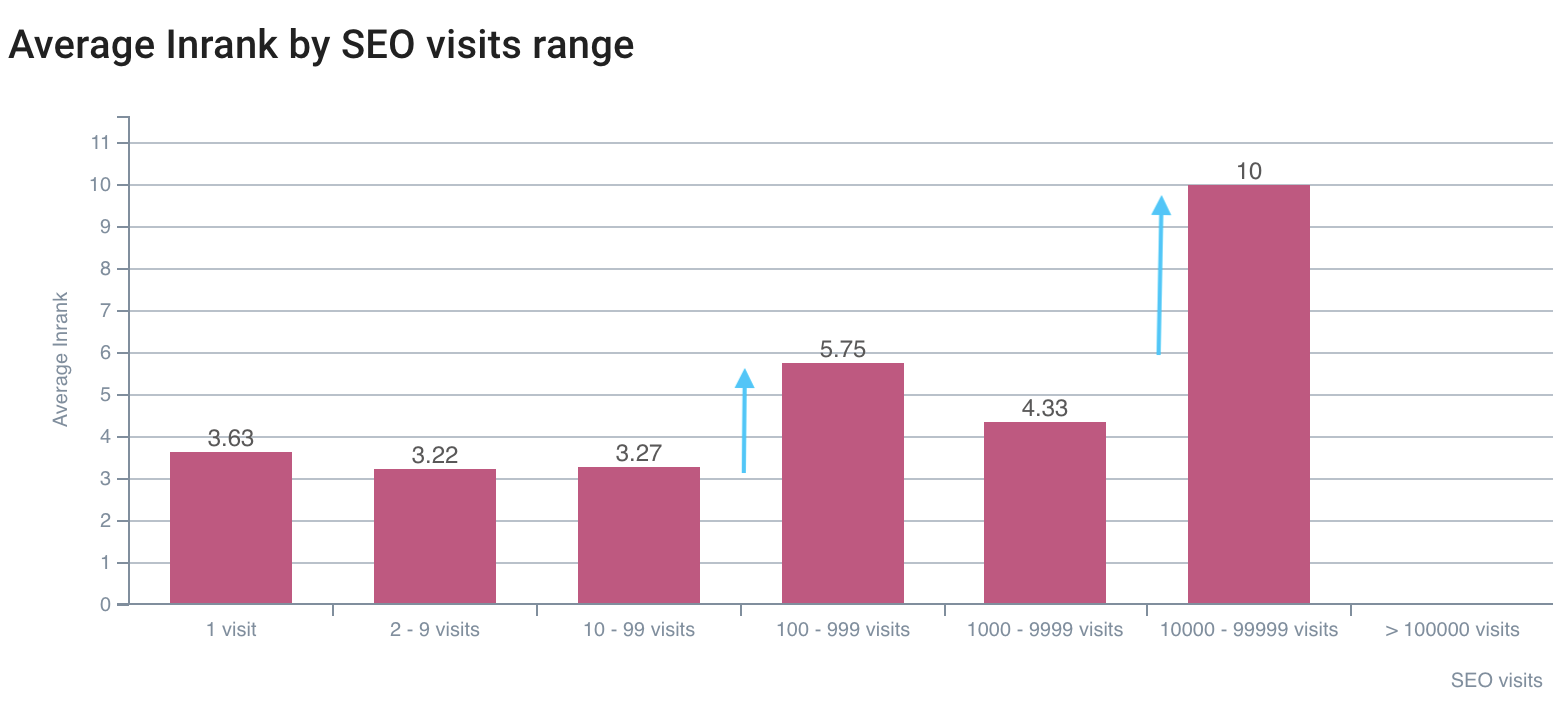

5# Bestimmen Sie, wie SEO-Ranking-Faktoren Ihre Crawl-Frequenz beeinflussen

Stellen Sie sich vor, Sie wüssten, auf welche Werte Sie abzielen müssen, um Ihre SEO zu maximieren? Dafür ist die datenübergreifende Analyse gemacht! Damit können Sie für jede Metrik genau bestimmen, bei welcher Schwelle Crawling-Frequenz, Crawling-Rate oder Aktivität maximiert werden.

Wir haben oben – am Beispiel über die Anzahl der Wörter pro Seite und die Crawl-Frequenz – gesehen, dass es Trigger-Werte für die Crawl-Frequenz gibt. Diese Lücken müssen für jeden Seitentyp analysiert und verglichen werden, da wir nach Spitzen im Bot-Verhalten oder bei SEO-Besuchen suchen.

Wie die unten vorgestellten:

Die Crawl-Frequenz hat eine Lücke bei 100+ Inlinks

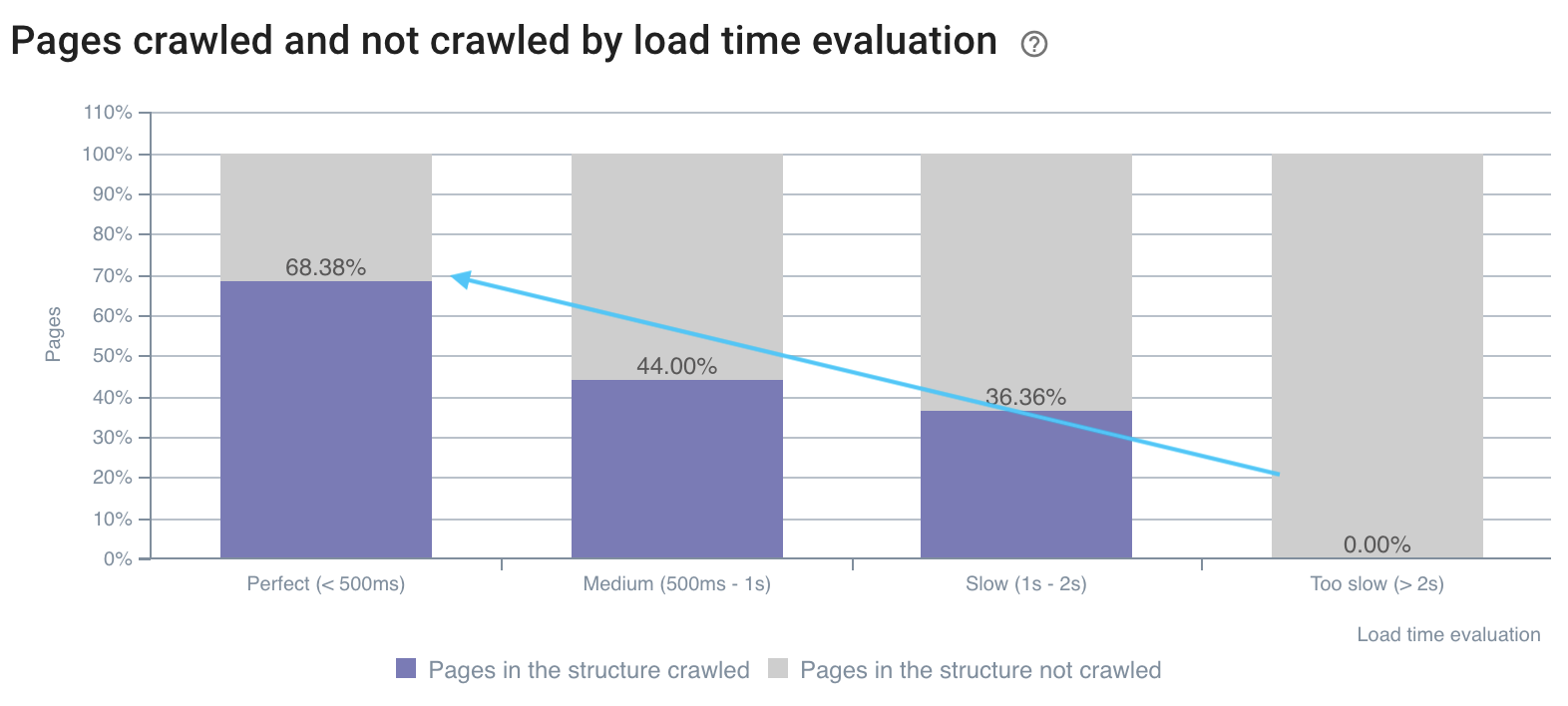

Die Crawling-Rate ist auf schnellen Seiten besser

Die erste Lücke bei SEO-Besuchen liegt bei InRank 5,75, die beste bei InRank 10 (Homepage)

Durch die Kombination von Crawl- und Protokolldaten können Sie die Google-Blackbox öffnen und die Auswirkungen Ihrer Metriken auf das Crawlen und die Besuche von Bots genau bestimmen. Wenn Sie Ihre Optimierungen anhand dieser Analysen implementieren, können Sie Ihre SEO zum Zeitpunkt jeder Ihrer Veröffentlichungen verbessern. Diese erweiterte Nutzung ist dauerhaft, da Sie bei jeder datenübergreifenden Analyse neue zu erreichende Werte erkennen können.

Gibt es noch andere Tricks mit datenübergreifender Analyse, die Sie teilen möchten?