[ملخص ندوة الويب] تحسين محركات البحث في Orbit: وجهات نظر جديدة حول المحتوى المكرر

نشرت: 2019-11-20ندوة الويب وجهات النظر الجديدة حول المحتوى المكرر هي الحلقة الأخيرة من SEO في سلسلة Orbit ، وتم بثها في 24 يونيو 2019. في هذه الحلقة ، انضم إلى OnCrawl Ambassador Omi Sido و Alexis Sanders أثناء استكشاف مسألة المحتوى المكرر. يعالجون أسئلة مثل: كيف تؤثر عوامل الترتيب وتقنيات البحث المتطورة على الطريقة التي نتعامل بها مع المحتوى المكرر؟ و: ما الذي يحمله المستقبل لمحتوى مماثل على الويب؟

SEO في Orbit هي أول سلسلة ندوات عبر الإنترنت ترسل تحسين محركات البحث إلى الفضاء. خلال السلسلة ، ناقشنا حاضر ومستقبل تحسين محركات البحث التقني مع بعض أفضل المتخصصين في تحسين محركات البحث وأرسلنا نصائحهم إلى الفضاء في 27 يونيو 2019.

شاهد الإعادة هنا:

تقديم الكسيس ساندرز

يعمل Alexis Sanders كمدير حساب تقني لتحسين محركات البحث في شركة Merkle. يضمن الفريق الفني لتحسين محركات البحث دقة وجدوى وقابلية التوسع في التوصيات الفنية للوكالة عبر جميع القطاعات. وهي من المساهمين في مدونة Moz وصنعت تحدي TechnicalSEO.expert ومحسن محركات البحث في بودكاست Lab.

استضافت هذه الحلقة أومي سيدو. أومي هو متحدث دولي متمرس ومعروف في الصناعة بروح الدعابة وقدرته على تقديم رؤى قابلة للتنفيذ يمكن للجمهور البدء في استخدامها على الفور. من استشارة تحسين محركات البحث مع بعض أكبر شركات الاتصالات والسفر في العالم إلى إدارة تحسين محركات البحث الداخلية في HostelWorld و Daily Mail ، يحب Omi الغوص في البيانات المعقدة والعثور على النقاط المضيئة. حاليًا ، Omi هو أحد كبار المسئولين الاقتصاديين التقنيين في Canon Europe وسفير OnCrawl.

ما هو المحتوى المكرر؟

يقدم Omi التعريف التالي للمحتوى المكرر:

محتوى مكرر مشابه أو مشابه تقريبًا لمحتوى موجود على عنوان URL مختلف على نفس موقع الويب (أو موقع مختلف).

أسطورة عقوبة المحتوى المكرر

لا يوجد محتوى مكرر عقوبة.

هذه مشكلة في الأداء. لا نريد أن ينظر الروبوت إلى عنواني URL محددين ونعتقد أنهما محتوىان مختلفان يمكن ترتيبهما بجانب بعضهما البعض.

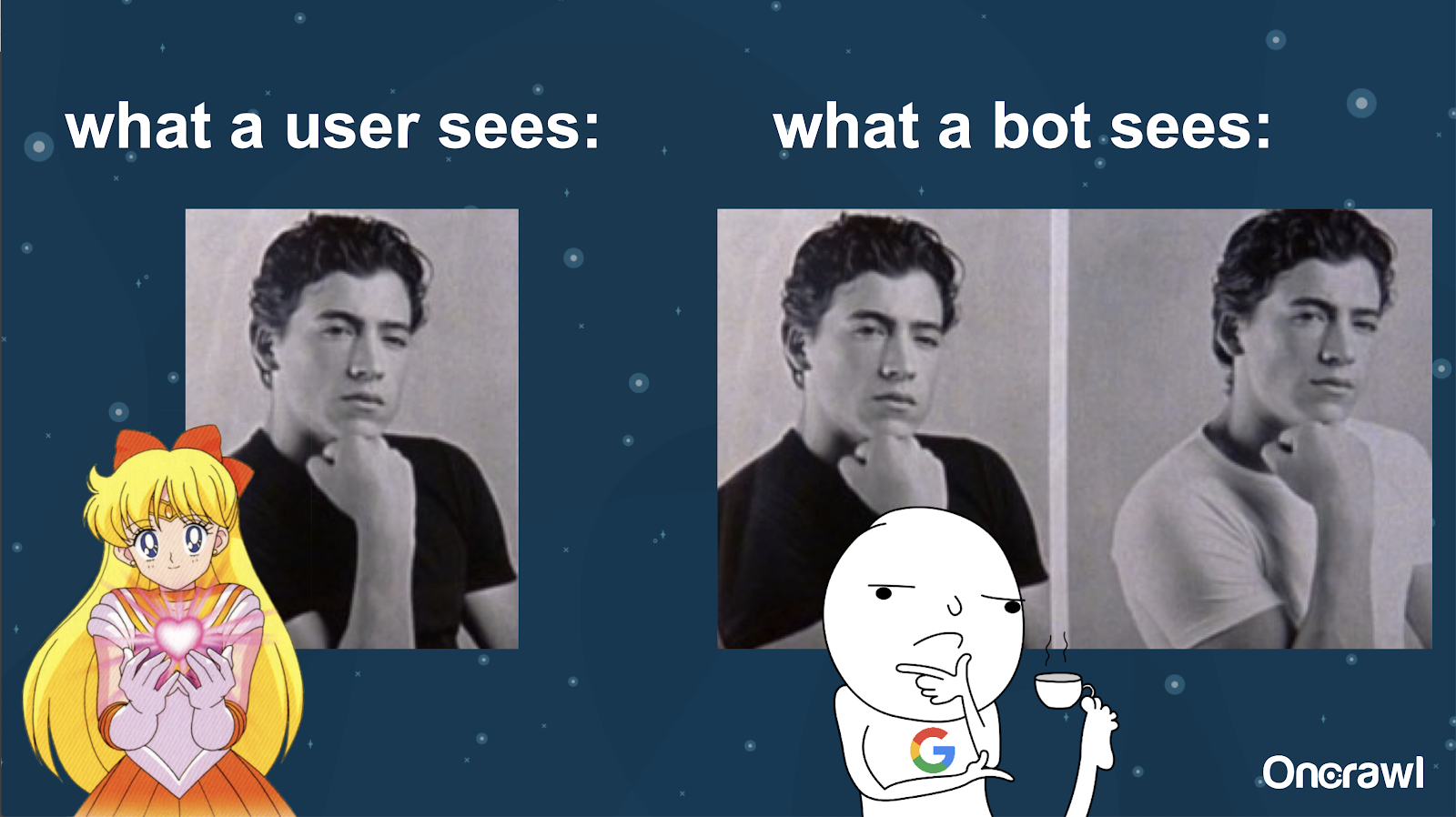

يقارن Alexis فهم الروبوت لموقعك على الويب بصور Joey من 10 أشياء أنا أكرهها فيك: من المستحيل أن يجد الروبوت فرقًا جوهريًا بين النسختين.

تريد تجنب وجود شيئين متشابهين يجب أن يتنافس كل منهما مع الآخر في حالة تصنيف محرك البحث. بدلاً من ذلك ، تريد الحصول على تجربة واحدة موحدة يمكنها الترتيب والأداء في محركات البحث.

الفرق بين ما يراه المستخدمون والروبوتات

قد يرى المستخدم عنوان URL واحدًا مقنعًا ، ولكن قد يستمر الروبوت في رؤية إصدارات متعددة تبدو مماثلة له بشكل أساسي.

- التأثير على ميزانية الزحف لموقع كبير جدًا

بالنسبة للمواقع الكبيرة جدًا ، مثل Zillow أو Walmart ، يمكن أن تختلف ميزانية الزحف باختلاف الصفحات.

كما ناقش Alexis في مقال عام 2018 استنادًا إلى عرض تقديمي بواسطة Frederic Dubut في SMX East ، يتم تعيين الميزانيات على مستويات مختلفة - على مستويات النطاق الفرعي ، على مستويات خادم مختلفة. تريد محركات البحث ، سواء كانت Google أو Bing ، أن تكون برامج زحف مهذبة ؛ لا يريدون إبطاء أداء المستخدمين الفعليين. كلما شعروا بتغيير في الأداء ، سوف يتراجعون. يمكن أن يحدث هذا على مستويات مختلفة ، وليس على مستوى الموقع فقط.

إذا كان لديك موقع ضخم ، فأنت تريد أن تتأكد من أنك تقدم التجربة الأكثر توحيدًا الملائمة لمستخدميك.

هل المحتوى المكرر محتوى أم مشكلة فنية؟

على الرغم من كلمة "محتوى" في "محتوى مكرر" ، إلا أنها مشكلة فنية جزئيًا.

- مصادر الازدواج - [07:50]

هناك العديد من العوامل التي يمكن أن تسبب الازدواجية. حتى القائمة الجزئية يمكن أن تستمر إلى الأبد:

- صفحات متكررة

- مواقع التدريج

- HTTP مقابل HTTPS URLS

- نطاقات فرعية مختلفة

- حالات مختلفة

- امتدادات الملفات المختلفة

- زائدة مائلة

- صفحات الفهرس

- معلمات URL

- جوانب

- أنواع

- طابعة سهلة النوع

- صفحة المدخل

- المخزون

- المحتوى المنشور

- إصدارات العلاقات العامة

- إعادة نشر المحتوى

- محتوى مسروق

- المحتوى المترجم

- محتوى ضعيف

- فقط الصور

- البحث الداخلي في الموقع

- موقع منفصل للجوال

- محتوى غير فريد

- ...

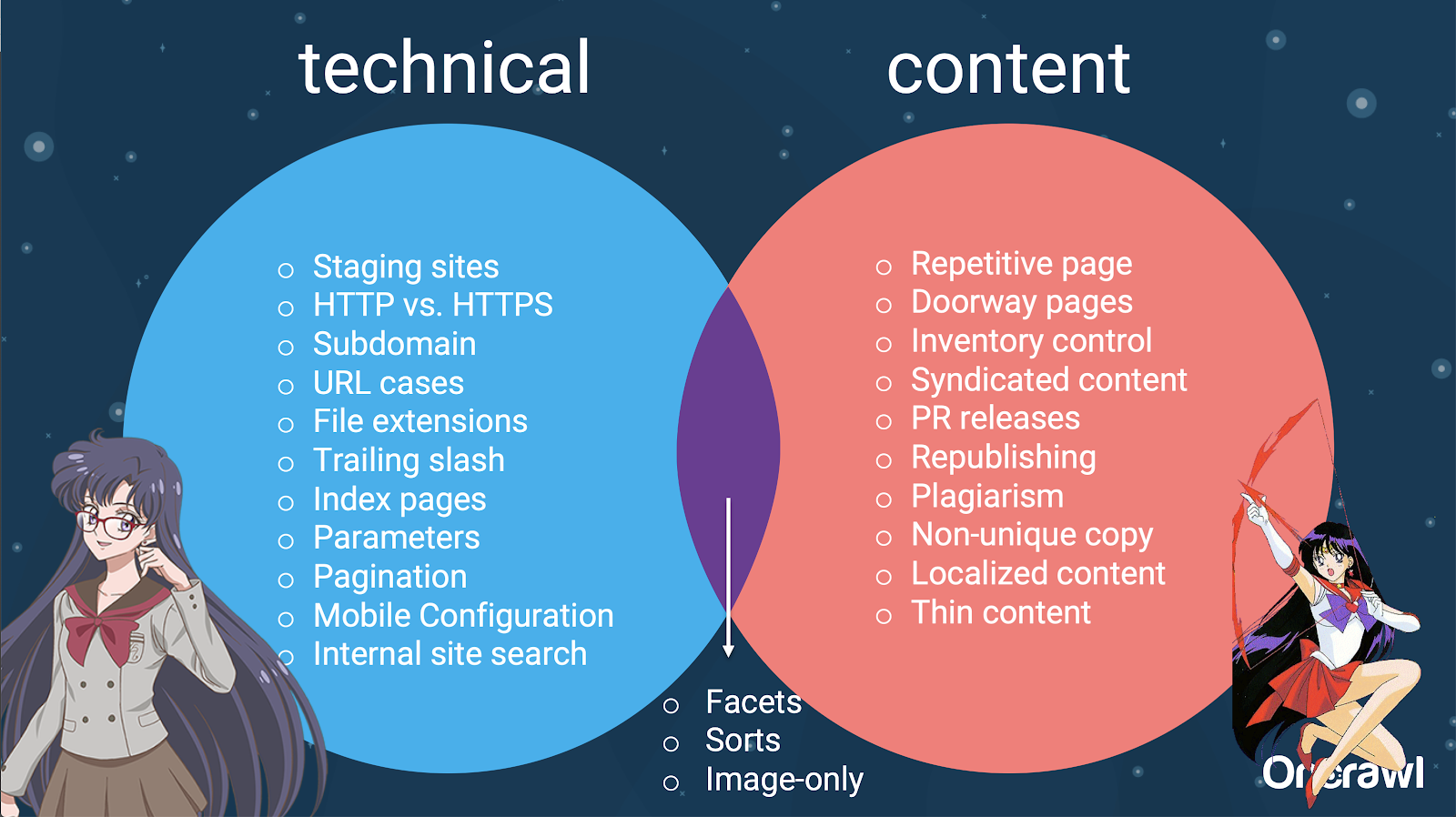

- توزيع القضايا بين تحسين محركات البحث الفني والمحتوى

في الواقع ، يمكن تقسيم مصادر المحتوى المكرر هذه إلى مصادر تقنية ومصادر تطوير ومصادر قائمة على المحتوى ، وبعضها يقع في منطقة متداخلة بين الاثنين.

هذا يجعل المحتوى المكرر مشكلة مشتركة بين الفريق ، وهو جزء مما يجعله ممتعًا للغاية.

كيفية البحث عن محتوى مكرر

معظم المحتوى المكرر غير مقصود. بالنسبة إلى Omi ، يشير هذا إلى وجود مسؤولية مشتركة بين المحتوى والفرق الفنية للعثور على المحتوى المكرر وإصلاحه.

- الأداة المفضلة Omi: Grammarly

Grammarly هي أداة Omi المفضلة للعثور على محتوى مكرر - وهي ليست حتى أداة تحسين محركات البحث. يستخدم مدقق الانتحال. يطلب من ناشر المحتوى التحقق لمعرفة ما إذا كان قد تم نشر جزء جديد من المحتوى بالفعل في أي مكان آخر.

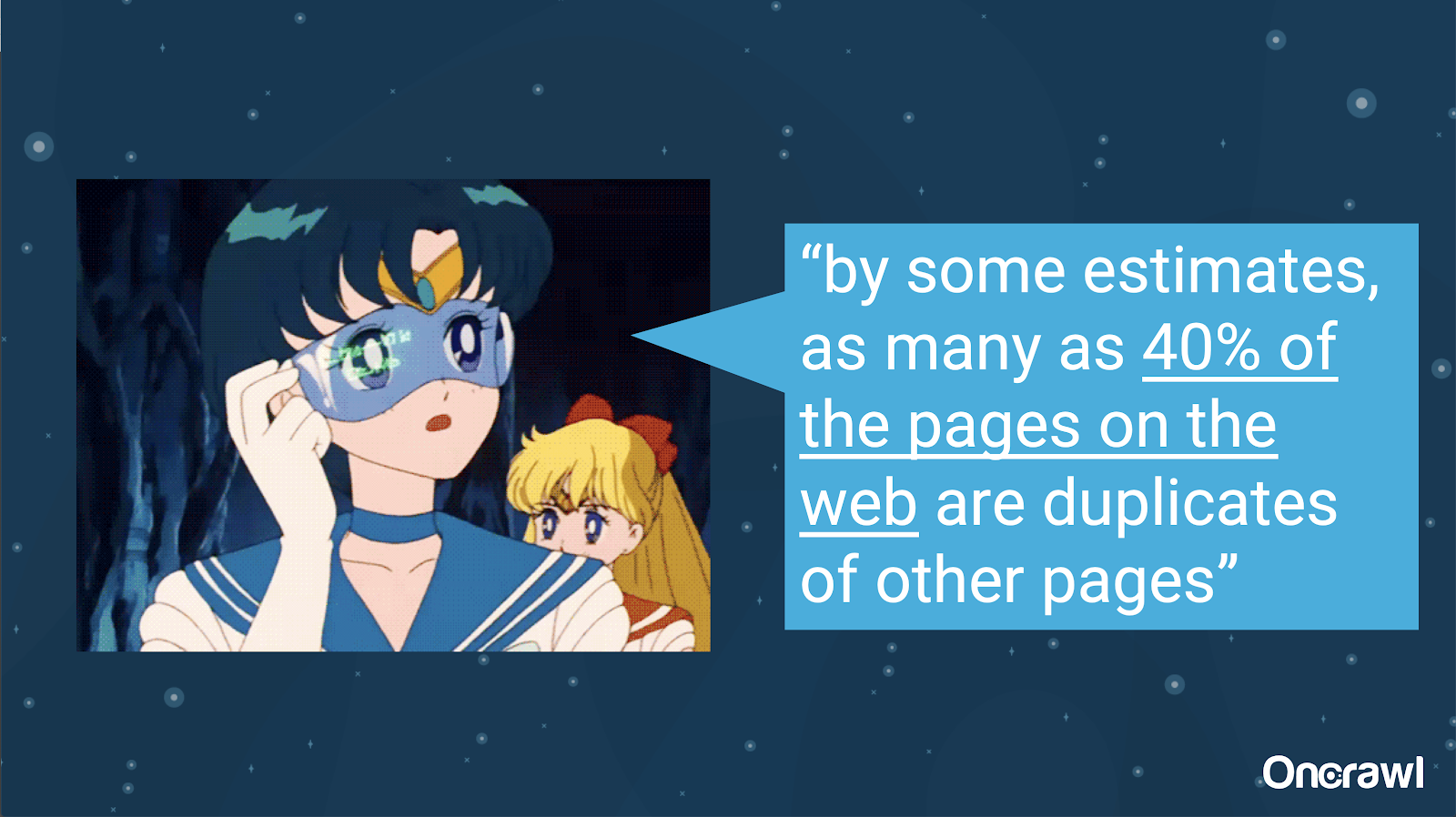

- حجم المحتوى المكرر غير المقصود

إن مشكلة المحتوى المكرر غير المقصود هي مشكلة مألوفة لدى المهندسين. في كتاب بعنوان مقدمة إلى استرداد المعلومات (2008) ، والذي من الواضح أنه عفا عليه الزمن ، قدروا أن حوالي 40 ٪ من الويب في ذلك الوقت قد تم نسخه.

- تحديد أولويات استراتيجيات التعامل مع المحتوى المكرر

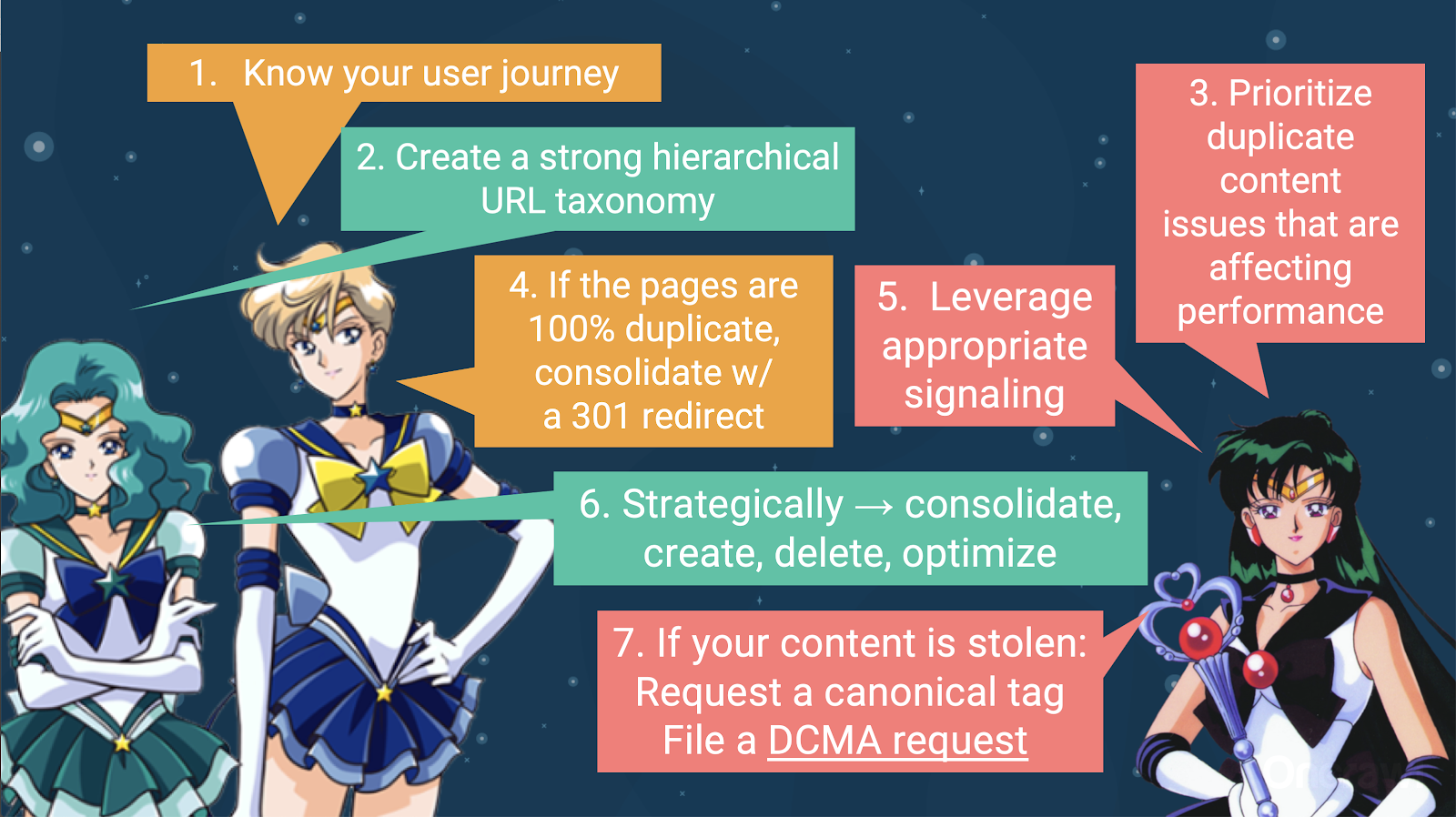

للتعامل مع المحتوى المكرر ، يجب عليك:

- ابدأ بمعرفة رحلة المستخدم الخاصة بك ، مما سيساعدك على فهم مكان كل جزء من المحتوى. قد يكون هذا أمرًا صعبًا للغاية ، لا سيما عندما تم إنشاء مواقع الويب قبل 20 عامًا ، عندما لم نكن نعرف حجمها أو كيف يمكن أن تتسع. ستساعدك معرفة مكان وجود المستخدم في أي نقطة معينة في رحلتهم على تحديد الأولويات في بعض الخطوات التالية.

- ستحتاج إلى تسلسل هرمي يعمل ، من أجل توفير مكان لكل نوع من أنواع المحتوى. يعتبر فهم بنية المعلومات الخاصة بك أمرًا كبيرًا في خطوات التعامل مع المحتوى المكرر.

- إعطاء الأولوية للمحتوى المكرر الذي يؤثر على الأداء. القائمة الجزئية للمصادر أعلاه طويلة جدًا بحيث لا يمكنك مهاجمتها بواقعية جميعًا مرة واحدة.

- تعامل مع الازدواجية بنسبة 100٪

- إشارة مكررة المحتوى

- اتخذ خيارًا استراتيجيًا حول كيفية التعامل مع الازدواجية: التوحيد ، الإنشاء ، الحذف ، التحسين

- تعامل مع المحتوى المسروق

- الأدوات: استخدام التجزئة في OnCrawl

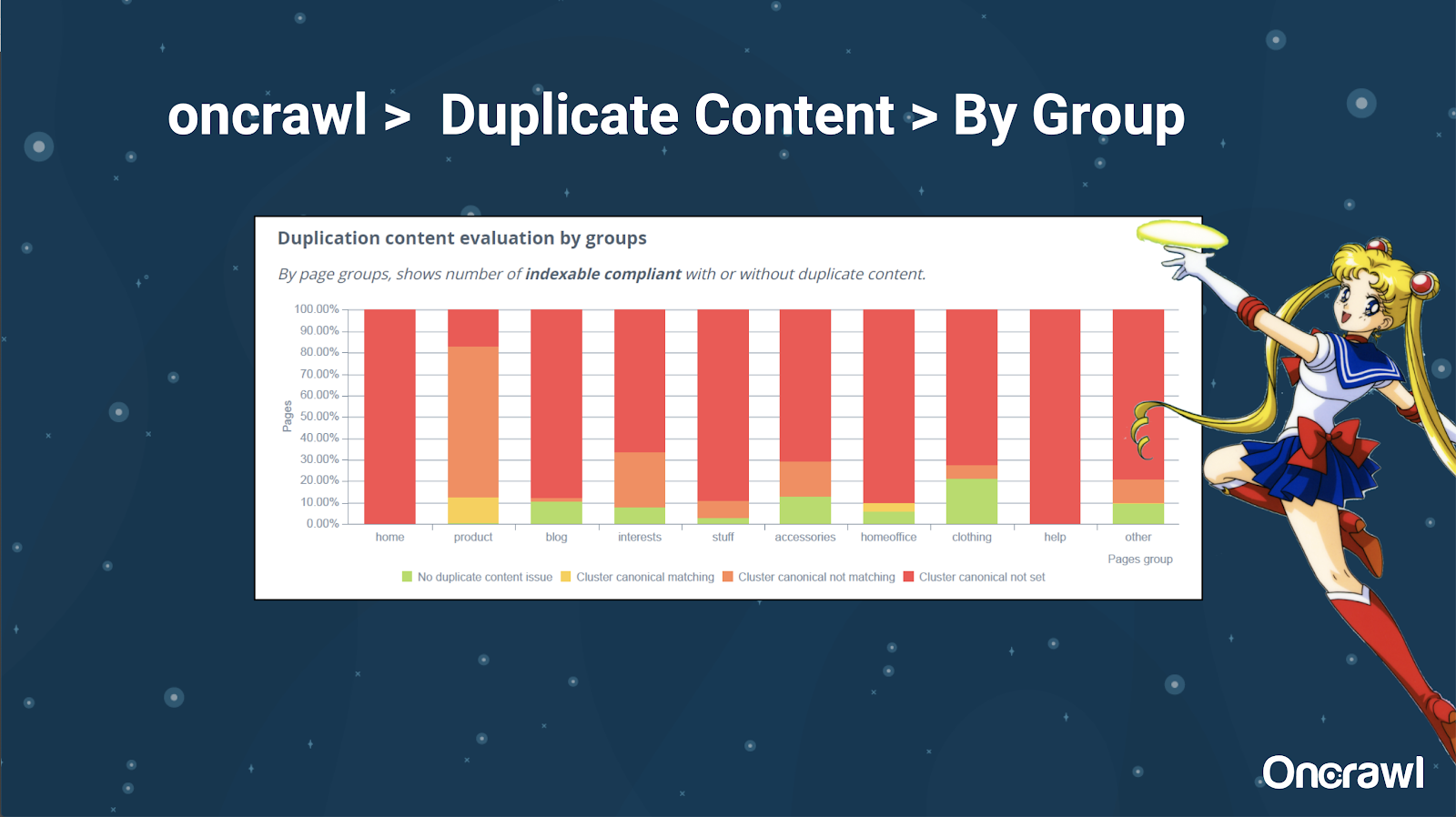

يحب Alexis حقًا القدرة على تقسيم موقع الويب الخاص بك في OnCrawl ، مما يتيح لك الغوص في الأشياء ذات الأهمية بالنسبة لك.

أنواع الصفحات المختلفة لها كميات مختلفة من الازدواجية ؛ يتيح ذلك الحصول على عرض للأقسام التي بها معظم المشكلات. في المثال أعلاه ، يحتاج الموقع إلى الكثير من الاهتمام.

- الأدوات: بحث Google و GSC

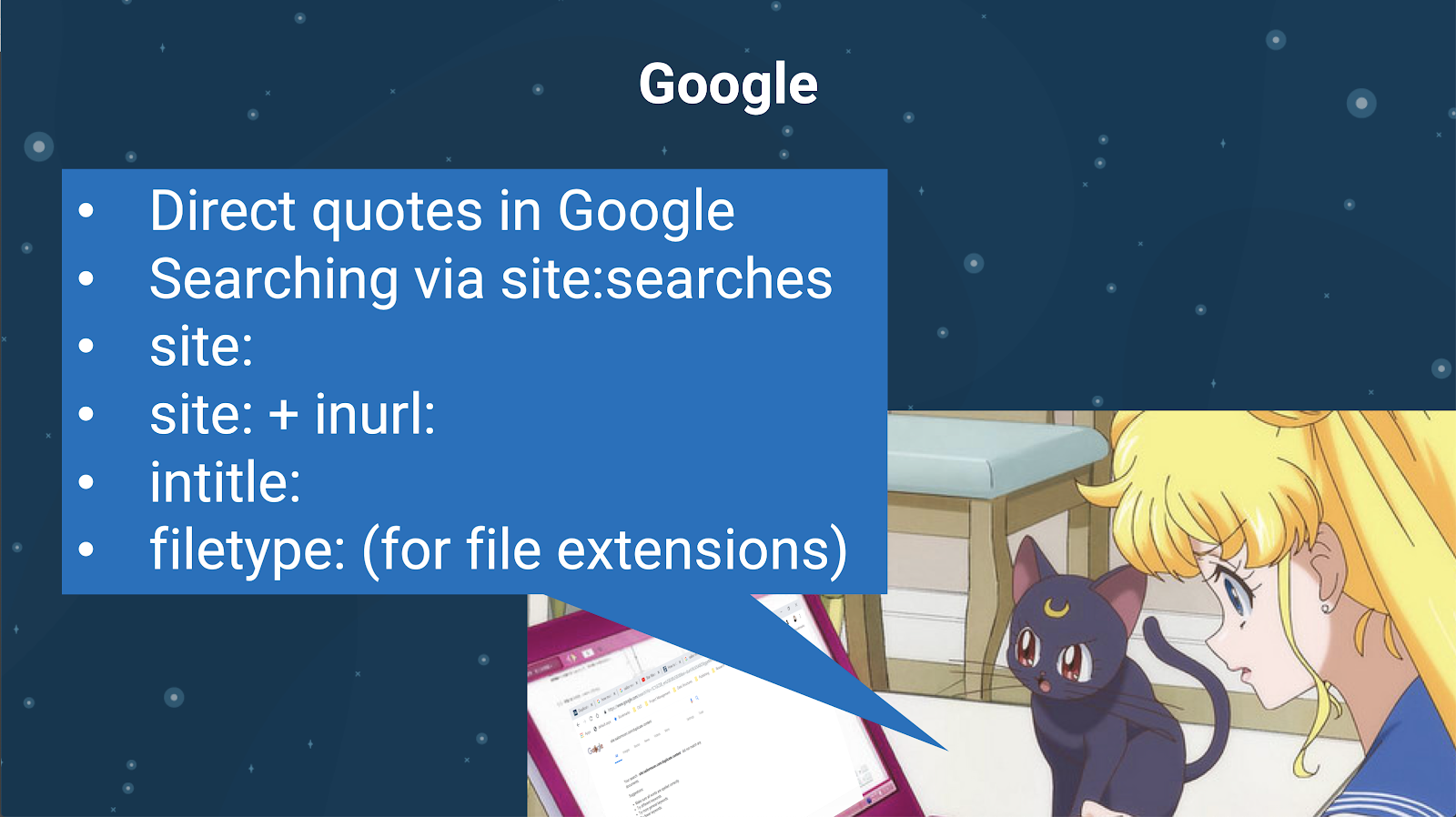

يمكنك أيضًا التحقق من وجود محتوى مكرر باستخدام محرك البحث نفسه. في جوجل يمكنك:

- استخدم الاقتباسات المباشرة

- استخدام الموقع: عمليات البحث

- استخدام عوامل تشغيل إضافية مثل inurl: أو intitle: أو filetype:

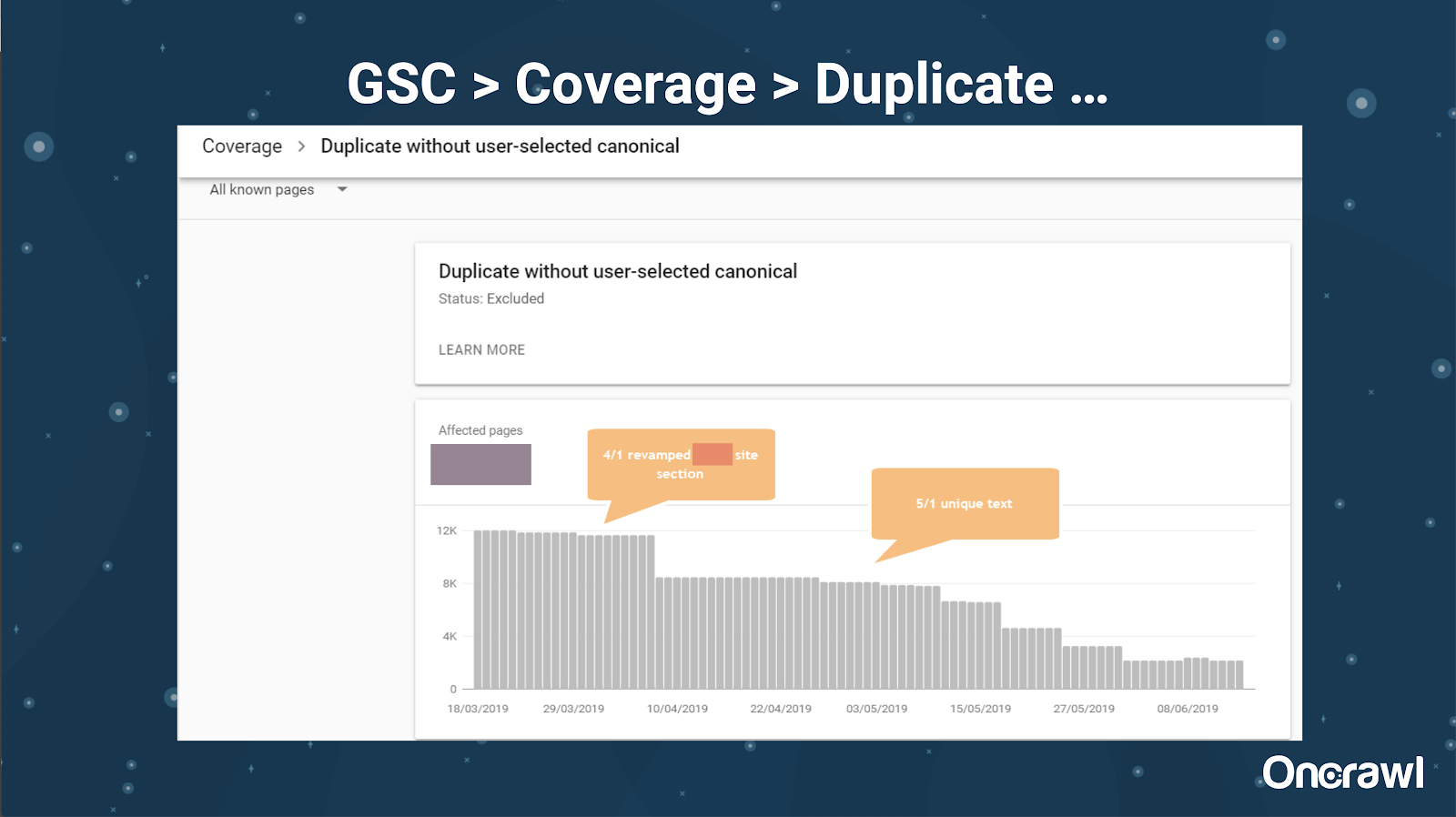

أضافت Google Search Console أيضًا تقرير محتوى مكررًا ، وهو مفيد جدًا في تحديد ما تعتقد Google أنه محتوى مكرر من جانبهم.

- الأدوات: أدوات الانتحال

مثل Omi ، يستخدم Alexis أيضًا أدوات سرقة أدبية مختلفة:

Quetext

نوبلاغ

PaperRater

نحوي

كوبيسكيب

تريد التأكد من أن المحتوى الخاص بك ليس أصليًا فقط ، ولكن أيضًا من منظور الروبوت ، وأنه لا يُنظر إليه على أنه مستمد من مصدر آخر.

يمكن أن تساعدك هذه أيضًا في العثور على أجزاء داخل مقالة قد تكون مشابهة للمحتوى في أي مكان آخر على الإنترنت.

يحب Alexis الطريقة التي نمتلك بها هذه الأدوات التي تسمح لنا بأن نكون "متعاطفين مع روبوتات محركات البحث" ، حيث لا أحد منا ليس روبوتات. عندما تعطينا الأدوات إشارات إلى أن المحتوى متشابه للغاية ، حتى لو علمنا بوجود اختلاف ، فهذه علامة جيدة على وجود شيء يجب البحث فيه.

- الأدوات: أدوات كثافة الكلمات الرئيسية

مثالان على أدوات كثافة الكلمات الرئيسية التي يستخدمها Alexis هما:

TagCrowd

SEObook

تعتمد المشكلات على نوع الموقع

يعتمد حل المحتوى المكرر حقًا على نوع المحتوى الذي تنشره ونوع المشكلة التي تواجهها. لا تواجه المدونات نفس حالات المحتوى المكرر مثل مواقع التجارة الإلكترونية ، على سبيل المثال.

حالات لا تنسى

تشارك Alexis حالات العملاء الأخيرة حيث وجدت مشكلات محتوى مكررة لا تُنسى.

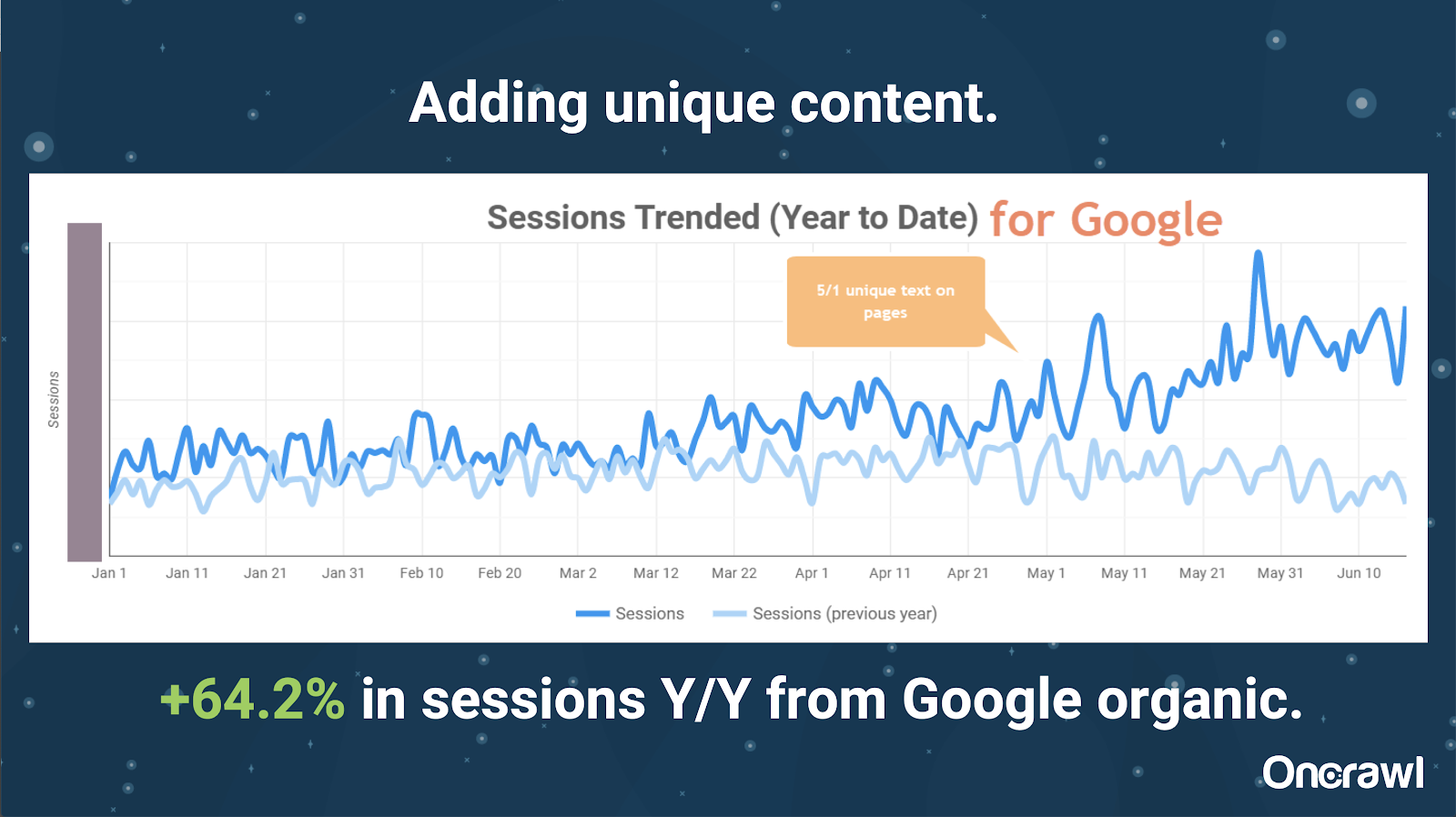

- موقع كبير للغاية: النتائج بعد إضافة محتوى فريد

كان هذا الموقع كبيرًا بشكل كبير ، ويواجه مشكلات تتعلق بالزحف في الميزانية. يحتوي على 86 مليون صفحة لم يتم فهرستها بعد ، وتم فهرسة حوالي 1 ٪ فقط من صفحاته.

هذا موقع عقاري ، الكثير من المحتوى ليس فريدًا بشكل خاص ، والكثير من صفحاته متشابهة جدًا جدًا. انتهى الأمر بـ Alexis بإضافة محتوى إلى الصفحة لإضافة معلومات خاصة بالموقع لتمييز الصفحات. كان من المدهش مدى السرعة التي أدى بها هذا إلى النتائج. (هذه مجرد بيانات عضوية من Google).

بالنسبة إلى Alexis ، هذه دراسة حالة عامة جدًا. بقدر ما نتحدث عن EAT وأشياء مماثلة اليوم ، فإن هذا يوضح أنه بمجرد أن ترى محركات البحث أن المحتوى فريد وقيِّم ، فلا يزال يتم مكافأته.

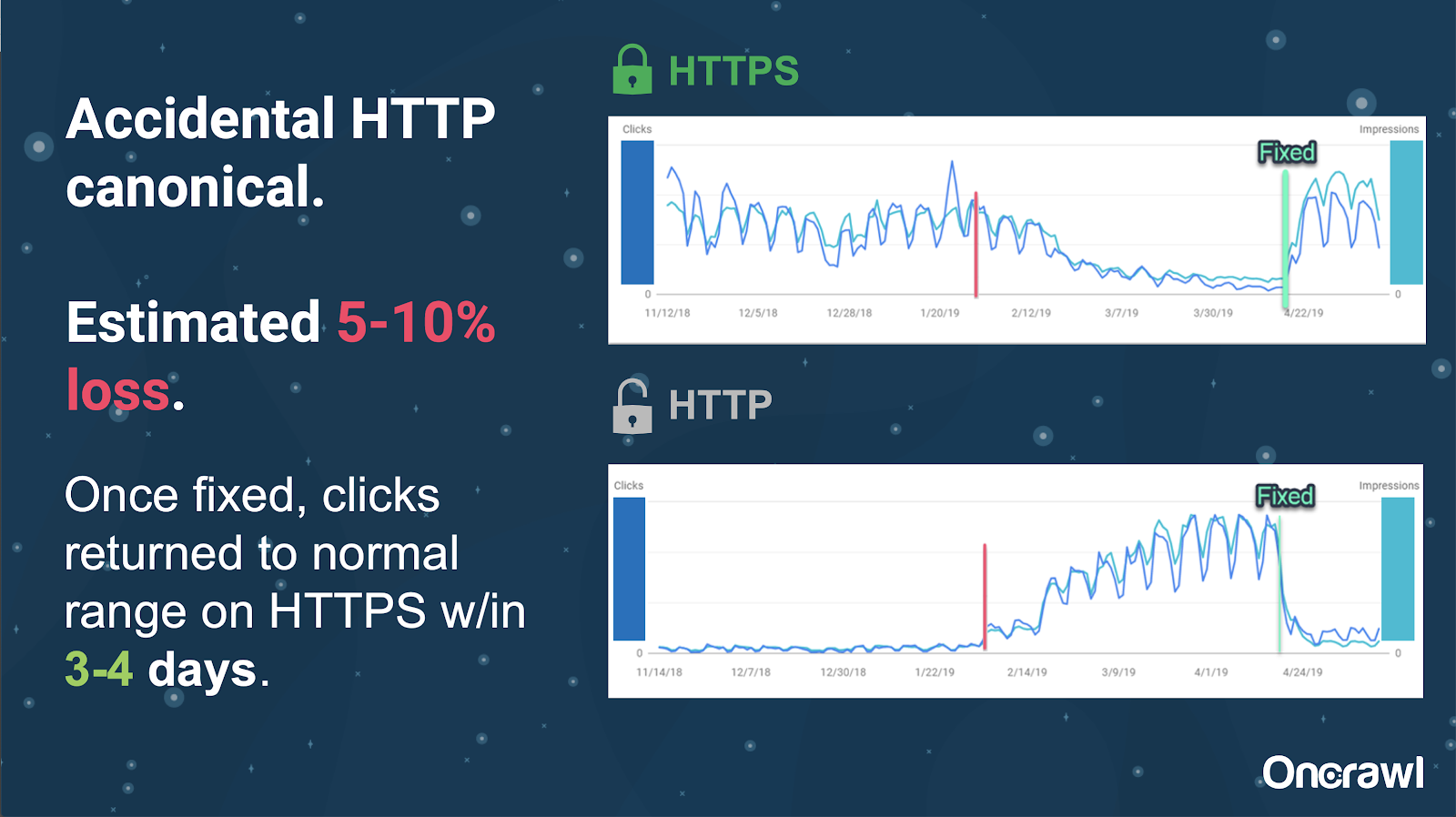

على هذا الموقع ، تسببت مشكلة علامة أساسية عرضية في إرسال حوالي 250 صفحة إلى البروتوكول الخطأ.

هذه إحدى الحالات التي تشير فيها العلامات الأساسية إلى الصفحة الرئيسية الخاطئة ، مما يؤدي إلى دفع صفحات HTTP بدلاً من صفحة HTTPS.

التغييرات في الـ 18 شهرًا الماضية

كتب Alexis مقالة كاملة للغاية ، محتوى مكرر ودقة استراتيجية ، قبل حوالي 18 شهرًا من هذه الندوة عبر الإنترنت. يتغير مُحسّنات محرّكات البحث بسرعة ، وتحتاج باستمرار إلى تجديد معلوماتك وإعادة تقييمها.

بالنسبة إلى Alexis ، لا يزال معظم ما ورد في المقالة مناسبًا اليوم ، باستثناء rel = next / prev. وتأمل في أن تتوقف أهميتها في غضون السنوات الخمس إلى العشر القادمة.

المشكلات الفنية التي عالجها المطورون: يدويًا جدًا

العديد من المشكلات المتعلقة بالمحتوى المكرر التي يتعامل معها المطورون هي طريقة يدوية للغاية. يعتقد Alexis أنه يجب التعامل معها بدلاً من ذلك بواسطة CMSs و Adobe. على سبيل المثال ، لا يجب أن تمر يدويًا وتأكد من أن جميع العناصر الأساسية مضبوطة ومتماسكة.

- فرص الأتمتة / الإخطار

هناك الكثير من الفرص للأتمتة في مجال المشكلات الفنية ذات المحتوى المكرر. لإعطاء مثال: يجب أن نكون قادرين على اكتشاف ما إذا كانت أي روابط ستنتقل إلى HTTP على الفور عندما يجب أن تنتقل إلى HTTPS ، وتصحيحها.

- عمر الموقع والبنية التحتية القديمة كعائق

بعض الأنظمة الخلفية قديمة جدًا بحيث لا تدعم بعض التغييرات والأتمتة. من الصعب للغاية ترحيل نظام CMS قديم إلى نظام جديد. يعطي Omi مثالاً على ترحيل مواقع Canon الإلكترونية إلى CMS جديد مصمم خصيصًا. لم تكن باهظة الثمن فحسب ، بل استغرقت 12 شهرًا.

Rel prev / next والتواصل من Google

أحيانًا يكون الاتصال من Google محيرًا بعض الشيء. يستشهد أومي بمثال حيث شهد عميله ، عند تطبيق rel = prev / next ، زيادة كبيرة في الأداء في عام 2018 ، على الرغم من إعلان Google لعام 2019 أن هذه العلامات لم تُستخدم منذ سنوات.

- عدم وجود حلول ذات مقاس واحد يناسب الجميع

تكمن الصعوبة في مُحسّنات محرّكات البحث في أن ما يلاحظه شخص ما يحدث على موقعه على الويب ليس بالضرورة هو نفسه ما يراه مُحسِّن محركات بحث آخر على موقعه على الويب ؛ لا يوجد حجم واحد يناسب الجميع لتحسين محركات البحث.

يجب الاعتراف بقدرة Google على إصدار إعلانات ذات صلة بجميع مُحسّنات محرّكات البحث باعتبارها إنجازًا كبيرًا ، حتى أن بعض عباراتهم فاشلة ، كما في حالة rel = next / prev.

آمال مستقبل إدارة المحتوى المكرر

آمال أليكسيس في المستقبل:

- محتوى مكرر يعتمد على التقنية أقل (كما هو الحال في أنظمة إدارة المحتوى).

- المزيد من الأتمتة (اختبار الوحدة والاختبار الخارجي). على سبيل المثال ، قد تقوم أدوات مثل OnCrawl بالزحف بانتظام إلى موقعك وإعلامك بمجرد ملاحظة بعض الأخطاء.

- اكتشف تلقائيًا الصفحات عالية التشابه وأنواع الصفحات للكتاب ومديري المحتوى. سيؤدي ذلك إلى أتمتة بعض عمليات التحقق التي يتم إجراؤها يدويًا حاليًا في أدوات مثل Grammarly: عندما يحاول شخص ما النشر ، يجب أن يقول نظام إدارة المحتوى "هذا نوع من التشابه - هل أنت متأكد من أنك تريد نشر هذا؟" هناك قيمة كبيرة في النظر إلى مواقع الويب الفردية وكذلك في المقارنة عبر مواقع الويب.

- تواصل Google تحسين أنظمتها الحالية واكتشافها.

- ربما يكون هناك نظام تنبيه لتصعيد مشكلة جوجل بعدم استخدام القانون الأساسي الصحيح. سيكون من المفيد أن تكون قادرًا على تنبيه Google بالمشكلة وحلها.

نحن بحاجة إلى أدوات أفضل وأدوات داخلية أفضل ، ولكن نأمل مع قيام Google بتطوير أنظمتها ، فإنها ستضيف عناصر لمساعدتنا قليلاً.

الحيل الفنية المفضلة لدى Alexis

لدى Alexis العديد من الحيل الفنية المفضلة:

- مثيل الكمبيوتر البعيد EC2. هذه طريقة رائعة حقًا للوصول إلى جهاز كمبيوتر حقيقي لعمليات الزحف الكبيرة جدًا ، أو أي شيء يتطلب الكثير من قوة الحوسبة. إنه سريع للغاية بمجرد إعداده. فقط تأكد من إنهائه عند الانتهاء ، لأنه يكلف مالاً.

- تحقق من أداة الاختبار الأولى للجوال. ذكرت Google أن هذه هي الصورة الأكثر دقة لما يبحثون عنه. إنه ينظر إلى DOM.

- تحويل وكيل المستخدم إلى Googlebot. سيعطيك هذا فكرة عما يراه Googlebots حقًا.

- استخدام أداة robots.txt الخاصة بـ TechnicalSEO.com. هذه إحدى أدوات Merkle ، لكن Alexis يحبها حقًا لأن ملف robots.txt قد يكون محيرًا حقًا في بعض الأحيان.

- استخدم محلل السجل.

- مصنوع من مدقق htaccess الخاص بـ Love.

- استخدام Google Data Studio للإبلاغ عن التغييرات (مزامنة جداول البيانات مع التحديثات ، تصفية كل صفحة حسب التحديثات ذات الصلة).

الصعوبات الفنية في تحسين محركات البحث: robots.txt

ملف robots.txt محير حقًا.

إنه ملف قديم يبدو أنه يجب أن يكون قادرًا على دعم RegEx ، لكنه لا يدعم ذلك.

لها قواعد أسبقية مختلفة لعدم السماح بالقواعد والسماح بها ، والتي يمكن أن تكون مربكة.

يمكن أن تتجاهل الروبوتات المختلفة أشياء مختلفة ، على الرغم من أنه ليس من المفترض أن تفعل ذلك.

افتراضاتك حول ما هو صحيح ليست دائمًا صحيحة.

سؤال وجواب

- HSTS: هل بروتوكول الانقسام مطلوب؟

يجب أن يكون لديك كل HTTPS للمحتوى المكرر إذا كان لديك HSTS.

- هل المحتوى المترجم مكرر؟

في كثير من الأحيان ، عندما تستخدم hreflang ، فأنت تستخدمه لإزالة الغموض بين الإصدارات المترجمة في نفس اللغة ، مثل صفحة باللغة الإنجليزية في الولايات المتحدة والأيرلندية. لن تفكر Alexis في هذا المحتوى المكرر ، لكنها ستوصي بالتأكيد بالتأكد من إعداد علامات hreflang بشكل صحيح للإشارة إلى أن هذه هي التجربة نفسها ، وقد تم تحسينها لجماهير مختلفة.

- هل يمكنك استخدام العلامات الأساسية بدلاً من عمليات إعادة التوجيه 301 لترحيل HTTP / HTTPS؟

سيكون من المفيد التحقق مما يحدث بالفعل في SERPs. إن غريزة Alexis هي القول إن هذا سيكون على ما يرام ، لكن ذلك يعتمد على كيفية تصرف Google في الواقع. من الناحية المثالية ، إذا كانت هذه هي نفس الصفحة بالضبط ، فقد ترغب في استخدام 301 ، لكنها رأت العلامات الأساسية تعمل في الماضي لهذا النوع من الترحيل. لقد شاهدت في الواقع هذا يحدث بالصدفة.

في تجربة Omi ، كان يقترح بشدة استخدام 301 لتجنب المشكلات: إذا كنت تقوم بترحيل موقع الويب ، فيمكنك أيضًا ترحيله بشكل صحيح لتجنب الأخطاء الحالية والمستقبلية.

- تأثير تكرار عناوين الصفحات

لنفترض أن لديك عنوانًا مشابهًا جدًا لمواقع مختلفة ، لكن المحتوى مختلف جدًا. على الرغم من أن هذا ليس محتوى مكررًا لـ Alexis ، إلا أنها ترى أن محركات البحث تتعامل مع هذا الأمر كنوع "شامل" ، والعناوين هي شيء يمكن استخدامه لتحديد المناطق التي بها مشكلات محتملة.

هذا هو المكان الذي قد ترغب في استخدام بحث [site: + intitle:] فيه.

ومع ذلك ، لمجرد أن لديك نفس علامة العنوان ، فلن يتسبب ذلك في مشكلة محتوى مكرر.

لا يزال يتعين عليك استهداف العناوين الفريدة والأوصاف التعريفية ، حتى في الصفحات المرقمة أو صفحات أخرى مشابهة جدًا. لا يرجع هذا إلى المحتوى المكرر ، ولكنه يتعلق بطريقة الرغبة في تحسين كيفية تقديم صفحاتك في SERPs.

أهم تلميح

"المحتوى المكرر يمثل تحديًا تقنيًا وتحديًا لتسويق المحتوى".

ذهب تحسين محركات البحث في Orbit إلى الفضاء

إذا فاتتك رحلتنا إلى الفضاء يوم 27 يونيو ، فاحصل عليها هنا واكتشف كل النصائح التي أرسلناها إلى الفضاء.