ما هو ملف robots.txt: التعريف والأهمية والأمثلة

نشرت: 2022-07-14ربما تكون قد سمعت عن قيام Google بالزحف إلى موقع الويب الخاص بنا والصفحات الموجودة على الإنترنت ثم عرضها على صفحة نتائج البحث الخاصة بهم.

حسنًا ، يخبر ملف robots.txt Google المواقع التي تتبع خوارزمياتها وأيها لا تتبع. في هذا الدليل ، شاركنا كل ما تحتاج لمعرفته حول ملف robots.txt والأمثلة وكيفية عملها.

ما هو ملف robots.txt؟

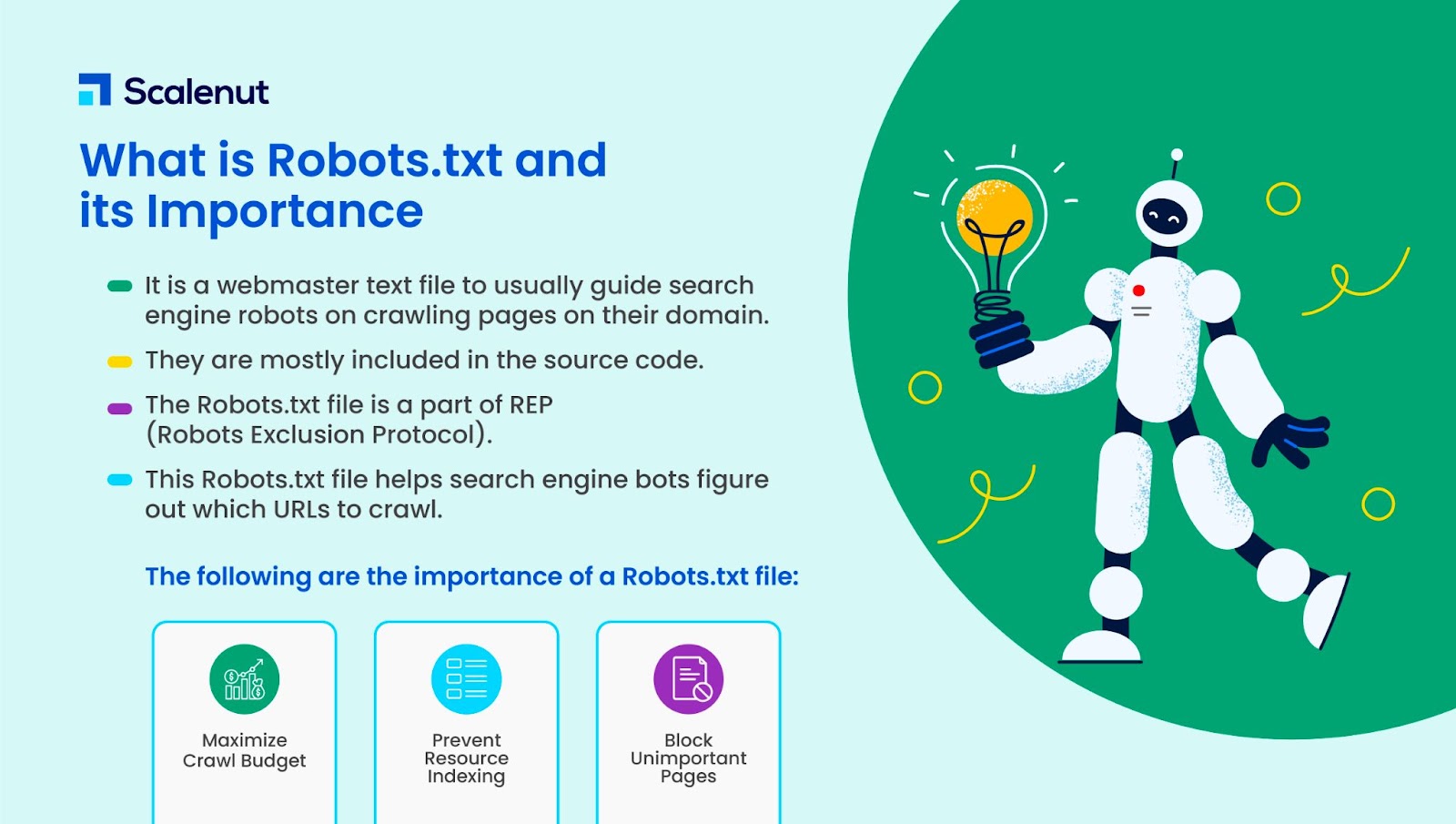

يعد ملف Robots.txt ملفًا نصيًا لمشرف الموقع لتوجيه روبوتات الويب (عادةً روبوتات محركات البحث) في الزحف إلى الصفحات الموجودة في نطاقها. بعبارة أخرى ، فإن ملف robots.txt عبارة عن مجموعة من التعليمات للروبوتات.

يتم تضمين ملف robots.txt في شفرة المصدر لمعظم مواقع الويب.

يعد ملف robots.txt جزءًا من بروتوكول استثناء الروبوتات (REP). وهي تحدد كيفية قيام الروبوتات بالزحف إلى صفحات الويب والعثور على المحتوى وفهرسته وتقديم هذه المعلومات للأشخاص الذين يريدون ذلك.

يساعد ملف Robots.txt روبوتات محرك البحث في التعرف على عناوين URL التي يجب الزحف إليها على موقعك.

ما سبب أهمية ملف robots.txt؟

هناك ثلاثة أسباب رئيسية حول كيف يمكن لملف txt مساعدتك:

- زيادة ميزانية الزحف إلى الحد الأقصى: ميزانية الزحف هي عدد الصفحات التي فهرستها برامج الروبوت في Google في إطار زمني. يمكن أن يساعد ملف robots.txt في حظر صفحات المحتوى غير المهمة أو المكررة والتركيز فقط على الصفحات المهمة بالنسبة لك ، مما يؤدي إلى زيادة ميزانية الزحف إلى الحد الأقصى وزيادة الرؤية.

- تجنب فهرسة الموارد: يمكن لملف Robots.txt فهرسة الموارد أو إلغاء فهرستها مثل ملفات PDF أو الصور. وبالتالي ، يمكن استخدام noindex أو الصفحات المحمية بكلمة مرور لحظر الصفحات أو الموارد. يمكنك التحقق من الصفحات المفهرسة باستخدام وحدة تحكم بحث Google ومعرفة ما إذا كانت الروبوتات تزحف إلى الصفحات التي تريد فهرستها.

- حظر الصفحات غير المهمة: هناك بعض الصفحات على موقع الويب الخاص بك لا تريد أن تظهر في نتائج بحث Google. قد تكون هذه هي صفحة تسجيل الدخول أو إصدار موقع الويب الخاص بك على مراحل / اختبار. باستخدام ملف robots.txt ، يمكنك حظر هذه الصفحات والتركيز فقط على الصفحات المهمة.

أمثلة على ملف robots.txt

بعض الأمثلة على ملف robots.txt هي:

وكيل المستخدم: Googlebot

Disallow: / nogooglebot /

وكيل المستخدم: *

السماح: /

خريطة الموقع: http://www.example.com/sitemap.xml

وبالمثل ، بالنسبة لمحرك بحث Bing ، فإنه يذهب:

وكيل المستخدم: Bingbot

Disallow: /example-subfolder/blocked-page.html

تساعد البنية الزاحف في تجنب الزحف إلى صفحة معينة.

تجدر الإشارة إلى أن كل نطاق فرعي يحتاج إلى ملف robots.txt الخاص به.

على سبيل المثال ، بينما يحتوي موقع www.cloudflare.com على ملف خاص به ، فإن جميع نطاقات Cloudflare الفرعية (blog.cloudflare.com و community.cloudflare.com وما إلى ذلك) تتطلب ملفات خاصة بها أيضًا.

كيف يعمل ملف Robots.txt؟

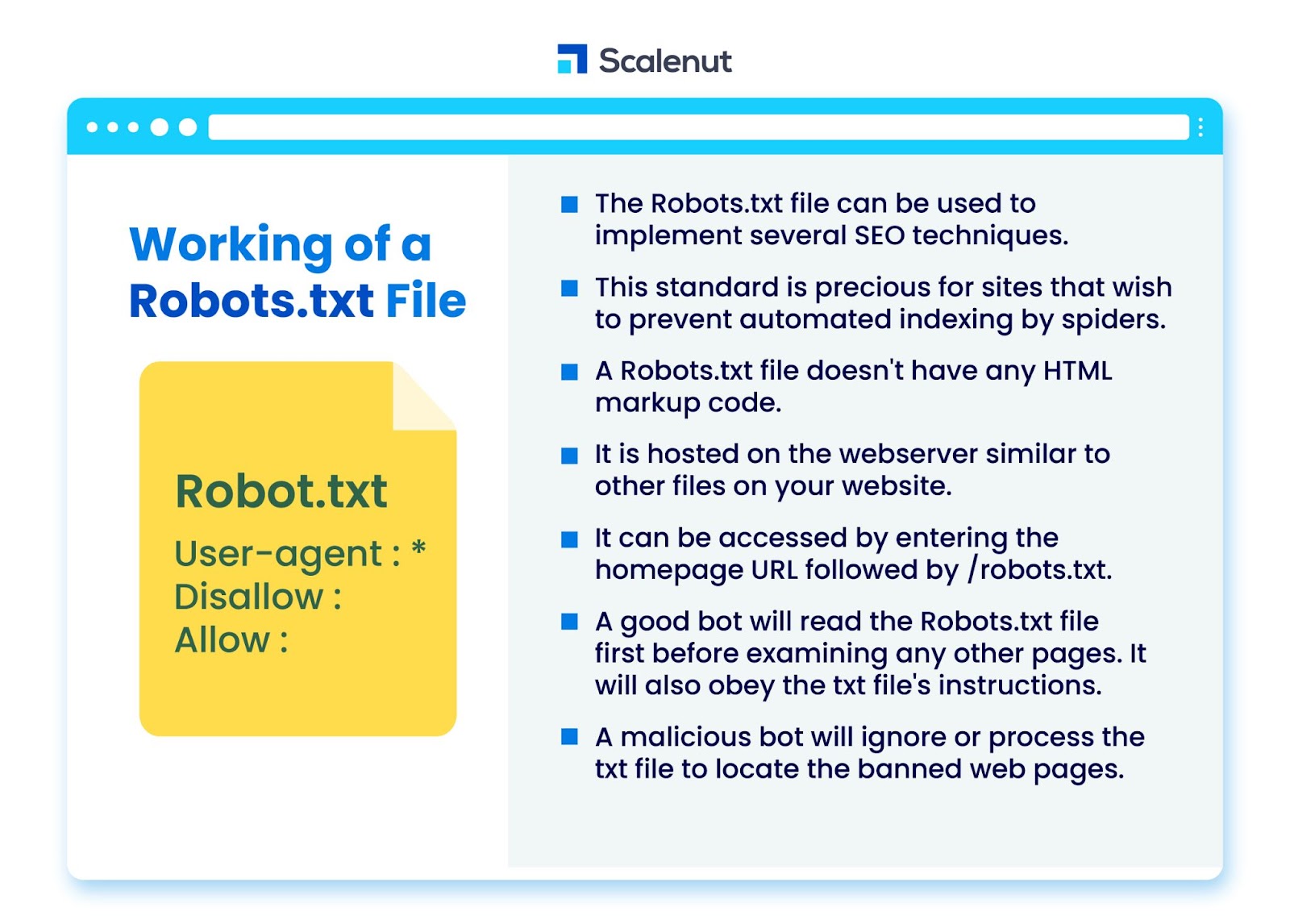

يمكن استخدام ملف robots.txt لتنفيذ العديد من تقنيات تحسين محركات البحث (SEO) ، مثل الصفحات غير المفهرسة أو ملفات robots.txt التي لا تسمح بكل أو أجزاء معينة من الموقع بواسطة برامج الروبوت.

يعتبر هذا المعيار ذا قيمة خاصة للمواقع التي ترغب في منع العناكب من فهرسة محتواها عبر عمليات آلية مثل البحث وبرامج ترتيب الصفحات باستخدام برامج زحف الويب التلقائية.

ملف robots.txt هو ملف لا يحتوي على كود ترميز HTML. يتم استضافته على خادم الويب ، تمامًا مثل الملفات الأخرى على موقع الويب الخاص بك.

يمكن الوصول إليه عن طريق إدخال عنوان URL للصفحة الرئيسية متبوعًا بـ /robots.txt. مثال عام هو https://www.xyz.com/robots.txt.

نظرًا لأن الملف غير مرتبط في أي مكان آخر على الموقع ، فمن غير المرجح أن يصادفه الزوار ، ولكن معظم روبوتات زاحف الويب ستبحث عنه قبل فهرسة بقية الموقع.

سيقرأ الروبوت الجيد ، مثل زاحف Google أو روبوت موجز الأخبار ، ملف robots.txt أولاً قبل فحص أي صفحات أخرى على الموقع والامتثال للإرشادات.

يقوم الروبوت الضار إما بتجاهل ملف robots.txt أو معالجته للعثور على صفحات الويب المحظورة.

Robots.txt حظر

يتكون ملف Robots.txt من إرشادات لإبلاغ الروبوتات بأي قواعد حظر على موقع ويب قابل للبحث وفهرسته Googlebot ، والتي تهدف إلى منع الزاحف من الوصول إلى الصفحات التي تحتوي على محتوى معين.

لا يؤثر ذلك على المستخدمين العاديين أو برامج الروبوت التي تتصفح المواقع دون الزحف إليها.

بمرور الوقت ، حظرت مواقع الويب تطبيقات الأجهزة المحمولة وجافا سكريبت وأجزاء أخرى من موقعها باستخدام هذه الطريقة مع السماح لبعض العناصر مثل الصور.

ما هي البروتوكولات المستخدمة في ملف Robots.txt؟

البروتوكول هو تنسيق لإرسال التعليمات أو الأوامر في الشبكات. تستخدم ملفات Robots.txt مجموعة متنوعة من البروتوكولات. يُعرف البروتوكول الأساسي باسم بروتوكول استبعاد الروبوتات.

يوجه الروبوتات على مواقع الويب والموارد التي يجب تجنبها.

بروتوكول خرائط المواقع هو بروتوكول آخر يتم استخدامه لملفات robots.txt. يمكن اعتبار هذا بمثابة بروتوكول لإدراج الروبوت.

تخبر ملفات Sitemap برامج زحف الويب بالصفحات التي يمكنهم الوصول إليها. يساعد هذا في ضمان عدم إغفال روبوت الزاحف لأي صفحات مهمة.

ما هو ملف Sitemap؟

ملف Sitemap هو ملف XML يصف المعلومات التي تستخدمها برامج زحف الويب لعرض صفحات موقعك. تسرد خريطة الموقع جميع عناوين URL الموجودة على موقع الويب الخاص بك ، بما في ذلك عناوينها وأوصافها والمعلومات الأخرى ذات الصلة.

يساعد هذا المستند محركات البحث في فهرسة هذه العناصر بشكل صحيح بحيث يمكن للزوار العثور عليها بسرعة باستخدام محركات البحث أو أنظمة التنقل الأخرى.

ما هو وكيل المستخدم؟

وكيل مستخدم User-agent: * disallow: / nogooglebot / user-agent user-agent: Googlebot

عدم السماح بجميع قواعد ملف robots.txt ، بغض النظر عن وكيل المستخدم. سيؤدي هذا إلى منع أي زاحف ويب من الوصول إلى موقعك. يتم استخدام هذا غالبًا بواسطة مواقع الويب الحساسة لمخاوف الخصوصية (وبالتالي لا تريد كشف بيانات مستخدميها).

تشمل أسماء وكلاء مستخدم روبوت محرك البحث الشائعة ما يلي:

جوجل :

- Googlebot

- Googlebot-Image (للصور)

- Googlebot-News (للأخبار)

- Googlebot-Video (للفيديو)

بنج:

- بينجبوت

- MSNBot-Media (للصور والفيديو)

بايدو:

- Baiduspider

ما هو ملف .txt؟

TXT هو امتداد ملف نصي يدعمه العديد من برامج تحرير النصوص.

لا يوجد مثل هذا التعريف الثابت للملف النصي ، في حين أن هناك العديد من التنسيقات الشائعة ، بما في ذلك ASCII (تنسيق عبر الأنظمة الأساسية) و ANSI (يستخدم على أنظمة DOS و Windows). TXT هو اختصار لـ TeXT. النص / العادي هو نوع MIME.

في الملف النصي robots.txt ، تحدد كل قاعدة نمط عناوين URL التي يمكن الوصول إليها من خلال جميع برامج الزحف أو برامج الزحف المحددة فقط.

يجب أن يبدأ كل سطر بنقطتين مفردتين (:) وأن يحتوي على 1-3 أسطر ، مع تجاهل الأسطر الفارغة. يتم تفسير كل سطر على أنه اسم ملف ، والذي يمكن أن يكون مطلقًا أو نسبيًا للدليل الذي تم وضعه فيه.

هل روبوتات الويب هي نفسها Robots.txt؟

قد لا تدعم بعض محركات البحث توجيهات النص.

لا يمكن للتعليمات الموجودة في ملفات robots.txt أن تجبر برامج الزحف على زيارة موقعك ؛ الأمر متروك للزاحف لمتابعتهم. في المقابل ، يتبع Googlebot وغيره من برامج زحف الويب المعروفة القواعد الموجودة في ملف robots.txt.

كيف يتم تنفيذ ملف robots.txt؟

يمكن تنفيذ ملف robots.txt في أي محرر نصوص تقريبًا. قد تقوم كل من Notepad و TextEdit و vi و emacs ، على سبيل المثال ، بإنشاء ملفات robots.txt شرعية.

فيما يلي القواعد لاتباع ملف robots.txt:

- يجب أن يكون اسم الملف robots.txt.

- يمكن استخدام ملف robots.txt لتقييد الوصول إلى النطاقات الفرعية (على سبيل المثال ، https://website.example.com/robots.txt) أو المنافذ غير القياسية.

- يجب أن يكون ملف robots.txt بتنسيق UTF-8 (الذي يتضمن ASCII). قد ترفض Google الأحرف التي ليست في نطاق UTF-8 ، مما قد يؤدي إلى إبطال لوائح ملف robots.txt.

- عادةً ما يتم العثور على ملف robots.txt في الدليل الجذر لمضيف موقع الويب الذي يتم تطبيق الملف عليه. لتمكين الزحف على جميع عناوين URL مثل https://www.example.com/ ، يجب العثور على ملف robots.txt على https://www.example.com/robots.txt. لا يمكن وضعها في دليل فرعي (على سبيل المثال ، https://example.com/pages/robots.txt).

حدود ملف Robots.txt

فيما يلي قيود ملف robots.txt:

- لا تدعم جميع محركات البحث Robots.txt: لا يمكن لملفات Robots.txt إجبار برامج الزحف على زيارة موقعك ؛ الأمر متروك للزاحف لمتابعتهم. في حين أن Googlebot وبرامج زحف الويب الأخرى الجديرة بالثقة ستتبع الإرشادات الواردة في ملف robots.txt ، فقد لا تتبع برامج الزحف الأخرى.

- تفسر برامج الزحف المختلفة البنية بشكل مختلف: على الرغم من أن عناكب الويب ذات السمعة الطيبة تلتزم بالتوجيهات في ملف robots.txt ، فقد يفسر كل زاحف التوجيهات بشكل مختلف.

- يمكن فهرسة الصفحة غير المسموح بها إذا كانت مرتبطة بصفحات أخرى: بينما لن يقوم محرك بحث Google بالزحف إلى المحتوى الذي قيده ملف robots.txt أو فهرسته ، فإنه قد يعثر على عنوان URL غير مسموح به ويفهرسه إذا كان مرتبطًا من مواقع أخرى على الإنترنت.

نتيجة لذلك ، قد يستمر ظهور عنوان URL وربما المعلومات الأخرى المتاحة للجمهور مثل نص الرابط في روابط الصفحة في نتائج بحث Google.

التعليمات

س 1. أين يذهب ملف robots.txt في الموقع؟

الإجابة: عادةً ما يتم وضع ملف robots.txt في الدليل الجذر لموقع الويب الخاص بك ، ولكن يمكن أن يكون في أي مكان على موقعك تريد تقييد الوصول إليه.

س 2. هل ملف robots.txt ضروري؟

الإجابة: الإجابة المختصرة هي لا. ملف robots.txt ليس ضروريًا لموقع ويب. إذا قام روبوت بزيارة موقع الويب الخاص بك ولم يكن لديه ملف robots.txt ، فسيقوم بالزحف إلى الصفحات وفهرستها كما هو معتاد. ملف .txt مطلوب فقط إذا كنت تريد المزيد من التحكم في ما يتم الزحف إليه.

س 3. هل ملف robots.txt آمن؟

الإجابة: لا يمثل ملف robots.txt مخاطرة أمنية في حد ذاته ، ويمكن أن يمثل استخدامه السليم ممارسة جيدة لأسباب غير متعلقة بالأمان. يجب ألا تتوقع أن جميع روبوتات الويب ستتبع الإرشادات الواردة في الملف.

س 4. هل الوصول إلى ملف robots.txt غير قانوني؟

الإجابة: ملف robots.txt عبارة عن ترخيص ضمني بواسطة مالك موقع الويب. إذا كنت على علم بملف robots.txt ، فقد يُنظر إلى الاستمرار في كشط موقعهم دون إذن على أنه وصول غير مصرح به أو قرصنة.

س 5. ما هو تأخير الزحف في robots TXT؟

الإجابة: توجيه تأخير الزحف هو وسيلة لإخبار برامج الزحف بالإبطاء حتى لا يتم تحميل خادم الويب بشكل زائد.

استنتاج

Robots.txt هو ملف بسيط يتمتع بقدر كبير من القوة. إذا كنت تعرف كيفية استخدامه جيدًا ، فيمكن أن يساعد ذلك في تحسين محركات البحث. يعني إنشاء النوع الصحيح من ملف robots.txt أنك تعمل على تحسين مُحسنات محركات البحث وتجربة المستخدم أيضًا.

ستتمكن الروبوتات من تقديم المحتوى الخاص بك في SERPs بالطريقة التي تريدها إذا سمحت لهم بالزحف إلى الأشياء الصحيحة.

إذا كنت على استعداد لمعرفة المزيد عن تحسين محركات البحث والعوامل المهمة ، فراجع العديد من مدونات Scalenut الأخرى.