تدقيق تقني سريع وقذر من 11 خطوة لتحسين محركات البحث لصحة موقع الويب بشكل عام

نشرت: 2020-02-27تعتبر عملية تحسين محركات البحث الفنية مهمة لأنها نقطة البداية لأي مشروع. من وجهة نظر خبير تحسين محركات البحث ، كل موقع هو مشروع جديد. يجب أن يكون لموقع الويب أساس متين من أجل الحصول على نتائج جيدة والوصول إلى أهم مؤشرات الأداء الرئيسية في تحسين محركات البحث مثل التصنيفات.

في كل مرة أبدأ فيها بمشروع جديد ، فإن أول شيء أفعله هو تدقيق تقني لتحسين محركات البحث. في معظم الأوقات ، يمكن أن يؤدي إصلاح المشكلات الفنية إلى نتائج مذهلة بمجرد إعادة الزحف إلى موقع الويب.

إنه لأمر مضحك بالنسبة لي عندما يتحدث الناس عن المحتوى والمزيد من المحتوى ، لكنهم لا يقولون كلمة واحدة عن تحسين محركات البحث التقني. هناك شيء واحد مؤكد ، وهو أن صحة موقع الويب وتقنية تحسين محركات البحث (Technical SEO) هما شيئان مهمان سيكونان حاسمين في عام 2020. لا أقصد أن أقول إن المحتوى ليس مهمًا. إنه كذلك ، ولكن بدون إصلاح المشكلات الفنية على موقع الويب ، لا أعتقد أن المحتوى يمكن أن يحقق نتائج.

لقد رأيت حالات تم فيها حظر صفحات مهمة بواسطة توجيهات في ملف robots.txt ، أو تم تعطيل أو حظر صفحات الفئات أو الخدمات الأكثر أهمية بواسطة روبوتات التعريف مثل noindex ، nofollow. كيف يمكن أن تكون ناجحًا دون إعطاء الأولوية لإصلاح هذه المشكلات؟

قد يكون من المفاجئ رؤية عدد مُحسّنات محرّكات البحث الذين لا يعرفون كيفية تحديد المشكلات التقنية لإبلاغ متخصصي تطوير الويب لحلها. تذكرت مرة واحدة أثناء العمل في مجال الشركة ، لقد قمت بإنشاء ورقة قائمة مراجعة تدقيق Tech SEO ليستخدمها فريقي. في ذلك الوقت ، أدركت أن وجود ورقة إصلاح سريعة مثل هذه في متناول اليد يمكن أن يساعد الفريق بشكل كبير ويولد دفعة سريعة للعميل. لهذا السبب أعتبر أنه من الأهمية بمكان الاستثمار في أداة / برنامج يمكن أن يساعدك في التشخيص والتوصيات التقنية لتحسين محركات البحث.

لنبدأ العملية العملية حول كيفية إجراء تدقيق تقني سريع لتحسين محركات البحث والذي سيحدث فرقًا كبيرًا. هذا تمرين سريع سيستغرق منك حوالي ساعة واحدة حتى لو لم تكن محترفًا. بالنسبة لي ، فإن استخدام أداة Tech SEO مثل OnCrawl لتقديم كل الأشياء بسرعة في خمس دقائق دون الاضطرار إلى القيام بكل الأعمال اليدوية يجعل حياتي سهلة.

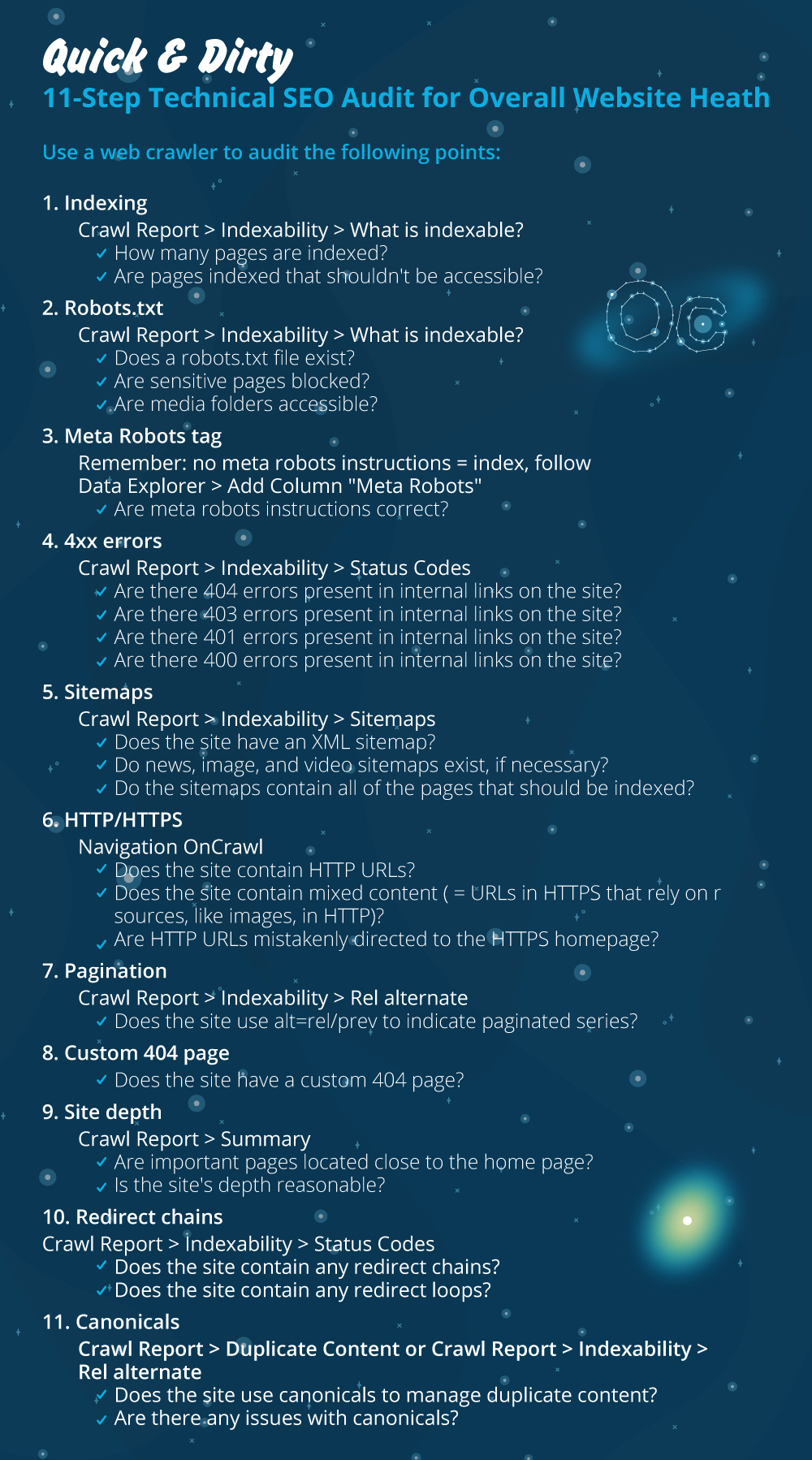

سوف أتطرق إلى أهم الأشياء التي يجب التحقق منها عند إجراء تدقيق تقني لتحسين محركات البحث. هناك المزيد من الأشياء التي يمكننا التحقق منها بحثًا عن مشاكل على الصفحة ، لكني أريد التركيز فقط على الأشياء التي ستؤدي إلى مشكلات في الفهرسة والزحف إلى ضياع الميزانية. إن تحديد أولويات هذا هو طريقة التأكد من أن Googlebot سيقوم بالزحف إلى أهم الصفحات.

- الفهرسة

- ملف Robots.txt

- علامة Meta robots

- أخطاء 4xx

- خرائط المواقع

- HTTP / HTTPS (أمان موقع الويب والمحتوى المختلط ومشكلات المحتوى المكرر)

- ترقيم الصفحات

- 404 صفحة

- عمق الموقع وهيكله

- سلاسل إعادة التوجيه الطويلة

- تنفيذ العلامة الأساسية

1) الفهرسة

هذا هو أول شيء يجب التحقق منه. يمكن أن تتأثر الفهرسة مرات عديدة بتكوين المكون الإضافي أو أي خطأ بسيط ولكن التأثير على إمكانية البحث يمكن أن يكون هائلاً ، حيث يوجد اليوم أكثر من 6.16 مليارات من صفحات الويب المفهرسة. يجب أن تفهم أن أي محرك بحث يبذل جهدًا وحتى Google يحتاج إلى إعطاء الأولوية للصفحة الأكثر صلة بتجربة المستخدم. إذا كنت لا تفكر في تسهيل الأمور على Googlebot ، فإن منافسيك سيفعلون ذلك ويكتسبون المزيد من الثقة التي تأتي مع موقع ويب سليم.

عندما تكون هناك مشكلات في الفهرسة ، ستنعكس مشكلات سلامة موقع الويب الخاص بك في فقدان حركة المرور العضوية. تعني عملية الفهرسة أن محرك البحث يزحف إلى صفحة ويب وينظم المعلومات التي تقدمها لاحقًا في SERP. تعتمد النتائج على مدى الصلة بقصد المستخدم. إذا كانت صفحة الويب لا يمكنها الزحف أو كانت بها مشكلات في الزحف ، فسيؤدي ذلك إلى تفضيل الصفحات الأخرى في نفس المكانة للحصول على ميزة.

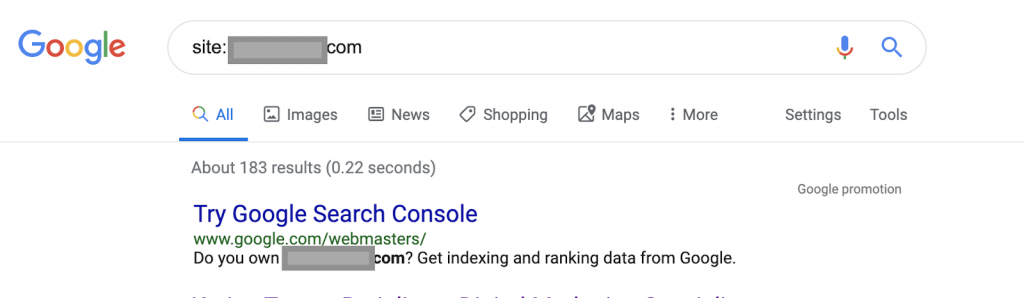

باستخدام عوامل تشغيل البحث على سبيل المثال:

الموقع: www.abc.com

سيعرض الاستعلام 183 صفحة مفهرسة بواسطة Google. هذا تقدير تقريبي لعدد الصفحات التي فهرستها Google. يمكنك التحقق من Google Search Console لمعرفة الرقم الدقيق.

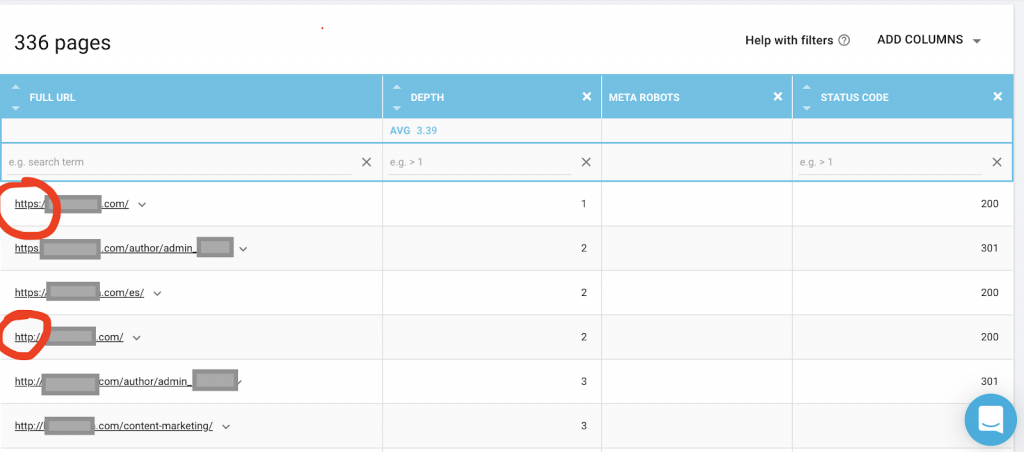

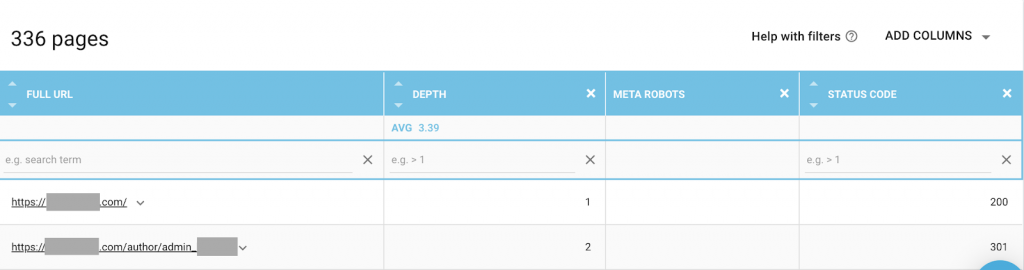

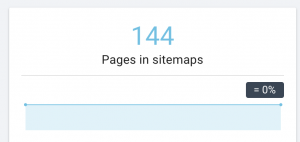

يجب عليك أيضًا استخدام زاحف ويب مثل OnCrawl لإدراج جميع الصفحات التي يمكن لـ Google الوصول إليها. يظهر هذا رقمًا مختلفًا كما ترى أدناه:

يحتوي موقع الويب هذا على ما يقرب من ضعف عدد الصفحات القابلة للزحف كما هو الحال مع الصفحات المفهرسة.

قد يكشف هذا عن مشكلة محتوى مكررة أو حتى مشكلة في إصدار أمان موقع الويب بين مشكلة HTTP و HTTPS. سأتحدث عن هذا لاحقًا في هذه المقالة.

في هذه الحالة ، تم ترحيل موقع الويب من HTTP إلى HTTPS. يمكننا أن نرى في OnCrawl أنه تم إعادة توجيه صفحات HTTP. لا يزال بإمكان Googlebot الوصول إلى كل من إصداري HTTP و HTTPS ، وقد يقوم بالزحف إلى جميع الصفحات المكررة ، بدلاً من إعطاء الأولوية للصفحات الأكثر أهمية التي يريد المالك ترتيبها ، مما يتسبب في إهدار ميزانية الزحف.

هناك مشكلة أخرى شائعة بين مواقع الويب المهملة أو مواقع الويب الكبيرة مثل مواقع التجارة الإلكترونية وهي مشكلات المحتوى المختلط. لجعل قصة طويلة قصيرة ، تظهر المشكلات عندما تحتوي صفحتك الآمنة على موارد مثل ملفات الوسائط (غالبًا: الصور) التي يتم تحميلها من إصدار غير آمن.

كيف تصلحها:

يمكنك أن تطلب من مطور الويب إجبار جميع صفحات HTTP على إصدار HTTPS ، وإعادة توجيه عناوين HTTP إلى HTTPS مرة واحدة باستخدام رمز الحالة 301.

بالنسبة إلى مشكلات المحتوى المختلط ، يمكنك التحقق يدويًا من مصدر الصفحة والبحث عن الموارد التي تم تحميلها كـ “src = http: //example.com/media/images” وهو أمر مجنون تقريبًا للقيام بذلك خاصةً لمواقع الويب الكبيرة. لهذا السبب نحتاج إلى استخدام أداة تحسين محركات البحث التقنية.

2) ملف Robots.txt:

يخبر ملف robots.txt وكلاء الزحف بالصفحات التي لا يجب عليهم الزحف إليها. يشير دليل مواصفات ملف robots.txt إلى أن تنسيق الملف يجب أن يكون نصًا عاديًا بحد أقصى للحجم يبلغ 500 كيلو بايت.

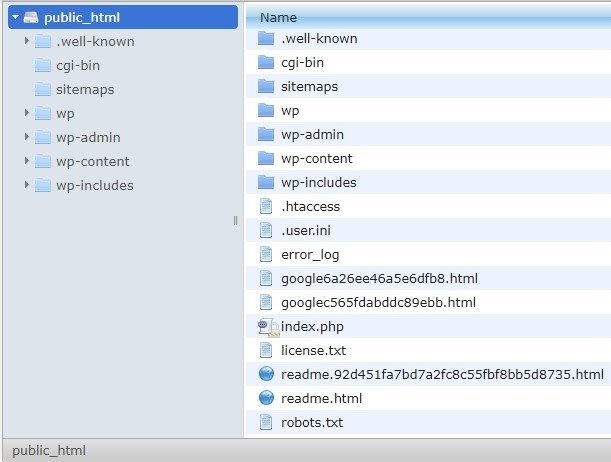

سأوصي بإضافة خريطة الموقع إلى ملف robots.txt. لا يفعل الجميع هذا ، لكنني أعتقد أنها ممارسة جيدة. يجب وضع ملف robots.txt في الخادم المستضاف في public_html ويتبع المجال الجذر.

يمكننا استخدام التوجيهات في ملف robots.txt لمنع محركات البحث من الزحف إلى صفحات أو صفحات غير ضرورية بها معلومات حساسة ، مثل صفحة المسؤول أو القوالب أو عربة التسوق (/ cart ، / checkout ، / login ، مجلدات مثل / tag المستخدمة في المدونات) ، عن طريق إضافة هذه الصفحات في ملف robots.txt.

نصيحة : تأكد من أنك لن تحظر مجلد ملفات الوسائط لأن هذا سيستبعد الصور أو مقاطع الفيديو أو الوسائط الأخرى المستضافة ذاتيًا من الفهرسة. يمكن أن تكون الوسائط مهمة جدًا لارتباط الصفحة وكذلك للترتيب العضوي وحركة المرور للصور أو مقاطع الفيديو.

3) علامة Meta Robots

هذا جزء من كود HTML يوجه محركات البحث إلى ما إذا كان ينبغي الزحف إلى صفحة وفهرستها ، مع جميع الروابط داخل تلك الصفحة. يتم وضع علامة HTML في رأس صفحة الويب الخاصة بك. هناك 4 علامات HTML شائعة للروبوتات:

- لا اتباع

- يتبع

- فِهرِس

- لا يوجد فهرس

في حالة عدم وجود علامات meta robots ، ستتبع محركات البحث المحتوى بشكل افتراضي وتقوم بفهرسته.

يمكنك استخدام أي مجموعة تناسب احتياجاتك. على سبيل المثال ، باستخدام OnCrawl وجدت أن "صفحة المؤلف" من موقع الويب هذا لا تحتوي على روبوتات وصفية. هذا يعني أن الاتجاه افتراضيًا هو ("متابعة ، مؤشر")

يجب أن يكون هذا ("noindex، nofollow").

لماذا ا؟

تختلف كل حالة عن الأخرى ، لكن هذا الموقع عبارة عن مدونة شخصية صغيرة. لا يوجد سوى مؤلف واحد ينشر على المدونة ، والمجال هو اسم المؤلف. في هذه الحالة ، لا تقدم صفحة "المؤلف" أي معلومات إضافية حتى لو تم إنشاؤها بواسطة منصة التدوين.

سيناريو آخر يمكن أن يكون موقع ويب حيث تكون الفئات على المدونة مهمة. عندما يريد المالك ترتيب الفئات على مدونته ، فيجب أن تكون برامج الروبوت الوصفية ("متابعة ، فهرس") أو افتراضية على صفحات الفئات.

في سيناريو مختلف ، بالنسبة إلى موقع ويب كبير ومعروف حيث يكتب كبار خبراء تحسين محركات البحث مقالات يتبعها المجتمع ، يعمل اسم المؤلف في Google كعلامة تجارية. في هذه الحالة قد ترغب في فهرسة بعض أسماء المؤلفين.

كما ترى ، يمكن استخدام Meta robots بعدة طرق مختلفة.

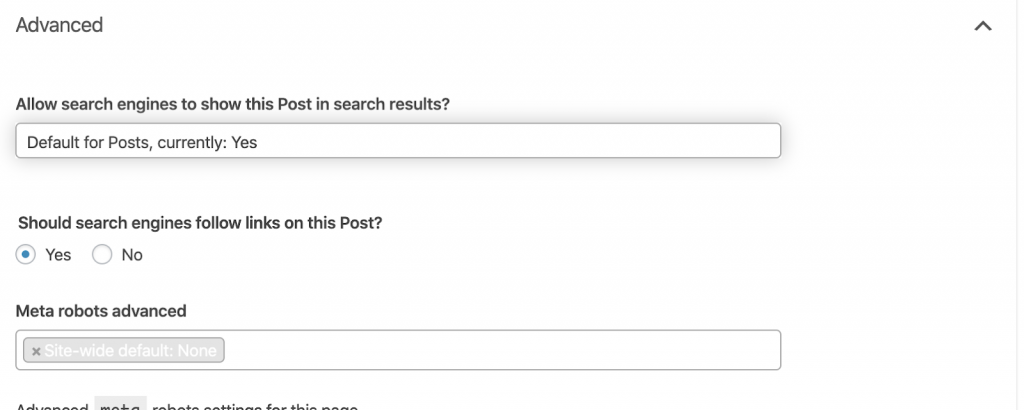

كيف تصلحها:

اطلب من مطور الويب تغيير علامة meta robot حسب حاجتك. في الحالة المذكورة أعلاه لموقع ويب صغير ، يمكنني القيام بذلك بنفسي بالانتقال إلى كل صفحة وتغييرها يدويًا. إذا كنت تستخدم WordPress ، فيمكنك تغيير ذلك من إعدادات RankMath أو Yoast.

4) أخطاء 4xx:

هذه أخطاء من جانب العميل ، ويمكن أن تكون 401 و 403 و 404.

- 404 الصفحة غير موجودة:

يحدث هذا الخطأ عندما لا تكون الصفحة متاحة على عنوان URL المفهرس. ربما تم نقله أو حذفه ، ولم يتم إعادة توجيه العنوان القديم بشكل صحيح باستخدام وظيفة خادم الويب 301. تعد أخطاء 404 تجربة سيئة للمستخدمين وتمثل مشكلة تقنية لتحسين محركات البحث يجب معالجتها. من الجيد التحقق كثيرًا من أخطاء 404 وإصلاحها ، وعدم تركها للمحاكمة مرارًا وتكرارًا لأن عوامل الزحف تضيع ميزانيتها.

كيف تصلحها:

نحتاج إلى العثور على العناوين التي تعرض أخطاء 404 وإصلاحها باستخدام عمليات إعادة التوجيه 301 إذا كان المحتوى لا يزال موجودًا. أو ، إذا كانت صورًا ، فيمكن استبدالها بأخرى جديدة تحمل نفس اسم الملف.

- 401 غير مصرح به

هذه قضية إذن. يحدث الخطأ 401 عادةً عندما تكون المصادقة مطلوبة مثل اسم المستخدم وكلمة المرور.

كيف تصلحها:

فيما يلي خياران: الأول هو منع الصفحة من محركات البحث باستخدام ملف robots.txt ، والخيار الثاني هو إزالة متطلبات المصادقة.

- 403 ممنوع

هذا الخطأ مشابه للخطأ 401. يحدث الخطأ 403 لأن الصفحة بها روابط لا يمكن للجمهور الوصول إليها.

كيف تصلحها:

قم بتغيير المتطلبات في الخادم للسماح بالوصول إلى الصفحة (فقط إذا كان هذا خطأ). إذا كنت تريد عدم إمكانية الوصول إلى هذه الصفحة ، فقم بإزالة جميع الروابط الداخلية والخارجية من الصفحة.

- 400 طلب سىء

يحدث هذا عندما يتعذر على المتصفح الاتصال بخادم الويب. يحدث هذا الخطأ بشكل شائع لبناء جملة عنوان URL تالف.

كيف تصلحها:

ابحث عن روابط لعناوين URL هذه وأصلح البنية. إذا لم يكن هذا قابلاً للإصلاح ، فستحتاج إلى الاتصال بمطور الويب لإصلاحها.

ملاحظة: يمكننا العثور على 400 خطأ في الأدوات أو في Google Console

5) خرائط المواقع

خريطة الموقع هي قائمة بجميع عناوين URL التي يحتوي عليها موقع الويب. يؤدي امتلاك خريطة (خرائط) الموقع إلى تحسين إمكانية العثور عليها لأنها تساعد برامج الزحف في العثور على المحتوى الخاص بك وفهمه.

لدينا أنواع مختلفة من خرائط المواقع ونحتاج إلى التأكد من أن جميعها في حالة جيدة.

خرائط المواقع التي يجب أن تكون لدينا هي:

- خريطة موقع HTML: سيكون هذا على موقع الويب الخاص بك وسيساعد المستخدمين على التنقل والعثور على الصفحات على موقع الويب الخاص بك

- خريطة موقع XML: هذا ملف سيساعد محركات البحث في الزحف إلى موقع الويب الخاص بك (كأفضل ممارسة ، يجب تضمينه في ملف robots.txt الخاص بك).

- خريطة موقع فيديو XML: نفس ما ورد أعلاه.

- خريطة موقع XML للصور: إنها أيضًا مماثلة لما ورد أعلاه. يوصى بإنشاء خرائط مواقع منفصلة للصور ومقاطع الفيديو والمحتوى.

بالنسبة إلى مواقع الويب الكبيرة ، يوصى باستخدام العديد من خرائط المواقع لتحسين إمكانية الزحف لأن خرائط المواقع يجب ألا تحتوي على أكثر من 50.000 عنوان URL.

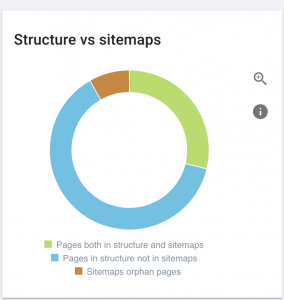

هذا الموقع به مشاكل خريطة الموقع.

كيف نصلحه:

نقوم بإصلاح ذلك من خلال إنشاء خرائط مواقع مختلفة لـ: المحتوى والصور ومقاطع الفيديو. بعد ذلك ، نرسلها عبر Google Search Console وننشئ أيضًا خريطة موقع HTML لموقع الويب. لا نحتاج إلى مطور ويب لهذا الغرض. يمكننا استخدام أي أداة مجانية عبر الإنترنت لإنشاء خرائط مواقع.

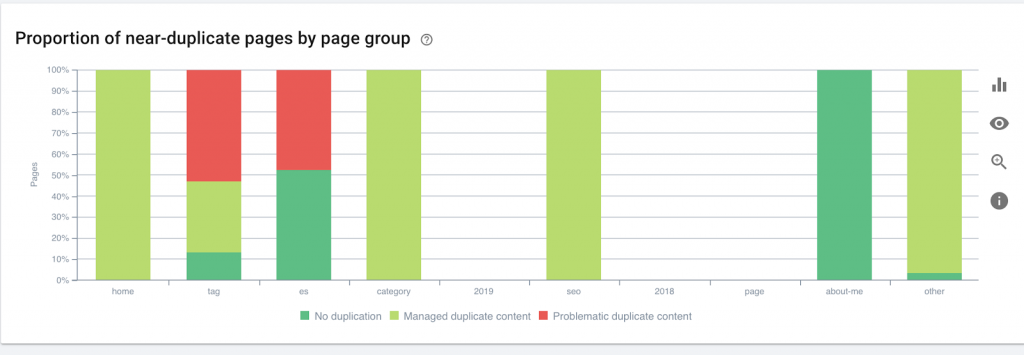

6) HTTP / HTTPS (محتوى مكرر)

تواجه العديد من مواقع الويب هذه المشكلات نتيجة الترحيل من HTTP إلى HTTPS. إذا كانت هذه هي الحالة ، فسيعرض موقع الويب إصدارات HTTP و HTTPS في محركات البحث. نتيجة لهذه المشكلة التقنية الشائعة ، تم تخفيف التصنيف. تؤدي هذه المشكلات أيضًا إلى إنشاء مشكلات محتوى مكررة.

![]()

كيف تصلحها:

اطلب من مطور الويب إصلاح هذه المشكلة عن طريق إجبار كل HTTP إلى HTTPS.

ملاحظة : لا تقم أبدًا بإعادة توجيه كل HTTP إلى صفحة HTTPS الرئيسية لأنها ستنتج أخطاء soft 404. (يجب أن تقول هذا لمطور الويب ؛ تذكر أنهم ليسوا مُحسنات محركات البحث.)

7) ترقيم الصفحات

هذا هو استخدام علامة HTML ("rel = prev" و "rel = next") التي تنشئ العلاقات بين الصفحات ، وتوضح لمحركات البحث أن المحتوى الذي يتم تقديمه في صفحات مختلفة يجب تحديده أو ربطه بواحد واحد. يستخدم ترقيم الصفحات للحد من محتوى UX ووزن الصفحة للجزء الفني ، مع الاحتفاظ بها أقل من 3 ميجابايت. يمكننا استخدام أداة مجانية للتحقق من ترقيم الصفحات.

يجب أن يحتوي ترقيم الصفحات على مراجع ذاتية متعارف عليها وأن يشير إلى "rel = prev" و "rel = next". ستكون المعلومات المكررة الوحيدة هي العنوان التعريفي والوصف التعريفي ، ولكن يمكن للمطورين تغيير ذلك لإنشاء خوارزمية صغيرة بحيث يكون لكل صفحة عنوان تعريف ووصف وصف تعريفي تم إنشاؤه.

كيف تصلحها:

اطلب من مطور الويب تنفيذ علامات ترقيم الصفحات HTML باستخدام علامة متعارف عليها ذاتيًا.

زاحف Oncrawl SEO

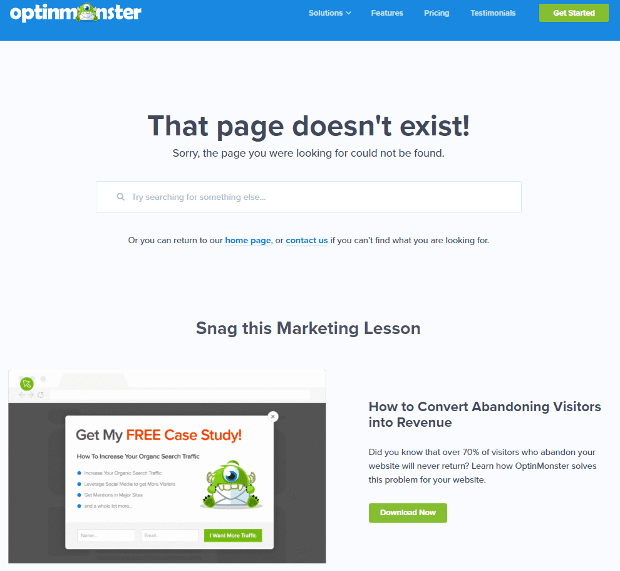

8) صفحة 404 مخصصة غير موجودة

استجابة 404 كما ناقشناها من قبل هي خطأ " لم يتم العثور عليه " الذي ينقل المستخدمين إلى ارتباط معطل أو صفحة غير موجودة. هذه فرصة لإعادة توجيه المستخدمين إلى المكان الصحيح. هناك أمثلة رائعة لصفحات 404 المخصصة. هذا أمر لا بد منه.

فيما يلي مثال لصفحة 404 مخصصة رائعة:

كيف تصلحها:

قم بإنشاء صفحة 404 مخصصة: فكر في شيء رائع لتضيفه. اجعل هذا الخطأ فرصة لعملك.

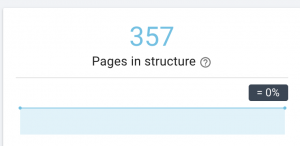

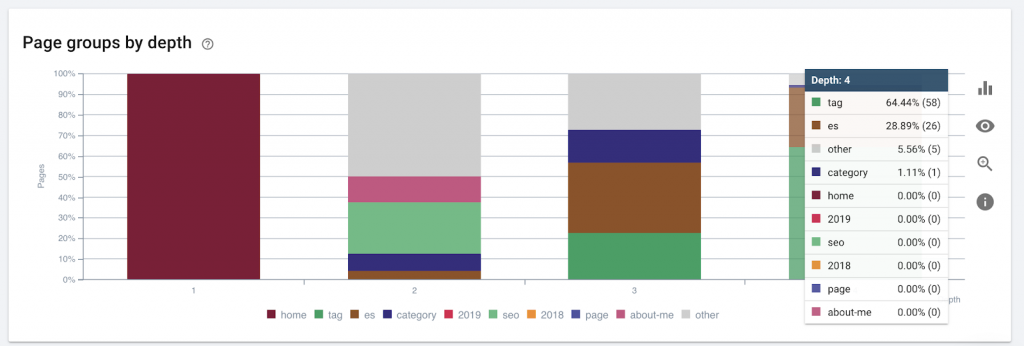

9) عمق / هيكل الموقع

عمق الصفحة هو عدد النقرات التي توجد بها صفحتك من المجال الجذر. قال جون مولر من Google "الصفحات الأقرب إلى الصفحة الرئيسية لها وزن أكبر". على سبيل المثال ، دعنا نتخيل أن الصفحة هنا تتطلب التنقل التالي حتى يتم الوصول إليها:

الصفحة "سجاد" على بعد 4 نقرات من الصفحة الرئيسية. يوصى بعدم وجود صفحات تبعد أكثر من 4 نقرات عن المنزل ، لأن محركات البحث تواجه صعوبة في الزحف إلى صفحات أعمق.

يوضح هذا الرسم مجموعة الصفحات حسب العمق. يساعدنا ذلك على فهم ما إذا كانت بنية موقع الويب بحاجة إلى إعادة صياغة.

كيف تصلحها:

يجب أن تكون الصفحات الأكثر أهمية هي الأقرب إلى الصفحة الرئيسية لتجربة المستخدم ، لسهولة الوصول إليها من قبل المستخدمين ولتحسين بنية موقع الويب. من المهم جدًا أخذ ذلك في الاعتبار عند إنشاء هيكل موقع ويب أو إعادة هيكلة موقع ويب.

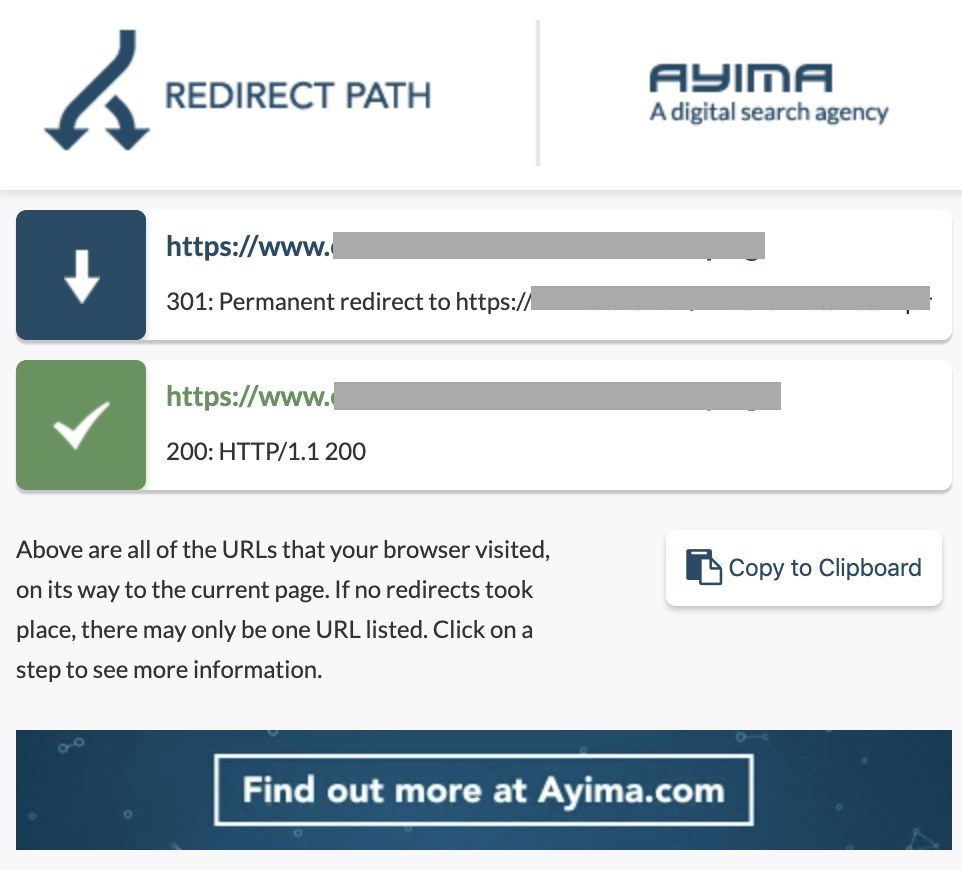

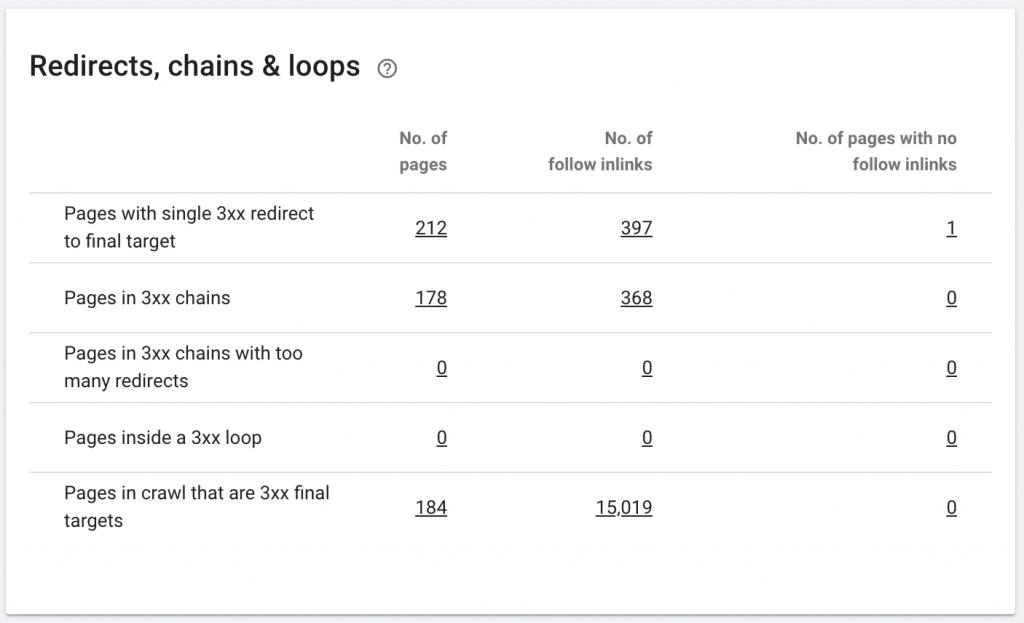

10. إعادة توجيه سلاسل

تحدث سلسلة إعادة التوجيه عندما تحدث سلسلة من عمليات إعادة التوجيه بين عناوين URL. قد تؤدي سلاسل إعادة التوجيه هذه أيضًا إلى إنشاء حلقات. كما أنه يعرض مشكلات لبرنامج Googlebot ويهدر ميزانية الزحف.

يمكننا تحديد سلاسل عمليات إعادة التوجيه باستخدام مسار إعادة توجيه ملحق Chrome ، أو في OnCrawl.

كيف تصلحها:

يعد إصلاح هذا أمرًا سهلاً حقًا إذا كنت تعمل باستخدام موقع ويب WordPress. ما عليك سوى الانتقال إلى إعادة التوجيه والبحث عن السلسلة - احذف جميع الروابط المضمنة في السلسلة إذا حدثت هذه التغييرات قبل أكثر من شهرين إلى ثلاثة أشهر واترك آخر إعادة توجيه إلى عنوان URL الحالي. يمكن لمطوري الويب أيضًا المساعدة في ذلك عن طريق إجراء جميع التغييرات المطلوبة في ملف htacces ، إذا لزم الأمر. يمكنك التحقق من سلاسل إعادة التوجيه الطويلة وتغييرها في مكونات تحسين محركات البحث (SEO) الخاصة بك.

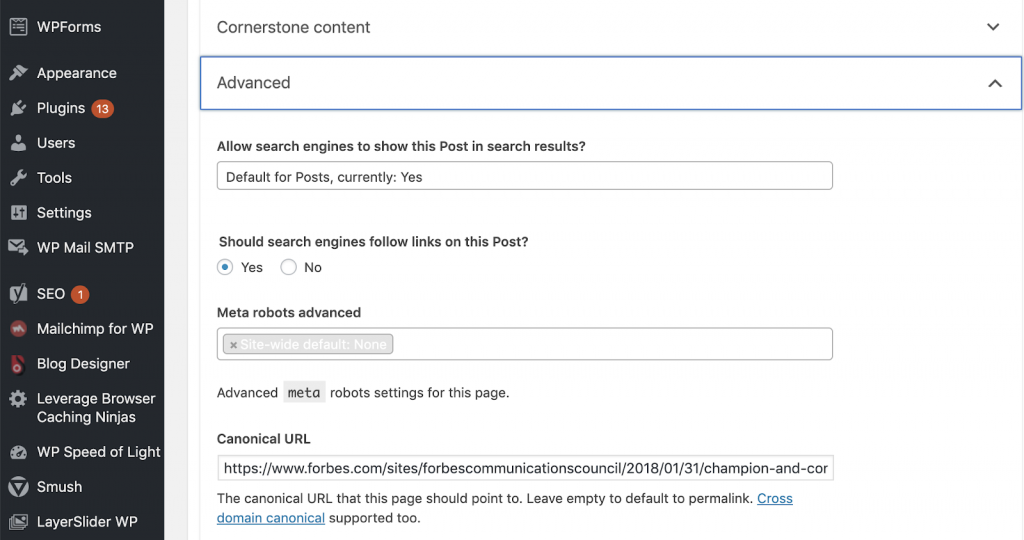

11) الكنسيات

تخبر العلامة الأساسية محركات البحث أن عنوان URL هو نسخة من صفحة أخرى. هذه مشكلة كبيرة موجودة في العديد من مواقع الويب. سيؤدي عدم تنفيذ القواعد الأساسية بالطريقة الصحيحة أو تنفيذها على الإطلاق إلى حدوث مشكلات محتوى مكررة.

يتم استخدام Canonical بشكل شائع في مواقع التجارة الإلكترونية حيث يمكن العثور على منتج عدة مرات في فئات مختلفة مثل: الحجم واللون وما إلى ذلك.

يمكنك استخدام OnCrawl لمعرفة ما إذا كانت صفحاتك تحتوي على علامات أساسية ، وما إذا تم تنفيذها بشكل صحيح أم لا. يمكنك بعد ذلك استكشاف أي مشاكل وتصحيحها.

كيف نصلحه:

يمكننا إصلاح المشكلات الأساسية باستخدام Yoast SEO إذا كنا نعمل في WordPress. نذهب إلى لوحة تحكم WordPress ثم إلى Yoast -setting - Advanced.

إجراء التدقيق الخاص بك

تحتاج مُحسّنات محرّكات البحث التي ترغب في بدء الغوص في مُحسّنات محرّكات البحث الفنية إلى دليل للخطوات السريعة التي يجب اتباعها لتحسين صحة مُحسّنات محرّكات البحث. التحدث عن تحسين محركات البحث التقني مع جون شحاتة ، نائب رئيس زيادة الجمهور في Conde Nast ومؤسس NewzDash في يوم التسويق العالمي في مدينة نيويورك في أكتوبر الماضي 2019.

هذا ما قاله لي:

"الكثير من الأشخاص في صناعة تحسين محركات البحث ليسوا تقنيين. الآن ، لا يفهم كل مُحسنات محركات البحث كيفية البرمجة ومن الصعب أن تطلب من الأشخاص القيام بذلك. بعض الشركات ، ما تفعله هو توظيف مطورين وتدريبهم ليصبحوا مُحسنات محركات بحث لسد الفجوة الفنية في تحسين محركات البحث. "

في رأيي ، لا يزال بإمكان مُحسّنات محرّكات البحث الذين ليس لديهم معرفة كاملة بالشفرة أن يحققوا أداءً رائعًا في Tech SEO من خلال معرفة كيفية إجراء تدقيق ، وتحديد العناصر الأساسية ، وإعداد التقارير ، وطلب مطوري الويب للتنفيذ ، واختبار التغييرات أخيرًا.

على استعداد للبدء؟ قم بتنزيل قائمة التحقق الخاصة بهذه القضايا المهمة.