الربط الداخلي: كيفية تحديد أهم الصفحات للربط؟

نشرت: 2021-05-03إذا كانت الروابط الخارجية (الروابط الخلفية) هي أحد مجالات التحسين التي يتم ذكرها غالبًا لتحسين مُحسّنات محرّكات البحث لديك ، فغالبًا ما يتم تجاهل الارتباط الداخلي ، ولكنه مهم أيضًا. في الواقع ، يمكن لبنية ربط داخلية جيدة أن تحدث فرقًا كبيرًا في القطاعات شديدة التنافسية.

إذا كان تحديد أهم الصفحات المراد ربطها أولاً ، بالنسبة لموقع صغير ، مهمة سهلة نسبيًا ، فماذا عن المواقع التي تحتوي على آلاف أو حتى ملايين الصفحات؟

في مقال اليوم ، سأشرح منهجية يمكنك تطبيقها على مشروعك من أجل تحديد صفحات الأولوية.

تحليل نانوغرام من كلماتنا الرئيسية

أولاً ، نحتاج إلى فهم الكلمات الرئيسية الأكثر استخدامًا للبحث عن منتجنا أو خدمتنا. إذا كنت قد فتحت تقرير Google Search Console من قبل ، فمن المحتمل أنك لاحظت وجود العديد من هياكل الكلمات الرئيسية. على سبيل المثال ، لشراء رحلة بين مدينتين مختلفتين ، لنأخذ ليون وبرشلونة ، قد تكون عمليات البحث:

- رحلة ليون برشلونة

- رحلة ليون برشلونة

- رحلة رخيصة ليون برشلونة

- إلخ.

إن امتلاك هذا النوع من تعدد هياكل الكلمات الرئيسية ليس خاصًا بصناعة السفر ، وربما يكون لديك وضع مماثل في مجال عملك.

ومع ذلك ، من الضروري معرفة الهياكل الأكثر استخدامًا حتى نتمكن من إجراء تحليلنا بشكل صحيح. كيف يمكننا عمل ذلك؟ ببساطة عن طريق إجراء تحليل n-gram (تسلسل N من الكلمات المستخدمة ككلمة رئيسية) لبيانات Google Search Console الخاصة بنا.

قبل شرح كيفية القيام بذلك ، دعني أوضح شيئًا واحدًا: لسوء الحظ ، بيانات Google Search Console ليست مثالية.

[دراسة حالة] كيف تعمل مُحسّنات محرّكات البحث الموجهة للأعمال على زيادة حركة المرور والتحويلات

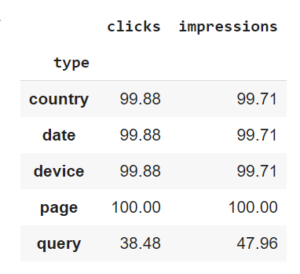

محددات

قبل أن نبدأ تحليلنا ، يجب أن ندرك أن المقاييس التي تعرضها الأداة عند تضمين بُعد "الاستعلام" لا تمثل سوى 30-50٪ (سيعتمد الرقم الدقيق على موقعك) من الإجمالي المعروض إذا قمت بتضمين بُعد "الصفحة" ، على سبيل المثال.

بمعنى آخر: الأداة تعاني من أخذ عينات الأبعاد. هذا يعني أن المقاييس التي يتم إرجاعها بواسطة Google Search Console ستكون مختلفة بناءً على ما تقوم بتحليله (استعلامات ، صفحات ...). يجب أن أشير أيضًا إلى أنني حصلت على هذه البيانات باستخدام واجهة برمجة التطبيقات ، أي من خلال التفاعل مع جميع البيانات المتاحة ، بدلاً من الواجهة التي يعرفها الجميع ، والتي تسمح لك فقط بتحليل 1000 عنصر كحد أقصى.

إذا كنت تعمل باستخدام Python ، فيمكنك قراءة وثائق Google الرسمية ، أو حتى أفضل من ذلك ، استخدام هذه المكتبة التي ستوفر لك الكثير من الوقت. أنا أستخدمه بنفسي على أساس منتظم.

ومع ذلك ، فإن Google Search Console لا تزال أكثر شمولاً من أي أداة خارجية أخرى مثل SEMrush أو SEObserver أو Ahrefs أو Sistrix ، على سبيل المثال لا الحصر المعروفة.

منهجية الحصول على n-grams الخاصة بك

من أجل الحصول على n-grams ، عليك اتباع هذا الإجراء:

قم بتنزيل بيانات Google Search Console

من المهم تنزيل بياناتك لقطاع واحد. نظرًا لأن عدد n-grams لقسم الرحلة وقسم القطار في موقعك سيكون مختلفًا على الأرجح ، إذا قمت بخلط بياناتك ، فقد تحصل على n-grams صالحة فقط للقطاع الأكثر بحثًا.

إذا كان موقعك جديدًا أو نادرًا ما يظهر في الصفحة الأولى ، فإنني أوصيك باستخدام مصدر بيانات إضافي.

إزالة المتغيرات

في بعض الحالات ، قد تحتاج إلى إزالة بعض العناصر في هذه الكلمات الأساسية. على سبيل المثال ، لنفترض أن قائمتي تحتوي على 4 كلمات رئيسية فقط:

- رحلة باريس روما

- رحلة رخيصة باريس روما

- رحلة ليون برشلونة

- رحلة رخيصة ليون برشلونة

أريد الحصول على n-grams في شكل تراكيب تحتوي على متغيرات. هنا ، على سبيل المثال ، أريد الاحتفاظ فقط بما يلي: رحلة الطيران {{الأصل}} {{الوجهة}} ورحلة الطيران الرخيصة {{الأصل}} {{الوجهة}} ، بدون المدن. في حالتك ، قد تضطر إلى استبدال اسم منتجاتك ، والحجم ، وما إلى ذلك ... سيعتمد ذلك على مجال عملك.

حساب n-grams واسترجع أحجام البحث

يمكنك استخدام أي نظام تفضله: في حالتي ، أستخدم Python ، والتي تتميز بكونها بسيطة ويمكنها التعامل مع كمية البيانات التي لدينا على جهاز كمبيوتر عادي (دون تعطله).

# استيراد المكتبات

مجموعات الاستيراد

استيراد nltk

استيراد numpy كـ np

استيراد الباندا كما pd

# إنشاء قائمة من الكلمات الرئيسية الفريدة

list_of_keywords = تقرير ['استعلام']. tolist ()

# إنشاء قائمة بالكلمات الواردة في هذه الكلمات الرئيسية

list_of_words_in_keywords = [x.split ("") لـ x في list_of_keywords]

#count الأكثر شيوعا

التهم = المجموعات. عداد ()

للعبارة في list_of_words_in_keywords:

counts.update (nltk.ngrams (عبارة، 1))

counts.update (nltk.ngrams (عبارة، 2))يمكنك أيضًا استخدام وظيفة Oncrawl الأصلية لتحليل المحتوى الخاص بك واكتشاف بعض n-grams التي لا تظهر في Google Search Console (حتى الآن).

بعد ذلك ، ستحتاج إلى استرداد أحجام البحث لكل من هذه الهياكل ، للحصول على جدول مثل الجدول أدناه. يوضح هذا الجدول الهياكل الأكثر شيوعًا: تلك التي تحتوي على أكبر عدد من مرات الظهور لقطاعنا الرأسي.

| استفسار | عدد | انطباعات |

|---|---|---|

| الرحلة {الأصل} {الوجهة} | 50 | 167000 |

| رحلة رخيصة {origin} {وجهة} | 676 | 30000 |

| التذكرة {origin} {وجهة} | 300 | 97000 |

عمل جيد للوصول إلى هذه المرحلة. يمكنني أن أخبرك أنك تريد معرفة ما سنستخدم هذه المعلومات من أجله. الجواب في الجزء التالي

[دراسة حالة] كيف تعمل مُحسّنات محرّكات البحث الموجهة للأعمال على زيادة حركة المرور والتحويلات

استخراج أحجام البحث

دعنا نتذكر أن هدفنا هو تحديد أهم الصفحات التي يجب الارتباط بها أولاً.

لفهم الصفحات التي تحتوي على أعلى حركة مرور محتملة ، نحتاج إلى استرداد أحجام البحث لهياكل الكلمات الرئيسية المختلفة الأكثر شيوعًا ، لكل صفحة. سنأخذ في الاعتبار حجم البحث هنا فقط ؛ سيأتي مفهوم نسبة النقر إلى الظهور لاحقًا!

هل بدأت في فهم الغرض من الخطوة السابقة؟ من أجل الحصول على الكفاءة ، فإن استخدام API إلزامي. توجد العديد من الحلول ، معظمها حلول مدفوعة. إذا كنت تستخدم DataForSEO ، فإن الحصول على مجلدات لـ 350.000 كلمة رئيسية سيكلفك أقل من 40 يورو ، لذلك نحن لا نتحدث عن استثمار كبير أيضًا.

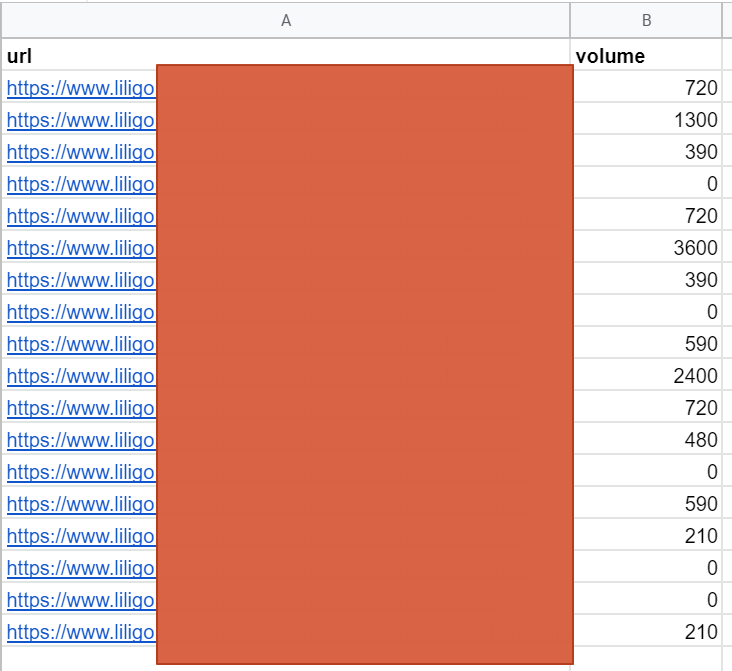

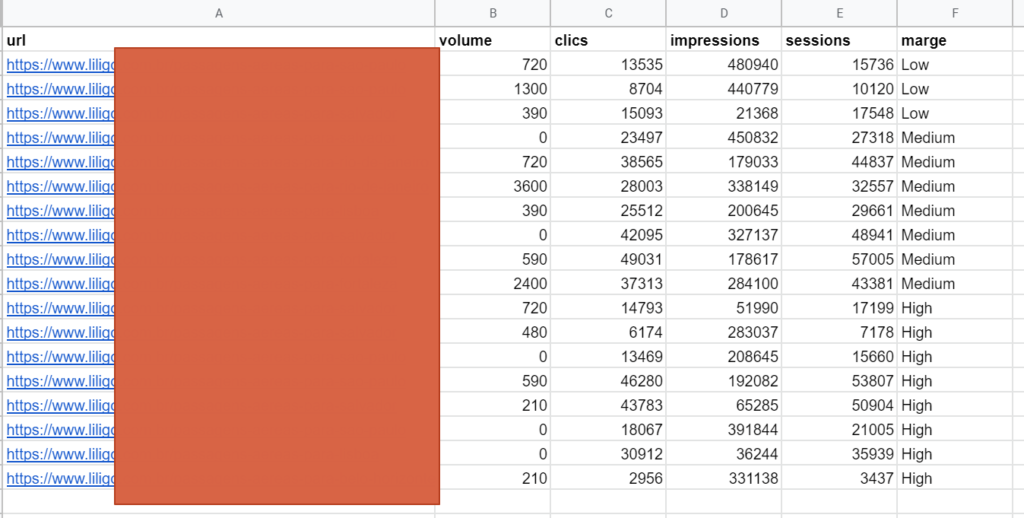

في نهاية هذه الخطوة ، سيكون لديك ملف بالحجم المحتمل لكل عنوان URL. هذا هو مجموع أحجام n-grams الأكثر شيوعًا المحسوبة في الخطوة السابقة.

دمج البيانات

في هذه المرحلة ، من الواضح أننا لا نستطيع استخدام هذه البيانات لتحديد أولويات الصفحات الأكثر أهمية في موقعنا. لما لا؟

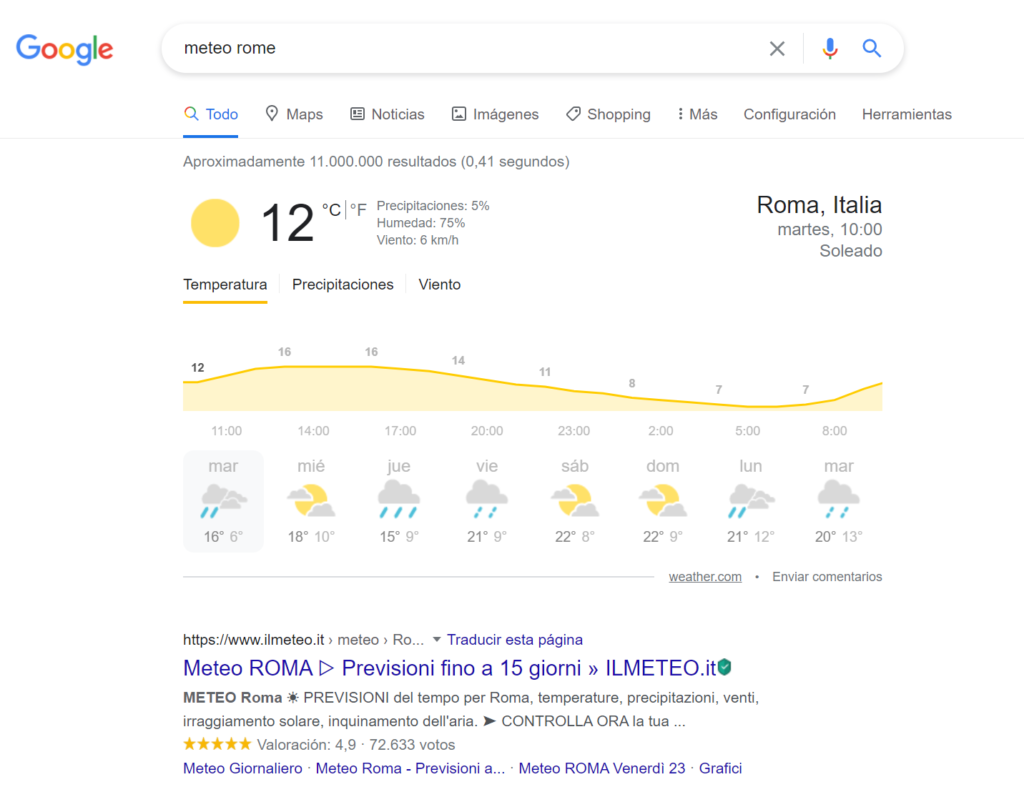

دعونا لا نمزج الحجم وحركة المرور!

في بعض الحالات ، حتى لو كنت في المركز الأول ، فقد تظل نسبة النقر إلى الظهور منخفضة. هذا غالبًا بسبب عدد الإعلانات وميزات SERP التي تعرضها Google أعلى صفحتك. فيما يلي مثال على استعلام الطقس حيث يجذب عنصر Google الأول انتباه المستخدم بشدة قبل أن يتمكن المستخدم من الوصول إلى النتيجة العضوية الأولى بوقت طويل.

حدود n-grams

يمكن أن تختلف أهمية الكلمات الرئيسية طويلة الذيل اعتمادًا على القطاع. يمكن أن تمثل الهياكل التي لم يتم الاحتفاظ بها في الخطوة الأولى (أو التي تم إخفاؤها بواسطة Google Search Console) جزءًا مثيرًا للاهتمام من الإمكانات. لذلك يجب علينا أن ندرجها.

أهمية كل صفحة

بصفتنا خبيرًا في تحسين محركات البحث (SEO) ، فإن هدفنا ليس توليد حركة المرور ، ولكن تحقيق المبيعات من خلال محركات البحث. لذلك من الضروري ، إذا أمكن ، استكمال هذا التحليل ببيانات من قسم المبيعات لديك. على سبيل المثال ، يمكن أن تساعدك البيانات الموجودة على هامش المبيعات في تحديد عناوين URL التي يجب تحديد أولوياتها.

لنأخذ الجدول من نهاية الخطوة السابقة ، ونضيف البيانات الأخرى التي قد يكون من المفيد قياسها:

- التعرض المحتمل (الحجم / مرات الظهور)

- عدد الزيارات الفعلية (جلسات / نقرات)

- الإيرادات (معدل التحويل / الهامش / الإيرادات)

فيما يلي مثال على كيفية تقديم هذا الجدول:

ترجيح البيانات

لتصنيف كل جزء مختلف من المحتوى وفقًا لتعرضه المحتمل وحركة المرور المحتملة والإيرادات ، يجب أن تقرر مقدار وزن كل عنصر من هذه العناصر.

لا يمكنني اقتراح نسب معيارية. الأمر متروك لك لتحديد النسب المئوية التي تناسب وضعك.

التوحيد

يرجى ملاحظة أنه لا يمكننا حتى الآن تحديد أهمية كل صفحة من صفحاتنا. النتيجة التي نحصل عليها من خلال ترجيح البيانات التي حصلنا عليها سابقًا ليست صالحة بعد.

توضيح: حسب التعريف ، ستكون مرات الظهور أعلى من النقرات والجلسات. هذا صحيح بشكل خاص في الصناعات ذات نسب النقر إلى الظهور المنخفضة. بدون معالجة بياناتنا مسبقًا ، فإننا نجازف بإفراط في عدد مرات الظهور (وجلسات تقليل الوزن ).

كيف يمكننا حل هذه المشكلة؟ من خلال توحيد بياناتنا! تسمح لنا هذه العملية بتغيير حجم المتغيرات العددية بحيث يمكن مقارنتها على مقياس مشترك (مصدر). من خلال التلاعب الرياضي ، سيكون لتوزيع البيانات الكمية قيمة متوسطة تبلغ 0 وانحراف معياري قدره 1.

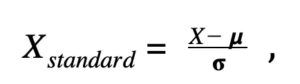

إذا كنت مهتمًا بالفضول ، فإن الصيغة الرياضية هي كما يلي:

X_standard = قيمة معيارية

X = القيمة الأولية

μ = متوسط (متوسط) توزيعنا

σ = الانحراف المعياري لتوزيعنا

من السهل جدًا تطبيق هذه الصيغة على بياناتك:

قم بتطبيق هذه الصيغة على جميع البيانات التي تريد أخذها في الاعتبار في الحساب الخاص بك. سيؤدي هذا بالتأكيد إلى القضاء على مشكلة زيادة وزن المقياس.

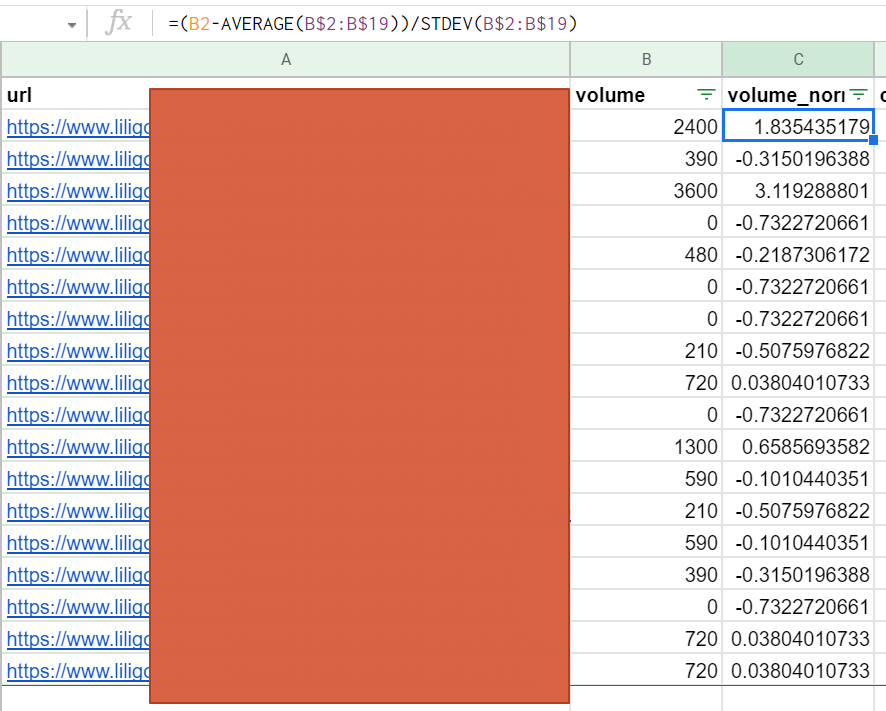

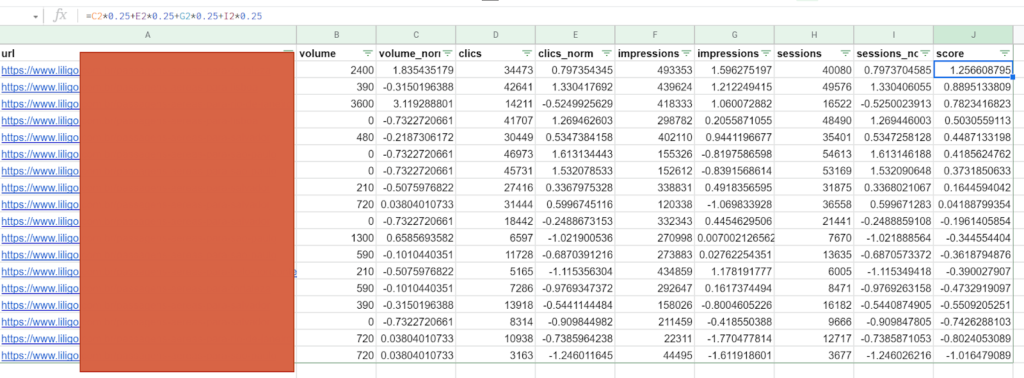

حساب النتيجة

بمجرد تحديد الأوزان الخاصة بك وحساب القيم الموحدة الخاصة بك ، يمكنك تعيين درجة لكل عنوان URL الخاص بك لتحديد أهميته. في هذا المثال ، لدينا 4 مقاييس ، كل منها يُقدّر بالتساوي بنسبة 25٪ ، ولكن يمكنك بوضوح استخدام أرقام أخرى.

وبالتالي ، تتيح لك هذه المنهجية وضع عنوان URL أولاً وهو الأفضل من الناحية الموضوعية: حجم بحث أقل ، ولكن مرات ظهور عالية ، وقبل كل شيء نسبة نقر إلى ظهور مثيرة للإعجاب.

باستخدام هذه المعلومات ، ستتمكن من تحديد هيكل الارتباط الداخلي الخاص بك بطريقة أكثر شمولاً وذات صلة مما لو كنت تعتمده على معيار واحد ، مثل حجم البحث. الأمر متروك لك للربط:

- من الصفحة الرئيسية: أهم الصفحات

- من فئة: أهم صفحات الفئة المعنية

- وهلم جرا.

استنتاج

تعتبر منهجية n-gram فعالة وتتمتع بميزة كونها قابلة للتطبيق على العديد من المشاريع. تحتاج فقط إلى تكييفها باستخدام أهم البيانات في مجال عملك. على الرغم من استخدام مفهوم رياضي قد يكون جديدًا بالنسبة للبعض (التوحيد القياسي) ، فمن السهل أيضًا شرحه وتطبيقه باستخدام الأدوات المتاحة لك.

سيوفر لك المعلومات اللازمة لبناء شبكة داخلية بناءً على إمكانات ونتائج صفحاتك. مهمة يصعب الحصول عليها أحيانًا للمواقع الكبيرة.

كل ما عليك فعله هو تطبيقه!