تحديثات Google الأساسية: التأثيرات والمشكلات والحلول لمواقع YMYL

نشرت: 2019-12-04في دراسة الحالة هذه ، سألقي نظرة على موقع Hangikredi.com الذي يُعد أحد أكبر الأصول المالية والرقمية في تركيا. سنرى العناوين الفرعية لتحسين محركات البحث الفنية وبعض الرسومات.

يتم تقديم دراسة الحالة هذه في مقالتين. تتناول هذه المقالة تحديث Google الأساسي في 12 مارس ، والذي كان له تأثير سلبي قوي على الموقع ، وما فعلناه لمواجهته. سننظر في 13 مشكلة فنية وحلاً ، بالإضافة إلى قضايا شاملة.

اقرأ الدفعة الثانية لترى كيف طبقت التعلم من هذا التحديث لأصبح الفائز من كل تحديث Google Core.

المشكلات والحلول: إصلاح تأثيرات تحديث Google الأساسي في 12 مارس

حتى تحديث الخوارزمية الأساسية في 12 مارس ، كان كل شيء يسير على نحو سلس للموقع ، بناءً على بيانات التحليلات. في يوم واحد ، بعد إصدار الأخبار حول تحديث الخوارزمية الأساسية ، كان هناك انخفاض كبير في التصنيف وإحباط كبير في المكتب. أنا شخصياً لم أر ذلك اليوم لأنني وصلت فقط عندما وظفوني لبدء مشروع وعملية تحسين محركات البحث الجديدة بعد 14 يومًا.

[دراسة حالة] تحسين التصنيف والزيارات العضوية والمبيعات من خلال تحليل ملفات السجل

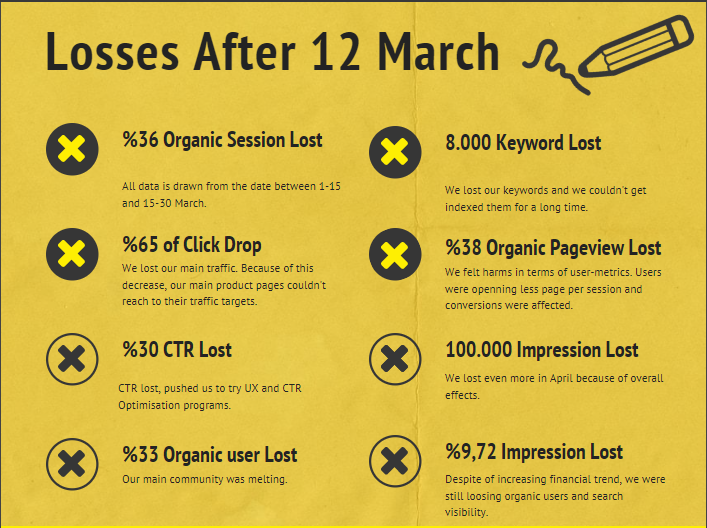

فيما يلي تقرير الضرر لموقع الشركة على الويب بعد تحديث الخوارزمية الأساسية في 12 مارس:

- 36٪ خسارة جلسة عضوية

- 65٪ انقر إفلات

- 30٪ خسارة نسبة النقر إلى الظهور

- 33٪ فقدان المستخدم العضوي

- ضاع 100000 ظهور في اليوم.

- 9.72٪ فقدان الانطباع

- فقدت 8000 كلمة رئيسية

الآن ، كما ذكرنا في بداية مقالة دراسة الحالة ، يجب أن نطرح سؤالاً واحدًا. لا يمكننا أن نسأل "متى سيحدث التحديث التالي للخوارزمية الأساسية؟" لأنه حدث بالفعل. بقي سؤال واحد فقط.

"ما المعايير المختلفة التي اعتبرتها Google بيني وبين منافسي؟"

كما ترون من الرسم البياني أعلاه ومن تقرير الضرر ، فقد فقدنا حركة المرور والكلمات الرئيسية الرئيسية.

1. المشكلة: الربط الداخلي

لقد لاحظت أنه عندما تحققت لأول مرة من عدد الروابط الداخلية ونص الرابط وتدفق الارتباط ، كان المنافس أمامي.

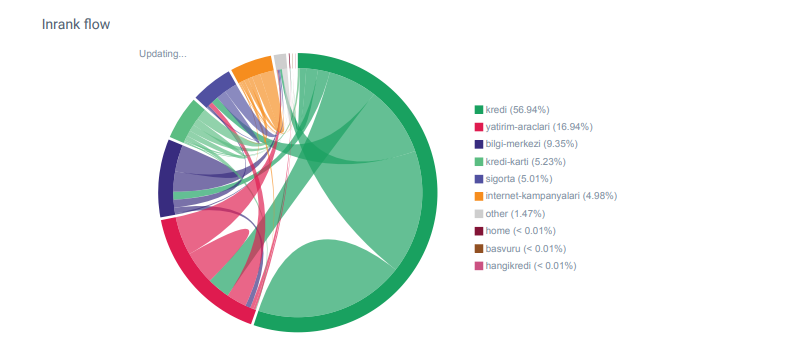

تقرير Linkflow لفئات Hangikredi.com من OnCrawl

يمتلك منافسي الرئيسي أكثر من 340000 رابط داخلي مع آلاف النصوص الأساسية. في هذه الأيام ، كان لموقع الويب الخاص بنا فقط 70000 رابط داخلي بدون نصوص ربط قيمة. بالإضافة إلى ذلك ، أثر نقص الروابط الداخلية على ميزانية الزحف والإنتاجية لموقع الويب. على الرغم من أن 80٪ من حركة المرور الخاصة بنا تم جمعها على 20 صفحة منتج فقط ، فإن 90٪ من موقعنا يتكون من صفحات إرشادية تحتوي على معلومات مفيدة للمستخدمين. وتأتي معظم الكلمات الرئيسية ودرجات الصلة بالاستفسارات المالية من هذه الصفحات. أيضًا ، كان هناك عدد لا يحصى من الصفحات اليتيمة.

بسبب بنية الارتباط الداخلية المفقودة ، عندما أجريت تحليل السجل باستخدام Kibana ، لاحظت أن أكثر الصفحات التي تم الزحف إليها هي تلك التي تلقت أقل حركة مرور. أيضًا ، عندما قمت بإقران هذا بشبكة الارتباط الداخلية ، اكتشفت أن صفحات الشركة الأقل حركة مرورًا (الخصوصية ، ملفات تعريف الارتباط ، الأمان ، صفحات من نحن) بها أقصى عدد من الروابط الداخلية.

كما سأناقش في القسم التالي ، تسبب هذا في قيام Googlebot بإزالة عامل الارتباط الداخلي من Pagerank عندما قام بالزحف إلى الموقع ، مدركًا أن الروابط الداخلية لم يتم إنشاؤها على النحو المنشود.

2. المشكلة: هندسة الموقع ، Inte²rnal Pagerank ، حركة المرور وكفاءة الزحف

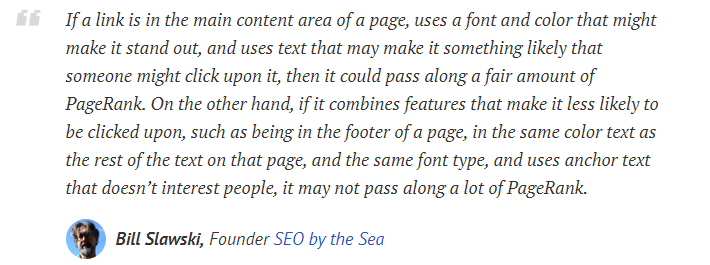

وفقًا لبيان Google ، تساعد الروابط الداخلية ونصوص الإرساء Googlebot على فهم أهمية صفحة الويب وسياقها. يتم حساب الصفحة الداخلية أو Inrank على أساس أكثر من عامل. وفقًا لبيل سلاوسكي ، الروابط الداخلية أو الخارجية ليست كلها متساوية. تتغير قيمة الارتباط لتدفق Pagerank وفقًا لموضعه ونوعه ونمطه ووزنه.

إذا فهم Googlebot الصفحات المهمة لموقعك على الويب ، فسيزحف إليها أكثر ويفهرسها بشكل أسرع. الروابط الداخلية والتصميم الصحيح لشجرة الموقع هي عوامل مهمة لذلك. علق خبراء آخرون أيضًا على هذا الارتباط على مر السنين:

"توفر معظم الروابط القليل من السياق الإضافي من خلال نص الرابط الخاص بها. على الأقل يجب عليهم ، أليس كذلك؟ "

- جون مولر ، Google 2017"إذا كانت لديك صفحات تعتقد أنها مهمة على موقعك ، فلا تدفنها في عمق 15 رابطًا داخل موقعك ولا أتحدث عن طول الدليل الذي أتحدث عنه فعليًا ، عليك النقر فوق 15 رابطًا للعثور على تلك الصفحة إذا كانت هناك صفحة مهمة أو بها هوامش ربح كبيرة أو تحويلات حقًا - حسنًا - تصعيد وضع رابط لتلك الصفحة من الصفحة الرئيسية الخاصة بك وهذا هو نوع الشيء الذي يمكن أن يكون له معنى كبير ".

- مات كاتس ، Google 2011"إذا كانت إحدى الصفحات مرتبطة بأخرى بكلمة" جهة اتصال "أو كلمة" حول "، وكانت الصفحة التي يتم ربطها تتضمن عنوانًا ، فيمكن اعتبار موقع العنوان ذا صلة بالصفحة التي تقوم بهذا الارتباط."

12 طريقة لتحليل روابط Google التي ربما تكون قد تغيرت - بيل سلاوسكي

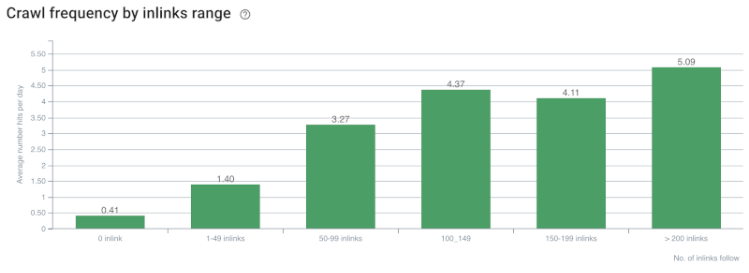

معدل الزحف / الطلب وترابط عدد الروابط الداخلية. المصدر: OnCrawl.

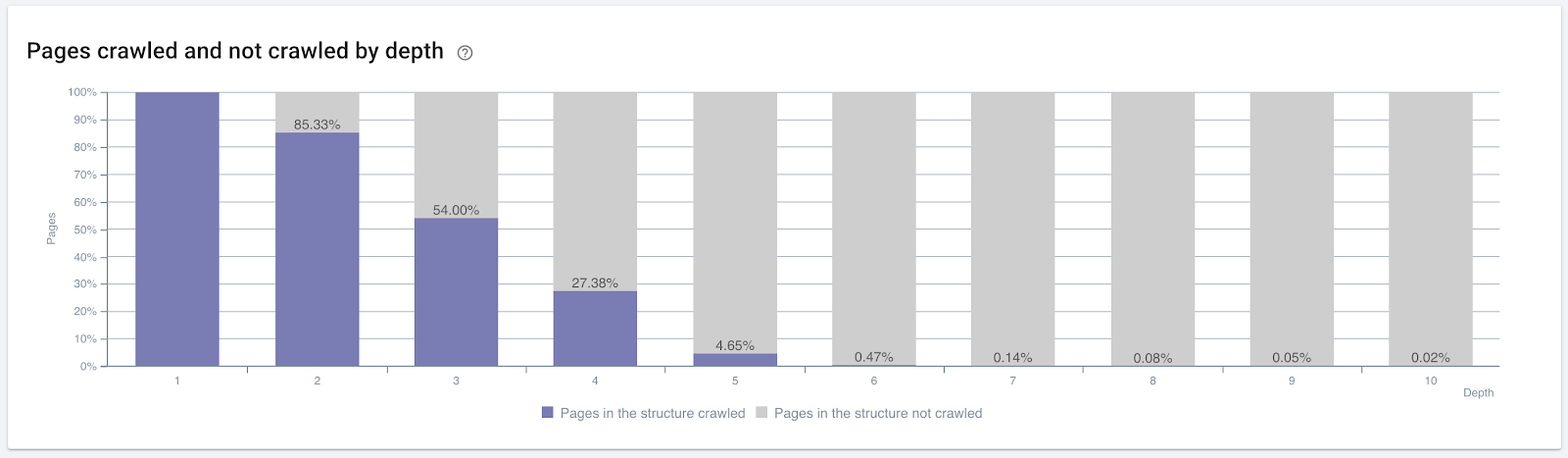

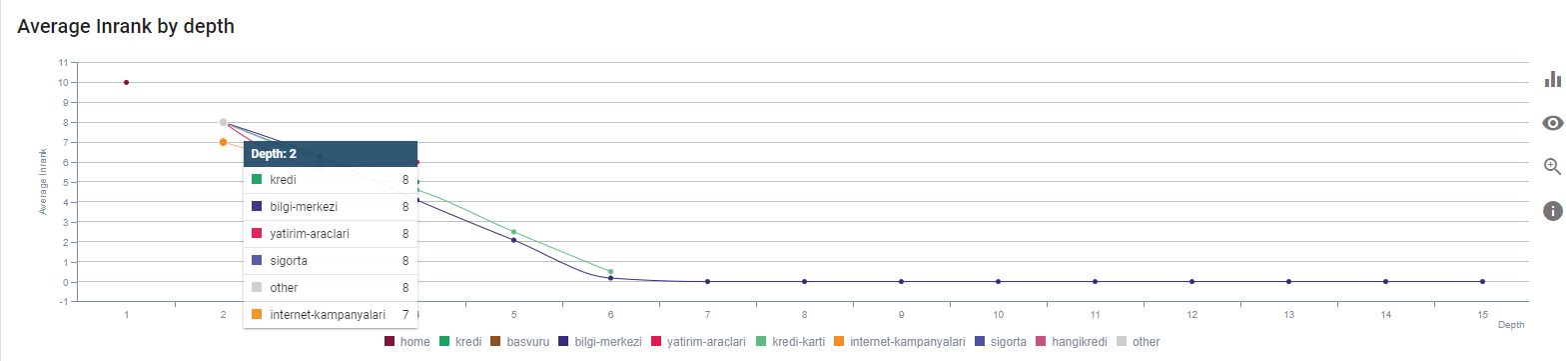

حتى الآن ، قد نجعل هذه الاستنتاجات:

- تهتم Google بعمق النقر. إذا كانت صفحة الويب أقرب إلى الصفحة الرئيسية ، فيجب أن تكون أكثر أهمية. تم تأكيد ذلك أيضًا من قِبل جون مولر في 1 يوليو 2018 جلسة Hangout باللغة الإنجليزية لمشرفي المواقع من Google.

- إذا كانت صفحة الويب تحتوي على الكثير من الروابط الداخلية التي تشير إليها ، فيجب أن تكون مهمة.

- يمكن أن تعطي نصوص الارتساء قوة سياقية لصفحة الويب.

- يمكن للرابط الداخلي إرسال كميات مختلفة من صفحات Pagerank بناءً على الموضع أو النوع أو وزن الخط أو النمط.

- تعتبر شجرة الموقع الملائمة لتجربة المستخدم والتي تقدم رسائل واضحة حول سلطة الصفحة الداخلية إلى برامج زحف محرك البحث خيارًا أفضل لتوزيع Inrank وكفاءة الزحف.

النسبة المئوية للصفحات التي تم الزحف إليها بعمق النقر. المصدر: OnCrawl.

لكن هذه ليست كافية لفهم طبيعة الروابط الداخلية وتأثيراتها على كفاءة الزحف.

زاحف Oncrawl SEO

إذا كانت معظم صفحاتك المرتبطة داخليًا لا تنشئ حركة مرور أو يتم النقر عليها ، فإنها تعطي إشارات تشير إلى أن شجرة الموقع وبنية الارتباط الداخلية لم يتم إنشاؤها وفقًا لنية المستخدم. ويحاول Google دائمًا العثور على صفحاتك الأكثر صلة بقصد المستخدم أو كيانات البحث. لدينا اقتباس آخر من بيل سلاوسكي يجعل هذا الموضوع أكثر وضوحًا:

"إذا كان أحد الموارد مرتبطًا بعدد من الموارد غير المتناسبة مع حركة المرور المتلقاة عن طريق استخدام هذه الروابط ، فقد يتم تخفيض هذا المورد في عملية التصنيف".

هل حدث تحديث جرذ الأرض في Google؟ - بيل سلاوسكي"قد تكون درجة جودة الاختيار أعلى بالنسبة إلى التحديد الذي ينتج عنه وقت طويل (على سبيل المثال ، أكبر من فترة زمنية حدية) من نقاط جودة التحديد لاختيار يؤدي إلى وقت قصير."

هل حدث تحديث جرذ الأرض في Google؟ - بيل سلاوسكي

لذلك لدينا عاملين آخرين:

- الوقت المكوث في الصفحة المرتبطة.

- حركة المستخدم التي ينتجها الارتباط.

عدد الروابط الداخلية والأسلوب / الموضع ليسا العوامل الوحيدة. عدد المستخدمين الذين يتابعون هذه الروابط ومقاييس سلوكهم مهم أيضًا. بالإضافة إلى ذلك ، نعلم أن الروابط والصفحات التي يتم النقر عليها / زيارتها يتم الزحف إليها بواسطة Google أكثر بكثير من الروابط والصفحات التي لم يتم النقر فوقها أو زيارتها.

"لقد تحركنا أكثر فأكثر نحو فهم أقسام الموقع لفهم جودة هذه الأقسام."

جون مولر ، 2 مايو 2017 ، جلسة Hangout باللغة الإنجليزية لمشرفي المواقع من Google.

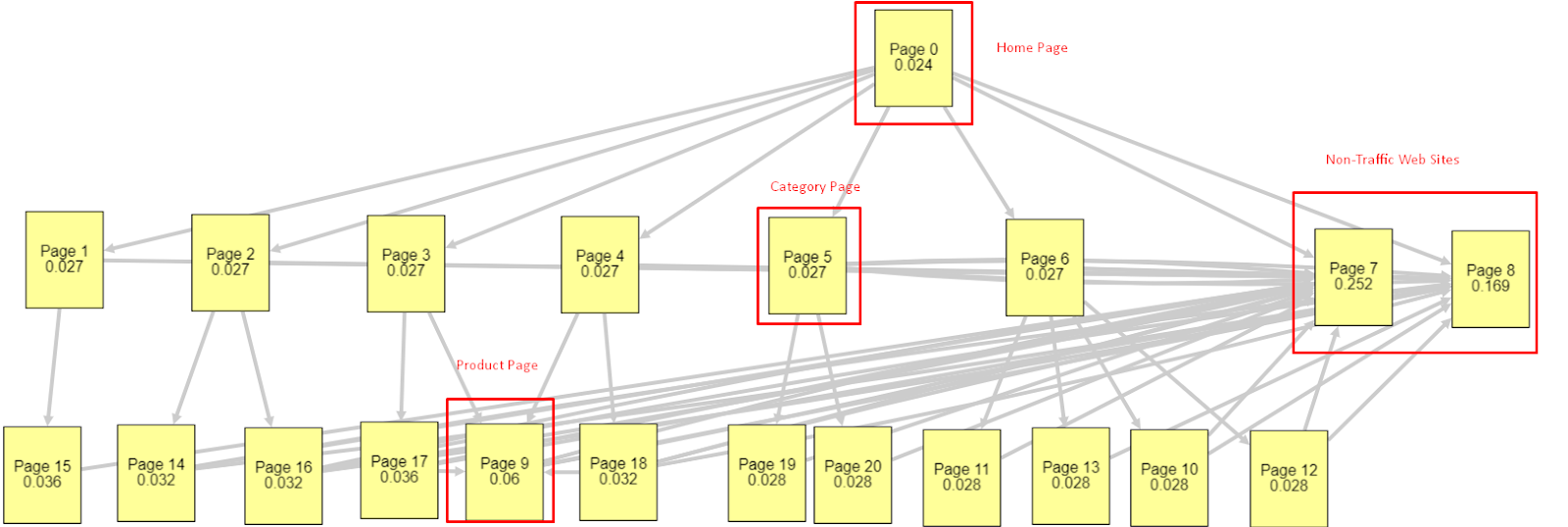

في ضوء كل هذه العوامل ، سوف أشارك نتيجتين مختلفتين ومختلفتين لـ Pagerank Simulator:

يتم إجراء حسابات Pagerank هذه بافتراض أن جميع الصفحات متساوية ، بما في ذلك الصفحة الرئيسية. يتم تحديد الاختلاف الحقيقي من خلال التسلسل الهرمي للارتباط.

المثال الموضح هنا أقرب إلى بنية الارتباط الداخلية قبل 12 مارس. الصفحة الرئيسية PR: 0.024 ، صفحة الفئة PR: 0.027 ، صفحة المنتج PR: 0.06 ، صفحات الويب غير المرورية PR: 0.252.

كما قد تلاحظ ، لا يمكن لبرنامج Googlebot الوثوق بهيكل الارتباط الداخلي هذا لحساب صفحة الصفحات الداخلية وأهمية الصفحات الداخلية. تتمتع الصفحات التي لا تحتوي على حركة مرور وخالية من المنتجات بسلطة تزيد بمقدار 12 مرة عن الصفحة الرئيسية. لديها أكثر من صفحات المنتج.

هذا المثال أقرب إلى موقفنا قبل تحديث الخوارزمية الأساسية في الخامس من يونيو .. الصفحة الرئيسية PR: 0.033 ، صفحة الفئة: 0،037 ، صفحة المنتج: 0،148 وصفحة الصفحات غير المرورية: 0،037.

كما قد تلاحظ ، لا تزال بنية الروابط الداخلية غير صحيحة ، ولكن على الأقل لا تحتوي صفحات الويب التي لا تحتوي على حركة مرور على علاقات عامة أكثر من صفحات الفئات وصفحات المنتج.

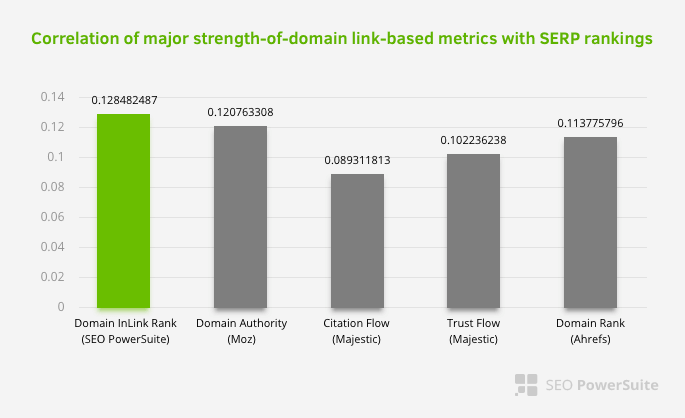

ما هو الدليل الإضافي على أن Google قد أخرجت الارتباط الداخلي وبنية الموقع من نطاق Pagerank وفقًا لتدفق المستخدم وطلباته ونواياه؟ بالطبع سلوك Googlebot و Inlink Pagerank وارتباطات الترتيب:

هذا لا يعني أن شبكة الارتباط الداخلية ، على وجه الخصوص ، أكثر أهمية من العوامل الأخرى. لا يمكن أن يكون منظور تحسين محركات البحث (SEO) الذي يركز على نقطة واحدة ناجحًا أبدًا. في مقارنة بين أدوات الطرف الثالث ، فإنه يوضح أن قيمة Pagerank الداخلية تتقدم فيما يتعلق بالمعايير الأخرى.

وفقًا لـ Inlink Rank وبحث ارتباط الرتبة بواسطة Aleh Barysevich ، فإن الصفحات التي تحتوي على معظم الروابط الداخلية لها ترتيب أعلى من الصفحات الأخرى في الموقع. وفقًا للمسح الذي تم إجراؤه في 4-6 مارس 2019 ، تم تحليل 1،000،000 صفحة وفقًا لمقياس Pagerank الداخلي لـ 33،500 كلمة رئيسية. تمت مقارنة نتائج هذا البحث الذي أجرته SEO PowerSuite مع المقاييس المختلفة لـ Moz و Majestic و Ahrefs وأعطت نتائج أكثر دقة.

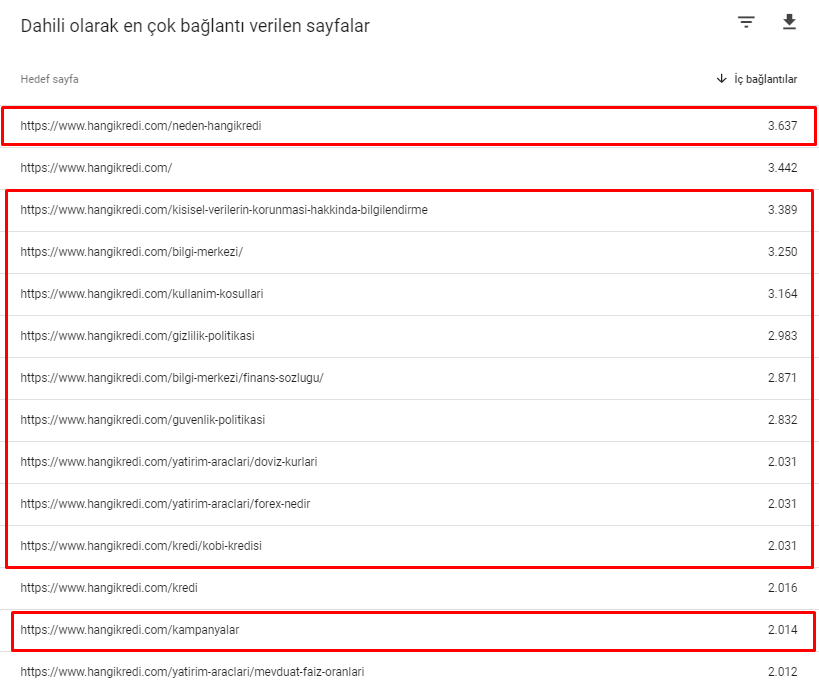

فيما يلي بعض أرقام الارتباطات الداخلية من موقعنا قبل تحديث الخوارزمية الأساسية يوم 12 مارس:

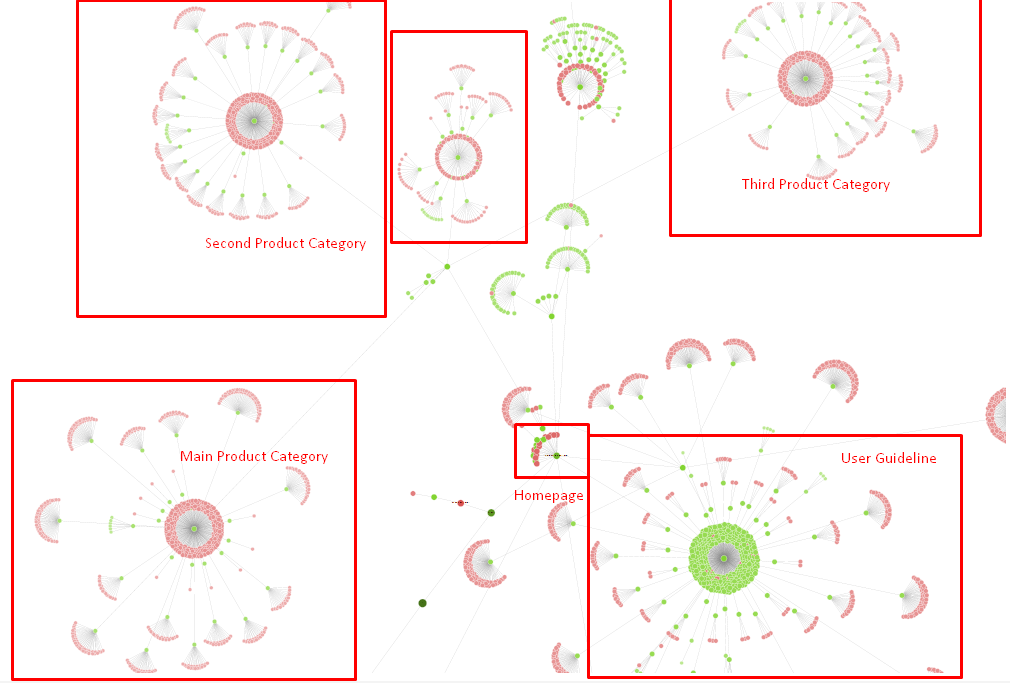

كما ترى ، فإن مخطط الاتصال الداخلي لدينا لا يعكس نية المستخدم وتدفقه. كانت الصفحات التي تتلقى أقل عدد من الزيارات (صفحات المنتج الثانوية) أو التي لم تستقبل زيارات أبدًا (باللون الأحمر) موجودة مباشرة في أول نقرة على عمق وتتلقى العلاقات العامة من الصفحة الرئيسية. والبعض لديه روابط داخلية أكثر من الصفحة الرئيسية.

في ضوء كل هذا ، لا يوجد سوى نقطتين أخيرتين يمكننا إظهارهما حول هذا الموضوع.

- معدل الزحف / الطلب لمعظم الصفحات المرتبطة داخليًا

- ربط النحت والبيجرانك

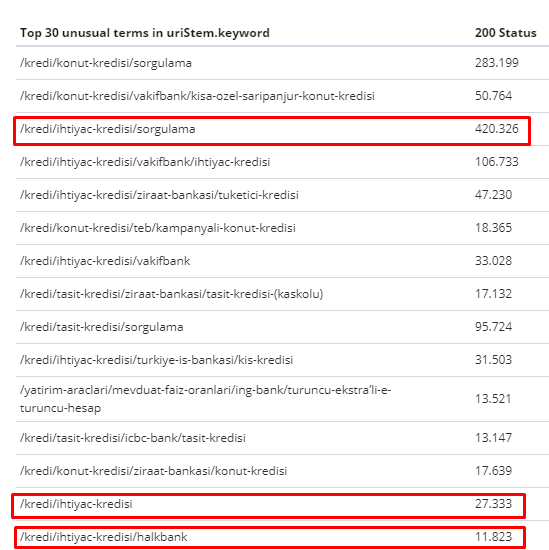

بين 1 شباط (فبراير) و 31 آذار (مارس) ، إليك الصفحات التي زحف Googlebot إليها بشكل متكرر:

كما قد تلاحظ ، فإن الصفحات التي تم الزحف إليها والصفحات التي تحتوي على معظم الروابط الداخلية مختلفة تمامًا عن بعضها البعض. الصفحات التي تحتوي على معظم الروابط الداخلية لم تكن ملائمة لقصد المستخدم ؛ ليس لديهم كلمات رئيسية عضوية أو أي نوع من القيمة المباشرة لتحسين محركات البحث. (

عناوين URL الموجودة في المربعات الحمراء هي فئات صفحات المنتجات الأكثر زيارة والأكثر أهمية. الصفحات الأخرى في هذه القائمة هي الفئة الثانية أو الثالثة الأكثر زيارة والأكثر أهمية.)

Inrank الحالي حسب عمق الصفحة. المصدر: Oncrawl.

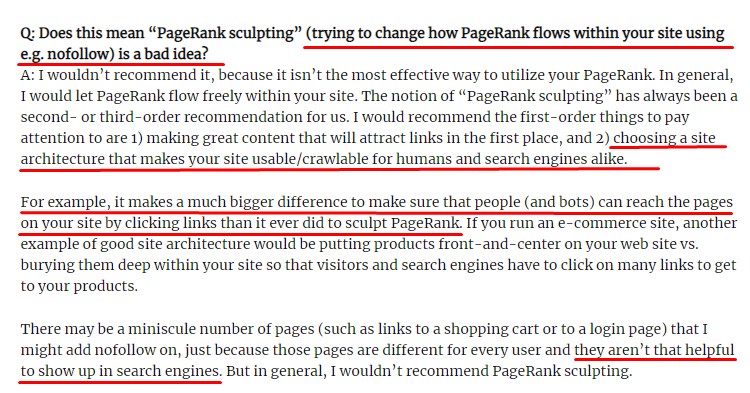

ما هو Link Sculpting وماذا تفعل مع الروابط Nofollowed داخليًا؟

على عكس ما تعتقده معظم مُحسّنات محرّكات البحث ، لا تزال الروابط المميزة بعلامة "nofollow" تمرر قيمة الصفحة الداخلية. بالنسبة لي ، بعد كل هذه السنوات ، لم يروي أحد عنصر تحسين محركات البحث هذا أفضل من Matt Cutts في مقال Pagerank Sculpting من 15 يونيو 2009.

جزء مفيد من Link Sculpting ، والذي يوضح الغرض الحقيقي من Pagerank Sculpting.

"أوصي بعدم استخدام nofollow لنوع من نحت PageRank داخل موقع ويب لأنه ربما لا يفعل ما تعتقد أنه يفعله."

- جون مولر ، Google 2017

إذا كانت لديك صفحات ويب لا قيمة لها من حيث Google والمستخدمين ، فلا يجب وضع علامة "nofollow" عليها. لن يوقف تدفق Pagerank. يجب عليك عدم السماح لهم من ملف robots.txt. وبهذه الطريقة ، لن يقوم Googlebot بالزحف إليها ولكنه أيضًا لن يمرر صفحة Pagerank الداخلية إليهم. لكن يجب ألا تستخدم هذا إلا للصفحات التي لا قيمة لها حقًا ، كما قال مات كاتس قبل عشر سنوات. الصفحات التي تجري عمليات إعادة توجيه تلقائية للتسويق بالعمولة أو الصفحات التي لا تحتوي في الغالب على محتوى هي بعض الأمثلة الملائمة هنا.

الحل: هيكل ربط داخلي أفضل وأكثر طبيعية

منافسنا لديه عيب. كان موقع الويب الخاص بهم يحتوي على نصوص رابط أكثر ، والمزيد من الروابط الداخلية ، لكن هيكلها لم يكن طبيعيًا ومفيدًا. تم استخدام نفس النص الأساسي مع نفس الجملة في كل صفحة على موقعهم. تمت تغطية فقرة الدخول لكل صفحة بهذا المحتوى المتكرر. يمكن لكل مستخدم ومحرك بحث أن يدركوا بسهولة أن هذا ليس هيكلًا طبيعيًا يأخذ في الاعتبار فائدة المستخدم.

لذلك قررت ثلاثة أشياء يجب القيام بها لإصلاح بنية الارتباط الداخلية:

- يجب أن تتبع هندسة معلومات الموقع أو شجرة الموقع مسارًا مختلفًا عن الروابط الموضوعة داخل المحتوى. يجب أن تتبع عن كثب عقل المستخدم والشبكة العصبية الرئيسية.

- في كل جزء من المحتوى ، يجب استخدام الكلمات الأساسية الجانبية جنبًا إلى جنب مع الكلمات الرئيسية الرئيسية للصفحة المستهدفة.

- يجب أن تكون نصوص الإرساء طبيعية ، ومكيفة مع المحتوى ، ويجب استخدامها في نقطة مختلفة في كل صفحة مع الانتباه إلى تصور المستخدم

شجرة الموقع الخاصة بنا وجزء من بنية الرابط في الوقت الحالي.

في الرسم البياني أعلاه ، يمكنك مشاهدة الارتباط الداخلي الحالي وشجرة الموقع.

فيما يلي بعض الأشياء التي فعلناها لإصلاح هذه المشكلة:

- أنشأنا 30000 رابط داخلي إضافي مع نقاط ارتساء مفيدة ..

- استخدمنا البقع الطبيعية والكلمات الرئيسية للمستخدم.

- لم نستخدم الجمل والأنماط المتكررة للربط الداخلي.

- لقد أعطينا Googlebot الإشارات الصحيحة حول Inrank لصفحة ويب.

- لقد فحصنا تأثيرات بنية الارتباط الداخلية الصحيحة على كفاءة الزحف عبر تحليل السجل ورأينا أنه تم الزحف إلى صفحات منتجاتنا الرئيسية بشكل أكبر مقارنة بالإحصائيات السابقة.

- إنشاء أكثر من 50000 رابط داخلي للصفحات المعزولة.

- تم استخدام الارتباطات الداخلية للصفحة الرئيسية لتشغيل الصفحات الفرعية وإنشاء المزيد من مصادر الارتباطات الداخلية على الصفحة الرئيسية.

- لحماية Pagerank Power ، استخدمنا أيضًا علامة nofollow لبعض الروابط الخارجية غير الضرورية. (لم يكن هذا متعلقًا بالروابط الداخلية ولكنه يخدم نفس الهدف.)

3. المشكلة: بنية المحتوى

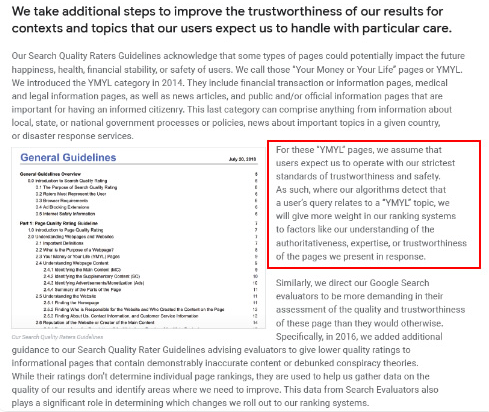

تقول Google أنه بالنسبة لمواقع YMYL ، تعد الجدارة بالثقة والسلطة أكثر أهمية من الأنواع الأخرى من المواقع.

في الماضي ، كانت الكلمات الرئيسية مجرد كلمات رئيسية. لكنهم الآن كيانات محددة جيدًا ومفردة وذات مغزى ويمكن تمييزها. في المحتوى الخاص بنا ، كانت هناك أربع مشاكل رئيسية:

- كان المحتوى الخاص بنا قصيرًا. (في العادة ، لا يعد طول المحتوى مهمًا. ولكن في هذه الحالة ، لم يحتوي على معلومات كافية حول الموضوعات.)

- لم تكن أسماء كتّابنا مفردة أو ذات مغزى أو يمكن تمييزها ككيان.

- لم يكن المحتوى الخاص بنا لطيفًا للعين. بمعنى آخر ، لم يكن محتوى "الوجبات السريعة". كان المحتوى دون عناوين فرعية.

- استخدمنا لغة التسويق. في مساحة فقرة واحدة ، يمكننا تحديد اسم العلامة التجارية وإعلانها للمستخدم.

- كان هناك الكثير من الأزرار التي أرسلت المستخدمين إلى صفحات المنتج من الصفحات الإعلامية.

- في محتويات صفحات منتجاتنا ، لم تكن هناك معلومات كافية أو إرشادات شاملة.

- لم يكن التصميم سهل الاستخدام. كنا نستخدم نفس اللون للخط والخلفية. (لا يزال هذا هو الحال في الغالب بسبب مشاكل البنية التحتية).

- لم يتم مشاهدة الصور ومقاطع الفيديو كجزء من المحتوى.

- نية المستخدم ونية البحث عن كلمة رئيسية معينة لم يُنظر إليها على أنها مهمة من قبل.

- كان هناك الكثير من المحتوى المكرر وغير الضروري والمتكرر لنفس الموضوع.

Oncrawl مضاعفة تدقيق المحتوى من اليوم.

الحل: بنية أفضل للمحتوى من أجل ثقة المستخدم

عند التحقق من مشكلة على مستوى الموقع ، يعد استخدام برنامج تدقيق على مستوى الموقع كمساعد طريقة أفضل لتنظيم الوقت الذي يقضيه في مشروعات تحسين محركات البحث. كما هو الحال في قسم الارتباط الداخلي ، استخدمت Oncrawl Site Audit مع أدوات أخرى وعمليات تفتيش Xpath.

أولاً ، كان إصلاح كل مشكلة في قسم المحتوى سيستغرق وقتًا طويلاً. في أيام الأزمة المنهارة ، كان الوقت بمثابة رفاهية. لذلك قررت إصلاح مشكلات الربح السريع مثل:

- حذف المحتوى المكرر وغير الضروري والمتكرر

- توحيد المحتوى القصير والرقيق الذي يفتقر إلى المعلومات الشاملة

- إعادة نشر المحتوى الذي يفتقر إلى العناوين الفرعية وهيكل يمكن تتبعه بالعين

- تحديد نغمة التسويق المكثف في المحتوى

- حذف الكثير من أزرار الحث على اتخاذ إجراء من المحتوى

- اتصال مرئي أفضل بالصور ومقاطع الفيديو

- جعل المحتوى والكلمات المستهدفة متوافقة مع هدف المستخدم والبحث

- استخدام وإظهار الكيانات المالية والتعليمية في المحتوى للثقة

- استخدام المجتمع الاجتماعي لإنشاء دليل اجتماعي على الموافقة

ركزنا على إصلاح محتويات صفحات المنتج وصفحات الدليل الأقرب إليها.

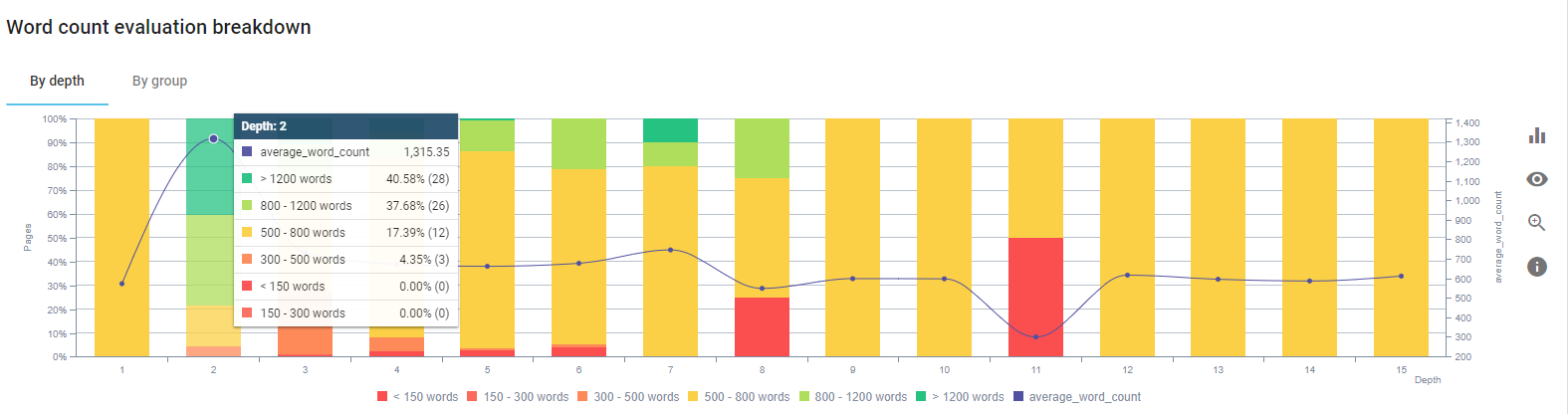

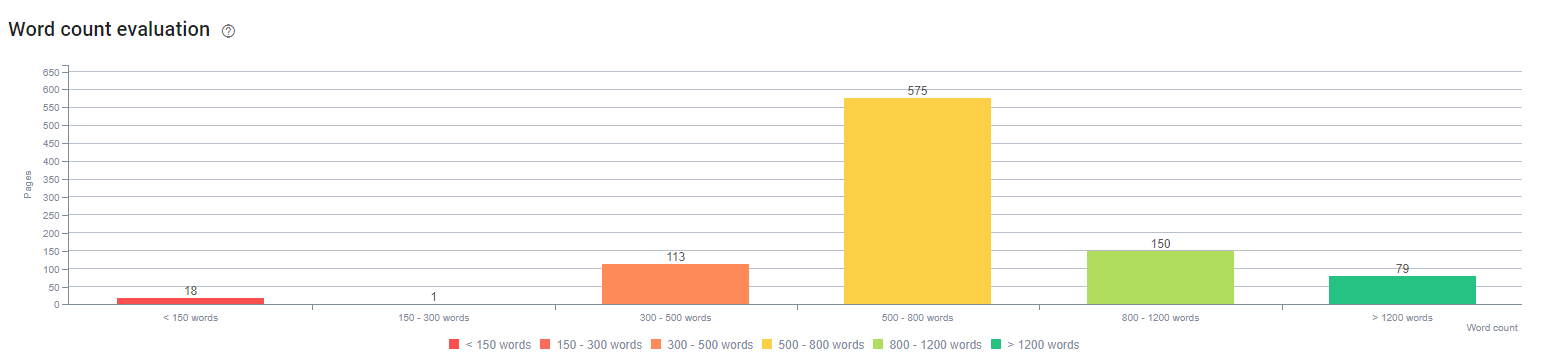

في بداية هذه العملية ، كانت معظم الصفحات المقصودة / الإرشادية الخاصة بمنتجاتنا والمعاملات تحتوي على أقل من 500 كلمة بدون معلومات شاملة.

فيما يلي الإجراءات التي قمنا بها خلال 25 يومًا:

- حذف 228 صفحة ذات محتوى مكرر وغير ضروري ومتكرر. (تم فحص ملفات تعريف الروابط الخلفية لـ Ccontent قبل عملية الحذف. واستخدمنا 301 أو 410 من رموز الحالة من أجل تواصل أفضل مع Googlebot.)

- مجمعة أكثر من 123 صفحة تفتقر إلى معلومات شاملة.

- تستخدم العناوين الفرعية حسب أهميتها وطلب المستخدم في المحتويات.

- تم حذف اسم العلامة التجارية وأزرار الحث على الشراء بلغة التسويق.

- قم بتضمين نص في الصور لتعزيز الموضوع الرئيسي.

هذه لقطة شاشة من Google Vision AI. يمكن لـ Google قراءة النص في الصور والكشف عن المشاعر والهويات داخل الكيانات.

- تنشيط شبكتنا الاجتماعية لجذب المزيد من المستخدمين.

- فحص فجوة المحتوى بيننا وبين المنافسين وإنشاء أكثر من 80 جزءًا جديدًا من المحتوى.

- استخدم Google Analytics و Search Console و Google Data Studio لتحديد الصفحات ذات الأداء الضعيف ذات معدل الارتداد المرتفع وحركة المرور المنخفضة.

- أجرى بحثًا عن المقتطفات المميزة وكلماتها الرئيسية وهيكل المحتوى. أضفنا نفس العناوين وبنية المحتوى إلى المحتويات ذات الصلة ، مما أدى إلى زيادة المقتطفات المميزة لدينا.

في بداية هذه العملية ، كانت محتوياتنا تتألف في الغالب من 150 إلى 300 كلمة. زاد متوسط طول المحتوى لدينا بمقدار 350 كلمة على مستوى الموقع.

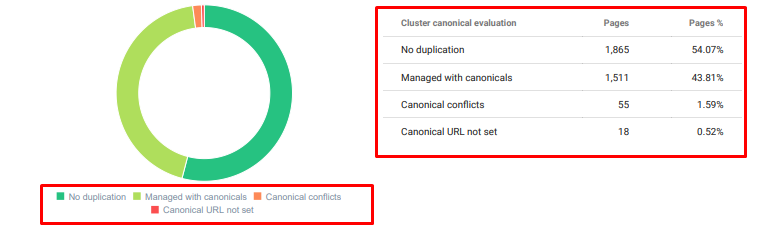

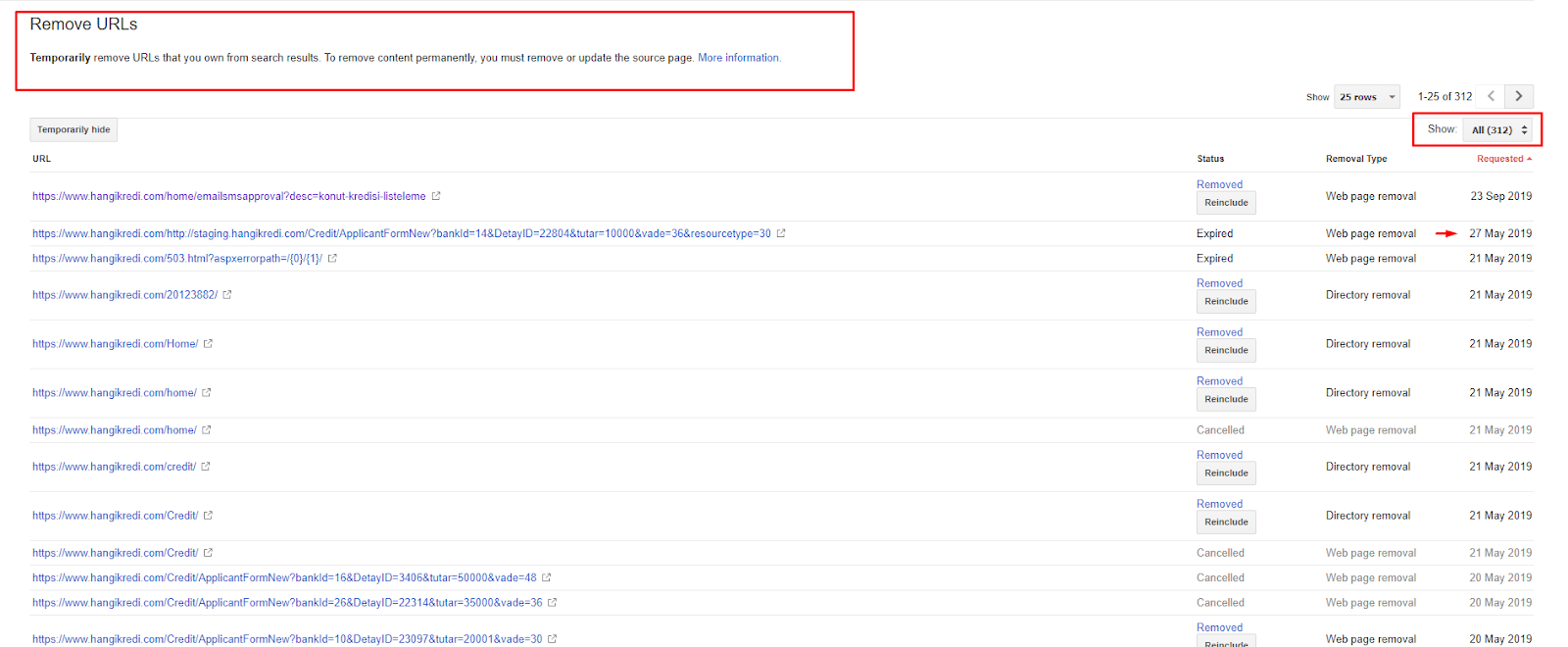

4. المشكلة: مؤشر التلوث ، سخام وعلامات Canonical

لم تصدر Google أبدًا بيانًا حول تلوث الفهرس ، وفي الحقيقة لست متأكدًا مما إذا كان شخص ما قد استخدمه كمصطلح تحسين محركات البحث من قبل أم لا. يجب إزالة جميع الصفحات التي ليس لها معنى لـ Google للحصول على درجة فهرس أكثر كفاءة من صفحات فهرس Google. الصفحات التي تسبب تلوث الفهرس هي الصفحات التي لم تنتج زيارات منذ شهور. ليس لديهم نسبة نقر إلى ظهور صفر وكلمات رئيسية عضوية صفرية. في الحالات التي تحتوي فيها على عدد قليل من الكلمات الرئيسية العضوية ، يجب أن تصبح منافسًا لصفحات أخرى على موقعك لنفس الكلمات الرئيسية.

أيضًا ، أجرينا بحثًا عن حجم الفهرس ووجدنا المزيد من الصفحات المفهرسة غير الضرورية. توجد هذه الصفحات بسبب بنية خاطئة لمعلومات الموقع ، أو بسبب بنية عنوان URL سيئة.

سبب آخر لهذه المشكلة هو استخدام العلامات الأساسية بشكل غير صحيح. لأكثر من عامين ، تم التعامل مع العلامات الأساسية على أنها مجرد تلميحات لبرنامج Googlebot. إذا تم استخدامها بشكل غير صحيح ، فلن يقوم Googlebot بحسابها أو الالتفات إليها أثناء تقييم الموقع. وأيضًا ، لإجراء هذا الحساب ، من المحتمل أن تستهلك ميزانية الزحف الخاصة بك بشكل غير فعال. بسبب الاستخدام غير الصحيح للعلامة الأساسية ، تمت فهرسة أكثر من 300 صفحة تعليق ذات محتوى مكرر.

تهدف نظريتي إلى إظهار الجودة والصفحات الضرورية لـ Google فقط مع إمكانية كسب نقرات وخلق قيمة للمستخدمين.

الحل: تحديد مؤشر التلوث والنفخ

أولاً ، أخذت نصيحة جون مولر من Google. سألته عما إذا كنت أستخدم علامة noindex لهذه الصفحات ولكن ما زلت أسمح لبرنامج Googlebot بمتابعتها ، "هل سأفقد قيمة الروابط والزحف إلى الكفاءة؟"

كما يمكنك أن تتخيل ، قال نعم في البداية لكنه اقترح بعد ذلك أن استخدام الروابط الداخلية يمكن أن يتغلب على هذه العقبة.

لقد وجدت أيضًا أن استخدام علامات noindex في نفس الوقت مثل dofollow يقلل من معدل الزحف بواسطة Googlebot على هذه الصفحات. سمحت لي هذه الإستراتيجيات بجعل Googlebot يزحف إلى منتجي وصفحات الإرشادات المهمة في كثير من الأحيان. قمت أيضًا بتعديل هيكل الارتباط الداخلي الخاص بي كما نصح به جون مولر.

في وقت قصير:

- تم اكتشاف صفحات مفهرسة غير ضرورية.

- تمت إزالة أكثر من 300 صفحة من الفهرس.

- تم تنفيذ علامة Noindex.

- تم تعديل بنية الارتباط الداخلية للصفحات التي تلقت ارتباطات من الصفحات التي تمت إزالتها من الفهرس.

- تم فحص كفاءة الزحف وجودته بمرور الوقت.

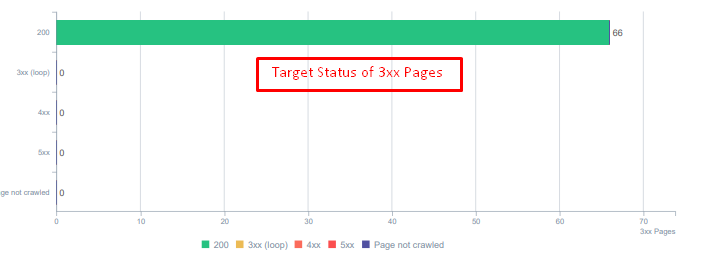

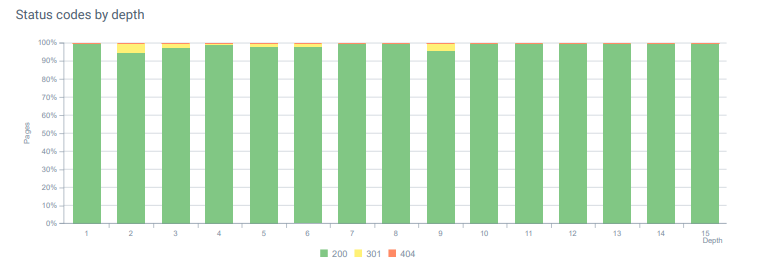

5. المشكلة: رموز الحالة الخاطئة

في البداية ، لاحظت أن Googlebot يزور الكثير من المحتوى المحذوف من الماضي. حتى صفحات من ثماني سنوات مضت ما زالت قيد الزحف. كان هذا بسبب استخدام رموز الحالة غير الصحيحة خاصة للمحتوى المحذوف.

يوجد فرق كبير بين 404 و 410 وظيفة. أحدهما لصفحة خطأ حيث لا يوجد محتوى والآخر للمحتوى المحذوف. بالإضافة إلى ذلك ، أشارت الصفحات الصالحة أيضًا إلى الكثير من عناوين URL للمصدر والمحتوى المحذوفة. تم أيضًا استخدام بعض الصور المحذوفة وأصول CSS أو JS على الصفحات المنشورة الصالحة كموارد. أخيرًا ، كان هناك الكثير من صفحات soft 404 وسلاسل إعادة توجيه متعددة و 302-307 عمليات إعادة توجيه مؤقتة للصفحات المعاد توجيهها بشكل دائم.

أكواد الحالة للأصول المعاد توجيهها اليوم.

الحل: إصلاح رموز الحالة الخاطئة

- تم تحويل كل رمز حالة 404 إلى رمز حالة 410. (أكثر من 30000)

- تم استبدال كل مورد برمز الحالة 404 بمورد صالح جديد. (أكثر من 500)

- تم تحويل كل إعادة توجيه 302-307 إلى إعادة توجيه دائمة 301. (أكثر من 1500)

- تمت إزالة سلاسل إعادة التوجيه من الأصول قيد الاستخدام.

- في كل شهر ، تلقينا أكثر من 25000 زيارة على الصفحات والموارد برمز الحالة 404 في تحليل السجل لدينا. الآن ، هو أقل من 50 لرموز الحالة 404 شهريًا وصفر عدد الزيارات لـ 410 من رموز الحالة ...

أكواد الحالة طوال عمق الصفحة اليوم.

6. المشكلة: HTML الدلالية

تشير الدلالات إلى ما يعنيه شيء ما. يتضمن HTML الدلالي العلامات التي تعطي معنى لمكون الصفحة داخل التسلسل الهرمي. باستخدام بنية الشفرة الهرمية هذه ، يمكنك إخبار Google بالغرض من جزء من المحتوى. أيضًا ، في حالة عدم تمكن Googlebot من الزحف إلى كل مورد مطلوب لعرض صفحتك بالكامل ، يمكنك على الأقل تحديد تخطيط صفحة الويب الخاصة بك ووظائف أجزاء المحتوى الخاصة بك إلى Googlebot.

على Hangikredi.com ، بعد تحديث الخوارزمية الأساسية لـ Google في 12 مارس ، علمت أنه لا توجد ميزانية كافية للزحف بسبب بنية موقع الويب غير المحسّنة. لذلك ، من أجل جعل Googlebot يفهم هدف صفحة الويب ووظيفتها ومحتواها وفائدتها بسهولة أكبر ، قررت استخدام لغة HTML الدلالية.

الحل: استخدام HTML الدلالي

وفقًا لإرشادات Google Quality Rater ، فإن كل باحث لديه نية وكل صفحة ويب لها وظيفة وفقًا لهذه النية. لإثبات هذه الوظائف لبرنامج Googlebot ، قمنا بإجراء بعض التحسينات على بنية HTML الخاصة بنا لبعض الصفحات التي يتم الزحف إليها بشكل أقل بواسطة Googlebot.

- تم استخدام علامة <main> لعرض المحتوى الأساسي والوظيفة الرئيسية للصفحة.

- تستخدم <nav> للجزء الملاحي.

- تم استخدام <footer> لتذييل الموقع.

- تم استخدام <article> للمقالة.

- يتم استخدام علامات <section> لكل علامة عنوان.

- تستخدم علامات <picture> و <table> و <citation> للصور والجداول والاقتباسات في المحتوى.

- مستخدمة ، علامة <aside> للمحتوى التكميلي.

- تم إصلاح مشاكل التسلسل الهرمي H1-H6 (على الرغم من بيان Google الأخير "استخدام اثنين من H1 ليس مشكلة" ، فإن استخدام البنية الصحيحة يساعد Googlebot.)

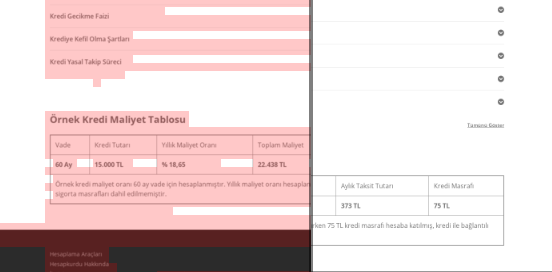

- كما هو الحال في قسم بنية المحتوى ، استخدمنا أيضًا لغة HTML الدلالية للمقتطفات المميزة ، واستخدمنا الجداول والقوائم لمزيد من نتائج المقتطفات المميزة.

بالنسبة لنا ، لم يكن هذا تطويرًا قابلاً للتنفيذ بشكل واقعي للموقع بأكمله. مع ذلك ، مع كل تحديث للتصميم ، نستمر في تنفيذ علامات HTML الدلالية لصفحات ويب إضافية.

7. المشكلة: استخدام البيانات المنظمة

مثل استخدام HTML الدلالي ، يمكن استخدام البيانات المنظمة لإظهار وظائف وتعريفات أجزاء صفحة الويب لبرنامج Googlebot. بالإضافة إلى ذلك ، تعد البيانات المنظمة إلزامية للحصول على نتائج منسقة. على موقعنا على الويب ، لم يتم استخدام البيانات المنظمة أو ، بشكل أكثر شيوعًا ، تم استخدامها بشكل غير صحيح حتى نهاية شهر مارس. من أجل إنشاء علاقات أفضل مع الكيانات على موقعنا على الويب وحساباتنا خارج الصفحة ، بدأنا في تنفيذ البيانات المهيكلة.

الحل: استخدام البيانات المنظمة بشكل صحيح ومختبر

بالنسبة للمؤسسات المالية ومواقع YMYL على الويب ، يمكن للبيانات المهيكلة إصلاح الكثير من المشاكل. على سبيل المثال ، يمكنهم إظهار هوية العلامة التجارية ونوع المحتوى وإنشاء عرض مقتطف أفضل. استخدمنا أنواع البيانات المنظمة التالية للصفحات على مستوى الموقع والصفحات الفردية:

- الأسئلة الشائعة حول البيانات المنظمة لصفحات المنتج الرئيسية

- البيانات المهيكلة لصفحة الويب

- البيانات المنظمة المنظمة

- البيانات المنظمة لمسار التنقل

8. ملف Sitemap و Robots.txt الأمثل

على Hangikredi.com ، لا يوجد خريطة موقع ديناميكي. لم تتضمن خريطة الموقع الموجودة في ذلك الوقت جميع الصفحات الضرورية وتضمنت أيضًا محتوى محذوفًا. أيضًا ، في ملف Robots.txt ، لم يُسمح ببعض صفحات الإحالة التابعة التي تحتوي على آلاف الروابط الخارجية. وشمل ذلك أيضًا بعض ملفات JS التابعة لجهات خارجية والتي لا تتعلق بالمحتوى والموارد الإضافية الأخرى التي لم تكن ضرورية لبرنامج Googlebot.

تم تطبيق الخطوات التالية:

- إنشاء ملف sitemap_index.xml للعديد من خرائط المواقع التي تم إنشاؤها وفقًا لفئات المواقع للحصول على إشارات زحف أفضل وفحص تغطية أفضل.

- تم حظر بعض ملفات JS التابعة لجهات خارجية وبعض ملفات JS غير الضرورية في ملف robots.txt.

- لم يُسمح بالصفحات التابعة التي تحتوي على روابط خارجية ولا تحتوي على أي قيمة للصفحة المقصودة ، كما ذكرنا في قسم Pagerank أو Internal Link Sculpting.

- تم إصلاح أكثر من 500 مشكلة تغطية. (كان معظمها عبارة عن صفحات تمت فهرستها على الرغم من عدم السماح بملف Robots.txt.)

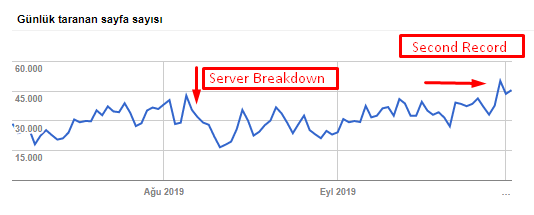

يمكنك رؤية معدل الزحف والحمل والطلب لدينا من الرسم البياني أدناه:

عدد الصفحات التي تم الزحف إليها يوميًا بواسطة Googlebot. كانت هناك زيادة مطردة في الصفحات التي يتم الزحف إليها يوميًا حتى 1 أغسطس. بعد هجوم تسبب في فشل الخادم في أوائل أغسطس ، استعاد استقراره في أكثر من شهر بقليل.

تطور التحميل الذي يتم الزحف إليه يوميًا بواسطة Googlebot بالتوازي مع عدد الصفحات التي يتم الزحف إليها يوميًا.

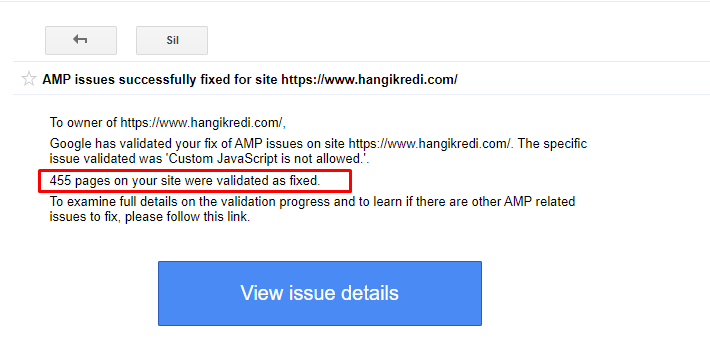

9. إصلاح مشاكل AMP

على موقع الويب الخاص بالشركة ، تحتوي كل صفحة مدونة على إصدار AMP. تم حذف جميع صفحات AMP من الفهرس بشكل متكرر بسبب التنفيذ غير الصحيح للشفرة وفقدان صفحات AMP الأساسية. أدى ذلك إلى عدم استقرار نتيجة المؤشر وانعدام الثقة في موقع الويب. بالإضافة إلى ذلك ، تحتوي صفحات AMP على مصطلحات وكلمات باللغة الإنجليزية بشكل افتراضي على المحتوى التركي.

- تم إصلاح العلامات الأساسية لأكثر من 400 صفحة AMP.

- تم العثور على عمليات تنفيذ التعليمات البرمجية غير الصحيحة وتم إصلاحها. (يرجع ذلك أساسًا إلى التنفيذ غير الصحيح لعلامات AMP-Analytics و AMP-Canonical.)

- تمت ترجمة المصطلحات الإنجليزية بشكل افتراضي إلى التركية.

- تم إنشاء الفهرس واستقرار الترتيب في جانب المدونة على موقع الشركة على الويب.

مثال على رسالة في GSC حول تحسينات AMP

10. مشاكل العلامات الوصفية وحلولها

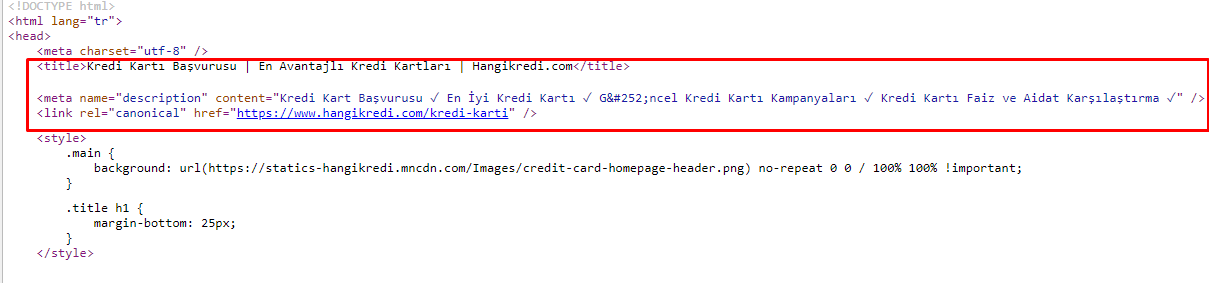

بسبب مشكلات ميزانية الزحف ، أحيانًا في استعلامات البحث الهامة لصفحات المنتج الرئيسية المهمة ، لم يقم Google بفهرسة أو عرض المحتوى في العلامات الوصفية. بدلاً من عنوان التعريف ، أظهرت قائمة SERP فقط اسم الشركة المبني من كلمتين. لم يتم عرض وصف مقتطف .. أدى ذلك إلى خفض نسبة النقر إلى الظهور والإضرار بهوية علامتنا التجارية. لقد أصلحنا هذه المشكلة عن طريق نقل العلامات الوصفية إلى أعلى كود المصدر الخاص بنا كما هو موضح أدناه.

بجانب ميزانية الزحف ، قمنا أيضًا بتحسين أكثر من 600 علامة وصفية لصفحات المعاملات والمعلومات:

- طول الأحرف الأمثل للأجهزة المحمولة.

- تستخدم المزيد من الكلمات الرئيسية في العناوين

- استخدم نمطًا مختلفًا من العلامات الوصفية وفحص نسبة النقر إلى الظهور وفجوة الكلمات الرئيسية وتغييرات الترتيب

- تم إنشاء المزيد من الصفحات بهيكل شجرة الموقع الصحيح لاستهداف الكلمات الرئيسية الثانوية بشكل أفضل بفضل عمليات التحسين هذه.

- على موقعنا ، لا يزال لدينا عناوين وصفية وأوصاف وعناوين مختلفة لاختبار خوارزمية Google ونسبة النقر إلى الظهور لمستخدم البحث.

11. مشاكل أداء الصورة وحلولها

يمكن تقسيم مشاكل الصور إلى نوعين. لراحة المحتوى ولسرعة الصفحة. بالنسبة لكليهما ، لا يزال موقع الويب الخاص بالشركة لديه الكثير للقيام به.

في مارس وأبريل بعد التحديث السلبي للخوارزمية الأساسية في 12 مارس:

- الصور ليس بها علامات بديل أو أنها تحتوي على علامات بديل خاطئة.

- لم يكن لديهم ألقاب.

- لم يكن لديهم بنية URL صحيحة.

- لم يكن لديهم ملحقات الجيل القادم.

- لم يتم ضغطهم.

- لم يكن لديهم الدقة المناسبة لكل حجم شاشة جهاز.

- لم يكن لديهم تعليق.

للتحضير لتحديث خوارزمية Google الأساسية التالي:

- تم ضغط الصور.

- تم تغيير ملحقاتها جزئيا.

- تمت كتابة علامات بديلة لمعظمهم.

- تم إصلاح العناوين والتعليقات التوضيحية للمستخدم.

- تم إصلاح هياكل عناوين URL جزئيًا للمستخدم.

- وجدنا بعض الصور غير المستخدمة والتي لا يزال يتم تحميلها بواسطة المتصفح ، وقمنا بحذفها من النظام.

بسبب البنية التحتية للموقع ، قمنا جزئيًا بتنفيذ تصحيحات تحسين محركات البحث على الصور.

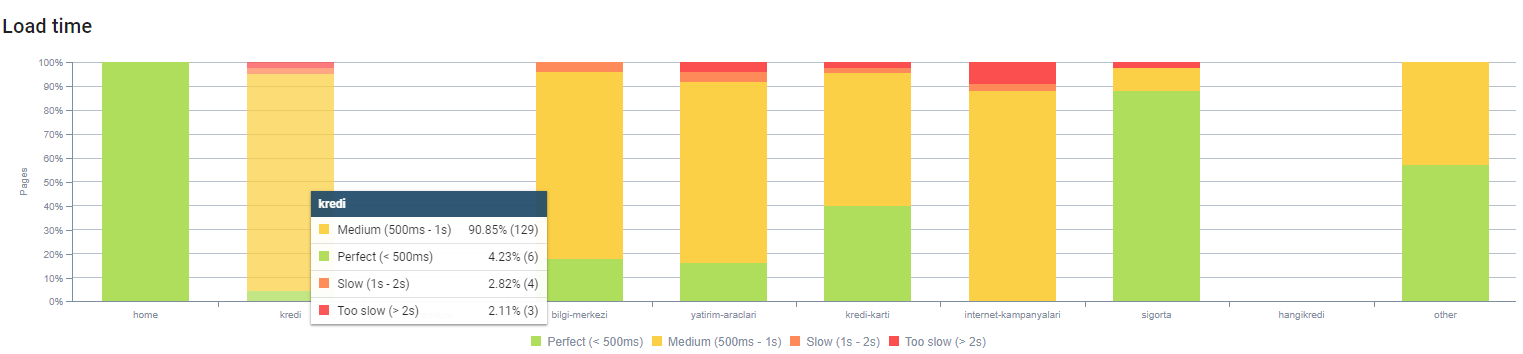

يمكنك مراقبة وقت تحميل صفحتنا من خلال عمق الصفحة أعلاه. كما ترى ، لا تزال معظم صفحات المنتج ثقيلة.

12. مشاكل وحلول ذاكرة التخزين المؤقت والجلب المسبق والتحميل المسبق

قبل تحديث الخوارزمية الأساسية في 12 مارس ، كان هناك نظام ذاكرة تخزين مؤقت فضفاض على موقع الويب الخاص بالشركة. كانت بعض أجزاء المحتوى في ذاكرة التخزين المؤقت ولكن بعضها لم يكن موجودًا. كانت هذه مشكلة خاصة لصفحات المنتج لأنها كانت أبطأ من صفحات منتج منافسنا بمقدار 2x. معظم مكونات صفحات الويب الخاصة بنا هي في الواقع مصادر ثابتة ولكنها لا تزال لا تحتوي على Etags لتوضيح نطاق ذاكرة التخزين المؤقت.

للتحضير لتحديث خوارزمية Google الأساسية التالي:

- قمنا بتخزين بعض المكونات مؤقتًا لكل صفحة ويب وجعلناها ثابتة.

- كانت هذه الصفحات صفحات منتجات مهمة.

- ما زلنا لا نستخدم العلامات الإلكترونية بسبب البنية التحتية للموقع.

- يتم الآن تخزين الصور والموارد الثابتة وبعض أجزاء المحتوى المهمة بشكل كامل مؤقتًا على مستوى الموقع على وجه الخصوص.

- لقد بدأنا في استخدام رمز الجلب المسبق لنظام أسماء النطاقات لبعض الموارد الخارجية المنسية.

- ما زلنا لا نستخدم كود التحميل المسبق ولكننا نعمل على رحلة المستخدم على الموقع من أجل تنفيذه في المستقبل.

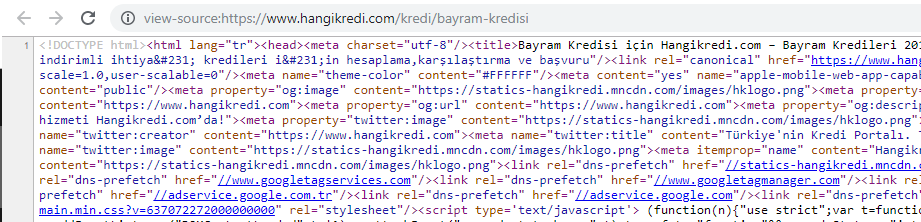

13. تحسين وتقليل HTML و CSS و JS

بسبب مشكلات البنية التحتية للموقع ، لم يكن هناك الكثير من الأشياء التي يجب القيام بها من أجل سرعة الموقع. حاولت سد الفجوة بكل طريقة ممكنة ، بما في ذلك حذف بعض مكونات الصفحة. بالنسبة لصفحات المنتجات المهمة ، قمنا بتنظيف بنية كود HTML وتقليلها وضغطها.

لقطة شاشة من أحد الكود المصدري لصفحة منتجنا الموسمية والمهمة. إن استخدام البيانات المنظمة للأسئلة الشائعة ، وتصغير HTML ، وتحسين الصورة ، وتحديث المحتوى ، والربط الداخلي أعطانا المرتبة الأولى في الوقت المناسب. (الكلمة الرئيسية هي "Bayram Kredisi" باللغة التركية ، وتعني "Holiday Credit")

قمنا أيضًا بتنفيذ CSS Factoring و Refactoring و JS Compression جزئيًا بخطوات صغيرة. عندما انخفض الترتيب ، قمنا بفحص فجوة سرعة الموقع بين صفحات منافسينا وصفحاتنا. لقد اخترنا بعض الصفحات العاجلة التي يمكننا تسريعها. قمنا أيضًا بتنقية ملفات CSS المهمة وضغطها جزئيًا على هذه الصفحات. لقد بدأنا عملية إزالة بعض ملفات JS للجهات الخارجية التي تستخدمها أقسام مختلفة من الشركة ، ولكن لم تتم إزالتها بعد. بالنسبة لبعض صفحات المنتجات ، تمكنا أيضًا من تغيير ترتيب تحميل الموارد.

فحص المنافسين

بالإضافة إلى كل تحسين تقني لتحسين محركات البحث ، كان فحص المنافسين هو أفضل دليل لدي لفهم طبيعة وأهداف تحديث الخوارزمية الأساسية. لقد استخدمت بعض البرامج المفيدة والمفيدة لمتابعة التغييرات في التصميم والمحتوى والرتبة والتكنولوجيا الخاصة بالمنافسين.

- لتغييرات ترتيب الكلمات الرئيسية ، استخدمت Wincher و Semrush و Ahrefs.

- للإشارة إلى العلامات التجارية ، استخدمت تنبيهات Google و BuzzSumo و Talkwalker.

- للحصول على ارتباط جديد وتقارير اكتساب الكلمات الرئيسية الجديدة ، استخدمت تنبيه Ahrefs.

- لتغييرات المحتوى والتصميم ، استخدمت Visualping.

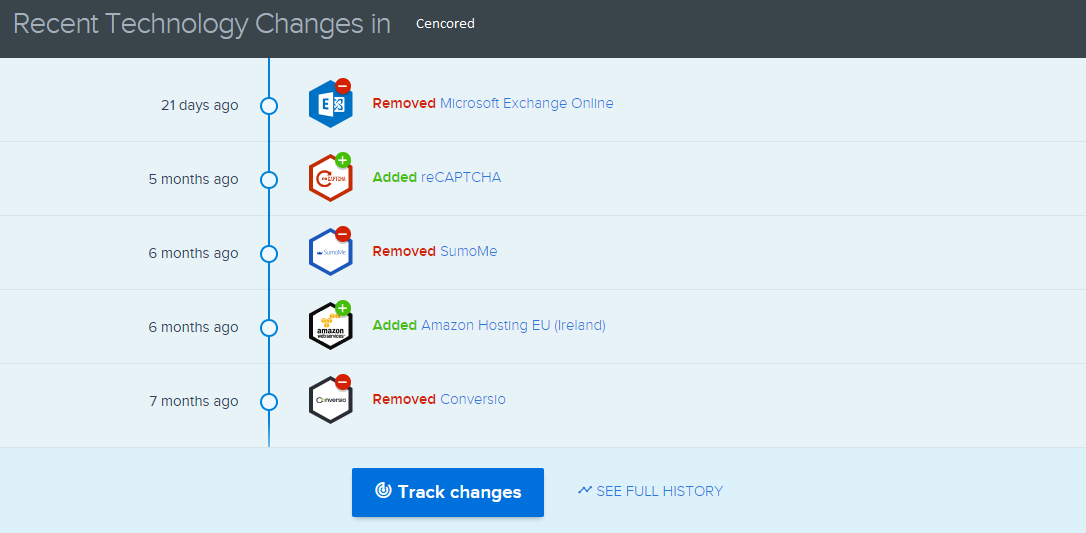

- بالنسبة للتغييرات التكنولوجية ، استخدمت نفس التقنية.

- بالنسبة إلى Google Update News and Inspection ، استخدمت بشكل أساسي Semrush Sensor و Algoroo و CognitiveSEO Signals.

- لفحص سجل عناوين URL للمنافسين ، استخدمت Wayback Machine.

- لسرعة خادم المنافسين ، استخدمت Chrome DevTools و ByteCheck.

- بالنسبة إلى تكلفة الزحف والعرض ، استخدمت "ما تكلفة موقعي". (Since last month, I have started using Onely's new JS Tools like WWJD or TL:DR..)

A screenshot from SimilarTech for my main competitor.

A screenshot from Visualping which shows the layout changes for my secondary competitor.

Testing the value of the changes

With all of these problems identified and solutions in place, I was ready to see whether the website would hold up to the next Google core algorithm updates.

In the next article, I'll look at the major core algorithm updates over the next several months, and how the site performed.