مقدمة لتحليل ملف سجل تحسين محركات البحث

نشرت: 2021-05-17يعد تحليل السجل هو الطريقة الأكثر شمولاً لتحليل كيفية قراءة محركات البحث لمواقعنا. تستخدم مُحسّنات محرّكات البحث والمسوقون الرقميون والمتخصصون في تحليلات الويب كل يوم أدوات تعرض مخططات حول حركة المرور وسلوكيات المستخدم والتحويلات. تحاول مُحسّنات محرّكات البحث عادةً فهم كيفية زحف Google إلى موقعهم عبر Google Search Console.

إذن ... لماذا يجب على مُحسّنات محرّكات البحث تحليل الأدوات الأخرى للتحقق مما إذا كان محرك البحث يقرأ الموقع بشكل صحيح؟ حسنًا ، لنبدأ بالأساسيات.

ما هي ملفات السجل؟

ملف السجل هو ملف يكتب فيه خادم الويب صفًا لكل مورد فردي على موقع الويب يتم طلبه بواسطة الروبوتات أو المستخدمين. يحتوي كل صف على بيانات حول الطلب ، والتي قد تشمل:

IP المتصل ، التاريخ ، المورد المطلوب (الصفحة ، .css ، .js ، ...) ، وكيل المستخدم ، وقت الاستجابة ، ...

سيبدو الصف كما يلي:

66.249.**.** - - [13/Apr/2021:00:07:31 +0200] "GET /***/x_*** HTTP/1.1" 200 40960 "-" "Mozilla/5.0 (compatible; Googlebot/2.1; +http://www.google.com/bot.html)" "www.***.it" "-"

إمكانية الزحف وإمكانية التحديث

تحتوي كل صفحة على ثلاث حالات أساسية لتحسين محركات البحث:

- الزحف

- قابل للفهرسة

- مرتبة

من منظور تحليل السجل ، نعلم أن الصفحة ، لكي تتم فهرستها ، يجب أن يقرأها الروبوت. وبالمثل ، يجب إعادة الزحف إلى المحتوى المفهرس بالفعل بواسطة محرك بحث ليتم تحديثه في فهارس محرك البحث.

لسوء الحظ ، في Google Search Console ، ليس لدينا هذا المستوى من التفاصيل: يمكننا التحقق من عدد مرات قراءة Googlebot لصفحة على الموقع في الأشهر الثلاثة الماضية ومدى سرعة استجابة خادم الويب.

كيف يمكننا التحقق مما إذا كان الروبوت قد قرأ صفحة؟ بالطبع ، باستخدام ملفات السجل ومحلل ملف السجل.

لماذا تحتاج مُحسّنات محرّكات البحث إلى تحليل ملفات السجل؟

يسمح تحليل ملف السجل لمحركات البحث (ومسؤولو النظام أيضًا) بفهم:

- بالضبط ما يقرأه الروبوت

- كم مرة يقرأها الروبوت

- كم تكلفة عمليات الزحف من حيث الوقت المنقضي (بالملي ثانية)

تتيح أداة تحليل السجل إمكانية تحليل السجلات من خلال تجميع المعلومات حسب "المسار" أو نوع الملف أو وقت الاستجابة. تتيح لنا أداة تحليل السجل الرائعة أيضًا ضم المعلومات التي تم الحصول عليها من ملفات السجل مع مصادر البيانات الأخرى مثل Google Search Console (النقرات ، مرات الظهور ، متوسط المواضع) أو Google Analytics.

محلل سجل الزحف

ما الذي تبحث عنه في ملفات السجل؟

من أهم المعلومات المهمة في ملفات السجل ما هو غير موجود في ملفات السجل. حقا ، أنا لا أمزح. تتمثل الخطوة الأولى في فهم سبب عدم فهرسة الصفحة أو عدم تحديثها إلى أحدث إصدار لها في التحقق مما إذا كان الروبوت (على سبيل المثال Googlebot) قد قرأها.

بعد ذلك ، إذا تم تحديث الصفحة بشكل متكرر ، فقد يكون من المهم التحقق من عدد مرات قراءة الروبوت للصفحة أو قسم الموقع.

الخطوة التالية هي التحقق من الصفحات التي تتم قراءتها بشكل متكرر بواسطة برامج الروبوت. من خلال تتبعهم ، يمكنك التحقق مما إذا كانت هذه الصفحات:

- تستحق أن تقرأ كثيرًا

- أو تتم قراءتها كثيرًا لأن شيئًا ما على الصفحة يتسبب في تغييرات مستمرة وخارجة عن السيطرة

على سبيل المثال ، منذ بضعة أشهر ، كان هناك موقع كنت أعمل فيه يحتوي على عدد كبير جدًا من قراءات الروبوت على عنوان URL غريب. كشف الروبوت أن هذه الصفحة من عنوان URL تم إنشاؤه بواسطة برنامج نصي لـ JS ، وأن هذه الصفحة قد تم ختمها ببعض قيم تصحيح الأخطاء التي تغيرت في كل مرة يتم فيها تحميل الصفحة ... بعد هذا الكشف ، يمكن لكبار المسئولين الاقتصاديين الجيد بالتأكيد إيجاد الحل الصحيح لإصلاح ذلك الزحف حفرة الميزانية.

ميزانية الزحف

ميزانية الزحف؟ ما هذا؟ كل موقع له ميزانيته المجازية المتعلقة بمحركات البحث وبرامج الروبوت الخاصة بهم. نعم: تحدد Google نوعًا من الميزانية لموقعك. لم يتم تسجيل هذا في أي مكان ، ولكن يمكنك "حسابه" بطريقتين:

- التحقق من تقرير إحصائيات الزحف في Google Search Console

- التحقق من ملفات السجل ، وتجميعها ( ترشيحها ) بواسطة وكيل المستخدم الذي يحتوي على "Googlebot" ( ستحصل على أفضل النتائج إذا تأكدت من تطابق وكلاء المستخدم مع عناوين IP الصحيحة لـ Google ... )

تزداد ميزانية الزحف عندما يتم تحديث الموقع بمحتوى مثير للاهتمام ، أو عندما يقوم بتحديث المحتوى بانتظام ، أو عندما يتلقى الموقع روابط خلفية جيدة.

يمكن إدارة كيفية إنفاق ميزانية الزحف على موقعك عن طريق:

- الروابط الداخلية (تابع / nofollow أيضًا!)

- noindex / الكنسي

- ملف robots.txt (دقيق: هذا "يحظر" وكيل المستخدم)

صفحات الزومبي

بالنسبة لي ، فإن "صفحات الزومبي" هي جميع الصفحات التي لم تحصل على أي زيارات عضوية أو زيارات روبوت لفترة زمنية طويلة ، ولكن بها روابط داخلية تشير إليها.

يمكن أن يستخدم هذا النوع من الصفحات الكثير من ميزانية الزحف ويمكن أن يتلقى ترتيبًا غير ضروري للصفحة بسبب الروابط الداخلية. يمكن حل هذا الموقف:

- إذا كانت هذه الصفحات مفيدة للمستخدمين الذين يأتون إلى الموقع ، فيمكننا تعيينها على noindex وتعيين الروابط الداخلية لها على أنها nofollow ( أو استخدم disallow robots.txt ، ولكن كن حذرًا مع هذا ... )

- إذا لم تكن هذه الصفحات مفيدة للمستخدمين الذين يأتون إلى الموقع ، فيمكننا إزالتها (وإرجاع رمز الحالة 410 أو 404) وإزالة جميع الروابط الداخلية.

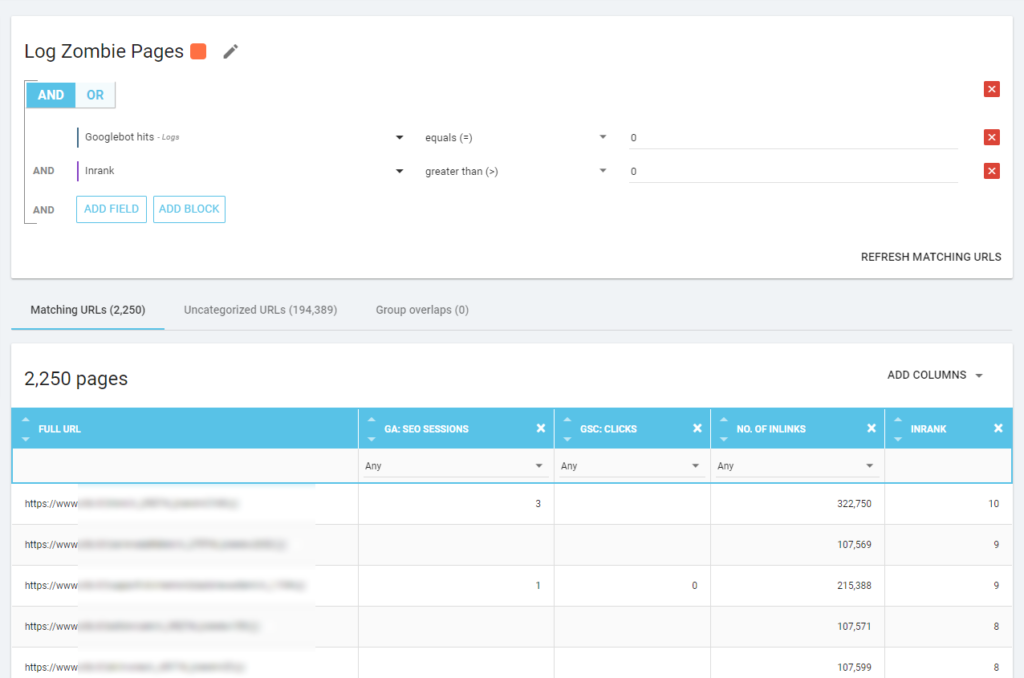

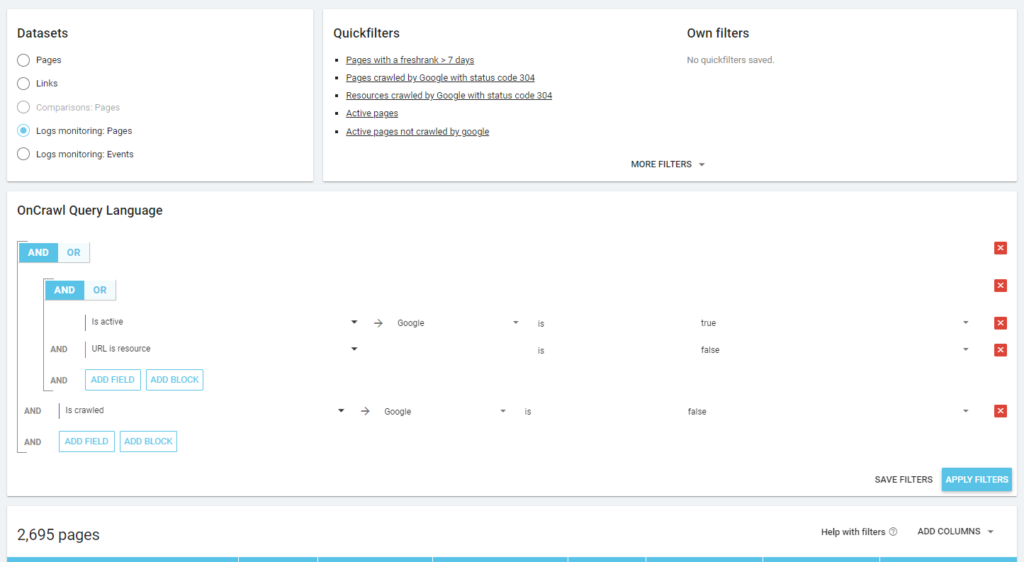

باستخدام Oncrawl ، يمكننا إنشاء "تقرير عن الزومبي" بناءً على:

- انطباعات GSC

- نقرات GSC

- جلسات الجمعية العامة

يمكننا أيضًا استخدام أحداث السجل للكشف عن صفحات الزومبي: يمكننا تحديد مرشح حدث 0 ، على سبيل المثال. تتمثل إحدى أسهل طرق القيام بذلك في إنشاء تجزئة. في المثال أدناه ، أقوم بتصفية جميع الصفحات بالمعايير التالية: لا توجد نتائج لبرنامج Googlebot ولكن باستخدام Inrank (وهذا يعني أن هذه الصفحات لها روابط داخلية تشير إليها).

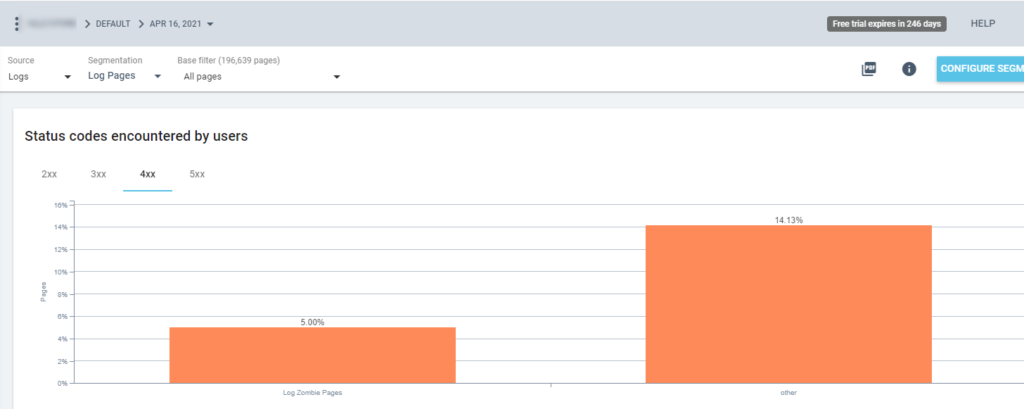

حتى الآن يمكننا استخدام هذا التقسيم في جميع تقارير Oncrawl. يتيح لنا ذلك الحصول على رؤى من أي رسم ، على سبيل المثال: كم عدد "صفحات سجل الزومبي" التي تعرض رمز الحالة 200؟

الصفحات اليتيمة

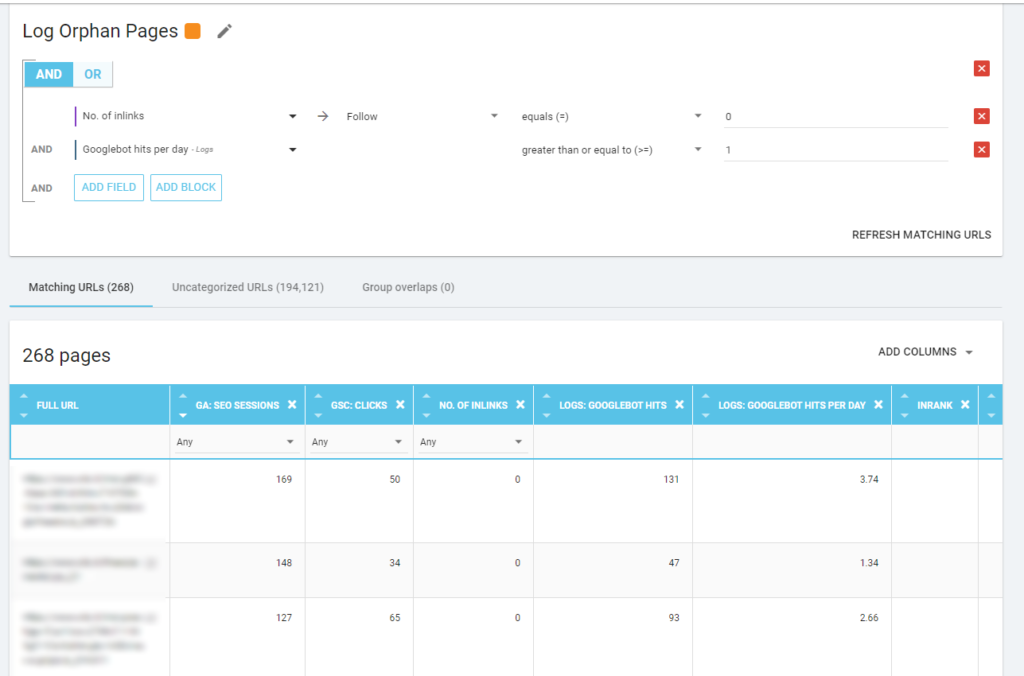

بالنسبة لي ، فإن "الصفحات اليتيمة" التي تستحق النظر فيها بعناية هي جميع الصفحات التي لها قيمة عالية في المقاييس المهمة (جلسة GA ، ظهور GSC ، نتائج السجل ، ...) التي لا تحتوي على أي روابط داخلية تشير إليها لمشاركة ترتيب الصفحة والإشارة إلى أهمية الصفحة.

كما هو الحال مع "صفحات الزومبي" ، لإنشاء تقرير مستند إلى السجل ، فإن أفضل طريقة هي إنشاء تقسيم جديد.

رائع ، يا له من الكثير من الصفحات التي تحتوي على جلسات ونجاحات وبدون روابط داخلية!

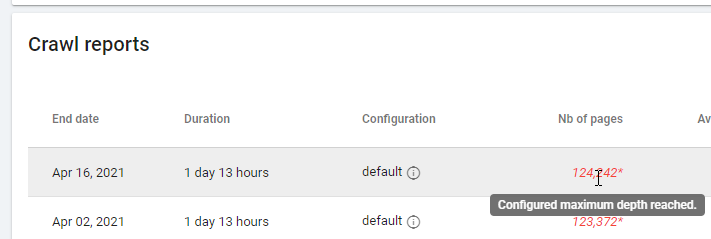

عند التحقق من تقرير يستند إلى "Zero Follow Inlinks" ، يرجى الانتباه إلى حالة الزحف: هل كان Oncrawl قادرًا على الزحف إلى كل الموقع ، أم بضع صفحات فقط؟ يمكنك أن ترى هذا في الصفحة الرئيسية للمشروع:

إذا تم الوصول إلى أقصى عمق:

- تحقق من تكوين الزحف الخاص بك

- تحقق من هيكل موقعك

ملفات الدخول و Oncrawl

ماذا يقدم Oncrawl في لوحات المعلومات الافتراضية الخاصة به؟

سجل مباشر

تعد لوحة المعلومات هذه مفيدة للتحقق من المعلومات الأساسية حول كيفية قراءة الروبوتات لمواقعك ، بمجرد زيارة الروبوتات للموقع وقبل معالجة المعلومات الواردة من ملفات السجل بالكامل. لتحقيق أقصى استفادة منه ، أوصي بتحميل ملفات السجل بشكل متكرر: يمكنك القيام بذلك عبر FTP ، من خلال موصلات مثل تلك الخاصة بـ Amazon S3 ، أو يمكنك القيام بذلك يدويًا عبر واجهة الويب.

يوضح الرسم البياني الأول عدد المرات التي تتم فيها قراءة موقعك وبأي روبوت. في المثال الذي يمكنك رؤيته أدناه ، يمكننا التحقق من الوصول إلى سطح المكتب مقابل الوصول عبر الهاتف المحمول. في هذه الحالة ، أرسلنا إلى Oncrawl ملفات السجل التي تمت تصفيتها لـ Googlebot فقط:

من المثير للاهتمام أن نرى كيف أن كمية قراءات الهاتف المحمول لا تزال عالية جدًا: هل هذا طبيعي؟ يعتمد ذلك على ... لا يزال الموقع الذي نقوم بتحليله في "فهرس الجوال أولاً" ولكنه ليس موقعًا متجاوبًا بالكامل: إنه موقع ويب يعمل بالخدمة الديناميكية (كما تسميه Google) وما زالت Google تتحقق من كلا الإصدارين!

رسم تخطيطي آخر مثير للاهتمام هو "الزيارات من مجموعة الصفحات". بشكل افتراضي ، يقوم Oncrawl بإنشاء مجموعات بناءً على مسارات URL. ولكن يمكننا تعيين المجموعات يدويًا من أجل تجميع عناوين URL الأكثر منطقية لتحليلها معًا.

كما ترون ، يفوز الأصفر! إنه يمثل عناوين URL مع مسار منتج ، لذلك من الطبيعي أن يكون له مثل هذا التأثير الكبير ، خاصة وأن لدينا حملات Shopping مدفوعة من Google.

و ... نعم ، لقد أكدنا للتو أن Google تستخدم Googlebot القياسي للتحقق من حالة المنتج المتعلقة بخلاصة التاجر!

سلوك الزحف

تعرض لوحة المعلومات هذه معلومات مشابهة لـ "السجل المباشر" ولكن تمت معالجة هذه المعلومات بالكامل وتم تجميعها حسب اليوم أو الأسبوع أو الشهر. هنا يمكنك تحديد فترة التاريخ (البداية / النهاية) ، والتي يمكن أن تعود بالزمن إلى الوراء بقدر ما تريد. هناك نوعان من المخططات الجديدة لمزيد من تحليل السجل:

- سلوك الزحف: للتحقق من النسبة بين الصفحات التي تم الزحف إليها والصفحات التي تم الزحف إليها حديثًا

- معدل الزحف في اليوم

أفضل طريقة لقراءة هذه الرسوم البيانية هي ربط النتائج بإجراءات الموقع:

- هل قمت بنقل الصفحات؟

- هل قمت بتحديث بعض الأقسام؟

- هل قمت بنشر محتوى جديد؟

تأثير تحسين محركات البحث

بالنسبة إلى مُحسّنات محرّكات البحث ، من المهم مراقبة ما إذا كانت تتم قراءة الصفحات المحسّنة بواسطة برامج الروبوت أم لا. كما كتبنا عن "الصفحات اليتيمة" ، من المهم التأكد من أن الروبوتات تقرأ الصفحات الأكثر أهمية / المحدثة حتى تتوفر أحدث المعلومات لمحركات البحث لتكون قابلة للترتيب.

يستخدم Oncrawl مفهوم "الصفحات النشطة" للإشارة إلى الصفحات التي تتلقى حركة مرور عضوية من محركات البحث. انطلاقا من هذا المفهوم يظهر بعض الأرقام الأساسية مثل:

- زيارات تحسين محركات البحث

- الصفحات النشطة لتحسين محركات البحث

- النسبة النشطة لتحسين محركات البحث (نسبة الصفحات النشطة بين جميع الصفحات التي تم الزحف إليها)

- Fresh Rank (متوسط الوقت المنقضي بين قراءة الروبوت للصفحة لأول مرة وأول زيارة عضوية)

- لم يتم الزحف إلى الصفحات النشطة

- الصفحات النشطة حديثًا

- معدل الزحف في اليوم للصفحات النشطة

كما هي فلسفة Oncrawl ، بنقرة واحدة ، يمكننا التعمق في بحيرة المعلومات ، وتصفيتها حسب المقياس الذي نقرنا عليه! على سبيل المثال: ما هي الصفحات النشطة التي لم يتم الزحف إليها؟ نقره واحدة…

سلامة الاستكشاف

تتيح لنا لوحة المعلومات الأخيرة هذه التحقق من جودة زحف bo ، أو بشكل أكثر دقة ، إلى أي مدى يقدم الموقع نفسه لمحركات البحث:

- تحليل كود الحالة

- تحليل كود الحالة باليوم

- تحليل كود الحالة من خلال مجموعة الصفحات

- تحليل زمن الاستجابة

من الإلزامي لعمل تحسين محركات البحث الجيد أن:

- تقليل عدد الردود 301 من الروابط الداخلية

- إزالة الردود 404/410 من الروابط الداخلية

- تحسين وقت الاستجابة ، لأن جودة زحف Googlebot ترتبط ارتباطًا مباشرًا بوقت الاستجابة: حاول تقليل وقت الاستجابة على موقعك بمقدار النصف وستلاحظ (في غضون أيام قليلة) أن كمية الصفحات التي يتم الزحف إليها ستتضاعف.

علم تحليل السجل و Oncrawl's Data Explorer

لقد رأينا حتى الآن تقارير Oncrawl القياسية وكيفية استخدامها للحصول على معلومات مخصصة عبر التقسيمات ومجموعات الصفحات.

لكن جوهر تحليل السجل هو فهم كيفية العثور على خطأ ما. عادةً ما تكون نقطة بداية التحليل هي التحقق من الذروات ومقارنتها بعدد الزيارات وبأهدافك:

- معظم الصفحات التي تم الزحف إليها

- أقل الصفحات التي تم الزحف إليها

- معظم الموارد التي تم الزحف إليها (وليس الصفحات)

- الزحف الترددات حسب نوع الملف

- تأثير رموز الحالة 3xx / 4xx

- تأثير رموز الحالة 5xx

- الصفحات التي تم الزحف إليها بشكل أبطأ

- ...

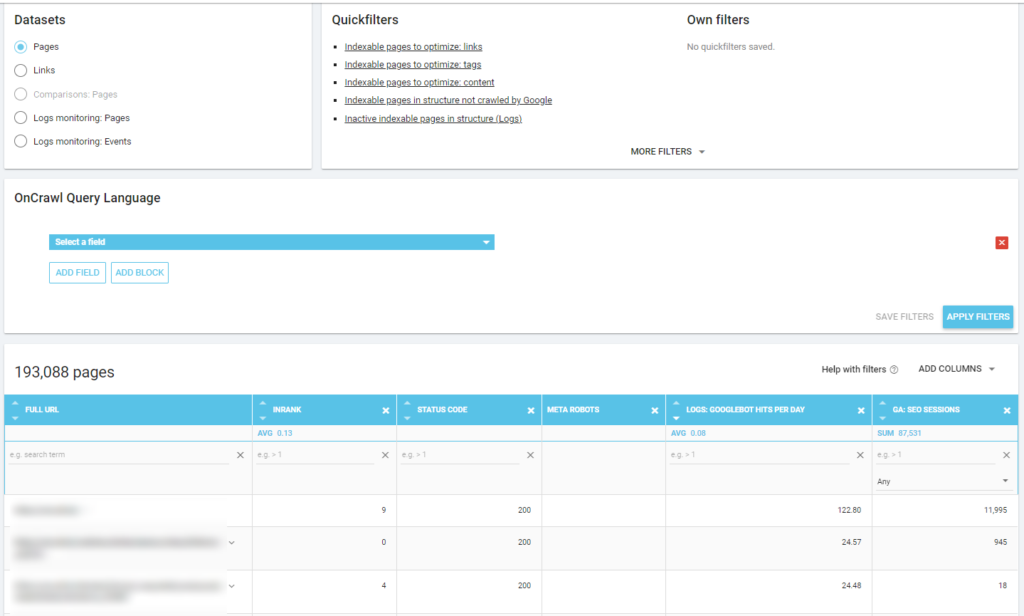

هل تريد التعمق أكثر؟ جيد ... أنت بحاجة إلى إضافة البيانات. ويقدم Oncrawl أداة قوية حقًا مثل Data Explorer.

كما ترى في لقطة شاشة سابقة (لم يتم الزحف إلى الصفحات النشطة) ، يمكنك إنشاء جميع التقارير التي تريدها بناءً على إطار عمل التحليل الخاص بك.

علي سبيل المثال:

- أسوأ صفحات حركة المرور العضوية مع الكثير من الزحف بواسطة برامج الروبوت

- أفضل صفحات حركة المرور العضوية التي تحتوي على الكثير من عمليات الزحف بواسطة برامج الروبوت

- صفحات أبطأ بها الكثير من مرات ظهور نتائج محرك البحث المتقدم

- ...

يمكنك أدناه معرفة كيف راجعت أكثر الصفحات التي تم الزحف إليها والمتعلقة بعدد جلسات تحسين محركات البحث:

الوجبات الجاهزة

تحليل السجل ليس تقنيًا بحت: للقيام بذلك بأفضل طريقة ممكنة ، نحتاج إلى الجمع بين المهارات الفنية ومهارات تحسين محركات البحث ومهارات التسويق.

في كثير من الأحيان ، يتم استبعاد التحليل من "قائمة التحقق من تحسين محركات البحث" لأن عملائنا لا يملكون حق الوصول إلى ملفات السجل أو لأنه يمكن أن يكون تحليلًا مكلفًا.

الحقيقة هي أن السجلات هي المصادر الوحيدة للتحقق حقًا من مكان ذهاب الروبوتات على مواقعنا ، ومعرفة كيفية استجابة خوادمنا لها.

يمكن لأداة مثل Oncrawl أن تقلل بشكل كبير من المتطلبات الفنية: ما عليك سوى تحميل ملفات السجل والبدء في تحليلها!